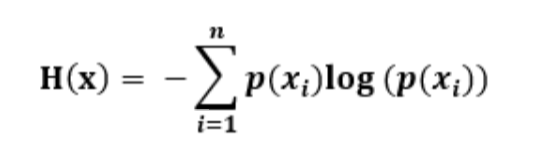

1.信息熵:一条信息的信息量与其不确定性有着直接的关系。(变量的不确定性越大,熵也就越大)

2.信息的作用:信息是消除系统不确定性的唯一办法(在没有获得任何信息前,一个系统就像是一个黑盒子,引入信息,就可以了解黑盒子系统的内部结构),信息和信号处理的应用都是一个消除不确定性的过程(知道的信息越多,随机事件的不确定性就越小)

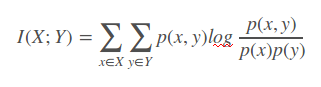

3.互信息(相关性):互信息为两个随机事件“相关性”的量化度量

4.相对熵

(1)对于两个完全相同的函数,它们的相对熵为零

(2)相对熵越大,两个函数差异越大;反之,相对熵越小,两个函数差异越小

(3)对于概率分布或者概率密度函数,如果取值均大于零,相对熵可以度量两个随机分布的差异