1、Global Library右键没有Scala SDK选择,导致无法new出scala,解决方案:安装scala sdk,我使用如图(1)装的

2、右键无法new出scala class,解决方法:需要将该文件夹指定为Source文件夹即可,图(1)的文件夹是Source文件夹,图(2)不是,所以无法创建scala class。

图(1)

图(2)

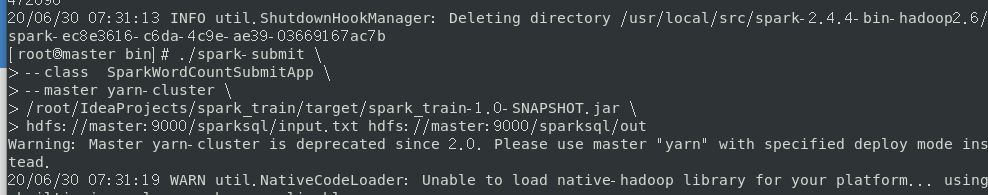

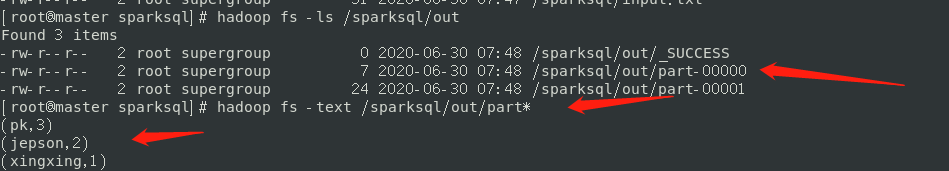

3、spark-submit提交jar时报程序文件名找不到,如图(1),原因很可能时改了代码后没有重新build,解决方法:重新build下项目即可,效果如图(2)

图(1)

图(2)

4、yarn模式提交spark应用程序报:如图(1),Retrying connect to server: master/192.168.110.10:8032. Already tried 0 time(s); retry policy is RetryUpToMaximumCountWithFixedSleep(maxRetries=10, sleepTime=1000 MILLISECONDS),原因是yarn没启动,而且8032是yarn的默认端口,解决方法是在hadoop的sbin目录下面./start-yarn.sh既可以,成功后结果如图(2)

图(1)

图(2)

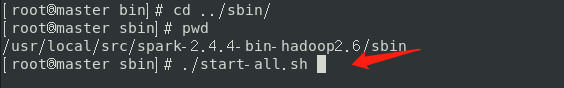

5、standalone模式运行spark应用程序报:拒绝连接 http://xxxx:7077,原因是:spark集群没启动,解决方法:运行$SPARK_HOME/sbin/start-all.sh即可。

图(1)

图(2)

6、spark-shell --master local启动后,通过运行spark.sql("show tables")报访问不聊hdfs://master:9000,这个是因为没用启动hadoop,去$HADOOP_HOME/sbin目录下面启动start-all.sh即可。

7、跑spark sql程序报:code 137 (interrupted by signal 9 sigkill),解决办法:内存不够了,将idea重启即可

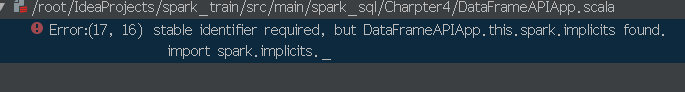

8、导入隐式转换报错,原因是SparkSession变量不能用var定义,需要用val。

9、spark-submit时报Exception in thread "main" java.lang.NoClassDefFoundError: com/typesafe/conf,原因是运行路径下面缺少typesafe包,将maven仓库下面的这个包的路径拷贝过来即可,如配置所示。

./spark-submit \

--class Charpter5.DataSourceApp \

--master yarn \

--name DataSourceApp \

--jars /home/keyan/maven_repository/com/typesafe/config/1.3.3/config-1.3.3.jar \

/root/IdeaProjects/spark_train/target/spark_train-1.0-SNAPSHOT.jar

10.启动$SPARK_HOME/sbin下面的beeline报错:

20/07/11 19:34:38 WARN thrift.ThriftCLIService: Error opening session:

org.apache.hive.service.cli.HiveSQLException: Failed to open new session: java.lang.RuntimeException: java.lang.RuntimeException: org.apache.hadoop.security.AccessControlException: Permission denied: user=anonymous, access=EXECUTE, inode="/tmp":root:supergroup:drwx------

at org.apache.hadoop.hdfs.server.namenode.FSPermissionChecker.checkFsPermission(FSPermissionChecker.java:271)

,原因为dfs下面的/tmp文件夹没权限,赋权即可:hadoop fs -chmod 777 /tmp

启动服务端:$SPARK_HOME/sbin/start-thriftserver.sh --master local --jars ../jars/mysql-connector-java-5.1.49.jar

启动客户端:$SPARK_HOME/bin/beeline -u jdbc:hive2://master:10000

11.用kudu创建表失败报连不上7051端口,原因是kudu-master没开,通过cd /etc/init.d , ./kudu-master start开启即可