说实话老子百度了各种方法,根本就不行,为啥?

都是一两行代码的回答,和没回答是一样的。这特么要是能用我会写这个博文

os.environ['CUDA_VISIBLE_DEVICES'] = '0,1'

或者这种:有个毛区别

CUDA_VISIBLE_DEVICES=0,1 python3 train.py都不能解决问题,统统都是垃圾。

还有一种tf.ConfigProto,这玩意我之前去掉了,这是另外的那个模型的。下面我试试放到TTS的模型中,看看有没有屁用。

事实证明这种也是狗屎一样垃圾。

session_conf = tf.ConfigProto(

device_count={'CPU': 3, 'GPU': 3},

gpu_options=tf.GPUOptions(allow_growth=True),

log_device_placement=False

)

与之前没区别,真是够了。果断杀死这个程序。

群里大佬给出了pytorch测试GPU是否能用:

return torch.device("cuda" if torch.cuda.is_available() else "cpu")

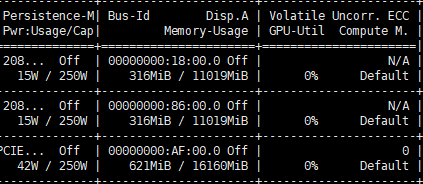

我知道 有tf的类似的函数,但是为啥子呢??之前出现一大堆东西我还以为能用GPU,如下

但是我在下面看到了False,我恍然大悟,卧槽,我没在nohup.out中返回,下面直接在python3下测试

xx=tf.test.is_gpu_available()

>>> xx

False

卧槽,难道卸载重装cudnn,还是啥玩意,这特么也是个工程啊。。、

群里大佬推荐用anaconda安装,问题是我试了多个anaconda版本,连安装都不能成功,谈何解决问题?

为何我的打开方式总是与别人不一样?

说不出的人生艰难。

另外有相关问题可以加入QQ群讨论,不设微信群

QQ群:868373192

语音深度学习群