比赛还有3天ddl 实在没空

水一下 啃一下老本

“你学了3遍SVM了,你应该会SVM了”(然而并不会,我这写的是啥我已经完全不记得了,(可能当时就不懂吧,以后再看吧55555))

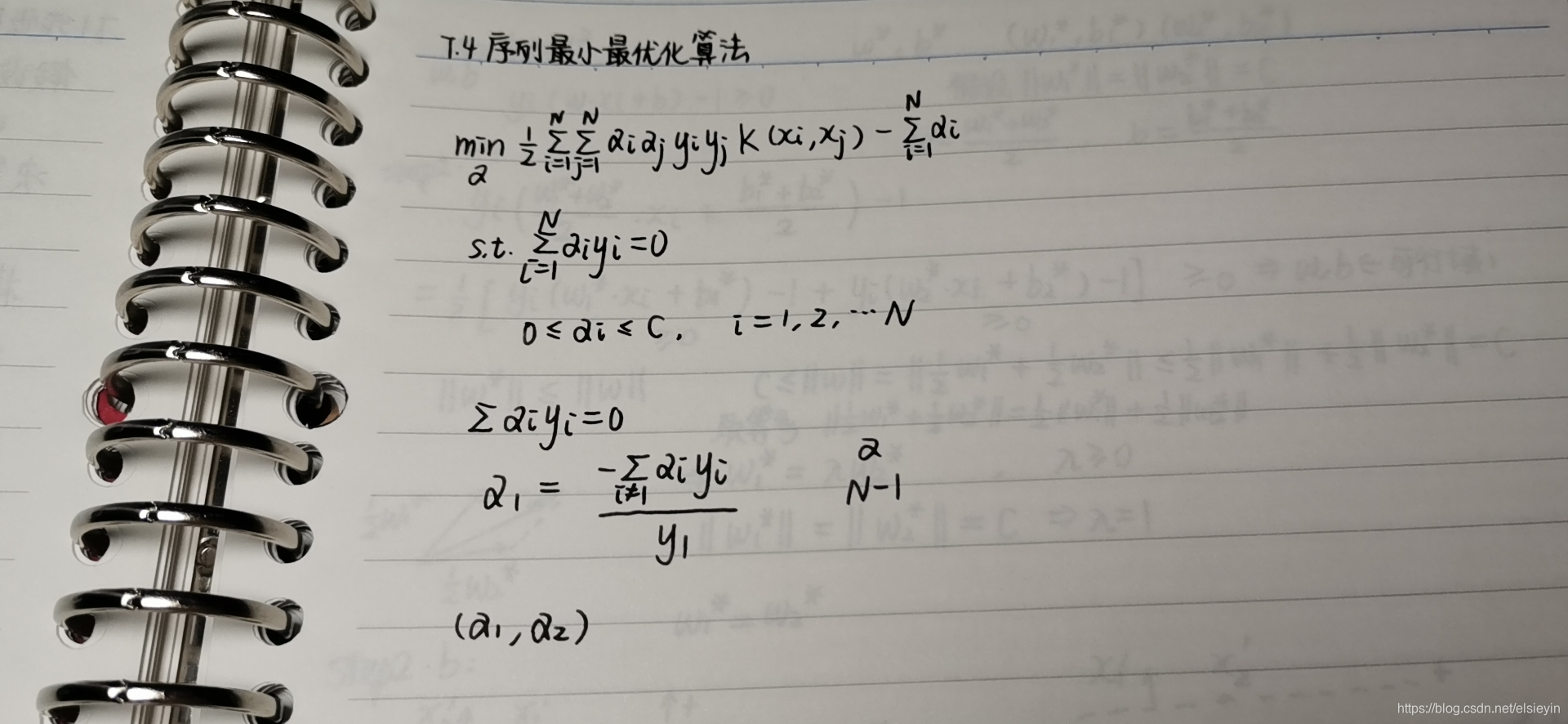

smo一直不会,收藏了一篇博文

,以后在学了

大概学了3遍SVM

好像还是不太会

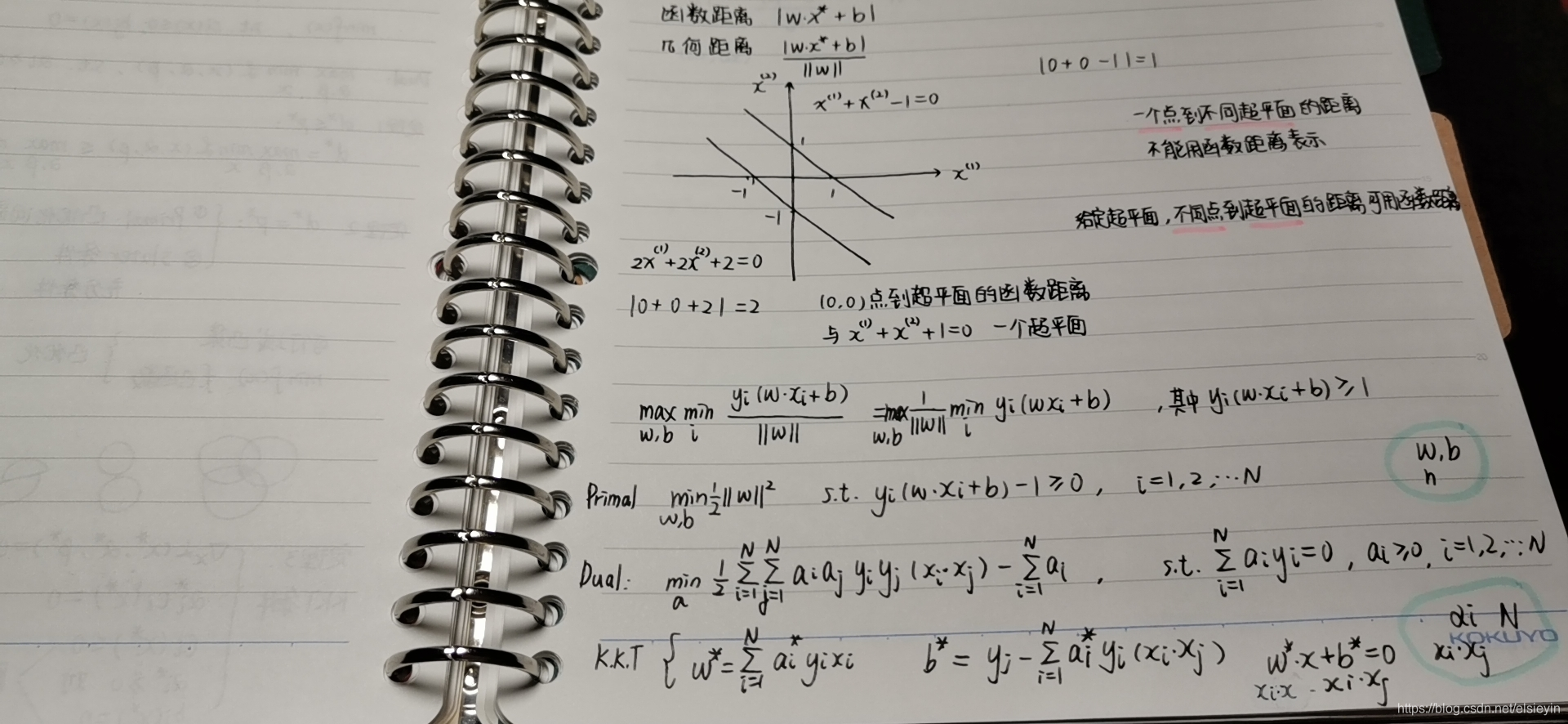

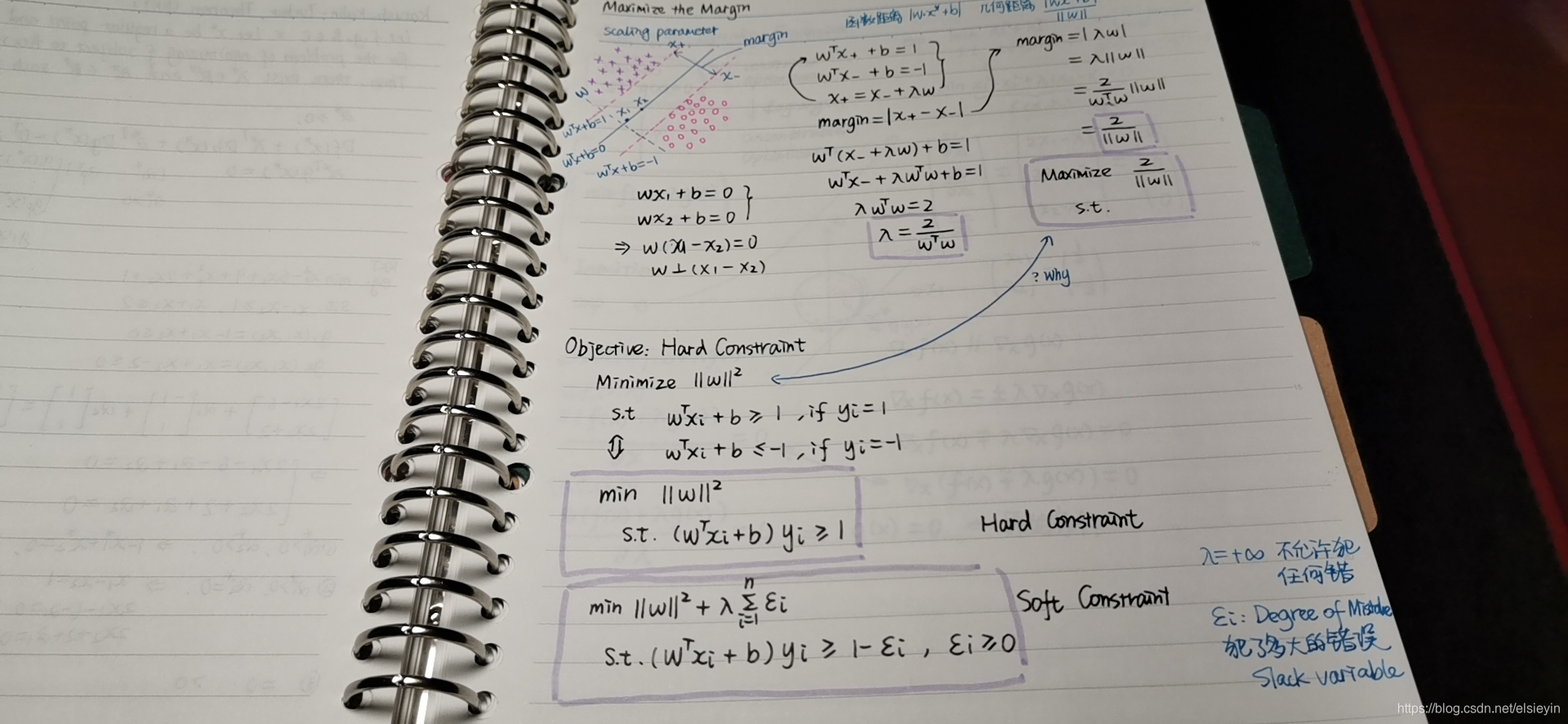

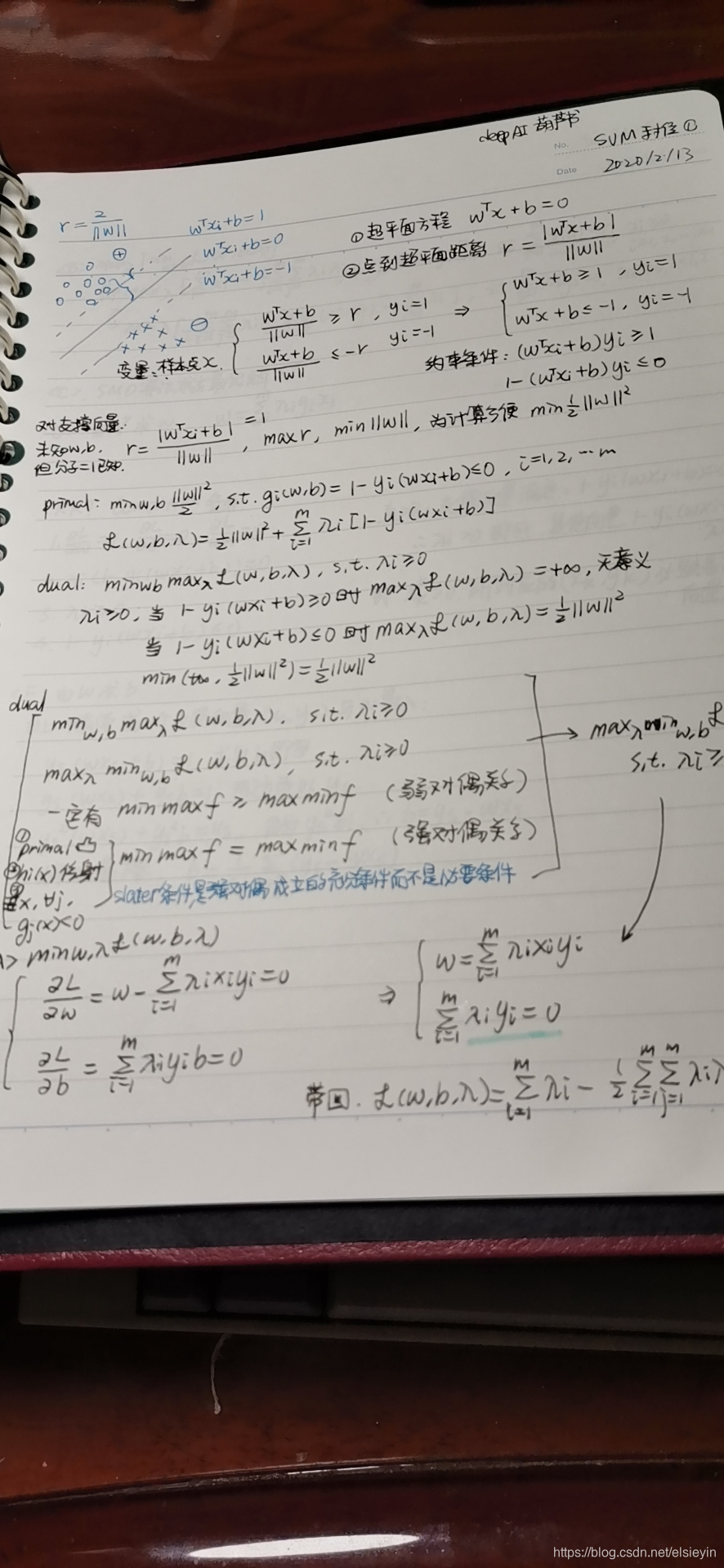

一般说SVM有三宝:对偶 间隔 核技巧

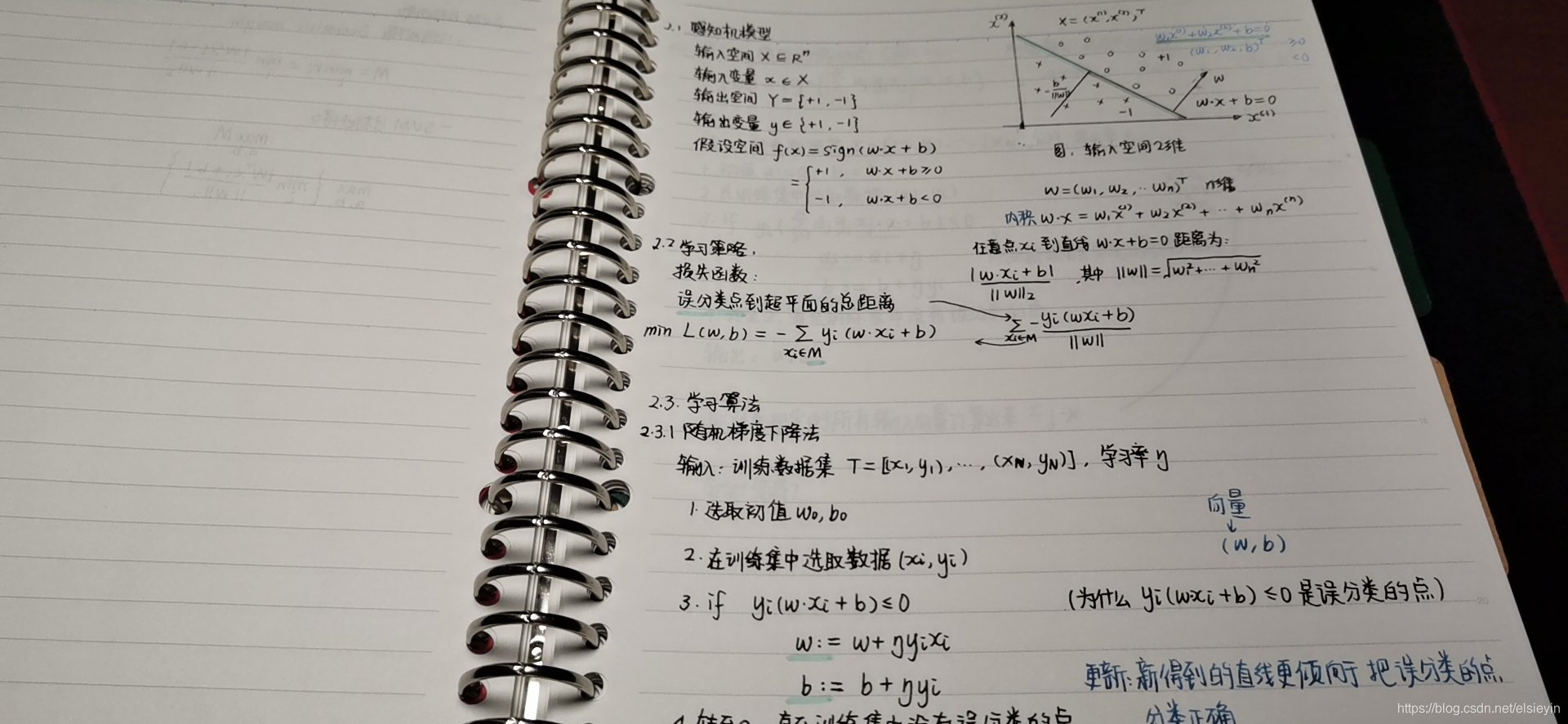

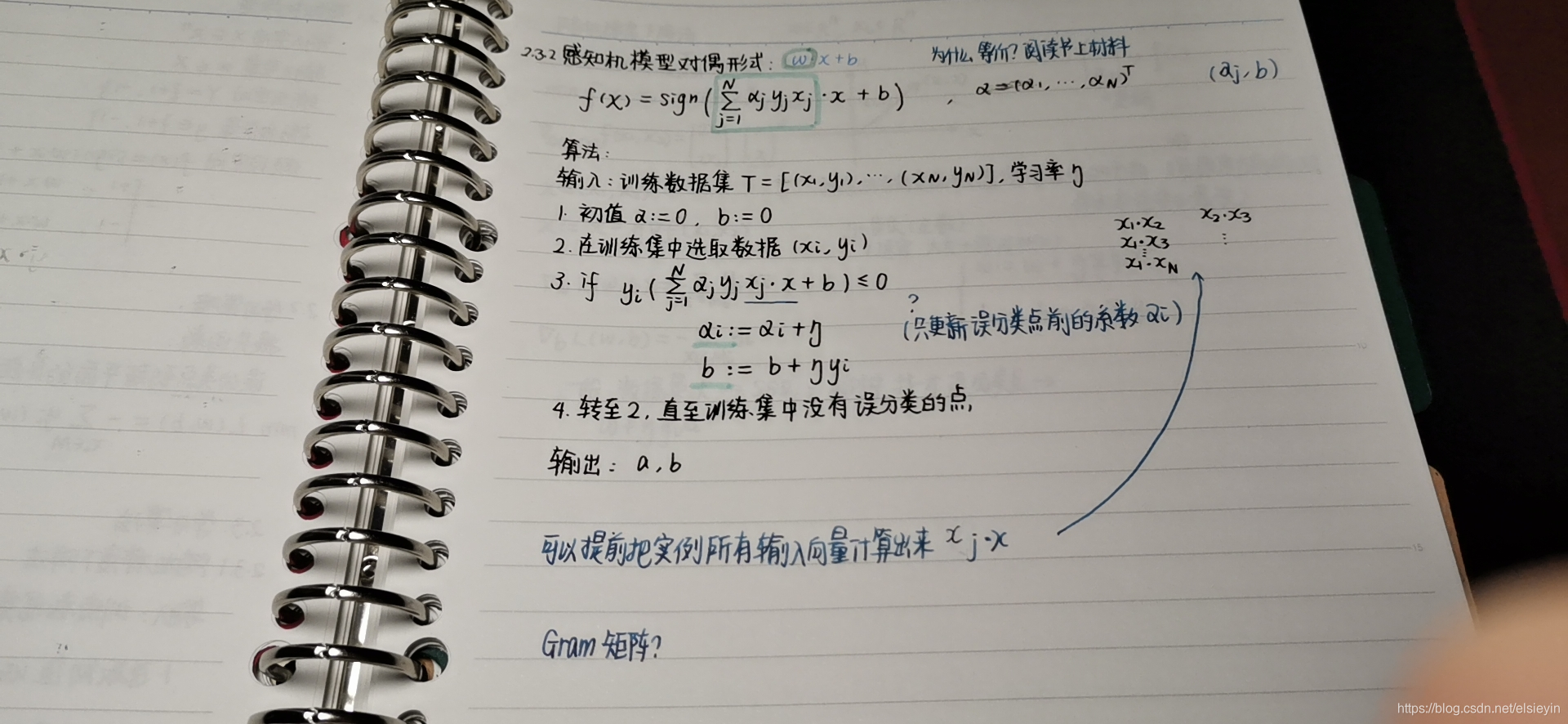

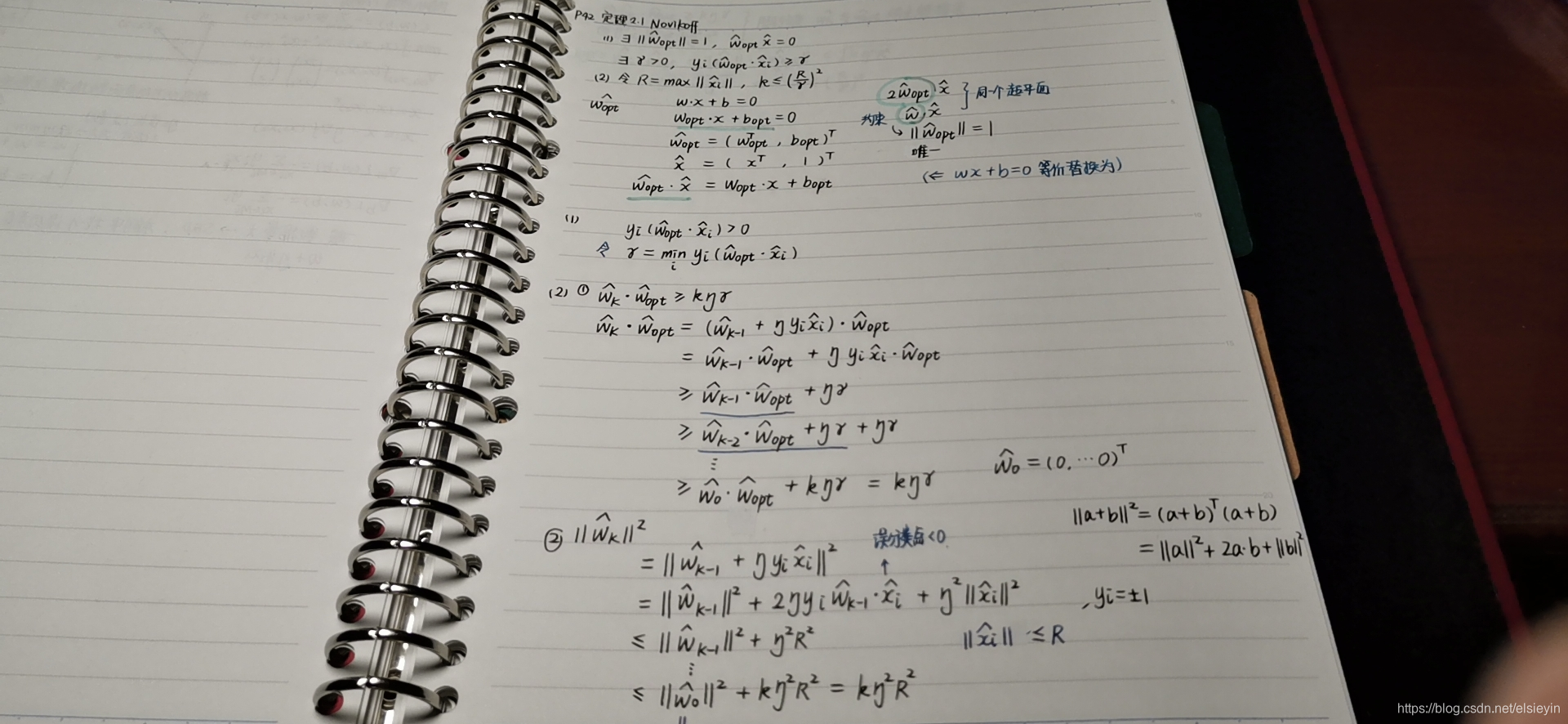

感知机

这里先写一下感知机,感觉两者有丢丢像

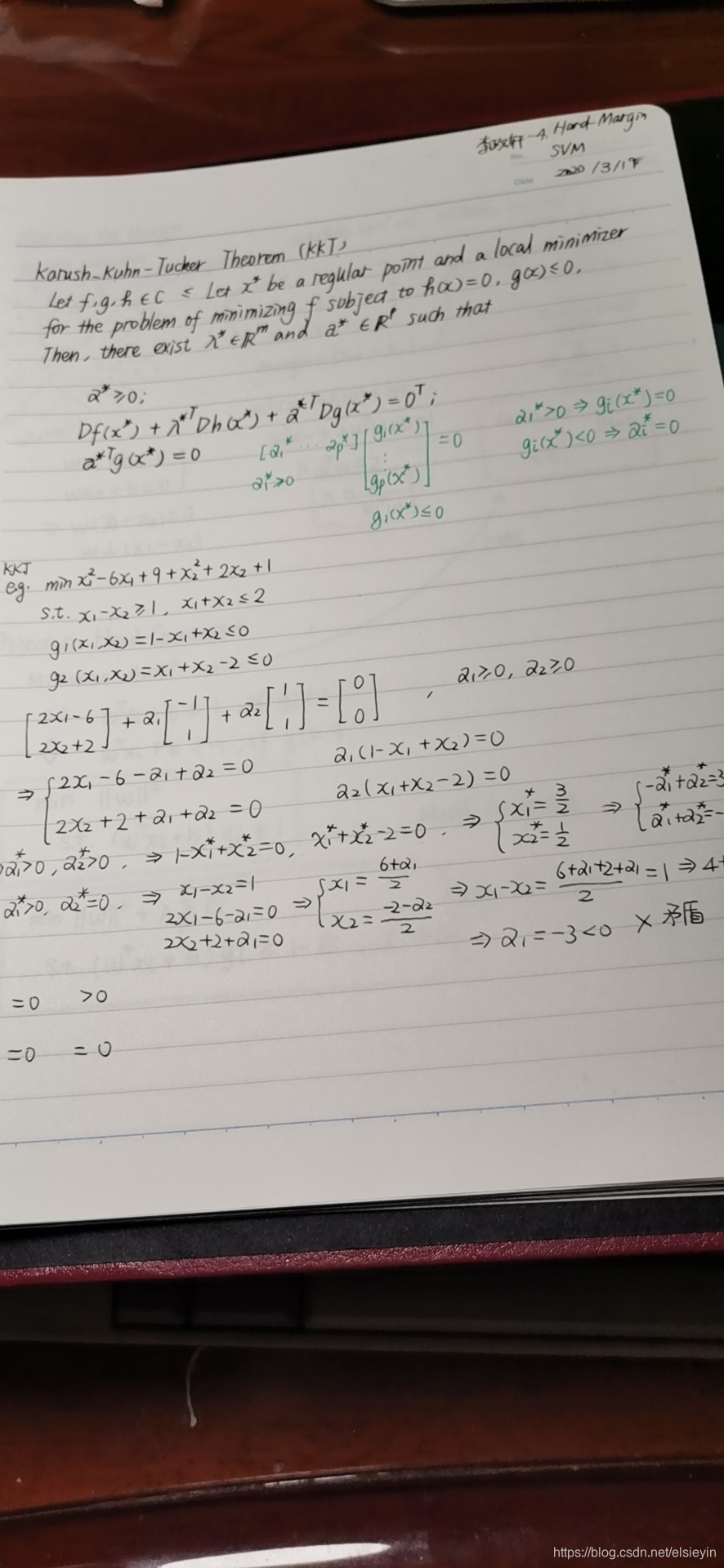

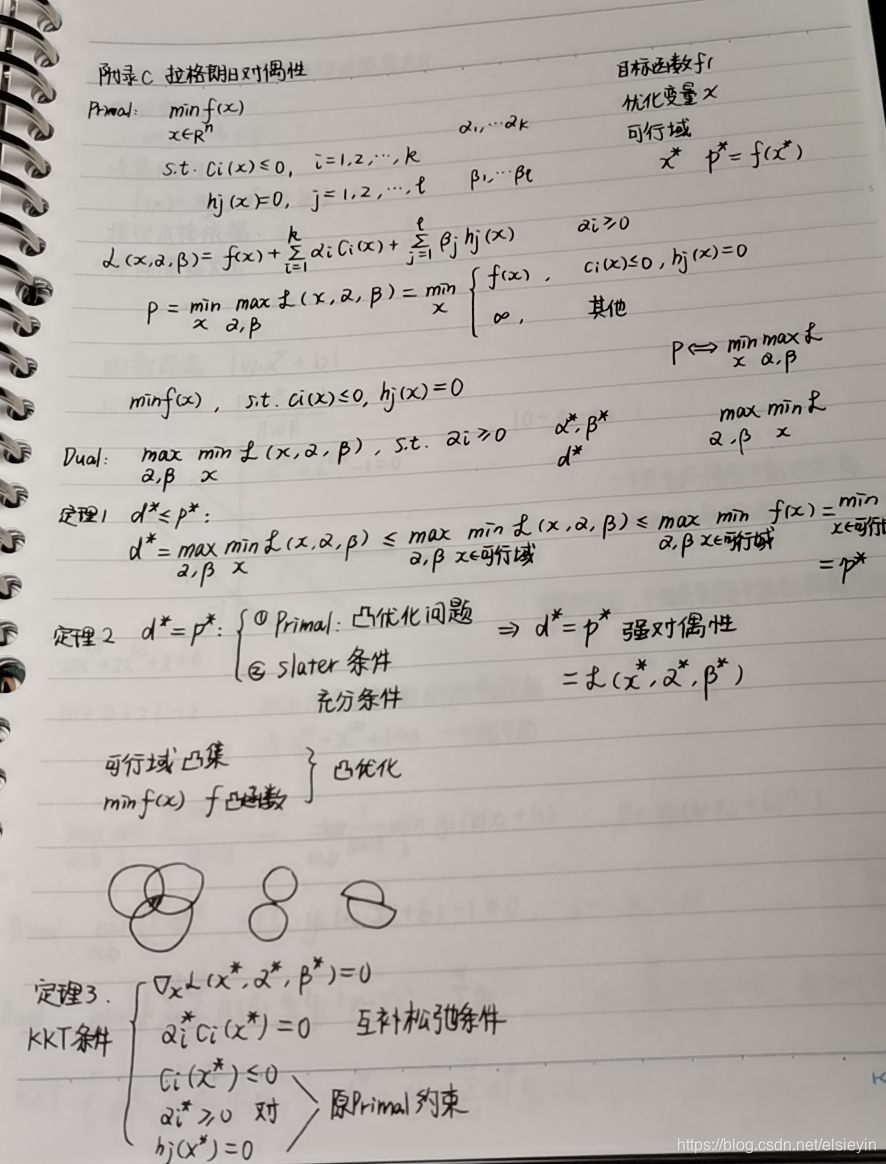

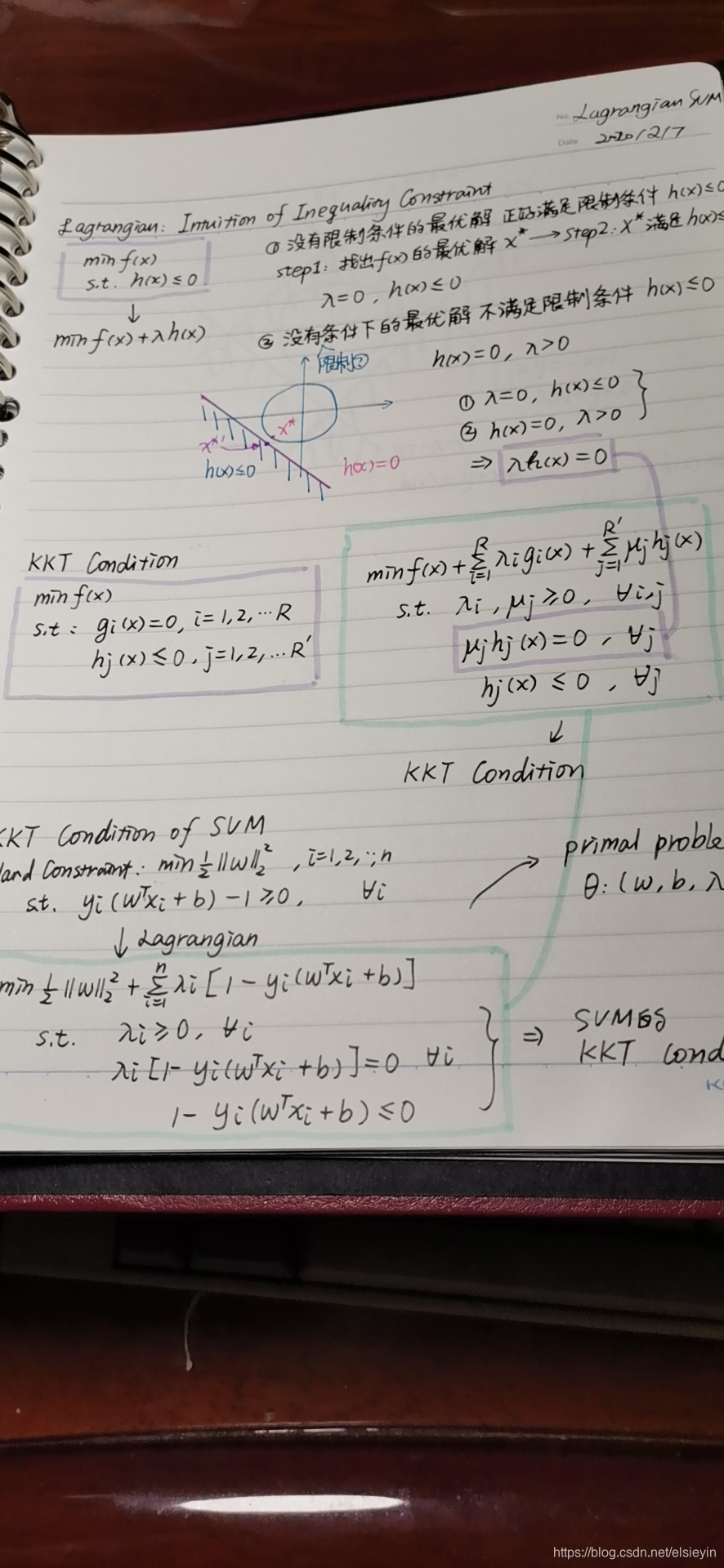

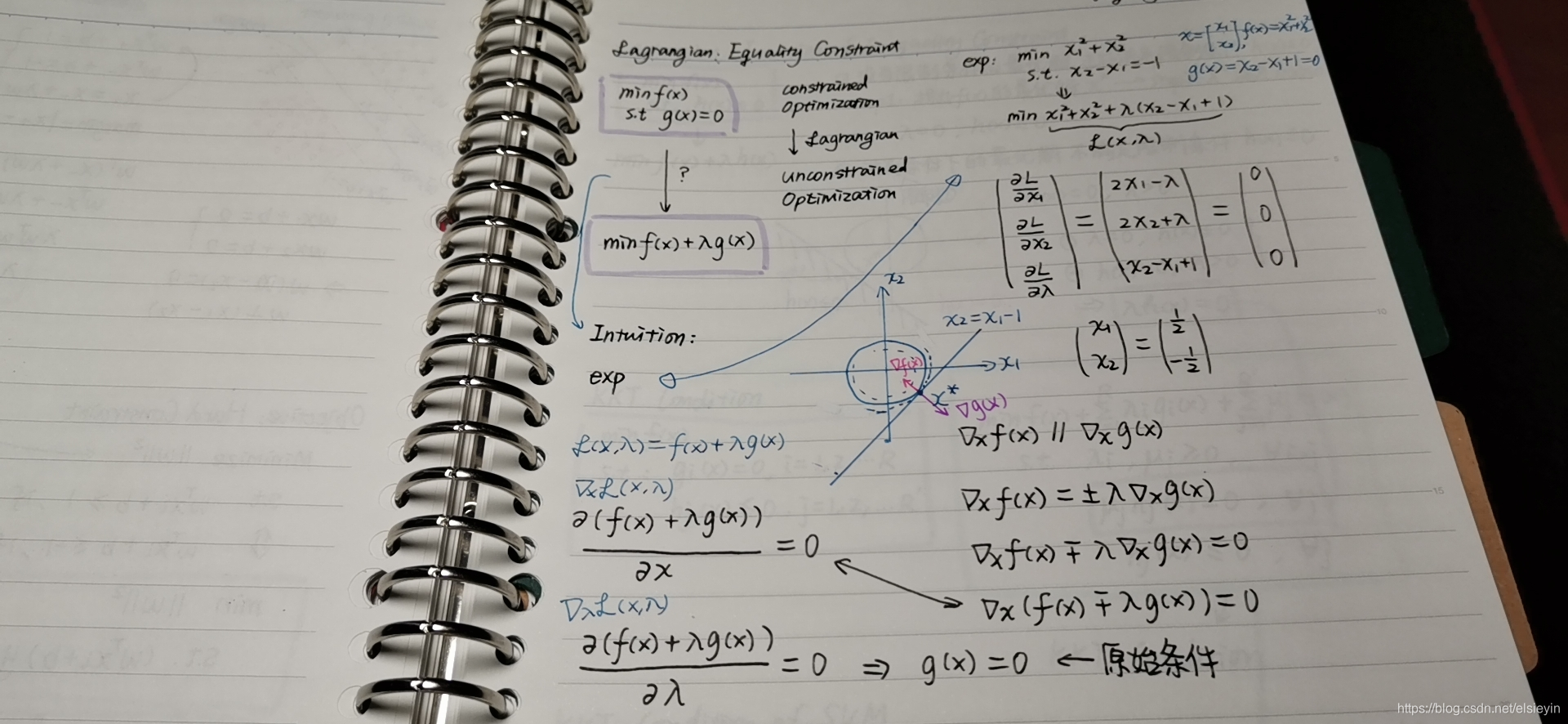

拉格朗日对偶性

这一块到现在也不是很掌握

但是确实是SVM的核心内容之一 事实上该方法在很多地方都有使用,为什么原问题要转化为对偶问题呢?

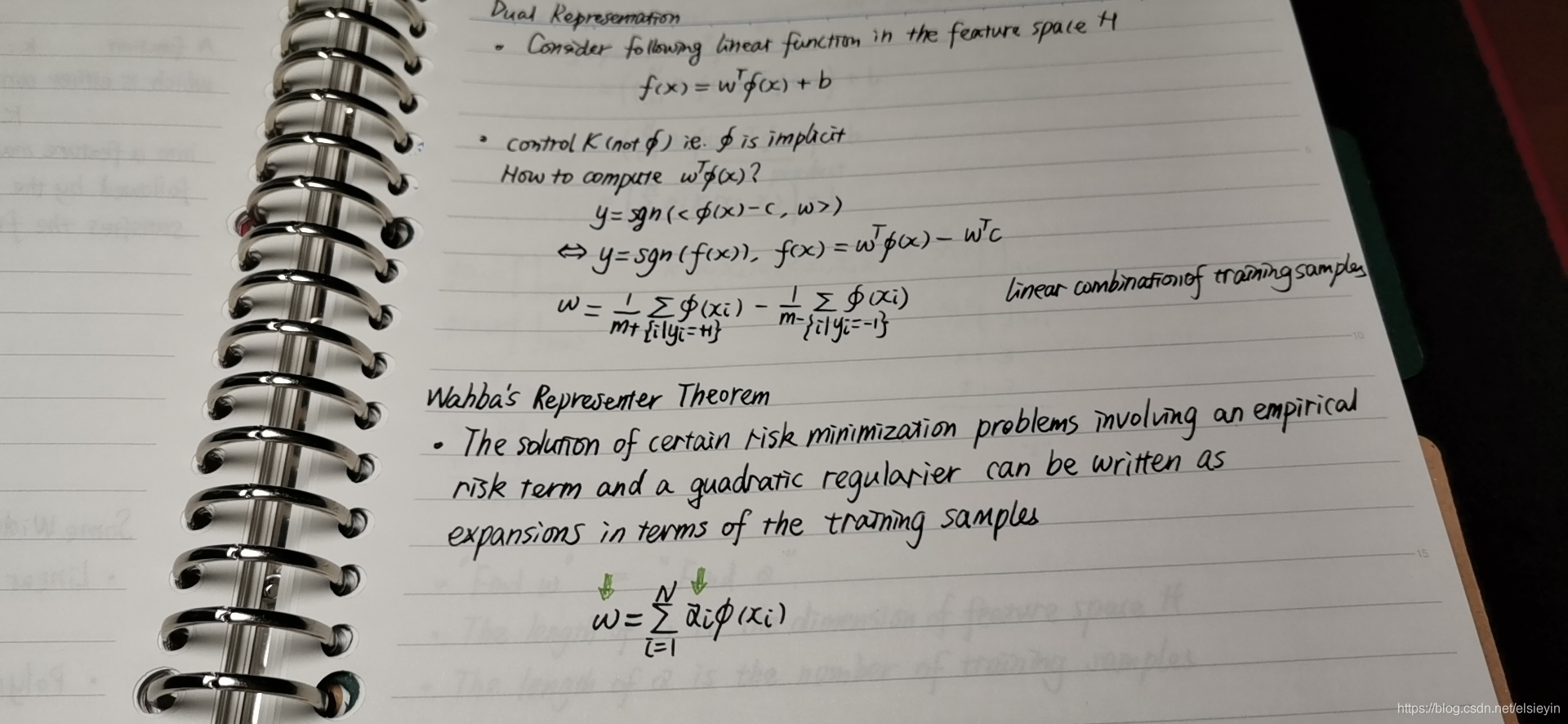

这一块朋友的回答是这样的,待考证:对偶在满足kkt条件下有一个非常非常好的性质对偶的duality函数最优值等于primal 函数最优值。且对偶不管原函数是否为convex,换成拉格朗日对偶就是convex的。有一点对偶求出来了x的转置乘以x可以用核函数表示,也就是说,可以找到一个核函数映射到再生希尔伯特空间,你不需要找到映射关系是怎样的,你只管核函数是怎样的就可以转化为高维空间,在高维空间里面进行线性不可分的分割,所以要用对偶。当然你也可以不用对偶,直接用辛吉函数导出来的那个函数直接优化,只是求导的时候比较麻烦。还有的书上说当维度大于样本的时候对偶方法不一定快过直接求损失函数方法。拉格朗日对偶还有一种用法,就是对偶的最优值是原函数最优值的下界,也就是说dstar小于等于pstar,可以用这个性质来确定优化中,原函数最优值里最优值还有多少距离。不满足kkt条件下也适用。

啥意思呢?反正我是看不懂。

简单理解

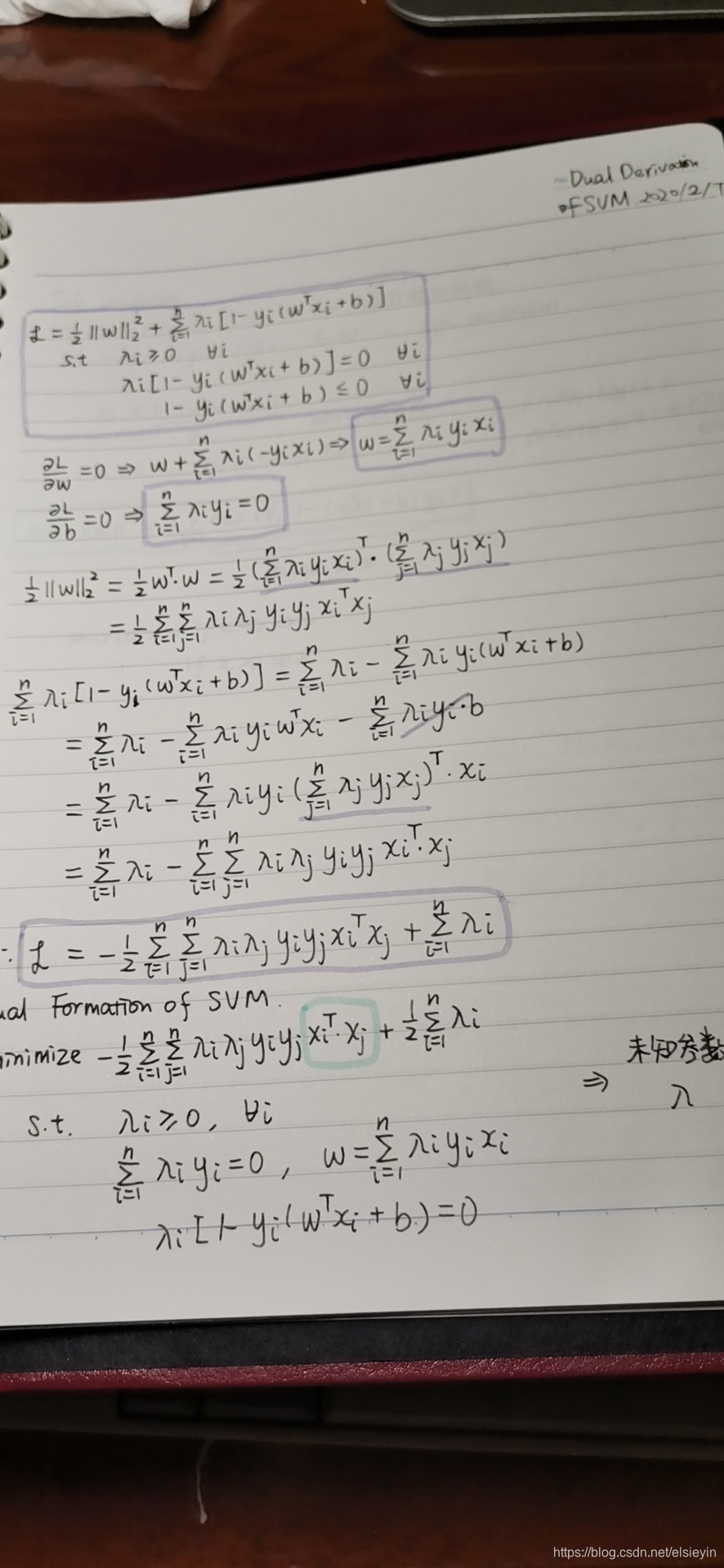

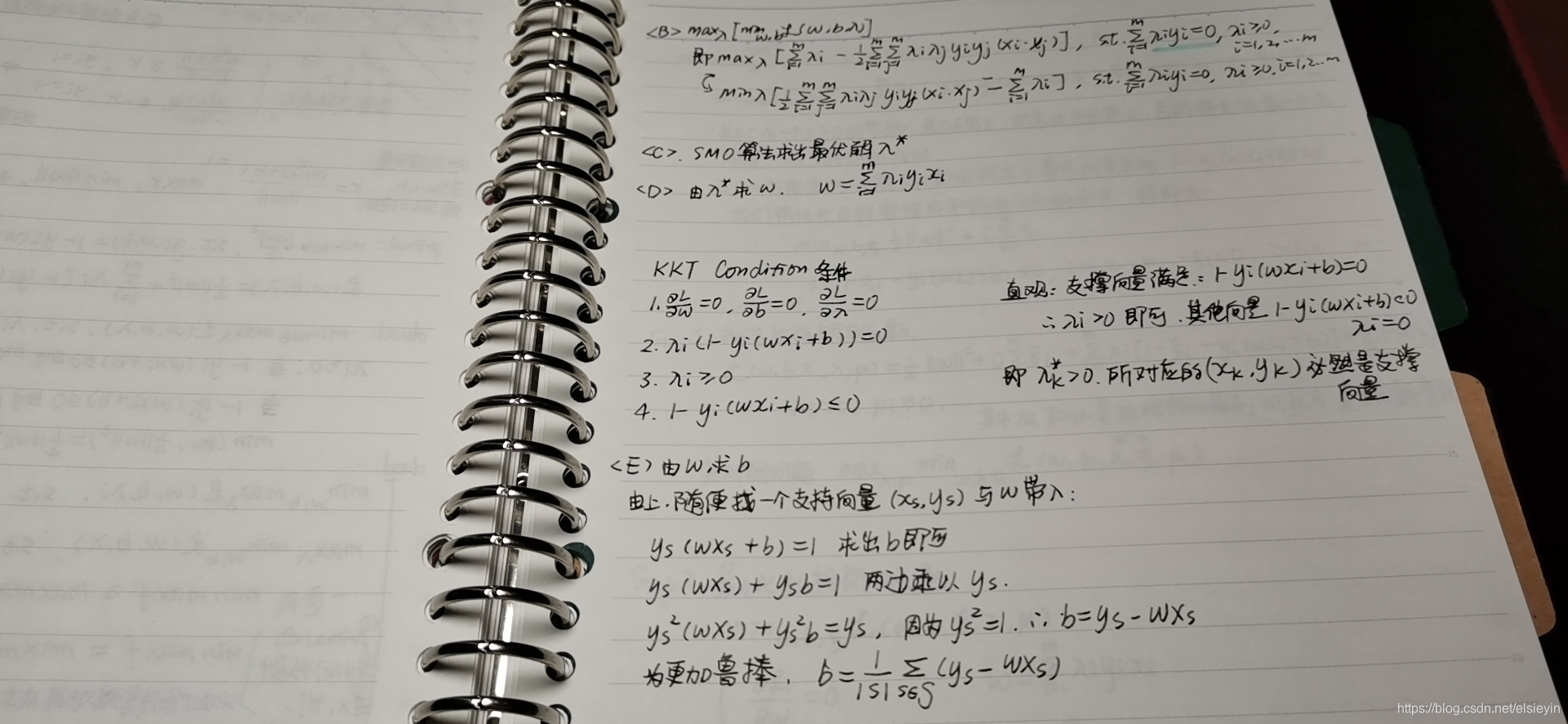

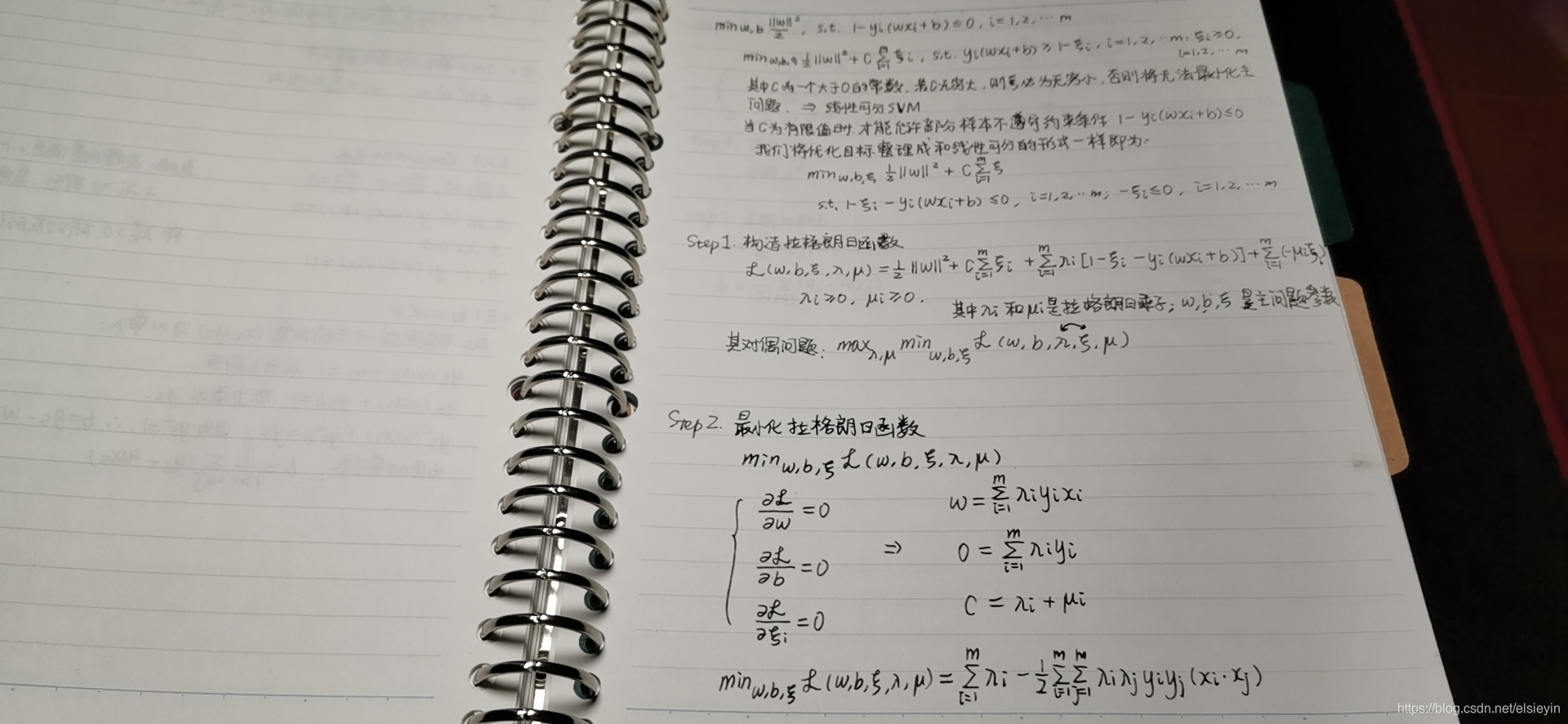

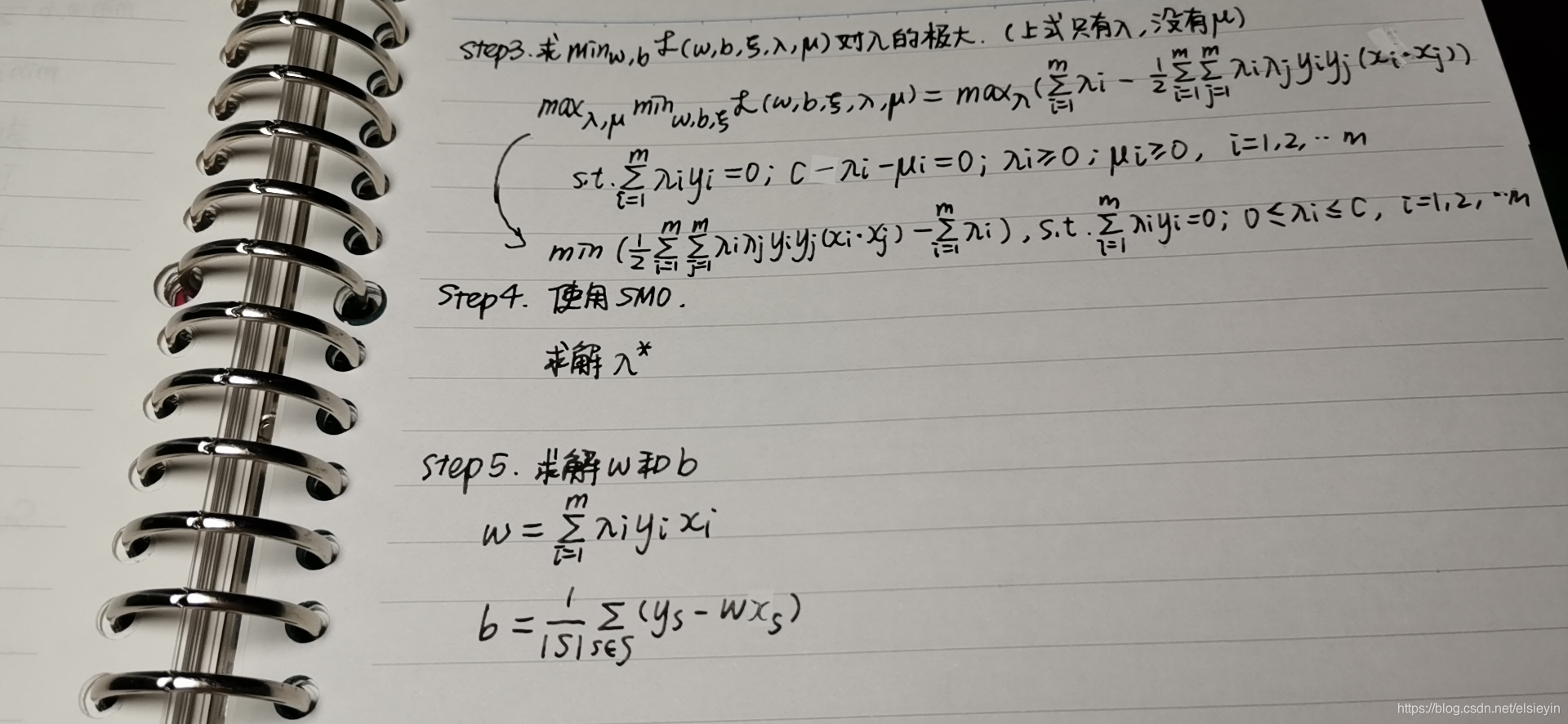

Dual Derivation

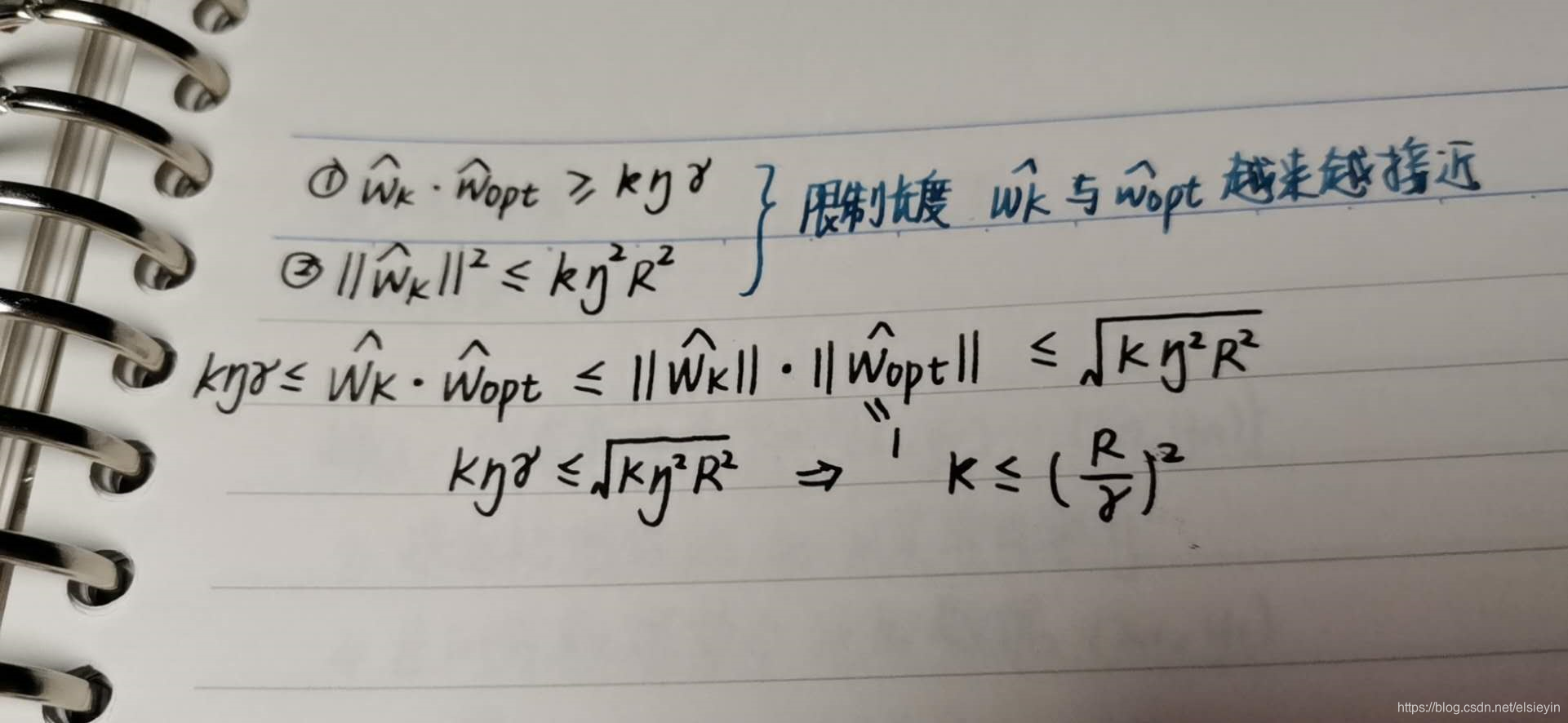

串起来一气呵成推一遍

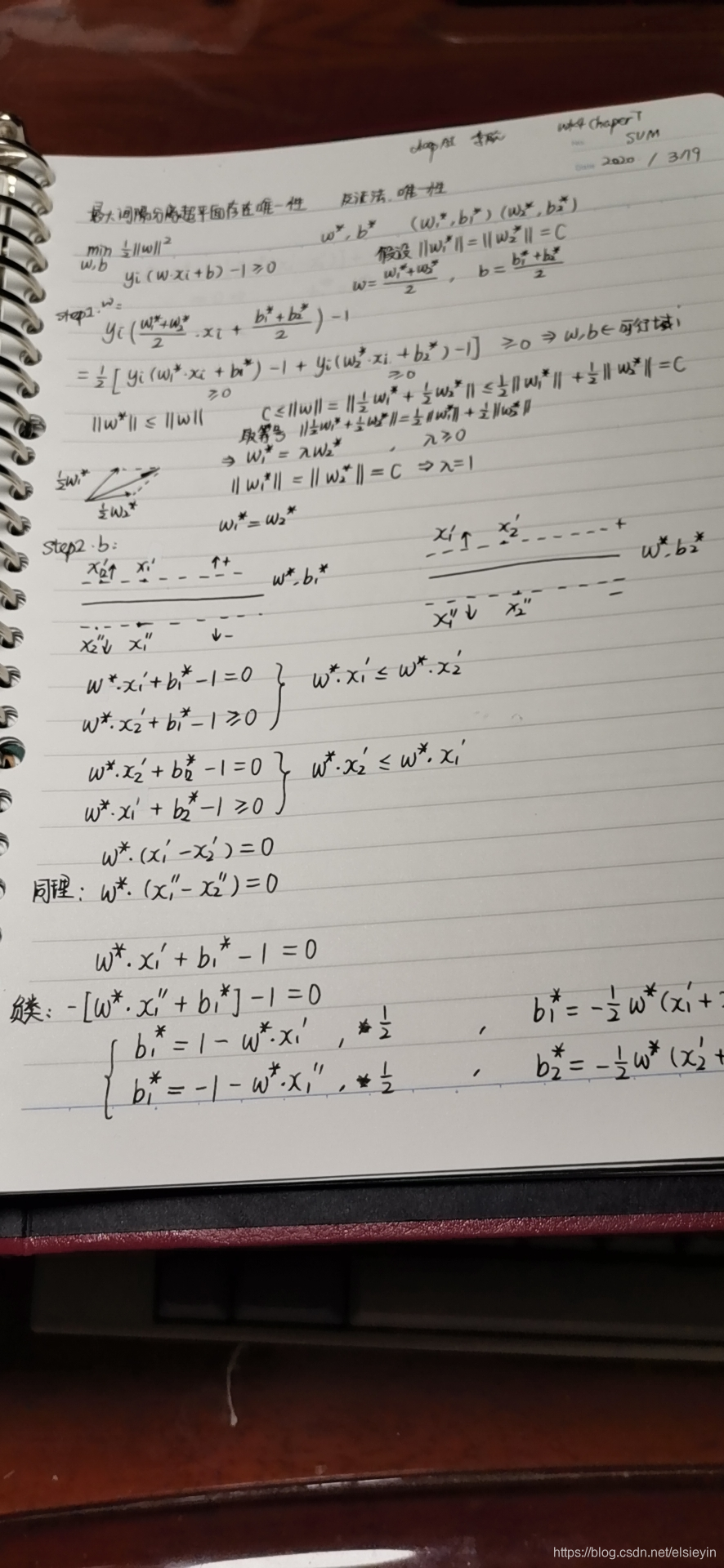

最大分离超平面存在唯一性证明

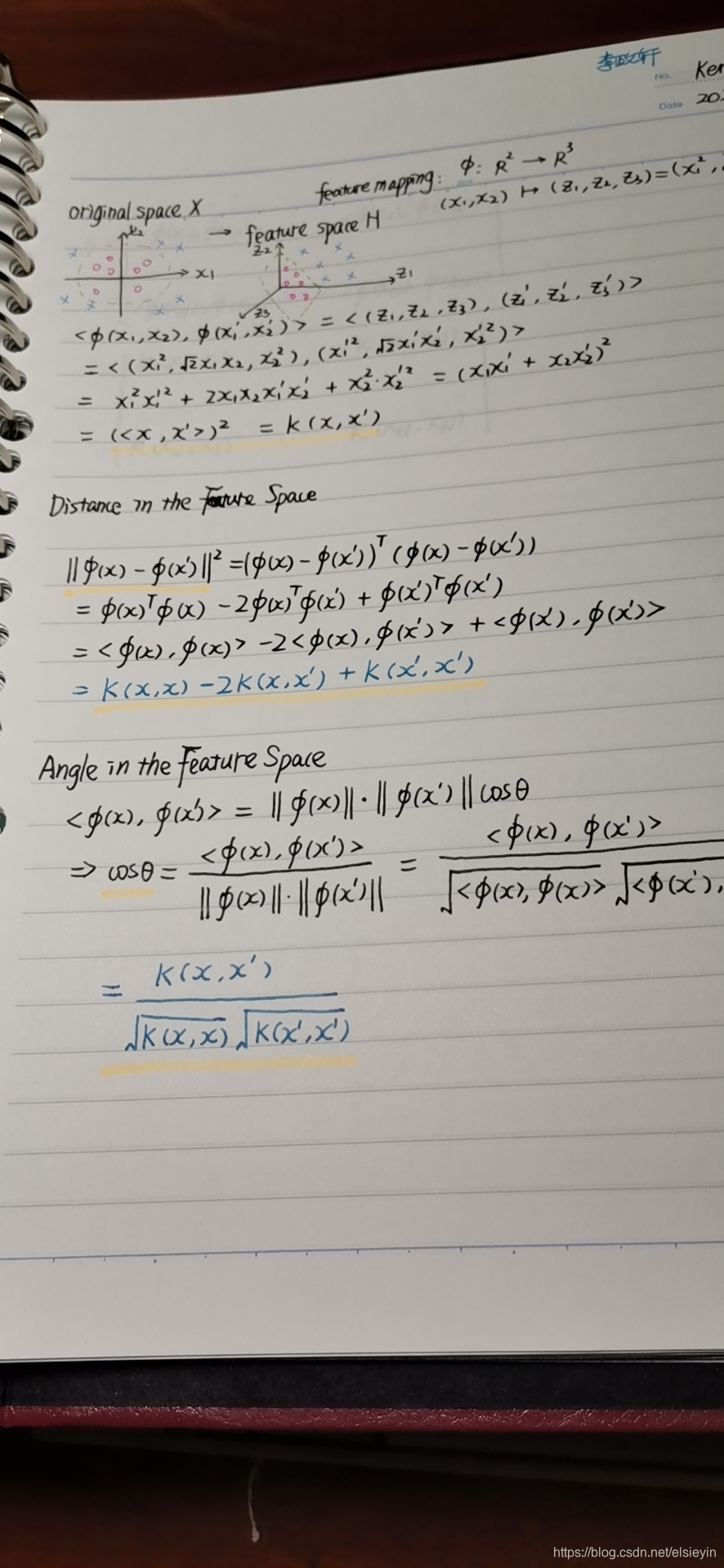

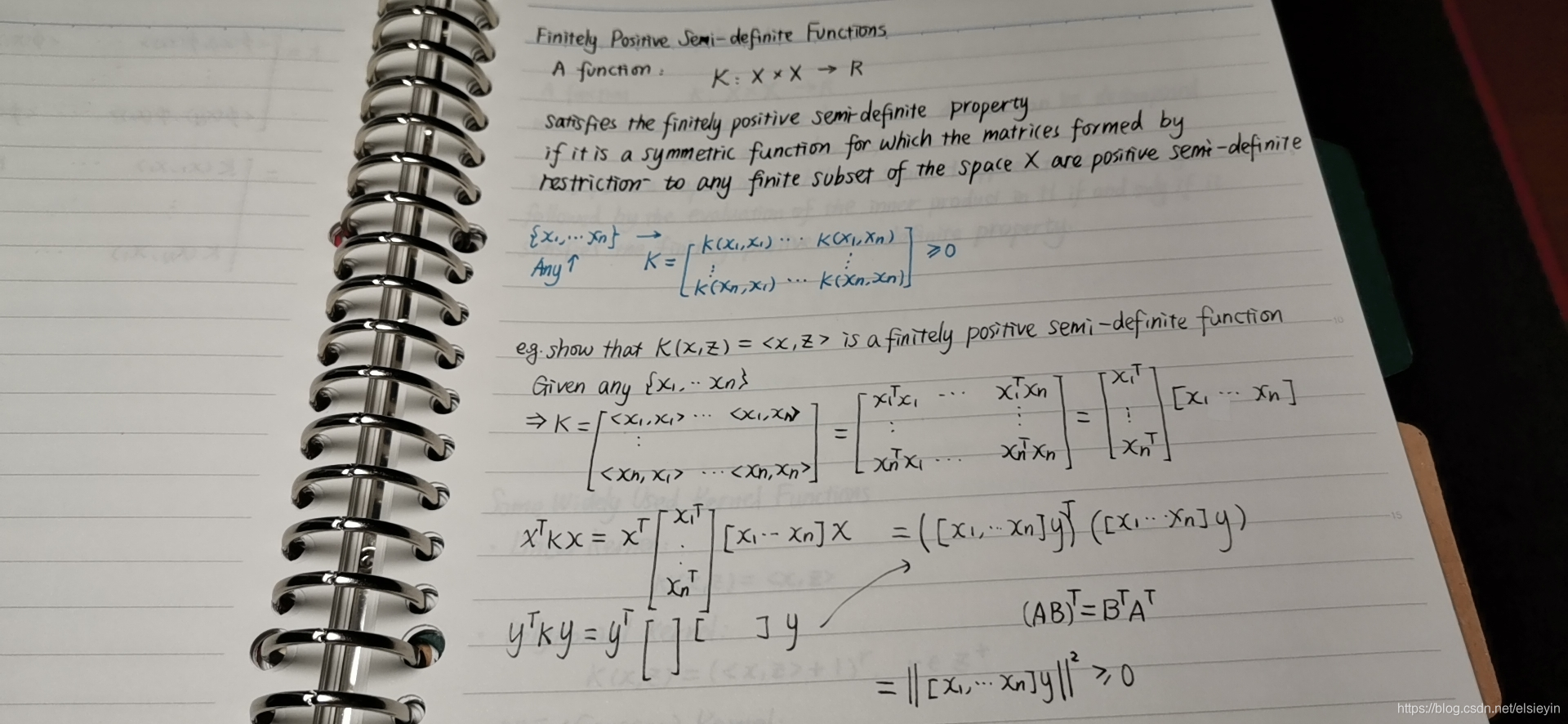

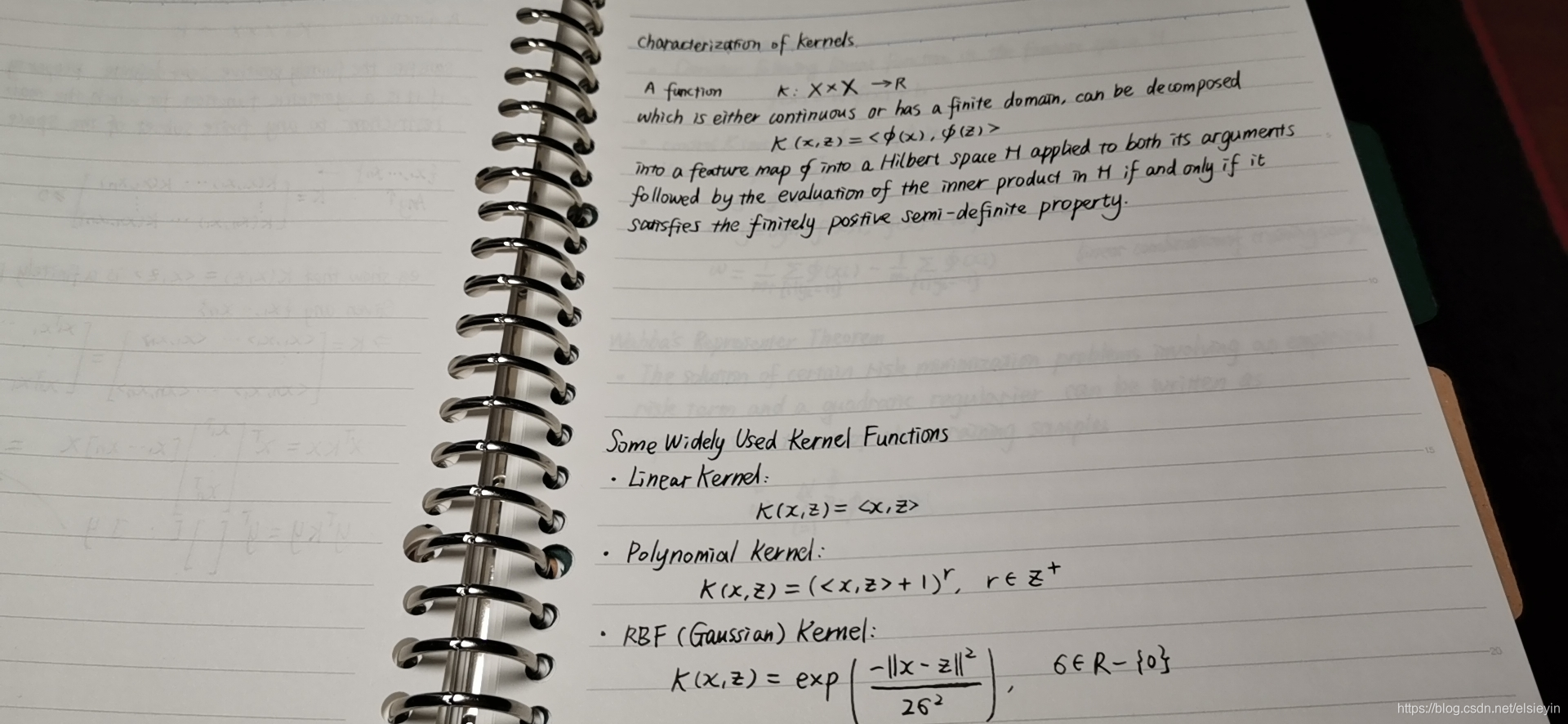

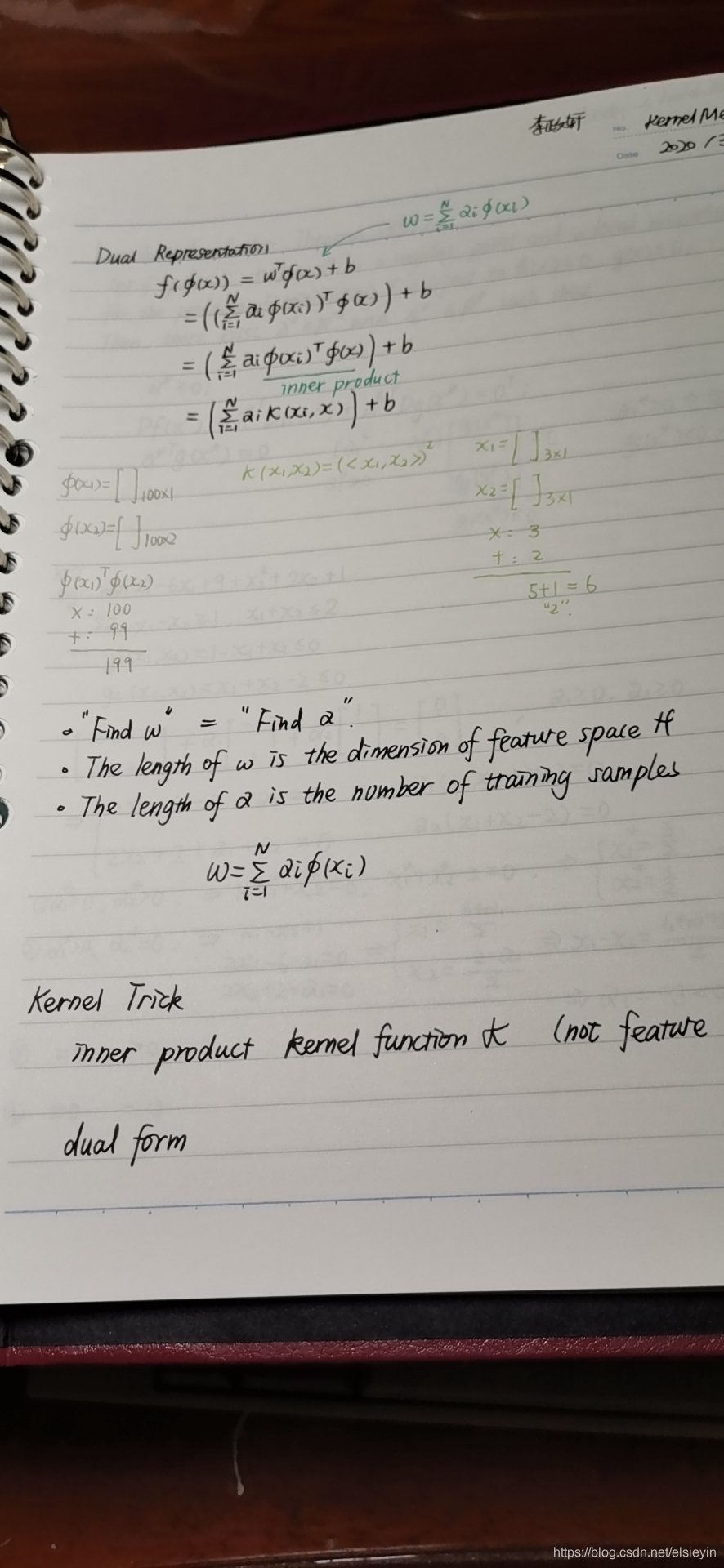

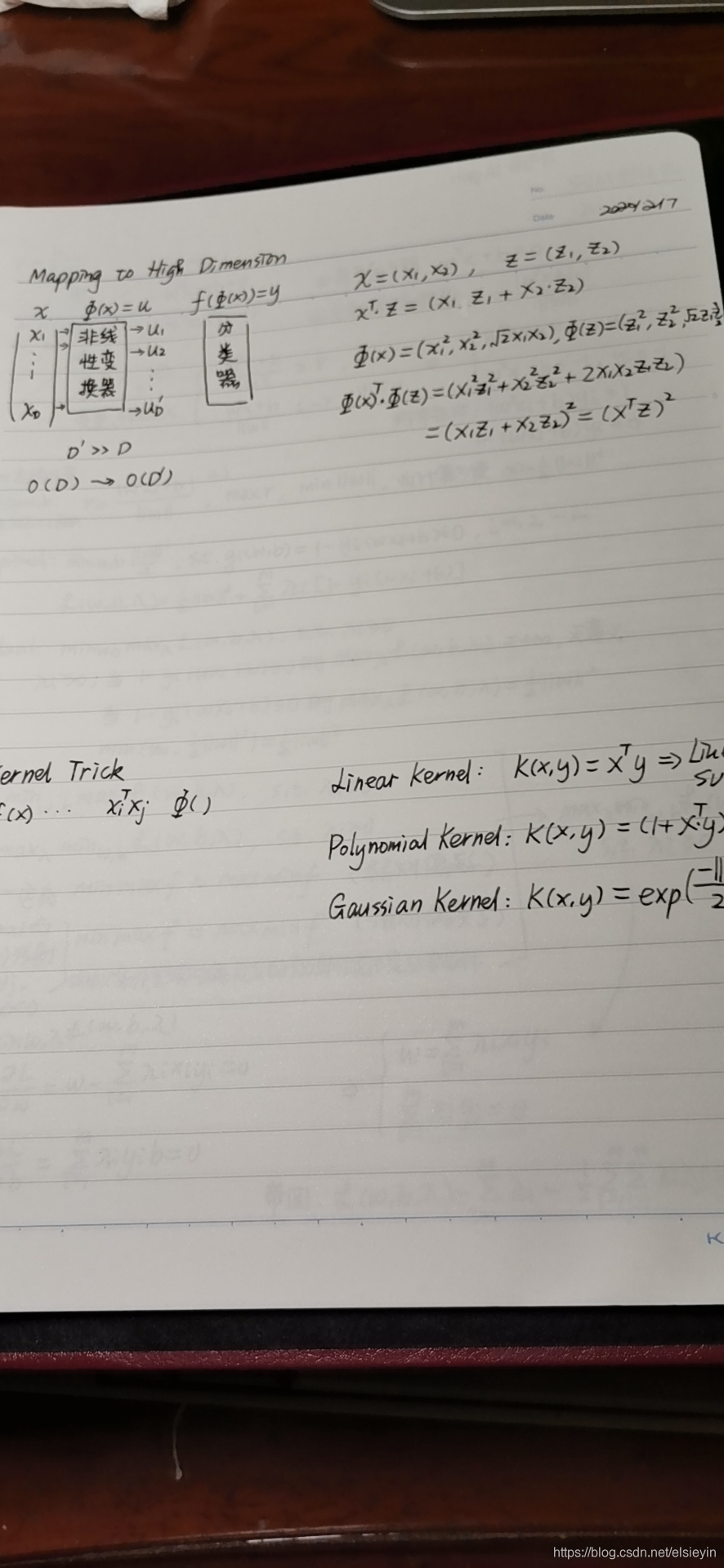

Kernel Method

这一块我看的是台大李老师的 还挺清楚 看完就忘