本人初学小白,如内容有误望批评指正。

此博文内容为私人笔记,转载请标明出处。

R-CNN

核心思想:是对每张图片选取多个区域,然后对每个区域样本进行卷积神经网络,来抽取特征,最后使用分类器来对齐分类和一个回归器来得到准确的边框。

模型:

1.输入原图产生感兴趣的区域也可能是含有目标的候选区域(selective search)

2.将候选的区域改变成到固定大小(本文为适应AlexNet将建议框变形为227*227)

3.将改变大小后特征图输入到CNN网络中,CNN会提取出固定维度的特征向量

4.将向量输入到训练好的SVM分类器,分类器输出图像的类别,并进行目标定位,已经对位置进行精修

selective search:采取过分割手段,将图像分割成小区域,再通过颜色直方图,梯度直方图相近等规则进行合并,最后生成约2000个建议框的操作

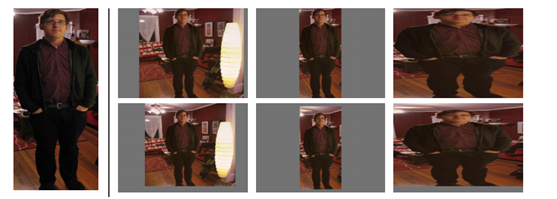

如何变形到固定大小:

① 考虑context【图像中context指RoI周边像素】的各向同性变形,建议框像周围像素扩充到227×227,若遇到图像边界则用建议框像素均值填充,下图第二列;

② 不考虑context的各向同性变形,直接用建议框像素均值填充至227×227,下图第三列;

③ 各向异性变形,简单粗暴对图像就行缩放至227×227,下图第四列;

④ 变形前先进行边界像素填充【padding】处理,即向外扩展建议框边界,以上三种方法中分别采用padding=0下图第一行,padding=16下图第二行进行处理;

创新点:

1.采用CNN网络提取图像特征,从经验驱动的人造特征范式HOG、SIFT到数据驱动的表示学习范式,提高特征对样本的表示能力;

2.采用大样本下有监督预训练+小样本微调的方式解决小样本难以训练甚至过拟合等问题。

3、 训练占空间

缺点:

1.处理速度慢,一张图片会因selective search算法得出2k建议框且每个建议框都需要进行CNN处理,而其中大部分属于重复。

2.测试过程复杂,要先提取建议框,之后提取每个建议框CNN特征,再用SVM分类,做非极大值抑制,最后做bounding-box回归才能得到图片中物体的种类以及位置信息;同样训练过程也很复杂,ILSVRC 2012上预训练CNN,PASCAL VOC 2007上微调CNN,做20类SVM分类器的训练和20类bounding-box回归器的训练;这些不连续过程必然涉及到特征存储、浪费磁盘空间等问题。

其他:

1.图像分类,图像定位,目标检测实力分割理解

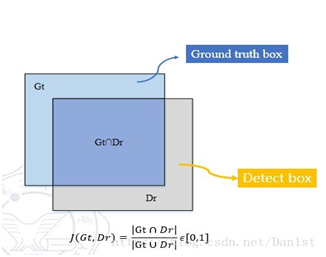

2.IOU(IoU即表示(A∩B)/(A∪B))

3. 有监督预训练也称之为迁移学习,举例说明:若有大量标注信息的人脸年龄分类的正负样本图片,利用样本训练了CNN网络用于人脸年龄识别;现在要通过人脸进行性别识别,那么就可以去掉已经训练好的人脸年龄识别网络CNN的最后一层或几层,换成所需要的分类层,前面层的网络参数直接使用为初始化参数,修改层的网络参数随机初始化,再利用人脸性别分类的正负样本图片进行训练,得到人脸性别识别网络,这种方法就叫做有监督预训练。

4.非极大抑制:如下图有多组候选框,分别编号A,B,C,D,E,F

(1)从最大概率矩形框F开始,分别判断A~E与F的重叠度IOU是否大于某个设定的阈值;

(2)假设B、D与F的重叠度超过阈值,那么就扔掉B、D;并标记第一个矩形框F,是我们保留下来的。

(3)从剩下的矩形框A、C、E中,选择概率最大的E,然后判断E与A、C的重叠度,重叠度大于一定的阈值,那么就扔掉;并标记E是我们保留下来的第二个矩形框。

就这样一直重复,找到所有被保留下来的矩形框。

Fast R-CNN

基础:CNN

核心思想:是R-CNN的改进版

背景:R-CNN训练过程复杂且目标检测速度较慢(原因是R-CNN中在检测过程中每个步骤只进行传递而不共享)

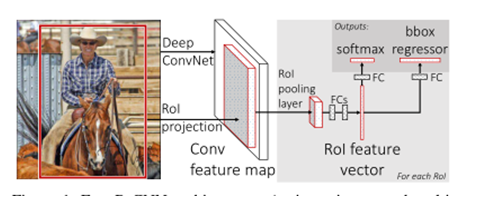

模型:

1.使用卷积网络提取图片特征

2.筛选2K的候选框(ROI)

3. 在conv5出来的feature map上,根据之前RoI框crop出对应的patch(也就是所谓的映射回了原图),再用Rol pooling layer(好像也就是一个单层的SPP layer)来统一到一样的尺度;

4.经过两个全连接层得到一个分类(最大概率估计)和回归(边界框位置)

ROI Pooling层:它可以在任意大小的图片feature map上针对输入的每一个ROI区域提取出固定维度的特征表示,保证后续对每个区域的后续分类能够正常进行。

RoI Pooling层将每个候选区域均匀分成M×N块,对每块进行max pooling,这样一来将feature map上大小不一的候选区域转变为了大小统一的特征向量,然后送入下一层。

(ROI pooling是针对ROI区域的特征图进行的操作,因此尺寸不是固定输入需要手动计算)

全连接层具有提速作用

分类:

不再像R-CNN需要通过SVM等分类器来分类,Fast R-CNN使用神经网络来进行分类操作:输出K+1维数组pp,表示属于K类和背景的概率,这是针对每个ROI区域的分类概率预测,p=(p0,p1,⋯,pK)p=(p0,p1,⋯,pK);

分类代价由真实分类uu对应的概率决定,损失函数定义如下:

Lcls=−log(pu)

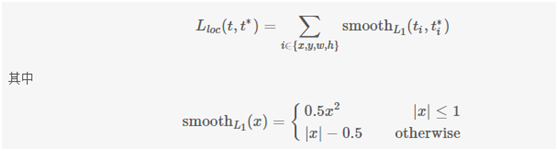

回归:

假设对于类别,在图片中标注了一个groundtruth坐标:,而预测值为 ,二者理论上越接近越好,这里定义损失函数:

这里的回归操作和R-CNN里一样,也是只对特定的候选框(即和Ground Truth的IoU大于特定thresh)进行

改进:

1.很大程度上实现了end to end(除了region proposals的产生还是用的selective search)。

2.不再是将region proposals依次通过CNN,而是直接输入原图,来提取特征(这样一张图只会CNN一次)。

3.网络同时输出类别判断以及bbox回归建议(即两个同级输出),不再分开训练SVM和回归器。

优势 :提高训练和测试速度同时提升了精度

缺点:1、 依旧用SS提取RP(耗时2-3s,特征提取耗时0.32s);

2、 无法满足实时应用,没有真正实现端到端训练测试;

3、 利用了GPU,但是区域建议方法是在CPU上实现的。

其他:

1.“end-to-end”(端到端)说的是,输入的是原始数据(始端),然后输出的直接就是最终目标(末端),中间过程不可知,因此也难以知。比如说,基于深度学习的图像识别系统,输入端是图片的像素数据,而输出端直接就是或猫或狗的判定。这个端到端就是:像素-->判定。

2.支持向量机:分类器

3.反向传播:沿着神经网络输出到输入,更新权重w。计算量要小很多

4. 在机器学习的上下文中,超参数是在开始学习过程之前设置值的参数,而不是通过训练得到的参数数据。通常情况下,需要对超参数进行优化,给学习机选择一组最优超参数,以提高学习的性能和效果。

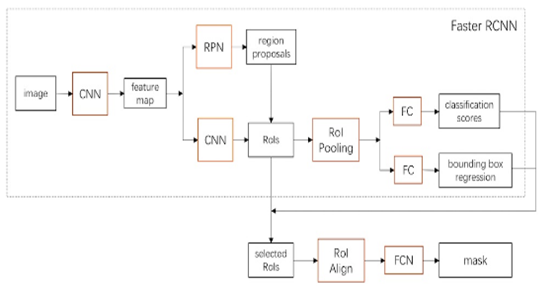

Faster R-CNN

核心思想:Fast R-CNN+RPN(区域生成网络)=Faster R-CNN

(Faster R-CNN是传统Fast R-CNN的一种加速最主要解决的如何快速获得 proposal)

背景:以往的做法都是利用显著性目标检测(如Selective search)过一遍待检测图,得到proposal。基于区域的深度卷积网络虽然使用了 GPU 进行加速,但是the region proposal methods 确却都是在 CPU上实现的,这就大大地拖慢了整个系统的速度。

模型:

检测基本流程:

具体流程:

RPN:

RPNs可以预测尺度和长宽比变化很大的region proposal

具体过程:使用一个小的网络在最后卷积得到的特征图上进行滑动扫描,这个滑动的网络每次与特征图上n*n 的窗口全连接,然后映射到一个低维向量,例如256D或512D, 最后将这个低维向量送入到两个全连接层,即box回归层(box-regression layer (reg))和box分类层(box-regression layer (reg))。对k个proposal进行参数化,相对应于k个参照box,我们称之为anchor。每个anchor集中于滑窗中心,关联一个尺度和一个长宽比.

(其实RPN最终就是在原图尺度上,设置了密密麻麻的候选Anchor。然后用cnn去判断哪些Anchor是里面有目标的foreground anchor,哪些是没目标的backgroud。仅仅是个二分类而已!)

训练:

PN可以由反向传播(back-propagation)和随机梯度下降(stochastic gradient descent, SGD)来进行端到端训练。我们使用“image-centric”取样策略来训练这个网络。每个mini-batch来自于一张图片,包含许多positive样本anchor和negative样本anchor。可以对所有anchor的损失函数进行优化,但是这样会偏袒negative样本。取而代之,我们在一张图片中随机取样256个anchor来计算一个mini-batch的损失函数,取样的positive anchor和negative anchor的比例在1:1之上。若一张图像没有128个positive样本,则用negative样本来补充。

其他:1.模型出现时间: R-CNN -> SPP-Net -> Fast R-CNN -> Faster R-CNN -> YOLO -> SSD -> R-FCN

2.尺度是大小(长宽比例不变)

具体解释:https://blog.csdn.net/bzdwdmzjsmff/article/details/52586709

3. 平移不变性比较好理解,在用基础的分类结构比如ResNet、Inception给一只猫分类时,无论猫怎么扭曲、平移,最终识别出来的都是猫,输入怎么变形输出都不变这就是平移不变性,网络的层次越深这个特性会越明显。平移可变性则是针对目标检测的,一只猫从图片左侧移到了右侧,检测出的猫的坐标会发生变化就称为平移可变性。当卷积网络变深后最后一层卷积输出的feature map变小,物体在输入上的小偏移,经过N多层pooling后在最后的小feature map上会感知不到,这就是为什么原文会说网络变深平移可变性变差。

4. 解决多尺度多长宽比问题方法;一种是使用图像金字塔,对伸缩到不同size的输入图像进行特征提取,虽然有效但是费时;另一种是使用滤波器金字塔或者滑动窗口金字塔,对输入图像采用不同size的滤波器分别进行卷积操作

Mask R-CNN

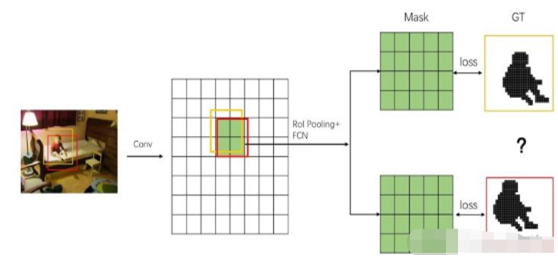

核心思想:mask R-CNN是Faster R-CNN的延伸,是在后者原有的bounding box recognition分支上分出一条与之并行的预测object mask的分支。

mask R-CNN = Faster R-CNN + 实例分割

背景:Faster R-CNN存在的问题是:特征图与原始图像是不对准的(mis-alignment),所以会影响检测精度。

模型:

基本流程:

相对于Faster R-CNN改进的位置:

1.在Cls和Reg的基础上添加了一条Mask生成通路。

2.将RoI Pooling改进为RoI Align

Faster-R-CNN:

Mask Faster-R-CNN:

RoIAlign:RoIPool会产生misalignments的问题(RoI和特征之间)。RoIAlign不做量化,而是做双线性插补。RoIWarp虽然也采用了双线性重采样,但是结果跟RoIpool差不多。(ROI Pooling 的作用是根据预选框的位置坐标在特征图中将相应区域池化为固定尺寸的特征图,以便进行后续的分类和包围框回归操作。两次量化过程:预选框边界量化为整数点坐标;将量化后的边界值分割为k*k个单元,对每一个单元的边界进行量化。)

misalignment问题:

原图中的小男孩有两个 bounding box 框住他,我们用卷积操作对图像进行下采样,然后根据 feature map 和原图的比例,推算出这两个 bounding box 对应在 feature map 上的位置和大小。结果,很不幸这两个框的位置四舍五入后刚好对应同一块 feature map。接着,RoI Pooling 和 FCN 会对这块 feature map 进行处理得到 mask,再根据 ground truth 计算 Loss。两个框对应的 ground truth 当然是不一样的。这个时候,网络就左右为难,同样一个 feature map,居然要拟合两个不同的结果,它左右为难一脸懵逼,直接导致模型无法收敛。

RoI Align 的主要工作。其具体的做法是采用双线性插值,根据相邻 feature map 上的点来插值一个新的特征向量。如下图所示:

图中,我们先在 bounding box 中采样出几个点,然后用双线性插值计算出这几个点的向量,之后,再按照一般的 Pooling 操作得到一个固定大小的 feature map。具体的细节,之后开一篇新的文章介绍。

参考:https://zhuanlan.zhihu.com/p/37998710

其他:实例分割其实就是目标检测和语义分割的结合。相对目标检测的边界框,实例分割可精确到物体的边缘;相对语义分割,实例分割需要标注出图上同一物体的不同个体(羊1,羊2,羊3...)

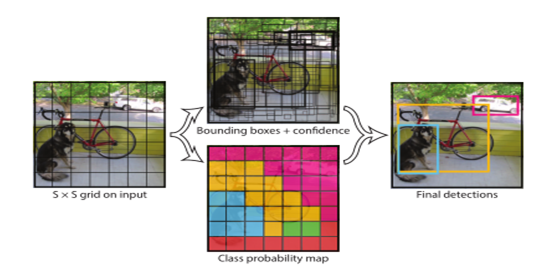

YOLO

核心思想:将目标检测转化为回归问题求解,并基于一个单独的end-to-end网络,完成从原始图像的输入到物体位置和类别的输出

背景:之前的目标检测都是基于two-stage的工作,先要提出候选框,然后再对提出的候选框做分类和边框回归

模型:

该网络对网络中的整个图像和图像中的所有对象进行全局推理。(可推理所有目标)

给定输入图像,将图像分割成 S∗S(实验中 S=7)个网格。如果一个物体 Ground Truth 的中心落在某个网格中,那么在训练过程中,该网格就负责对该物体的 Bounding Box 进行回归

网络结构:

主体结构如下:包括 24 个卷积层,最后接 2 个全连接层。文章设计的网络借鉴 GoogleNet 的思想,在每个 1∗1的 归约层之后再接一个 3∗3 的卷积层的结构替代 Inception结构。文章中还提到了 fast 版本的 Yolo,只有 9 个卷积层,其他的结构基本一致。网络的主体结构如下:

训练过程:

1.首先利用 ImageNet 的数据集 Pretrain 卷积层。使用上述网络中的前 20 个卷积层,外加一个全连接层,作为 Pretrain 的网络,训练大约一周的时间,使得在 ImageNet 2012 的验证数据集 Top-5 的准确度达到 88%,这个结果跟 GoogleNet 的效果相当。

2.将 Pretrain 的结果应用到 Detection 中,将剩下的 4 个卷积层及 2 个全连接成加入到 Pretrain 的网络中。同时为了获取更精细化的结果,将输入图像的分辨率224*224 提升到 448*448。

3.将所有的预测结果都归一化到 0~1, 使用 Leaky RELU 作为激活函数。

4.对比 localization error 和 classification error,加大 localization 的权重

5.在 Pascal VOC 2007 和 2012 上训练 135 个 epochs, Batchsize 设置为 64, Momentum 为 0.9, Decay 为 0.0005.

6.在第一个 epoch 中 学习率是逐渐从 10−310−3 增大到 10−210−2,然后保持学习率为 10−210−2,一直训练到 75个 epochs,然后学习率为 10−310−3 训练 30 个 epochs,最后 学习率为 10−410−4 训练 30 个 epochs。

7.为了防止过拟合,在第一个全连接层后面接了一个 ratio=0.5ratio=0.5 的 Dropout 层。并且对原始图像做了一些随机采样和缩放,甚至对调节图像的在 HSV 空间的饱和度。

优点:1.检测速度快

2.关于背景信息检测错误减少

3. 泛化能力强(泛化能力=预测能力)。在自然图像上训练好的结果在艺术作品中的依然具有很好的效果。

缺点:1.检测准确性仍然落后于检测系统。很难精准定位对象,特别是小对象。

2. 多个不同类的目标中心落在同一个网格时,我们一个网格内的bbox输出类别唯一,检测出现问题;

3.预测的 Box 对于尺度的变化比较敏感,在尺度上的泛化能力比较差。

4. 之前提到的在损失函数中,对小尺寸边界框和大尺寸边界框相同的误差处理方式依然没有根本解决。大尺寸对小的错误偏移通常可以接受,而小尺寸则影响较大。这一问题的根源是对边界框的位置预测不正确导致的。

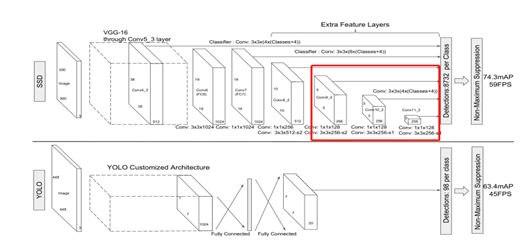

SSD:

定义:一种利用单一神经网络进行目标检测的方法

背景:SSD之前,最流行的是YOLO和faster R-CNN,但在实时性问题上没有大突破,以往的检测方法提升速度是建立在损失精度的前提下,SSD实现了高精度和高速度的权衡。(速度提升根本原因是消除了边界框提议以及随后的像素或特征重采样阶段)

核心思想:该论文的改进包括使用不同宽高比检测的单独的预测器(滤波器)预测边界框中的对象类别和偏移,并且将这些滤波器应用于网络后期的多个特征图,以便执行多尺度检测。通过这些修改,我们可以使用相对低分辨率的输入实现高精度检测,进一步提高处理速度。(使用小卷积滤波器预测特征图上一组默认边界框的类别分数和位置偏移)

方法:

(基本思想SSD基于前馈神经网络产生固定大小的边界框和对象类别的分数,然后是非最大抑制步骤以产生最终检测)

上图为文章的核心思想图,下文在基于该思想上进行模型步骤详细解析。

(在网络末端添加几个特征层,且尺寸逐层减小,他们可以预测不同规模和高宽比的检测目标的偏移量以及相关置信度)

训练:

(当jaccard overlap>0.5时标注为正样本,其余标注为负样本)

创新点:

1.对多个卷积层输出进行种类和位置回归(借鉴YOLO),实现低层特征检测小目标,高层特征监测大目标。

2.每组检测器包括不同尺寸和不同高宽(借鉴faster R-CNN)

优点:速度快,检测效果好

缺点:小尺寸目标识别较差(未达到faster R-CNN标准)

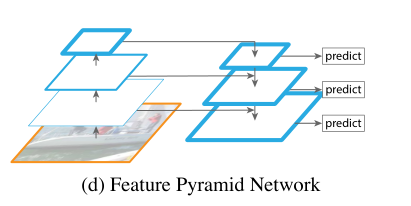

特征金字塔(FPN)

定义:一种具有横向连接的自顶向下的结构,用于构建各种尺度的高级语义特征图。

(从高层携带信息传给底层,再分层预测)

核心思想:处理多尺度(大目标和小目标)变化问题

背景:原始的方法多利用单个高层特征(比如说Faster R-CNN利用下采样四倍的卷积层——Conv4,进行后续的物体的分类和bounding box的回归),因此会因为小物体本身具有像素较小所以容易在检测时被丢失,而经典的方法是利用图像金字塔,但该方法会产生较大的计算量所以提出本文。

对比:

图像金字塔:

优:对多尺度进行提取 缺:检测时间过长

常见的利用单个高层特征图预测(例如Faster R-CNN中的RPN层)

优:速度变快 缺:有一定的尺度局限性,对不同尺寸特征图检测效果不够好

金字塔形特征层级:ConvNet's pyramidal feature hierarchy

(例如SSD one-stage目标检测模型)

缺:对低层特征图语义信息不够和低层特征图分辨率不高

特征金字塔:

较少计算量前提下精准渐层多层次语义信息

方法:

结构图:

1.自下向上的途径:

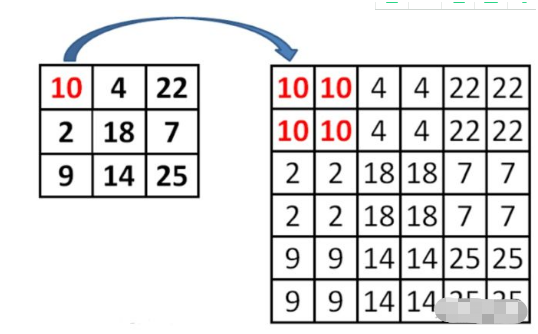

通过前馈计算每层往上进行下采样。步长为2(Faster R-CNN)(最近邻上采样法)

2.自上而下的路径和横向连接:

通过下采样的方式将顶层的小特征图。放大到上一个stage的特征图一样的大小。

具体过程为:C5层先经过1 x 1卷积,改变特征图的通道数(文章中设置d=256,与Faster R-CNN中RPN层的维数相同便于分类与回归)。M5通过上采样,再加上(特征图中每一个相同位置元素直接相加)C4经过1 x 1卷积后的特征图,得到M4。这个过程再做两次,分别得到M3,M2。M层特征图再经过3 x 3卷积(减轻最近邻近插值带来的混叠影响,周围的数都相同),得到最终的P2,P3,P4,P5层特征。

注意:这里的对应尺寸的卷积特征图是通过 1×1卷积 来降低通道数得到的。因为每个尺寸有很多个 channel 的 卷积特征图。(1*1卷积有降维功能:32*32*8 经1*1*2卷积后为32*32*2特征图)

应用:

RPN中的FCN

FCN将RPN中的头部网络更改为{32^2、64^2、128^2、256^2、512^2}这五种尺度的anchor,分别对应到{P2、P3、P4、P5、P6}这五个特征层上。每个特征层都处理1:1、1:2、2:1三种长宽比例的候选框。P6是专门为了RPN网络而设计的,用来处理512大小的候选框。它由P5经过下采样得到。且网络之间互相共享。

其他:

1.鲁棒性:一个系统或组织抵御或克服不利条件的能力(稳定性)

2.最近邻上采样法(最大程度保留语义信息)

3. 消融实验:控制变量,提出了一种方案,同时改变了多个条件/参数,他在接下去的消融实验中,会一一控制一个条件/参数不变,来看看结果,到底是哪个条件/参数对结果的影响更大。

Resnet(残差网络)

核心思想:结局梯度消失和梯度爆炸问题。

梯度消失/梯度爆炸:随着网络模型深度的增加训练,误差没有变小反而变大,且不是过拟合的原因。(本文推测退化问题产生的原因:深度普通网络的收敛速度可能呈指数级放缓,进而影响训练误差的下降速度。)

模型:

本文工作的基础是假设优化残差映射比优化原始目标映射容易。极端情况下,如果恒等映射为最优,则相比于拟合恒等映射,堆叠网络层将残差映射拟合为零更加容易。

这里我们首先求取残差映射 F(x):= H(x)-x,那么原先的映射就是 F(x)+x。尽管这两个映射应该都可以近似理论真值映射 the desired functions (as hypothesized),但是它俩的学习难度是不一样的。

基础模型如下

1.捷径连接:跳过一层或多层的连接。本文中,捷径连接简化为恒等映射(identity mapping),其输出与堆叠网络层的输出相加。

2.多重网格法:将方程组分解为多尺度子问题,每个子问题对应粗尺度和细尺度间的残差解。多重网格法可采用分层预处理,即以两个尺度间的残差向量为自变量。现已证明其解收敛速度远大于比标准求解器。

网络结构:

(1)采用恒等捷径,增加维度用零填充;(2)采用投影捷径(Eqn.(2))匹配维度。

优势:1.残差网络更容易优化2.在更深层网络的精度更高y

全卷积网络(端到端):

定义:当一个普通深度的网络计算一个普通的非线性函数,一个网络只有这种形式的层计算非线性滤波,我们称之为深度滤波或全卷积网络

核心思想:将CNN改为 FCN

方法:

将CNN模型中的全连接层看成卷积层,卷积模板大小就是输入map的大小

优势:

1.可以接受 任意大小的输入 通过有效处理 产生 相应大小输出(先进行上采样再进行下采样还原图像)

一个确定的CNN网络结构之所以要固定输入图片大小,是因为全连接层权值数固定,而该权值数和feature map大小有关。

2.训练一个end-to-end的FCN模型,利用卷积神经网络的很强的学习能力,得到较准确的结果,以前的基于CNN的方法都是要对输入或者输出做一些处理,才能得到最终结果

缺点:容易丢失小目标

其他:

1.端到端模型:使用一个模型,一个目标函数

优点:规避多模块缺陷 ,减少工程复杂度

2:上采样:放大图像 下采样:缩小图像

3:反卷积(卷积核大于输入图片尺寸,卷积的逆过程,通过反卷积操作并不能还原出卷积之前的图片,只能还原出卷积之前图片的尺寸)

对比结果:

1,对比3种性能较好的几种CNN:AlexNet, VGG16, GoogLeNet进行实验,选择VGG16

2,对比FCN-32s-fixed, FCN-32s, FCN-16s, FCN-8s,证明最好的dense prediction组合是8s

3,FCN-8s和state-of-the-art对比是最优的,R-CNN, SDS. FCN-16s

4,FCN-16s和现有的一些工作对比,是最优的

5,FCN-32s和FCN-16s在RGB-D和HHA的图像数据集上,优于state-of-the-art

对抗网络(GAN)

定义:生成器和鉴别器之间的博弈

(生成器的输入为带水印的图像,输出为无水印的图像;而判别器用于识别结果到底是原始真实的无水印图像,还是经过生成器生成的无水印图像。通过两者之间不断的对抗训练,生成器生成的无水印图像变得足够“以假乱真”,从而达到理想的去水印效果。

即,1个不断生成.1个不断判定.最后以假乱真.)

目的:预测行人轨迹

背景:

在行人行走时可能出现的状况如下

1.人与人之间的相互影响

2.社交上的可接受程度

3. 多情况

模型:

(预测多个好的轨迹)

整体生成器和判别器的架构:

Pool Module:

计算红色和所有其他人之间的相对位置; 这些位置与每个人的隐藏状态连接,由MLP独立处理,然后汇集元素以计算红人的汇集向量P1。 社交池只考虑网格内的人,并且不能模拟所有人之间的交互。

其他:

MLP:多层感知机:前馈神经网络模型