.本周视频学习内容:https://www.bilibili.com/video/BV1Tb411H7uC?p=2

1)P2 概率论与贝叶斯先验

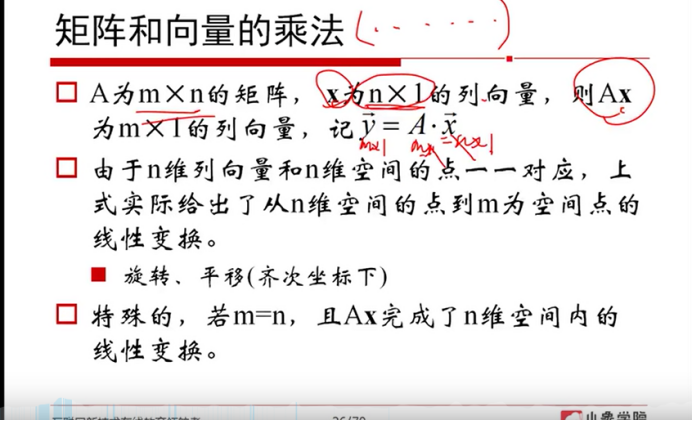

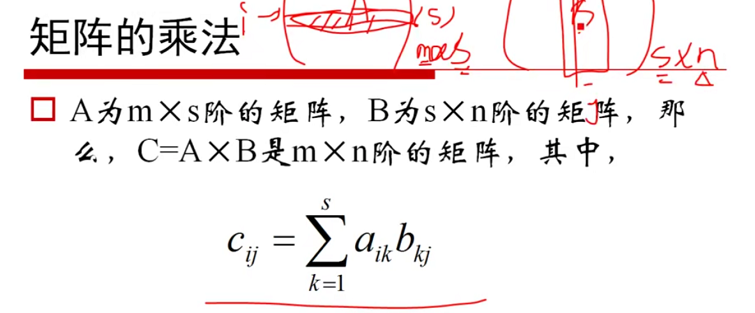

2)P3 矩阵和线性代数

机器学习是一门多领域交叉学科,涉及较多的数学知识,本节课知识之前都有学过,这次根据重点重新梳理一遍,一定要多加重视。通过观看视频,大家对课程的数学基础部分加深印象。

建议大家边看边做笔记,记录要点及所在时间点,以便有必要的时候回看。学习笔记也是作业的一部分。

3.作业要求:

1)贴上视频学习笔记,要求真实,不要抄袭,可以手写拍照。

2)用自己的话总结“梯度”,“梯度下降”和“贝叶斯定理”,可以word编辑,可做思维导图,可以手写拍照,要求言简意赅、排版整洁。

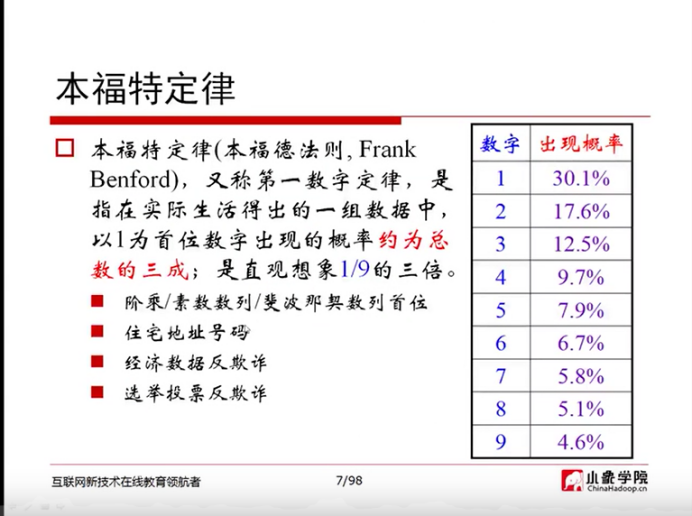

本福特定律:

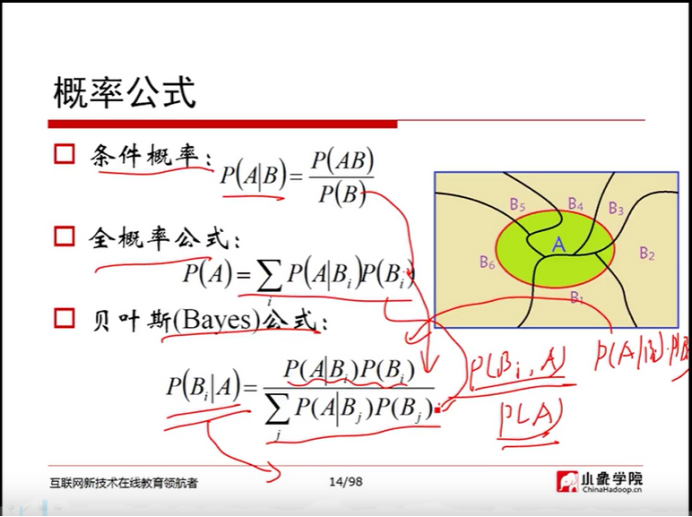

概率公式:

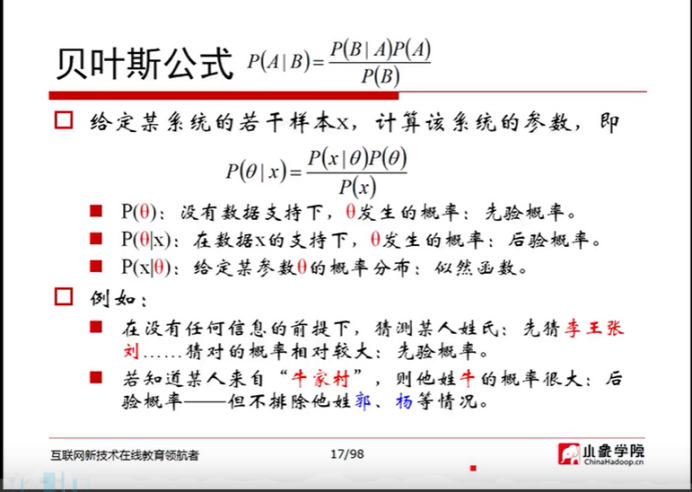

贝叶斯公式:

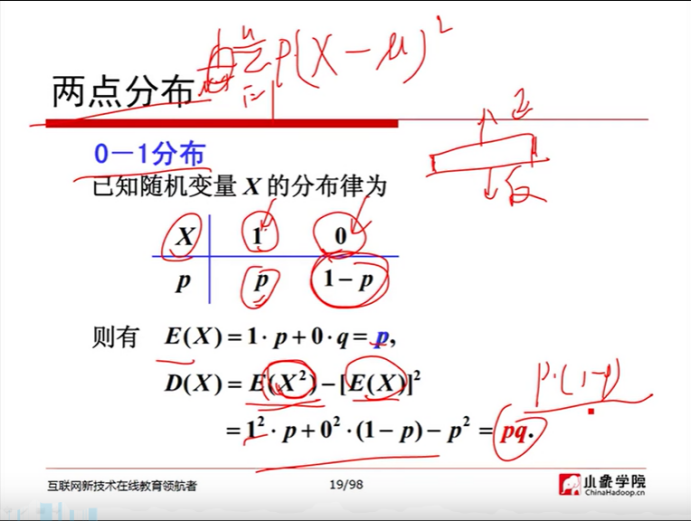

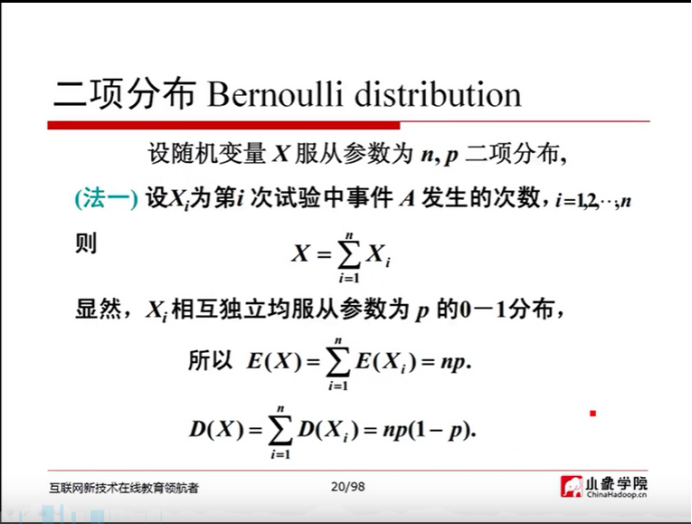

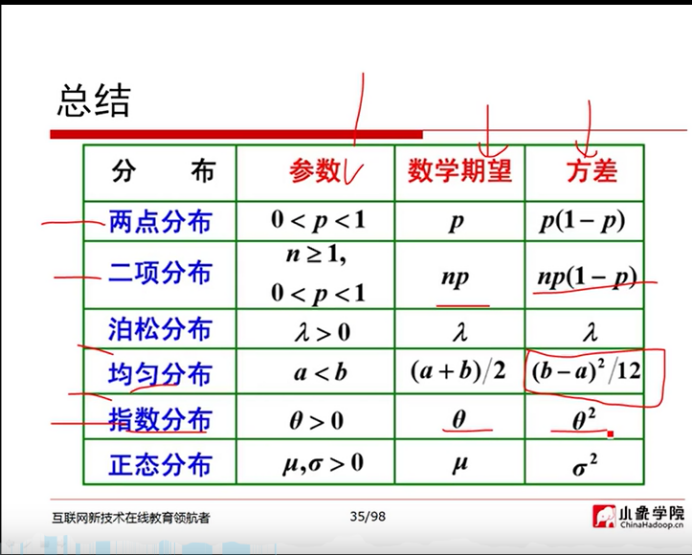

两点分布:

泰勒级数:

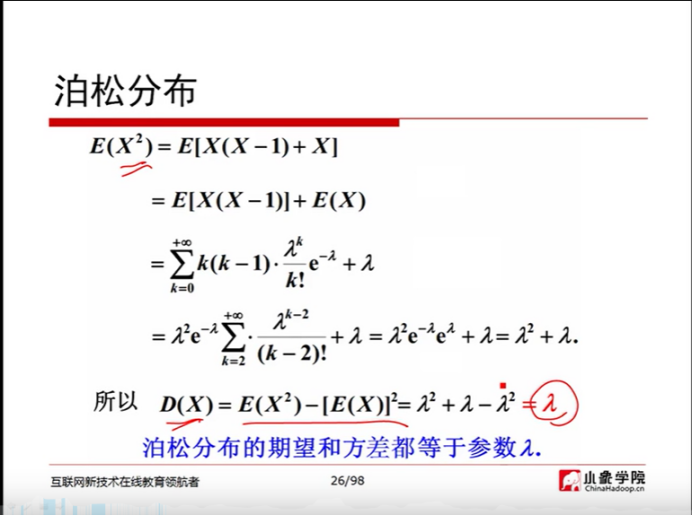

泊松分布:

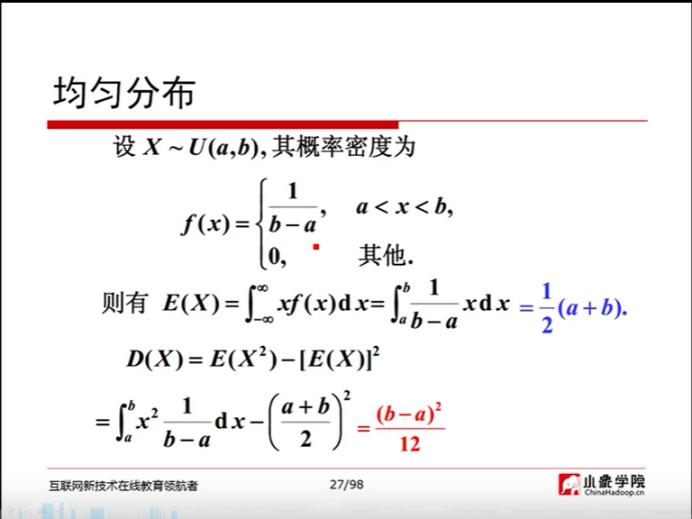

均匀分布:

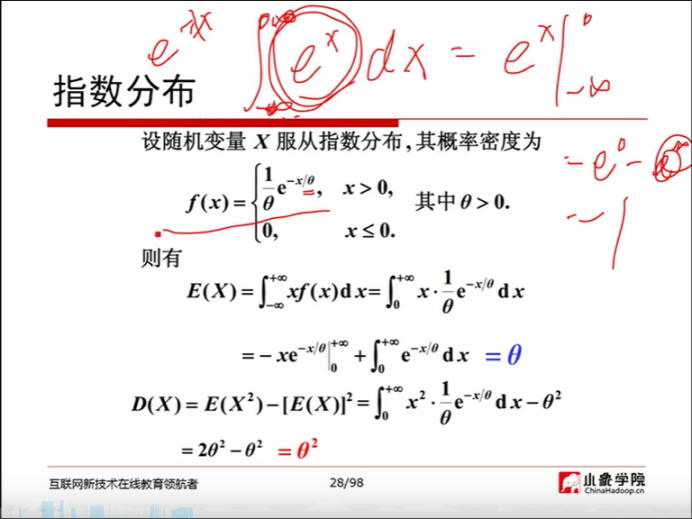

指数分布:

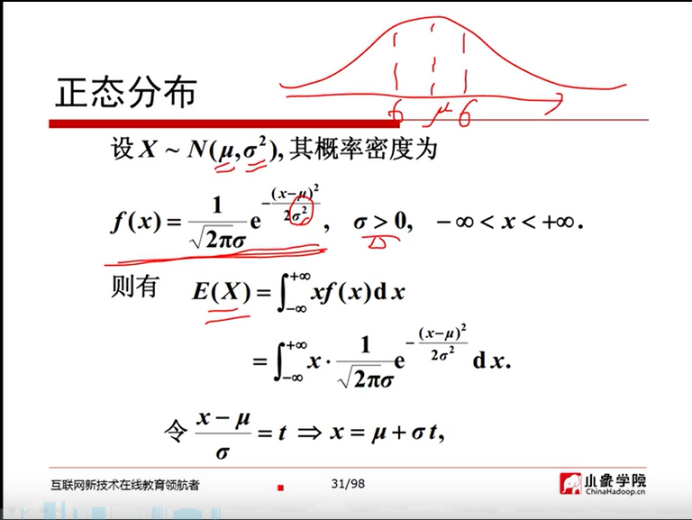

正态分布:

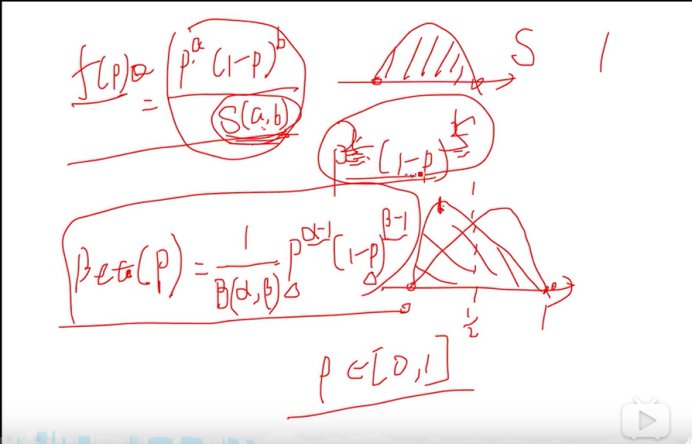

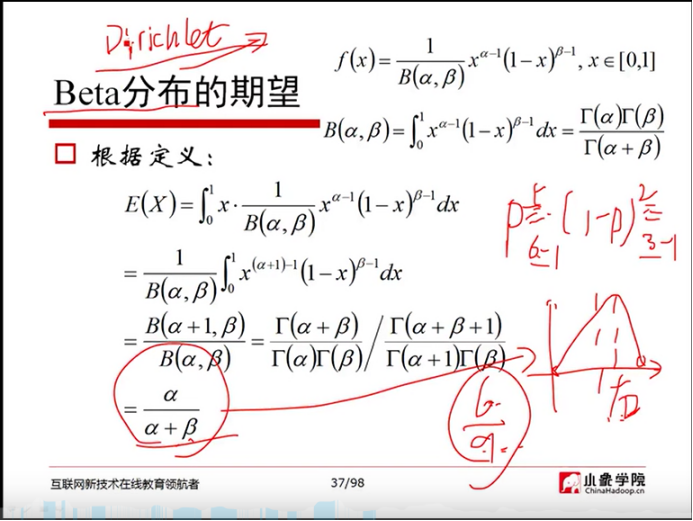

Beta分布:

事件的独立性:

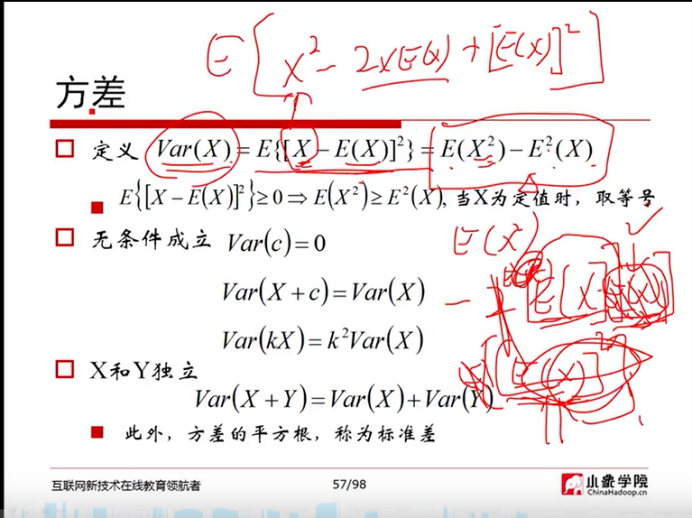

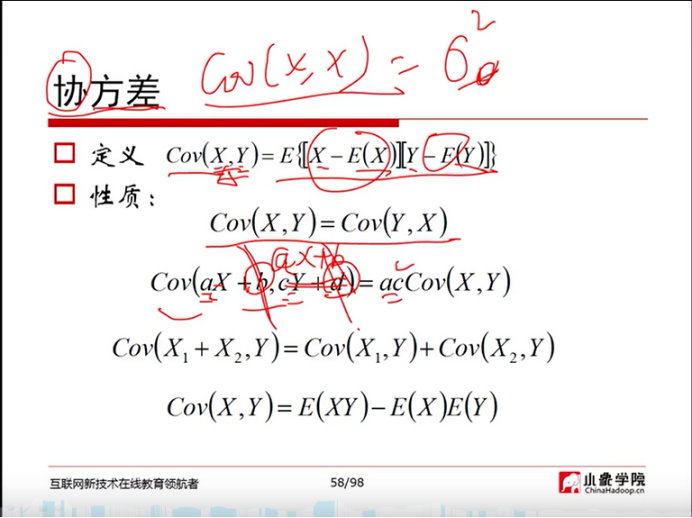

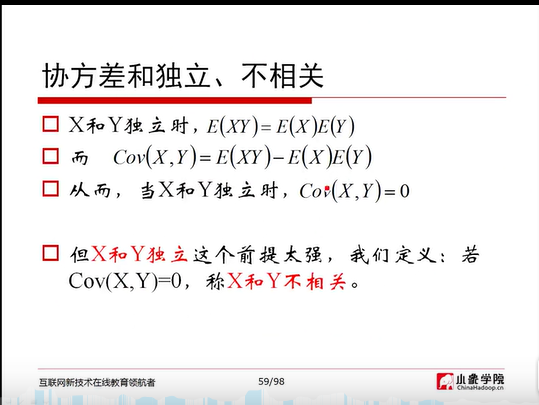

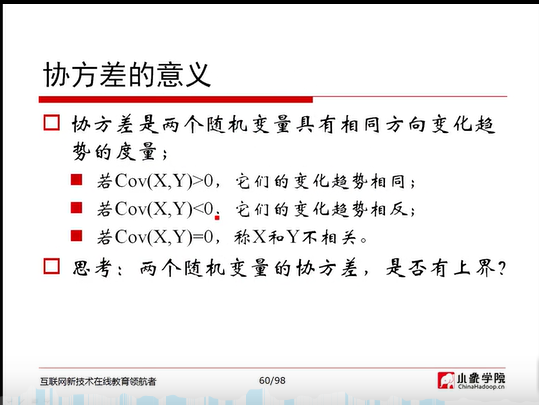

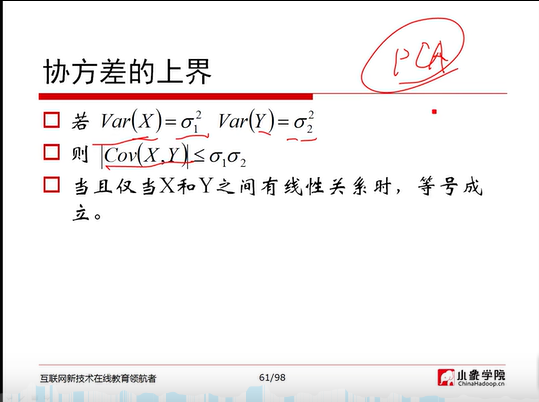

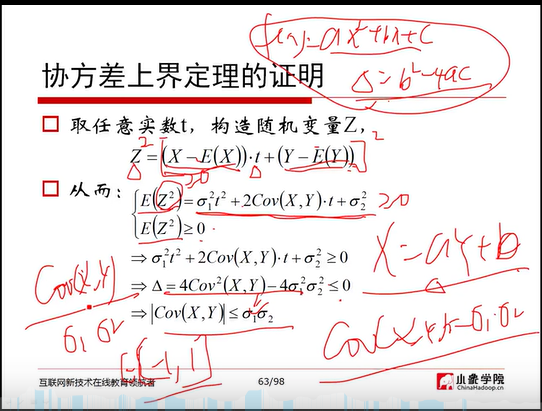

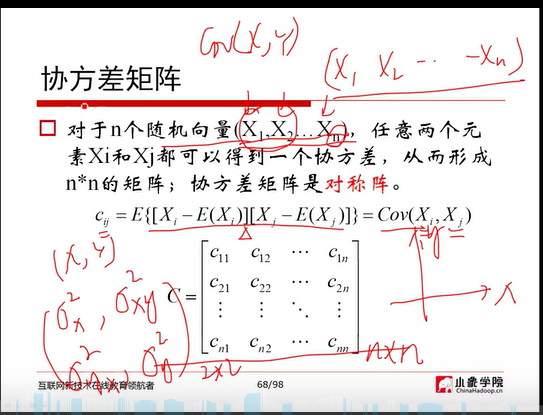

方差、协方差:

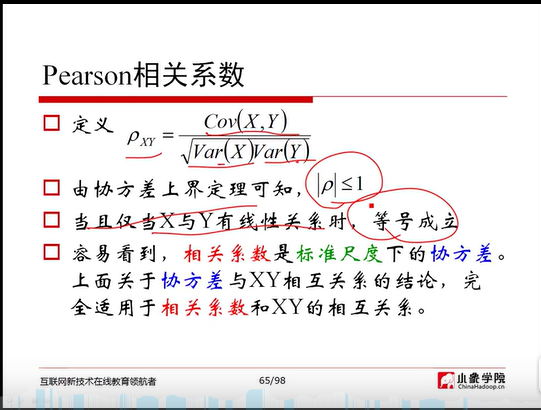

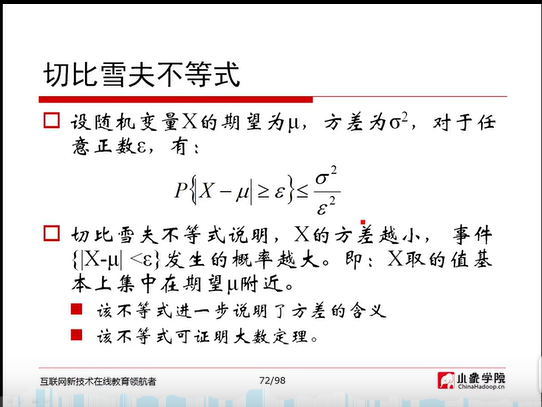

pearson相关系数、切比雪夫不等式:

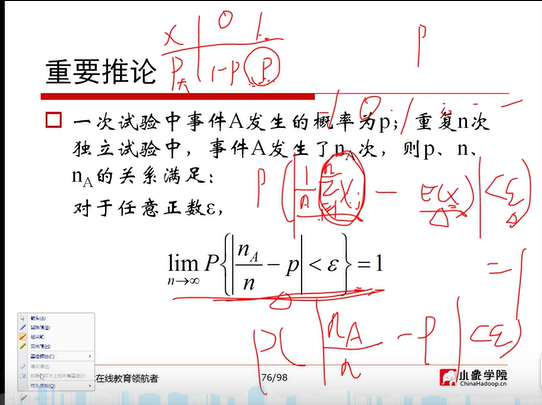

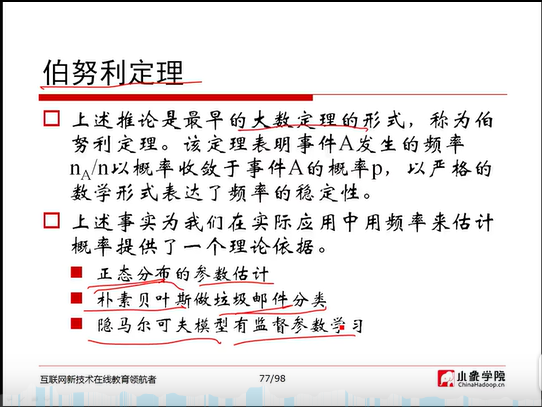

大数定律:

重要推论:

2)用自己的话总结“梯度”,“梯度下降”和“贝叶斯定理”,可以word编辑,可做思维导图,可以手写拍照,要求言简意赅、排版整洁。

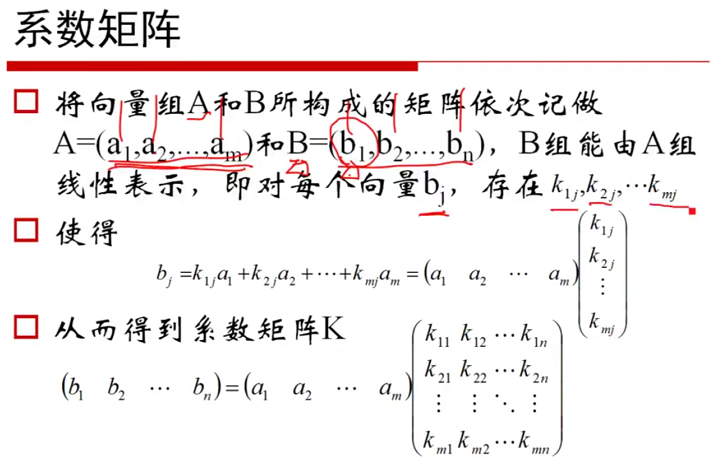

①梯度:梯度的定义如下:

梯度的提出只为回答一个问题: 函数在变量空间的某一点处,沿着哪一个方向有最大的变化率?

梯度定义如下: 函数在某一点的梯度是这样一个向量,它的方向与取得最大方向导数的方向一致,而它的模为方向导数的最大值。

这里注意三点: 1)梯度是一个向量,即有方向有大小; 2)梯度的方向是最大方向导数的方向; 3)梯度的值是最大方向导数的值。

②梯度下降:梯度下降是迭代法的一种,可以用于求解最小二乘问题(线性和非线性都可以)。在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降(Gradient Descent)是最常采用的方法之一,另一种常用的方法是最小二乘法。在求解损失函数的最小值时,可以通过梯度下降法来一步步的迭代求解,得到最小化的损失函数和模型参数值。反过来,如果我们需要求解损失函数的最大值,这时就需要用梯度上升法来迭代了。在机器学习中,基于基本的梯度下降法发展了两种梯度下降方法,分别为随机梯度下降法和批量梯度下降法。

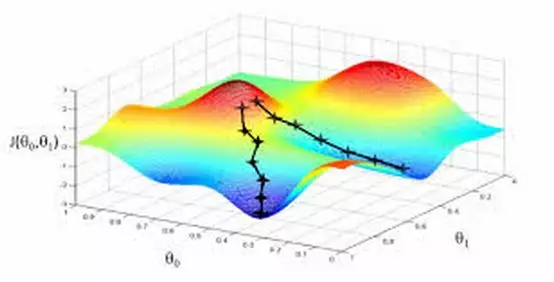

③贝叶斯定理:

概率论中的条件概率公式:

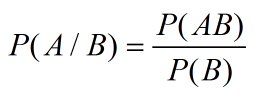

(1)

(1)

其中,P(B/A) 表示事件A已经发生的前提下,事件B发生的概率,叫做事件A发生下事件B的条件概率,P(AB)表示AB事件同时发生的概率。同理可得事件B发生下事件A发生的概率如下: (2)

(2)

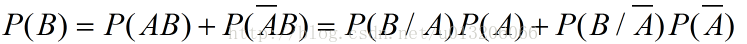

事件B发生的概率为P(B),它包含两部分,一是在A发生的条件下事件B发生了,另一种情况是在A非的情况下事件B发生了,所以P(B)的计算公式如下:

(3)

(3)

将公式(3)带入公式(2),可得到完整的贝叶斯公式如下: