梯度下降算法

梯度下降算法是一种致力于找到函数极值点的算法。

前面介绍过,所谓“学习”便是改进模型参数,以便通过大量训练步骤将损失最小化。有了这个概念,将梯度下降算法应用于寻找损失函数的极值点便构成了依据输入数据的模型学习。

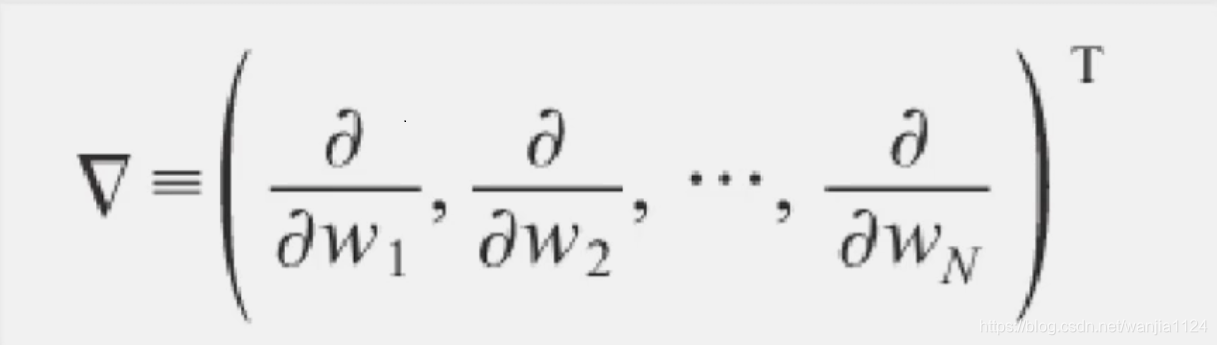

梯度的输出是一个由若干偏导数构成的向量,它的每个分量对应于函数对输入向量的相应分量的偏导:

梯度的输出向量表明了在每个位置损失函数增长最快的方向,可将它视为表示了在函数的每个位置向哪个方向移动函数值可以增长。

多层感知器(神经网络)

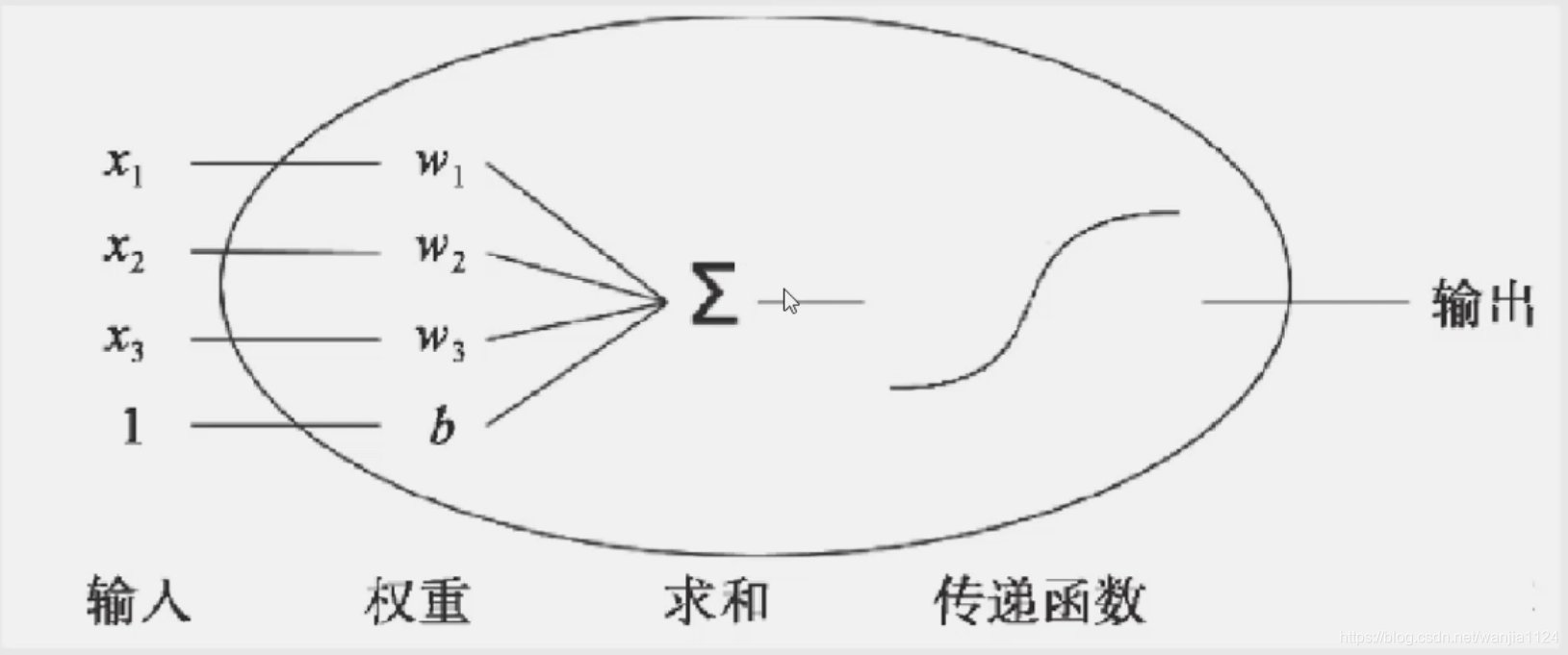

上一节学习的线性回归模型是单个神经元:

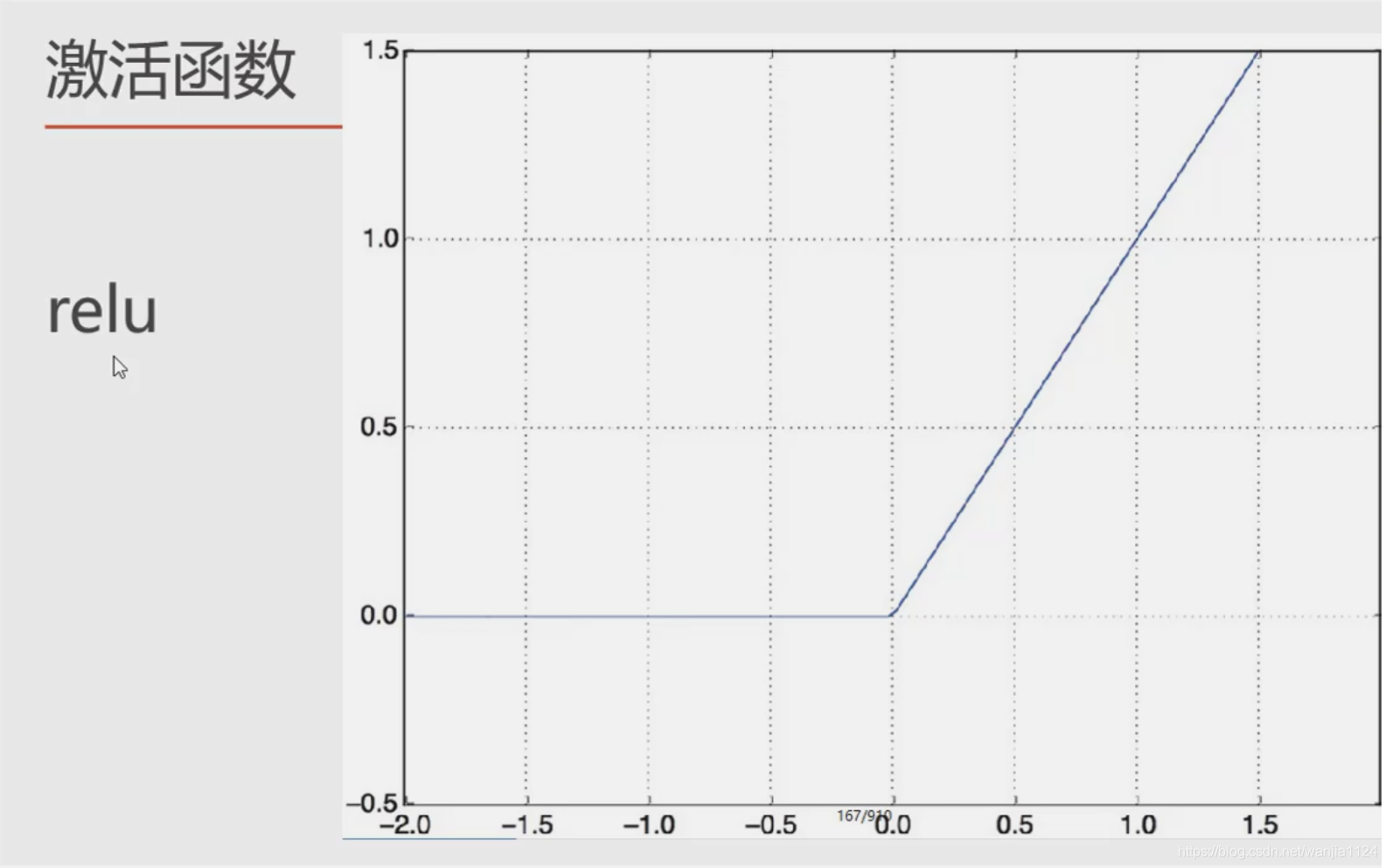

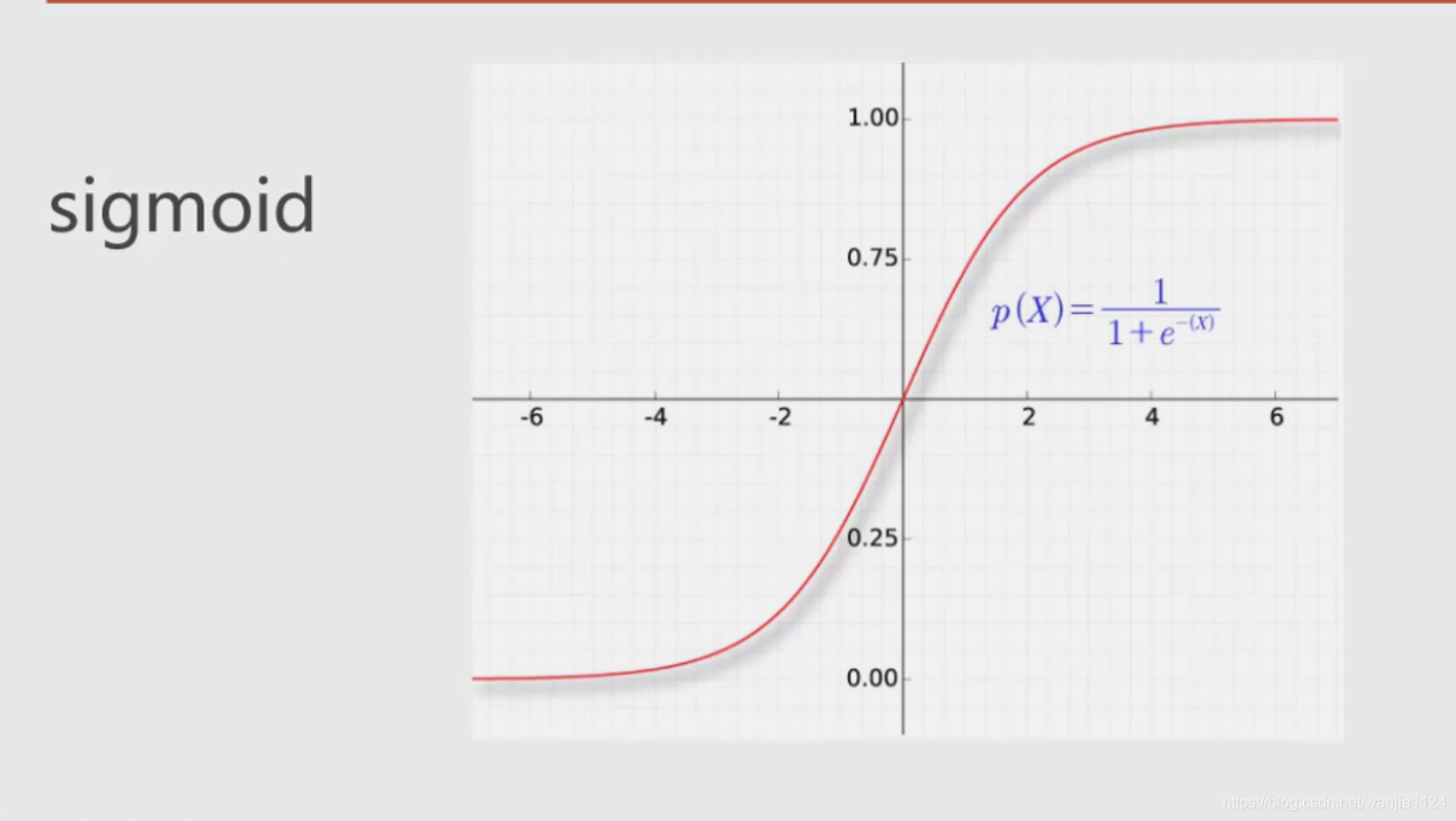

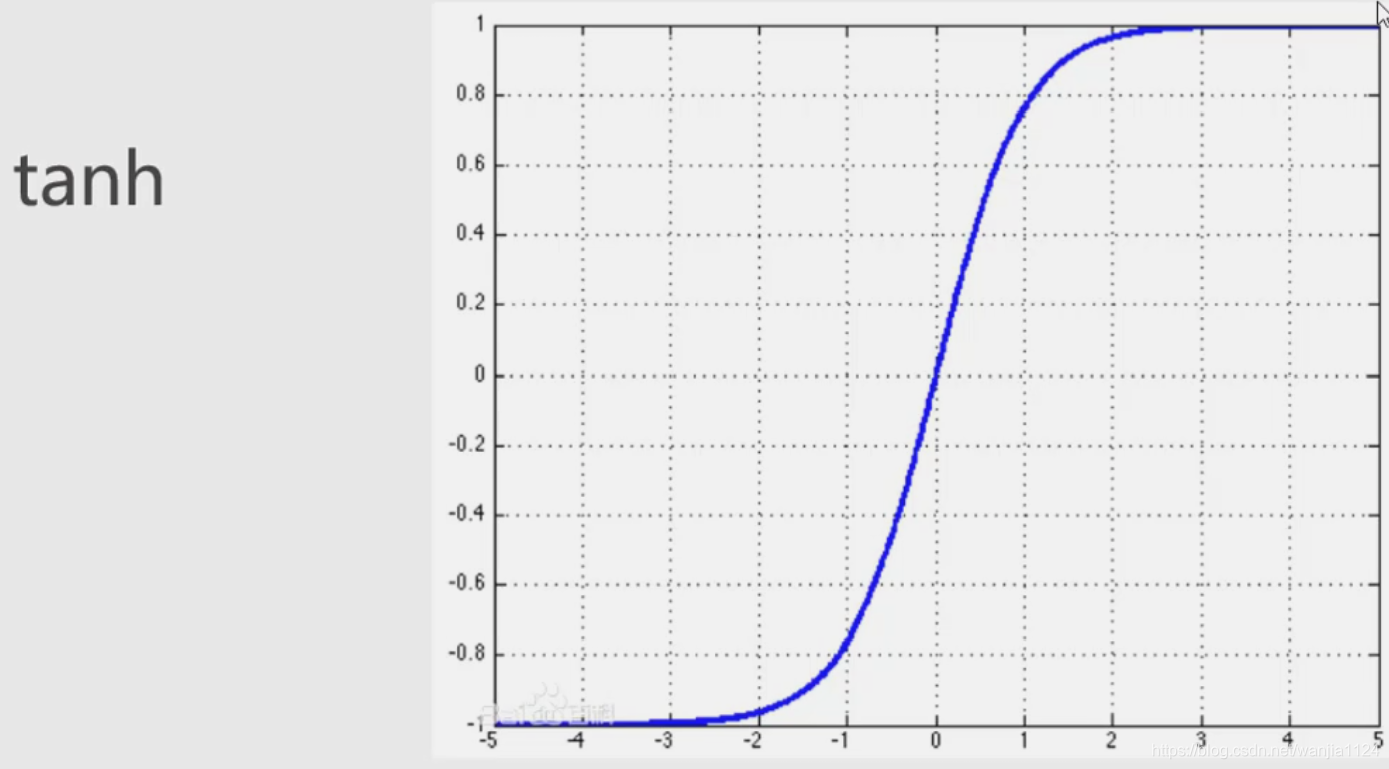

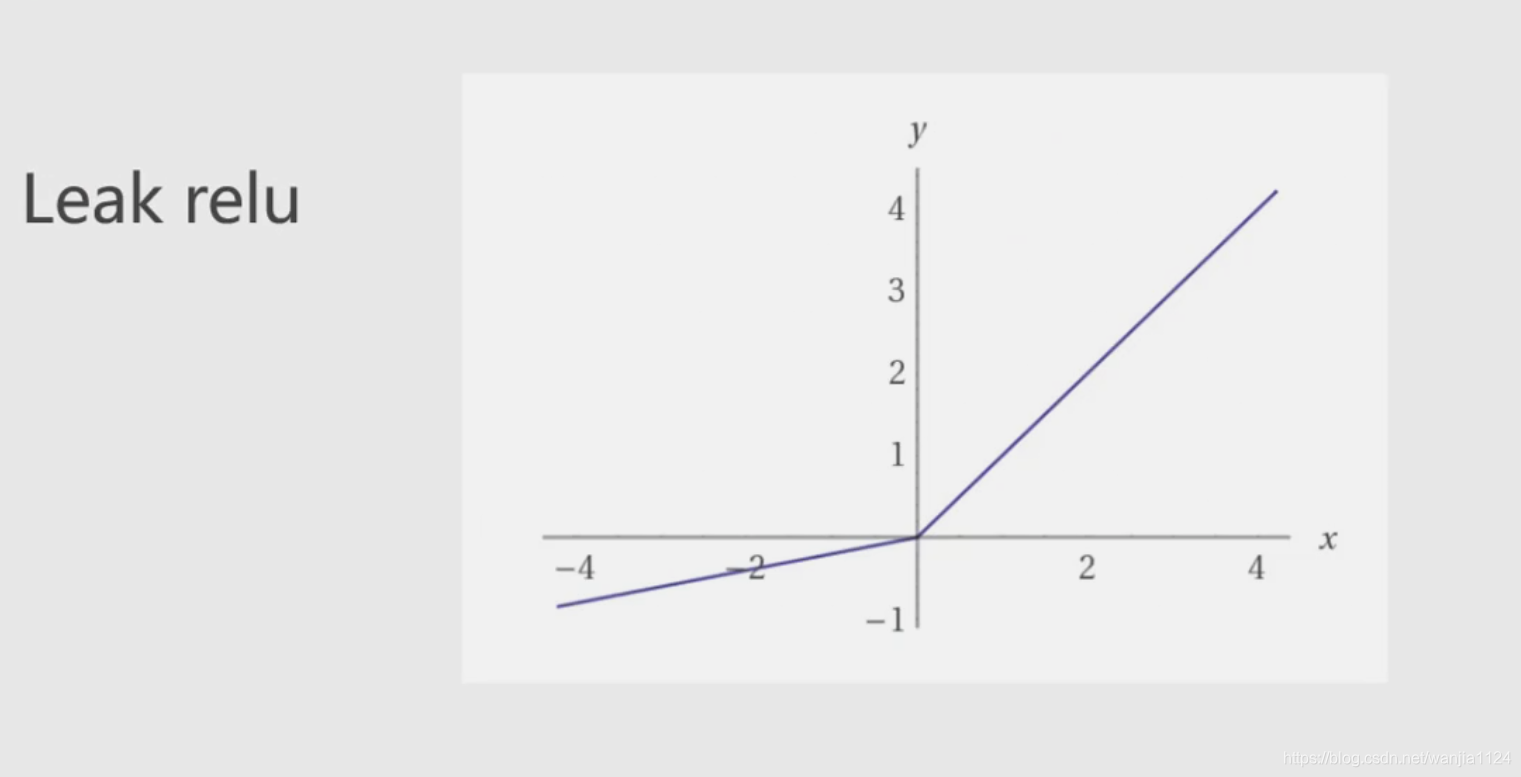

计算输入特征的加权和,然后使用一个激活函数(或传递函数)计算输出。

单个神经元(二分类)

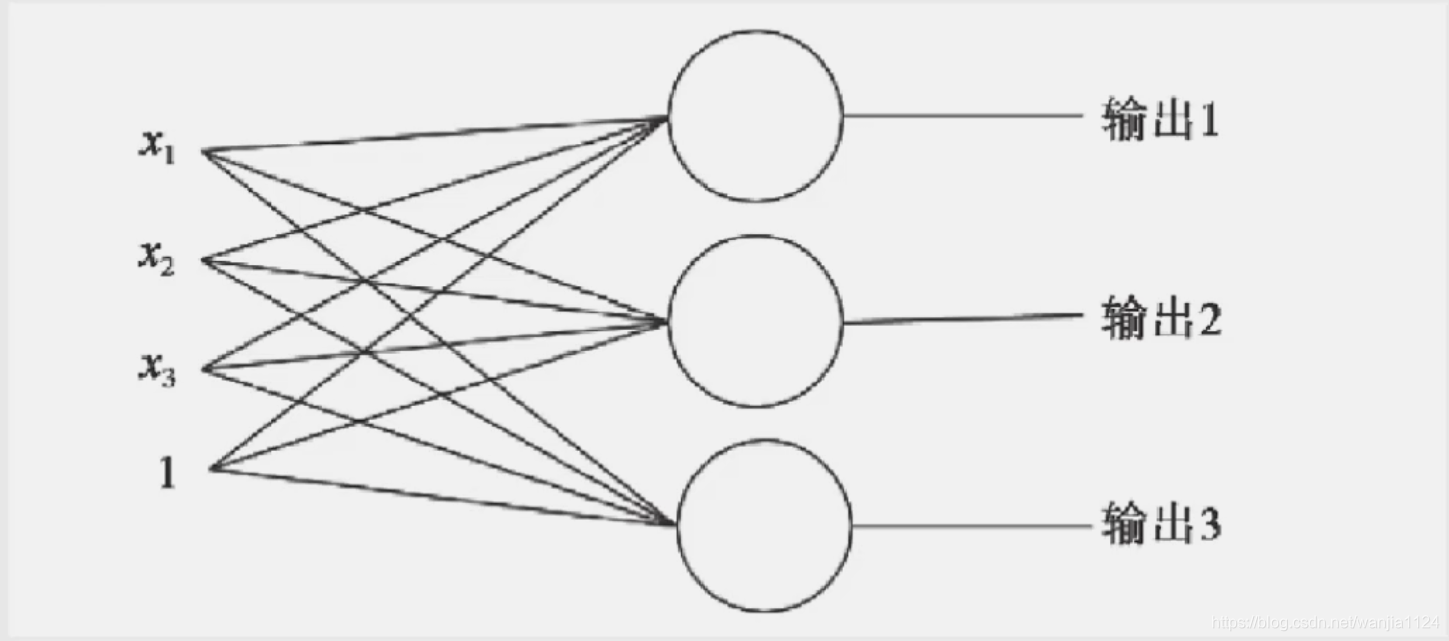

多个神经元(多分类)

以上都是单层神经元,它的缺陷:无法拟合“异或”运算,神经元要求数据必须是线性可分的,异或问题无法找到一条直线分割两个类。

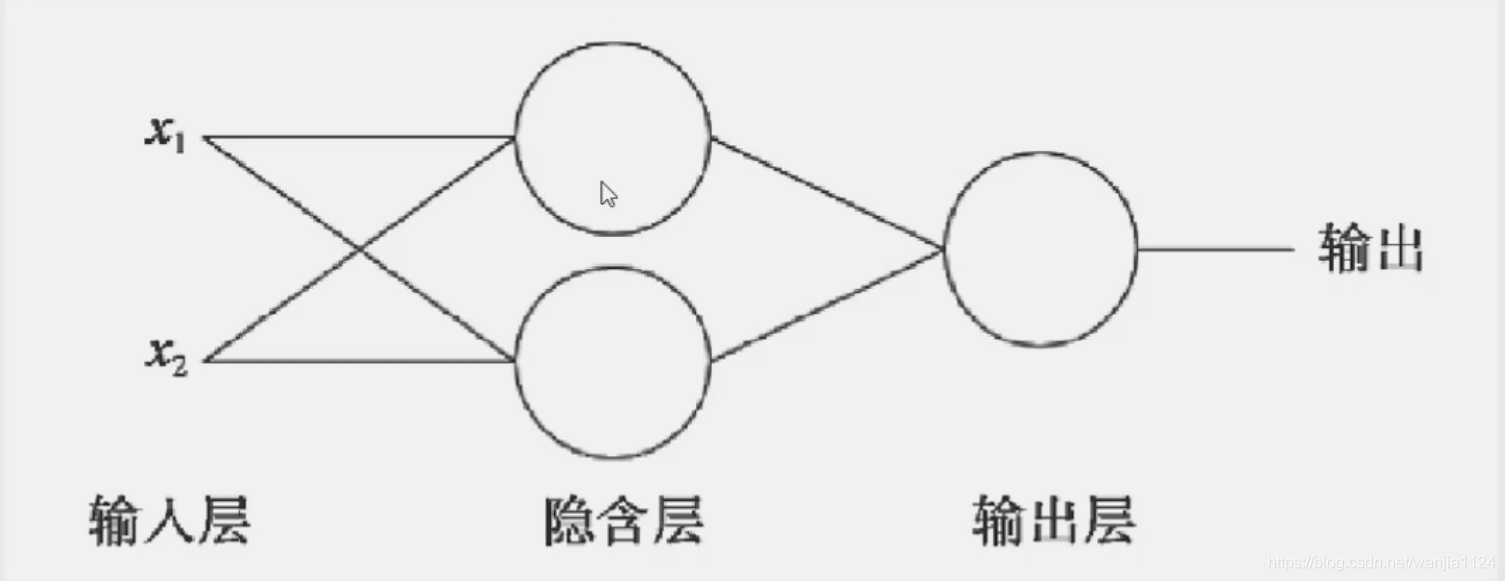

多层感知器

- 生物的神经元一层一层连接起来,当神经信号达到某一个条件,这个神经元就会激活,然后继续传递信息下去。

- 为了继续使用神经网络解决这种不具备线性可分性的问题,采取在神经网络的输入端和输出端之间插入更多的神经元。

激活函数