local本地模式-Spark初体验 :开箱即用 解压即用 (不需要修改任何配置)

解压 : tar zxvf spark-2.2.0-bin-2.6.0-cdh5.14.0.tgz -C ../servers/

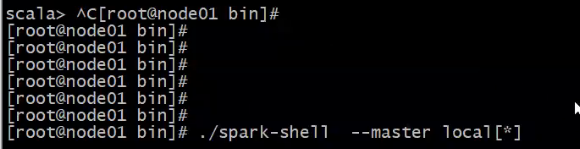

启动 : 进入 cd spark-2.2.0-bin-2.6.0-cdh5.14.0/bin 命令: ./spark-shell

第二种 启动方式 :

退出 : ctrl + c

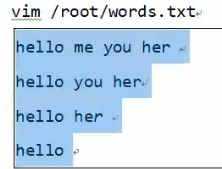

初体验-读取本地文件

●准备数据

vim /opt/tt.txt

val textFile = sc.textFile("file:///opt/tt.txt")

val counts = textFile.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _)counts.collect //收集结果

// Array[(String, Int)] = Array((you,2), (hello,4), (me,1), (her,3))

初体验-读取HDFS文件

●准备数据

上传文件到hdfs

hadoop fs -put /tt.txt

目录如果不存在可以创建

hadoop fs -mkdir -p /ttt

结束后可以删除测试文件夹

hadoop fs -rm -r /ttt

val textFile = sc.textFile("hdfs://node001:8020/tt.txt")

val counts = textFile.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _)查看结果 输出 到 下面路径中

counts.saveAsTextFile("hdfs://node001:8020/ttt")