Multi-Person Pose Estimation with Enhanced Channel-wise and Spatial Information

网址:https://arxiv.org/pdf/1905.03466.pdf

introduction

本文的两点贡献:

1)提出一种a Channel Shuffle Module (CSM)来在通道维度加强不同level特征的融合;

2)提出Spatial, Channel-wise Attention Residual Bottleneck (SCARB)来学习特征在空间和通道维度的关系。(相当于空间和通道维度的attention)

方法的出发点:

1)希望在通道维度建立high-level和low-level特征间的联系,因此设计CSM,融合不同level的特征;

2)希望进一步结合空间和通道attention机制,因此设计了SCARB

(因为博主不是做这个方向的,对这方面的任务也不算了解,只能大概讲讲主要的CSM模块和attenion机制的设计)

Method

1. CSM: Channel Shuffle Module

CSM:不同level的通道特征可以相互补充和强化,所以提取出GlobalNet得到的不同尺度的特征,定义为Conv-2∼5。融合步骤:

1)先用1*1卷积将每层抽取的特征固定到256维,(使conv-3~5的特征下采样,与conv-2的特征维度相同),再链接这些特征(链接后的特征维度256*4=1024)

2)使用channel shuffle操作进一步融合这些来自不同level的特征

3)shuffle后的特征,分组,再映射回原始的特征维度,定义为C-Conv2~5。C-Conv2~5可被视为含有不同level的特征

4) 再使用1*1卷积聚合C-Conv2~5,得到S-Conv-2∼5,最后我们将S-Conv-2∼5与原始的Conv-2∼5相连接,得到最终表示。

如何实现步骤(2)中的channel shuffle?

参考shuffleNet,channel shuffle的操作可以定义为“reshape-transpose-reshape”。如果有特征,shape=256*4,我们先进行第一个reshape得到(g, c),其中g使分组的数目,c是每个小组的channel数目,c=1024/g;随后进行transpose操作,得到(g, c)的特征;最后展开特征到原始的1024维度。

2.ARB: Attention Residual Bottleneck

1)空间维度attention

经过attention的输出特征与输入特征要保持形状相同。对于特征图上的每个点,我们都去计算它对应的权重(0-1之间),所以权重矩阵β 的shape为:h*w,用一个1*1的卷积+sigmoide得到:

![]()

(作者没放出代码,但我在实现的时候,对shape=h*w*c的输入,直接1个1*1的卷积,将channel维度从c降到1,再使用sigmoid即可)

2)channel维度attention

没什么好说的,就是不对通道降维的se-net

![]()

3)SCARB:Spatial, Channel-wise Attention Residual Bottleneck

先进行空间attention,再通道attention

4)CSARB: Channel-wise, Spatial Attention Residual Bottleneck

先通道attention,再空间attention

experiment

1)CSM中分组数目的探究

2)SCARB和CSARB的比较

(这里两种融合的attention只涨了1%和1.4%,我在行为识别ucf101中尝试过本篇paper的方案,效果会下降...特别是空间attention的方案,一用上去就降很多~)

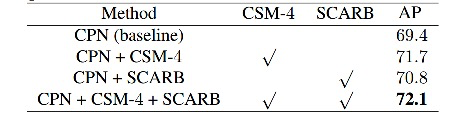

3)CSMH和SCARB融合

4)和state-of-the-art对比

个人想法:

1)本文学习空间位置权重时,与传统non-local方式不同,学习了每个位置的重要性,参数较少。例如在resnet中,本文将空间权重的学习引在residual分支,而不是block与block之间,值得学习。

2)不过本文和paper:CBAM: Convolutional Block Attention Module(先发表出来)中attention机制,基本上一摸一样啊~ CBAM 的相关阅读下篇会放出。空间attention那一部分基本上就是CBAM的复制,channel attention也是照搬了SE...

CSM模块的设计感觉有点意思,不过这种channel shuffle的操作在我之前写过的paper reading:

Timeception Complex Action Recognition 也有体现过~

总体而言paper中性能提升不高,我参考了中间attention部分进行了几组小实验,未见性能提升。