Spark是什么

Apache Spark是用于大规模数据处理的统一分析引擎

Spark基于内存计算,提高了在大数据环境下数据处理的实时性,同时保证了高容错性和高可伸缩性,允许用户将Spark部署在大量硬件之上,形成集群。

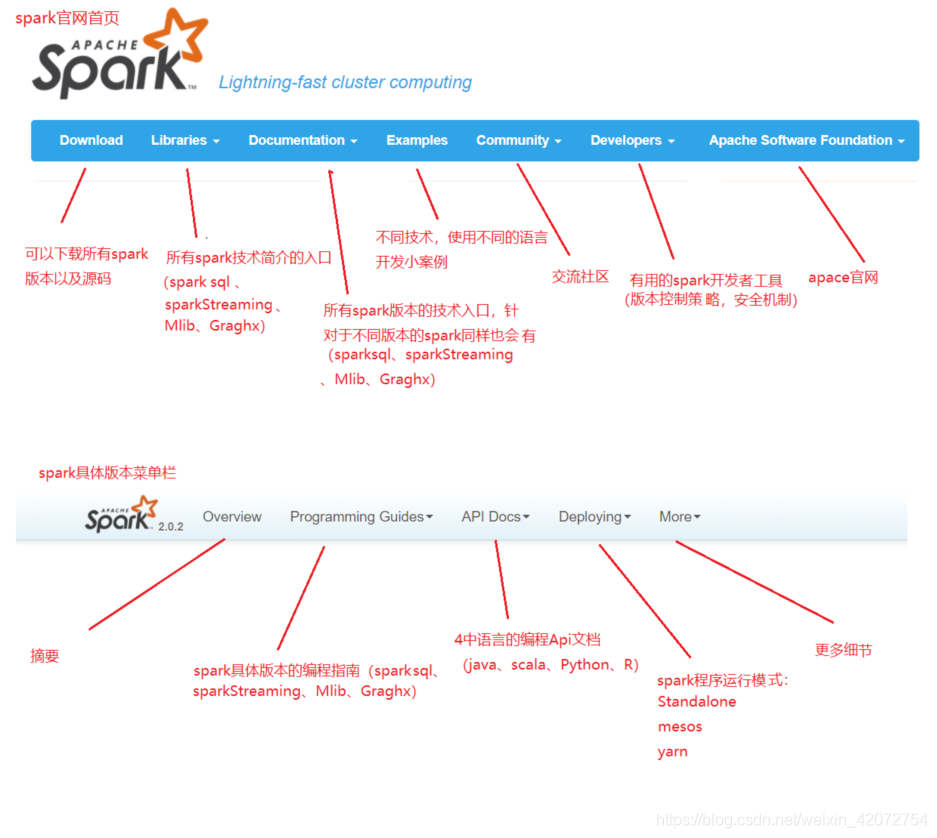

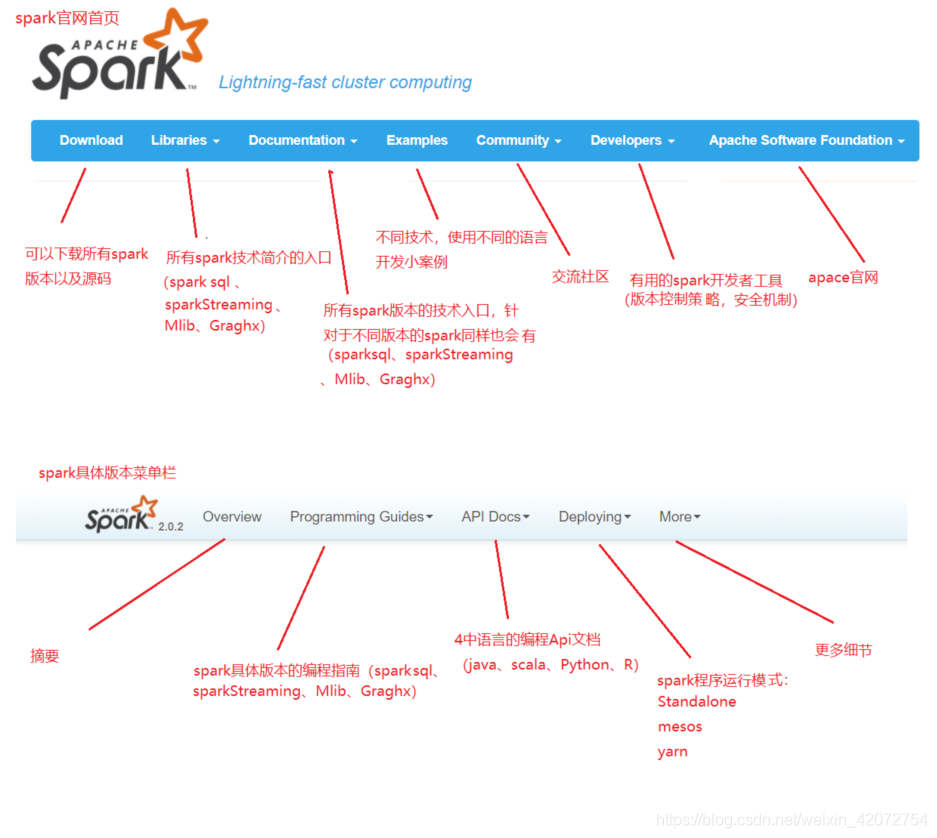

官网

http://spark.apache.org

http://spark.apachecn.org

Apache Spark是用于大规模数据处理的统一分析引擎

Spark基于内存计算,提高了在大数据环境下数据处理的实时性,同时保证了高容错性和高可伸缩性,允许用户将Spark部署在大量硬件之上,形成集群。

http://spark.apache.org

http://spark.apachecn.org