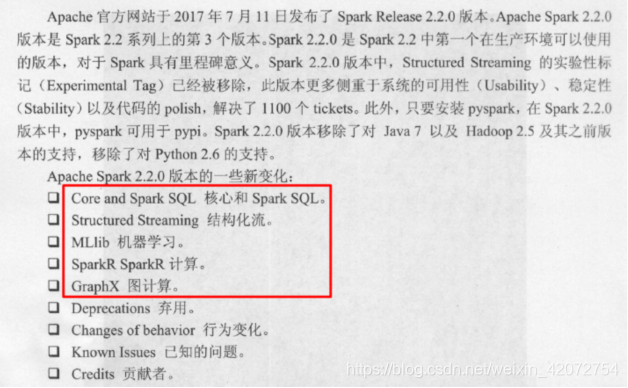

选择目前企业中使用最多的稳定版Spark2.2.0

使用Apache版还是CDH版?

1.Apache版直接下载官方编译好的基于Apache Hadoop的Spark即可

2.自己下载Spark源码基于CDH Hadoop重新编译

因为CDH5.14版 Spark基于Spark1.6版本较低,且为了推广自家的Impala对Spark SQL进行了阉割,所以要重新编译

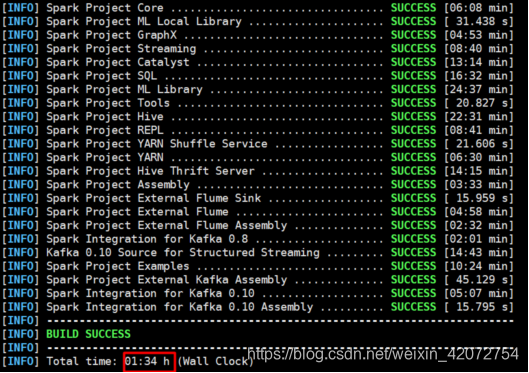

资料中已经提供了编译好的CHD Spark,当然也可以根据资料自己编译

(如果自己编译要求网络环境较好,使用提供的软件、仓库,细心耐心操作,耗时1个半小时左右)

大家之前安装的如果是CDH的Hadoop那么安装Spark的时候使用红线标出的重新编译之后的CDH版Spark即可

安装

●下载Spark安装包

下载地址:http://spark.apache.org/downloads.html

●解压重命名

cd /export/servers

tar spark-2.2.0-bin-2.6.0-cdh5.14.0.tgz

mv spark-2.2.0-bin-2.6.0-cdh5.14.0 spark

●注意:

如果有权限问题,可以修改为root,方便学习时操作,实际中使用运维分配的用户和权限即可

chown -R root /export/servers/spark

chgrp -R root /export/servers/spark

●解压目录说明:

bin 可执行脚本

conf 配置文件

data 示例程序使用数据

examples 示例程序

jars 依赖 jar 包

python pythonAPI

R R 语言 API

sbin 集群管理命令

yarn 整合yarn需要的东东