数学知识回顾

一、线性代数

二、概率论及数理统计

三、信息熵和基尼系数

四、最优化

一二两部分是对之前的数学知识的复习,后面两部分是大数据中涉及到的新的知识。

一、线性代数:

1.线性代数:

1.1行列式是一个将方阵映射到一个标量的函数,记作det(A)或|A|。行列式也可以看作是有向面积或体积在一般欧几里得空间的推广。或者说是在n维欧几里得空间中,行列式描述的是一个线性变换对“体积”所造成的影响。

行列式的意义:

行列式等于矩阵特征值的乘积。

行列式的绝对值可以用来衡量矩阵参与矩阵乘法后空间扩大或缩小了多少。

行列式的正负表示空间的定向。

行列式的应用:求矩阵特征值,求解线性方程等。

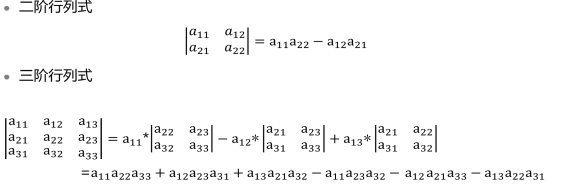

行列式的计算:

注意:这里能看出右边的每一项都是2个或3个元素的乘积,且这些元素位于不同的列,不同的行

行列式的几何意义:

1.2矩阵:

矩阵的运算:

几种特殊的矩阵:

A. 转置矩阵:

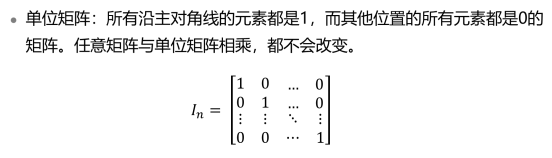

B. 单位矩阵:

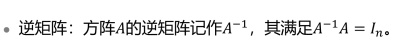

C. 逆矩阵:

D. 对角矩阵:

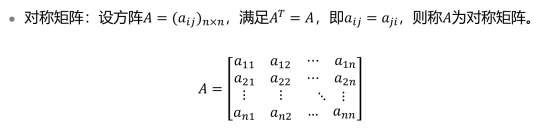

E. 对称矩阵:

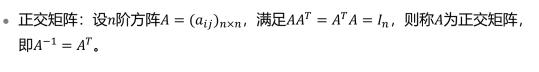

F. 正交矩阵:

矩阵的分解:

特征值分解和奇异值分解:

特征值分解:

矩阵乘法是对向量进行旋转、压缩。如图所示,如果矩阵作用于某一个向量或某些向量使这些向量只发生伸缩变换,不对这些向量产生旋转及投影的效果,那么这些向量就称为这个矩阵的特征向量,伸缩的比例就是特征值。

应用:

从线性空间的角度看,特征值越大,则矩阵在对应的特征向量上的方差越大,信息量越多。

在最优化中,矩阵特征值的大小与函数值的变化快慢有关,在最大特征值所对应的特征方向上函数值变化最大,也就是该方向上的方向导数最大。

在数据挖掘中,最大特征值对应的特征向量上包含最多的信息量。如果某几个特征值很小,说明这个方向上的信息量很小,可以用来降维的算法删除小特征值对应方向的数据,只保留大特征值方向对应的数据,这样做可以减少数据量,同时保留有用信息。

奇异值分解:

应用:

在机器学习和数据挖掘领域,有很多的应用都与奇异值相关,比如做特征减少的主成分分析(PCA)和线性判别分析(LDA),数据压缩(以图像压缩为代表)算法,还有做搜索引擎语义层次检索的LSI(Latent semantic indexing)。

奇异值分解和特征值分解的区别:

奇异值分解适用于所有矩阵;特征值分解只适用于方阵。

特征值分解和奇异值分解都是给一个矩阵找一组特殊的基,特征值分解找到了特征向量这组基,在这组基下该变换只有缩放效果。而奇异值分解则是一组基,将变换的旋转、缩放、投影三种功能独立地展示出来。

奇异值都是非负的,而特征值可能是负的

二、概率论与数理统计:

数据挖掘是在海量的数据中归纳、总结、分析数据的内在规律,概率论与数理统计是研究数据分布与如何处理数据的学科,在数据挖掘中的应用提高了数据挖掘的精度与效率。

复习:

随机事件:

随机变量:

特殊的离散分布:–伯努利分布

特殊的离散分布:–二项分布

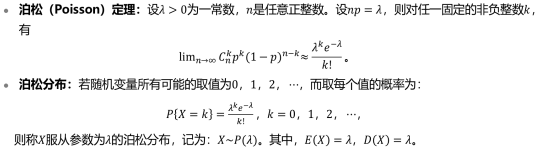

特殊的离散分布:–泊松分布

参数估计与假设检验:

对总体进行抽样后,我们需要根据样本对总体的指标作出具有一定可靠度的估计和判断,主要推断统计方法有参数估计和假设检验。

参数估计:

模型已定,但是参数未知,总体分布,其中几个参数未知。

估计未知参数的方法:

点估计和区间估计:

注意:两者相同点都是基于一个样本做出估计

不同点是,点估计只提供单一的估计值,而区间估计在点估计的基础上还提供一个误差界限,给出了取值范围。

方差分析和回归分析:

方差分析(Analysis of Variance , ANOVA): 用于两个及以上均数差别的显著性检验,即检测某个因素(自变量)对总体(因变量)是否具有显著影响。虽然我们关注的是均值,但是需要借助方差判断均值之间是否有差异。

回归分析(regression of analysis): 确定两种或两种以上变量之间互相依赖的定量关系的一种统计分析方法。回归分析得到的是因变量和自变量之间的更精确的回归函数关系。

两者关系:方差分析给出自变量(因素)与因变量(总量)是否相互独立的初步判断,不需要自变量(因素)的具体数据,只需要因变量(总量)的观察数据。在不独立即相关的条件下,自变量与因变量到底是什么样的关系类型,则需应用回归分析作出进一步的判断,此时需要自变量(因素)及因变量(总量)的具体观察数据,得到它们之间的回归函数关系式。

应用:回归分析在预测、优化、做决策与数据拟合等方面都有着广泛的应用。

三、信息熵与基尼系数

1.信息量:

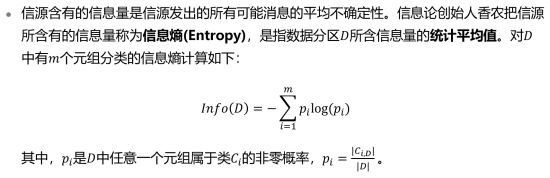

2.什么是信息熵?

信息熵:

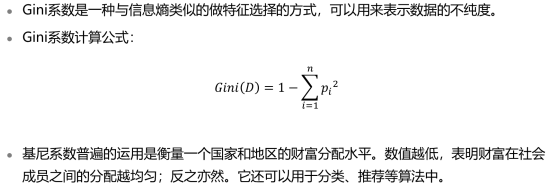

3.基尼系数:

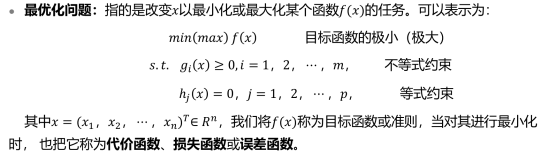

四、最优化

什么是最优化?

如果除了目标函数以外,对参与优化的各变量没有其他函数或变量约束,则称为无约束最优化问题。

反之称为有约束的最优化问题。

最优化的问题分类:

无约束最优化的求解方法主要有解析法和直接法。

解析法,即间接法,是根据无约束最优化问题的目标函数的解析表达式给出一种求最优解的方法,主要有梯度下降法、牛顿法、拟牛顿法、共轭方向法和共轭梯度法等。

直接法通常用于当目标函数表达式十分复杂或写不出具体表达式时的情况。通过数值计算,经过一系列迭代过程产生点列,在其中搜索最优点。

梯度下降:

约束最优化:分为等式约束最优化和不等式约束最优化:

总结:

求解无约束最优化、等式最优化、不等式最优化的常用方法:

无约束最优化:解析法(梯度下降法、牛顿法、拟牛顿法、共轭方向法和共轭梯度法);直接法。等式最优化:拉格朗日乘子法。不等式最优化:KKT条件