第1章 数据仓库概念

第2章 项目需求

2.1 项目需求分析

2.2 项目框架

2.2.1 技术选型

2.2.2 系统架构图设计

2.2.3 系统数据流程设计

2.2.4 框架版本选型

| 产品 |

版本 |

| Hadoop |

2.7.2 |

| Flume |

1.7.0 |

| Kafka |

0.11.0.2 |

| Kafka Manager |

1.3.3.22 |

| Hive |

1.2.1 |

| Sqoop |

1.4.6 |

| Mysql |

5.6.24 |

| Azkaban |

2.5.0 |

| Java |

1.8 |

| Zookeeper |

3.4.10 |

注意事项:框架选型尽量不要选择最新的框架,选择最新框架半年前左右的稳定版。

2.2.5 集群资源规划设计

|

|

服务器1 |

服务器2 |

服务器3 |

| HDFS |

NameNode DataNode |

DataNode |

DataNode |

| Yarn |

NodeManager |

Resourcemanager NodeManager |

NodeManager |

| Zookeeper |

Zookeeper |

Zookeeper |

Zookeeper |

| Flume(采集日志) |

Flume |

Flume |

|

| Kafka |

Kafka |

Kafka |

Kafka |

| Flume(消费Kafka) |

|

|

Flume |

| Hive |

Hive |

|

|

| Mysql |

Mysql |

|

|

第3章 数据生成模块

3.1 埋点数据基本格式

- 公共字段:基本所有安卓手机都包含的字段

- 业务字段:埋点上报的字段,有具体的业务类型

下面就是一个示例,表示业务字段的上传。

{

"ap":"xxxxx",//产品字段 app key

"cm": { //公共字段

"mid": "", // (String) 设备唯一标识

"uid": "", // (String) 用户标识

"vc": "1", // (String) versionCode,程序版本号

"vn": "1.0", // (String) versionName,程序版本名

"l": "zh", // (String) 系统语言

"sr": "", // (String) 渠道号,应用从哪个渠道来的。

"os": "7.1.1", // (String) Android系统版本

"ar": "CN", // (String) 区域

"md": "BBB100-1", // (String) 手机型号

"ba": "blackberry", // (String) 手机品牌

"sv": "V2.2.1", // (String) sdkVersion

"g": "", // (String) gmail

"hw": "1620x1080", // (String) heightXwidth,屏幕宽高

"t": "1506047606608", // (String) 客户端日志产生时的时间

"nw": "WIFI", // (String) 网络模式

"ln": 0, // (double) lng经度

"la": 0 // (double) lat 纬度

},

"et": [ //事件

{

"ett": "1506047605364", //客户端事件产生时间

"en": "request", //事件名称

"kv": { //事件结果,以key-value形式自行定义

"your key1": "your value1",

"your key2": "your value2",

"your key n": "your value n"

}

}

]

}

示例日志(服务器时间戳 | 日志):

1540934156385|{

"ap": "gmall",

"cm": {

"uid": "1234",

"vc": "2",

"vn": "1.0",

"la": "EN",

"sr": "",

"os": "7.1.1",

"ar": "CN",

"md": "BBB100-1",

"ba": "blackberry",

"sv": "V2.2.1",

"g": "[email protected]",

"hw": "1620x1080",

"t": "1506047606608",

"nw": "WIFI",

"ln": 0

},

"et": [

{

"ett": "1506047605364",

"en": "request",

"kv": {

"url": "www.baidu.com",

"click": "1"

}

}

]

}

}

下面是各个埋点日志格式。其中商品点击属于信息流的范畴

3.2 事件日志数据

3.2.1 商品点击(display)

事件标签:display

| 标签 |

含义 |

|

| action |

动作:曝光商品=1,点击商品=2, |

|

| newsid |

商品ID(服务端下发的ID) |

|

| place |

顺序(第几条商品,第一条为0,第二条为1,如此类推) |

|

| extend1 |

曝光类型:1 - 首次曝光 2-重复曝光(没有使用) |

|

| category |

分类ID(服务端定义的分类ID) |

|

3.2.2 商品详情页(newsdetail)

事件标签:newsdetail

| 标签 |

含义 |

|

| entry |

页面入口来源:应用首页=1、push=2、详情页相关推荐=3 |

|

| action |

动作:开始加载=1,加载成功=2(pv),加载失败=3, 退出页面=4 |

|

| newsid |

商品ID(服务端下发的ID) |

|

| show_style |

商品样式:0、无图 |

|

|

|

1、一张大图 |

|

|

|

2、两张图 |

|

|

|

3、三张小图 |

|

|

|

4、一张小图 |

|

|

|

5、一张大图两张小图 |

|

|

|

来源于详情页相关推荐的商品,上报样式都为0(因为都是左文右图) |

|

| news_staytime |

页面停留时长:从商品开始加载时开始计算,到用户关闭页面所用的时间。若中途用跳转到其它页面了,则暂停计时,待回到详情页时恢复计时。或中途划出的时间超过10分钟,则本次计时作废,不上报本次数据。如未加载成功退出,则报空。 |

|

| loading_time |

加载时长:计算页面开始加载到接口返回数据的时间 (开始加载报0,加载成功或加载失败才上报时间) |

|

| type1 |

加载失败码:把加载失败状态码报回来(报空为加载成功,没有失败) |

|

| category |

分类ID(服务端定义的分类ID) |

|

3.2.3 商品列表页(loading)

事件名称:loading

| 标签 |

含义 |

| action |

动作:开始加载=1,加载成功=2,加载失败=3 |

| loading_time |

加载时长:计算下拉开始到接口返回数据的时间,(开始加载报0,加载成功或加载失败才上报时间) |

| loading_way |

加载类型:1-读取缓存,2-从接口拉新数据 |

| extend1 |

扩展字段 Extend1 |

| extend2 |

扩展字段 Extend2 |

| type |

加载类型:自动加载=1,用户下拽加载=2,底部加载=3(底部条触发点击底部提示条/点击返回顶部加载) |

| type1 |

加载失败码:把加载失败状态码报回来(报空为加载成功,没有失败) |

3.2.4 广告(ad)

事件名称:ad

| 标签 |

含义 |

| entry |

入口:商品列表页=1 应用首页=2 商品详情页=3 |

| action |

动作:请求广告=1 取缓存广告=2 广告位展示=3 广告展示=4 广告点击=5 |

| content |

状态:成功=1 失败=2 |

| detail |

失败码(没有则上报空) |

| source |

广告来源:admob=1 facebook=2 ADX(百度)=3 VK(俄罗斯)=4 |

| behavior |

用户行为: |

| newstype |

Type: 1- 图文 2-图集 3-段子 4-GIF 5-视频 6-调查 7-纯文 8-视频+图文 9-GIF+图文 0-其他 |

| show_style |

内容样式:无图(纯文字)=6 一张大图=1 三站小图+文=4 一张小图=2 一张大图两张小图+文=3 图集+文 = 5 |

3.2.5 消息通知(notification)

事件标签:notification

| 标签 |

含义 |

| action |

动作:通知产生=1,通知弹出=2,通知点击=3,常驻通知展示(不重复上报,一天之内只报一次)=4 |

| type |

通知id:预警通知=1,天气预报(早=2,晚=3),常驻=4 |

| ap_time |

客户端弹出时间 |

| content |

备用字段 |

3.2.6 用户前台活跃(active_foreground)

事件标签: active_foreground

| 标签 |

含义 |

| push_id |

推送的消息的id,如果不是从推送消息打开,传空 |

| access |

1.push 2.icon 3.其他 |

3.2.7 用户后台活跃(active_background)

事件标签: active_background

| 标签 |

含义 |

| active_source |

1=upgrade,2=download(下载),3=plugin_upgrade |

3.2.8 评论(comment)

描述:评论表

| 序号 |

字段名称 |

字段描述 |

字段类型 |

长度 |

允许空 |

缺省值 |

| 1 |

comment_id |

评论表 |

int |

10,0 |

|

|

| 2 |

userid |

用户id |

int |

10,0 |

√ |

0 |

| 3 |

p_comment_id |

父级评论id(为0则是一级评论,不为0则是回复) |

int |

10,0 |

√ |

|

| 4 |

content |

评论内容 |

string |

1000 |

√ |

|

| 5 |

addtime |

创建时间 |

string |

|

√ |

|

| 6 |

other_id |

评论的相关id |

int |

10,0 |

√ |

|

| 7 |

praise_count |

点赞数量 |

int |

10,0 |

√ |

0 |

| 8 |

reply_count |

回复数量 |

int |

10,0 |

√ |

0 |

3.2.9 收藏(favorites)

描述:收藏

| 序号 |

字段名称 |

字段描述 |

字段类型 |

长度 |

允许空 |

缺省值 |

| 1 |

id |

主键 |

int |

10,0 |

|

|

| 2 |

course_id |

商品id |

int |

10,0 |

√ |

0 |

| 3 |

userid |

用户ID |

int |

10,0 |

√ |

0 |

| 4 |

add_time |

创建时间 |

string |

|

√ |

|

3.2.10 点赞(praise)

描述:所有的点赞表

| 序号 |

字段名称 |

字段描述 |

字段类型 |

长度 |

允许空 |

缺省值 |

| 1 |

id |

主键id |

int |

10,0 |

|

|

| 2 |

userid |

用户id |

int |

10,0 |

√ |

|

| 3 |

target_id |

点赞的对象id |

int |

10,0 |

√ |

|

| 4 |

type |

点赞类型 1问答点赞 2问答评论点赞 3 文章点赞数4 评论点赞 |

int |

10,0 |

√ |

|

| 5 |

add_time |

添加时间 |

string |

|

√ |

|

3.2.11 错误日志数据

| errorBrief |

错误摘要 |

| errorDetail |

错误详情 |

3.3 启动日志数据

事件标签: start action=1可以算成前台活跃

| 标签 |

含义 |

| entry |

入口: push=1,widget=2,icon=3,notification=4, lockscreen_widget =5 |

| open_ad_type |

开屏广告类型: 开屏原生广告=1, 开屏插屏广告=2 |

| action |

状态:成功=1 失败=2 |

| loading_time |

加载时长:计算下拉开始到接口返回数据的时间,(开始加载报0,加载成功或加载失败才上报时间) |

| detail |

失败码(没有则上报空) |

| extend1 |

失败的message(没有则上报空) |

3.5 数据生成脚本

3.5.1 创建Maven工程

1)创建log-collector

2)创建一个包名:com.newbies.appclient

3)在com.newbies.appclient包下创建一个类,AppMain。

4)在pom.xml文件中添加如下内容

<!--版本号统一-->

<properties>

<slf4j.version>1.7.20</slf4j.version>

<logback.version>1.0.7</logback.version>

</properties>

<dependencies>

<!--阿里巴巴开源json解析框架-->

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.51</version>

</dependency>

<!--日志生成框架-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>${slf4j.version}</version>

</dependency>

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-core</artifactId>

<version>${logback.version}</version>

</dependency>

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-classic</artifactId>

<version>${logback.version}</version>

</dependency>

</dependencies>

<!--编译打包插件-->

<build>

<plugins>

<plugin>

<artifactId>maven-compiler-plugin</artifactId>

<version>2.3.2</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

<plugin>

<artifactId>maven-assembly-plugin </artifactId>

<configuration>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

<archive>

<manifest>

<mainClass>com.newbies.appclient.AppMain</mainClass>

</manifest>

</archive>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

注意:com.newbies.appclient.AppMain要和自己建的全类名一致。

3.5.2 公共字段Bean

1)创建包名:com.newbies.bean

2)在com.newbies.bean包下依次创建如下bean对象

package com.newbies.bean;

import java.io.Serializable;

/**

* 公共日志

*/

public class AppBase implements Serializable{

private String mid; // (String) 设备唯一标识

private String uid; // (String) 用户uid

private String vc; // (String) versionCode,程序版本号

private String vn; // (String) versionName,程序版本名

private String l; // (String) 系统语言

private String sr; // (String) 渠道号,应用从哪个渠道来的。

private String os; // (String) Android系统版本

private String ar; // (String) 区域

private String md; // (String) 手机型号

private String ba; // (String) 手机品牌

private String sv; // (String) sdkVersion

private String g; // (String) gmail

private String hw; // (String) heightXwidth,屏幕宽高

private String t; // (String) 客户端日志产生时的时间

private String nw; // (String) 网络模式

private String ln; // (double) lng经度

private String la; // (double) lat 纬度

public String getMid() {

return mid;

}

public void setMid(String mid) {

this.mid = mid;

}

public String getUid() {

return uid;

}

public void setUid(String uid) {

this.uid = uid;

}

public String getVc() {

return vc;

}

public void setVc(String vc) {

this.vc = vc;

}

public String getVn() {

return vn;

}

public void setVn(String vn) {

this.vn = vn;

}

public String getL() {

return l;

}

public void setL(String l) {

this.l = l;

}

public String getSr() {

return sr;

}

public void setSr(String sr) {

this.sr = sr;

}

public String getOs() {

return os;

}

public void setOs(String os) {

this.os = os;

}

public String getAr() {

return ar;

}

public void setAr(String ar) {

this.ar = ar;

}

public String getMd() {

return md;

}

public void setMd(String md) {

this.md = md;

}

public String getBa() {

return ba;

}

public void setBa(String ba) {

this.ba = ba;

}

public String getSv() {

return sv;

}

public void setSv(String sv) {

this.sv = sv;

}

public String getG() {

return g;

}

public void setG(String g) {

this.g = g;

}

public String getHw() {

return hw;

}

public void setHw(String hw) {

this.hw = hw;

}

public String getT() {

return t;

}

public void setT(String t) {

this.t = t;

}

public String getNw() {

return nw;

}

public void setNw(String nw) {

this.nw = nw;

}

public String getLn() {

return ln;

}

public void setLn(String ln) {

this.ln = ln;

}

public String getLa() {

return la;

}

public void setLa(String la) {

this.la = la;

}

}

3.5.3 启动日志Bean

package com.newbies.bean;

/**

* 启动日志

*/

public class AppStart {

private String entry;//入口: push=1,widget=2,icon=3,notification=4, lockscreen_widget =5

private String open_ad_type;//开屏广告类型: 开屏原生广告=1, 开屏插屏广告=2

private String action;//状态:成功=1 失败=2

private String loading_time;//加载时长:计算下拉开始到接口返回数据的时间,(开始加载报0,加载成功或加载失败才上报时间)

private String detail;//失败码(没有则上报空)

private String extend1;//失败的message(没有则上报空)

public String getEntry() {

return entry;

}

public void setEntry(String entry) {

this.entry = entry;

}

public String getOpen_ad_type() {

return open_ad_type;

}

public void setOpen_ad_type(String open_ad_type) {

this.open_ad_type = open_ad_type;

}

public String getAction() {

return action;

}

public void setAction(String action) {

this.action = action;

}

public String getLoading_time() {

return loading_time;

}

public void setLoading_time(String loading_time) {

this.loading_time = loading_time;

}

public String getDetail() {

return detail;

}

public void setDetail(String detail) {

this.detail = detail;

}

public String getExtend1() {

return extend1;

}

public void setExtend1(String extend1) {

this.extend1 = extend1;

}

}

3.5.3 错误日志Bean

package com.newbies.bean;

/**

* 错误日志

*/

public class AppErrorLog {

private String errorBrief; //错误摘要

private String errorDetail; //错误详情

public String getErrorBrief() {

return errorBrief;

}

public void setErrorBrief(String errorBrief) {

this.errorBrief = errorBrief;

}

public String getErrorDetail() {

return errorDetail;

}

public void setErrorDetail(String errorDetail) {

this.errorDetail = errorDetail;

}

}

3.5.4 事件日志Bean之商品点击

package com.newbies.bean;

/**

* 商品点击日志

*/

public class AppDisplay {

private String action;//动作:曝光商品=1,点击商品=2,

private String newsid;//商品ID(服务端下发的ID)

private String place;//顺序(第几条商品,第一条为0,第二条为1,如此类推)

private String extend1;//曝光类型:1 - 首次曝光 2-重复曝光(没有使用)

private String category;//分类ID(服务端定义的分类ID)

public String getAction() {

return action;

}

public void setAction(String action) {

this.action = action;

}

public String getNewsid() {

return newsid;

}

public void setNewsid(String newsid) {

this.newsid = newsid;

}

public String getPlace() {

return place;

}

public void setPlace(String place) {

this.place = place;

}

public String getExtend1() {

return extend1;

}

public void setExtend1(String extend1) {

this.extend1 = extend1;

}

public String getCategory() {

return category;

}

public void setCategory(String category) {

this.category = category;

}

}

3.5.5 事件日志Bean之商品详情页

package com.newbies.bean;

/**

* 商品详情

*/

public class AppNewsDetail {

private String entry;//页面入口来源:应用首页=1、push=2、详情页相关推荐=3

private String action;//动作:开始加载=1,加载成功=2(pv),加载失败=3, 退出页面=4

private String newsid;//商品ID(服务端下发的ID)

private String showtype;//商品样式:0、无图1、一张大图2、两张图3、三张小图4、一张小图5、一张大图两张小图 来源于详情页相关推荐的商品,上报样式都为0(因为都是左文右图)

private String news_staytime;//页面停留时长:从商品开始加载时开始计算,到用户关闭页面所用的时间。若中途用跳转到其它页面了,则暂停计时,待回到详情页时恢复计时。或中途划出的时间超过10分钟,则本次计时作废,不上报本次数据。如未加载成功退出,则报空。

private String loading_time;//加载时长:计算页面开始加载到接口返回数据的时间 (开始加载报0,加载成功或加载失败才上报时间)

private String type1;//加载失败码:把加载失败状态码报回来(报空为加载成功,没有失败)

private String category;//分类ID(服务端定义的分类ID)

public String getEntry() {

return entry;

}

public void setEntry(String entry) {

this.entry = entry;

}

public String getAction() {

return action;

}

public void setAction(String action) {

this.action = action;

}

public String getNewsid() {

return newsid;

}

public void setNewsid(String newsid) {

this.newsid = newsid;

}

public String getShowtype() {

return showtype;

}

public void setShowtype(String showtype) {

this.showtype = showtype;

}

public String getNews_staytime() {

return news_staytime;

}

public void setNews_staytime(String news_staytime) {

this.news_staytime = news_staytime;

}

public String getLoading_time() {

return loading_time;

}

public void setLoading_time(String loading_time) {

this.loading_time = loading_time;

}

public String getType1() {

return type1;

}

public void setType1(String type1) {

this.type1 = type1;

}

public String getCategory() {

return category;

}

public void setCategory(String category) {

this.category = category;

}

}

3.5.6 事件日志Bean之商品列表页

package com.newbies.bean;

/**

* 商品列表

*/

public class AppLoading {

private String action;//动作:开始加载=1,加载成功=2,加载失败=3

private String loading_time;//加载时长:计算下拉开始到接口返回数据的时间,(开始加载报0,加载成功或加载失败才上报时间)

private String loading_way;//加载类型:1-读取缓存,2-从接口拉新数据 (加载成功才上报加载类型)

private String extend1;//扩展字段 Extend1

private String extend2;//扩展字段 Extend2

private String type;//加载类型:自动加载=1,用户下拽加载=2,底部加载=3(底部条触发点击底部提示条/点击返回顶部加载)

private String type1;//加载失败码:把加载失败状态码报回来(报空为加载成功,没有失败)

public String getAction() {

return action;

}

public void setAction(String action) {

this.action = action;

}

public String getLoading_time() {

return loading_time;

}

public void setLoading_time(String loading_time) {

this.loading_time = loading_time;

}

public String getLoading_way() {

return loading_way;

}

public void setLoading_way(String loading_way) {

this.loading_way = loading_way;

}

public String getExtend1() {

return extend1;

}

public void setExtend1(String extend1) {

this.extend1 = extend1;

}

public String getExtend2() {

return extend2;

}

public void setExtend2(String extend2) {

this.extend2 = extend2;

}

public String getType() {

return type;

}

public void setType(String type) {

this.type = type;

}

public String getType1() {

return type1;

}

public void setType1(String type1) {

this.type1 = type1;

}

}

3.5.7 事件日志Bean之广告

package com.newbies.bean;

/**

* 广告

*/

public class AppAd {

private String entry;//入口:商品列表页=1 应用首页=2 商品详情页=3

private String action;//动作:请求广告=1 取缓存广告=2 广告位展示=3 广告展示=4 广告点击=5

private String content;//状态:成功=1 失败=2

private String detail;//失败码(没有则上报空)

private String source;//广告来源:admob=1 facebook=2 ADX(百度)=3 VK(俄罗斯)=4

private String behavior;//用户行为: 主动获取广告=1 被动获取广告=2

private String newstype;//Type: 1- 图文 2-图集 3-段子 4-GIF 5-视频 6-调查 7-纯文 8-视频+图文 9-GIF+图文 0-其他

private String show_style;//内容样式:无图(纯文字)=6 一张大图=1 三站小图+文=4 一张小图=2 一张大图两张小图+文=3 图集+文 = 5

//一张大图+文=11 GIF大图+文=12 视频(大图)+文 = 13

//来源于详情页相关推荐的商品,上报样式都为0(因为都是左文右图)

public String getEntry() {

return entry;

}

public void setEntry(String entry) {

this.entry = entry;

}

public String getAction() {

return action;

}

public void setAction(String action) {

this.action = action;

}

public String getContent() {

return content;

}

public void setContent(String content) {

this.content = content;

}

public String getDetail() {

return detail;

}

public void setDetail(String detail) {

this.detail = detail;

}

public String getSource() {

return source;

}

public void setSource(String source) {

this.source = source;

}

public String getBehavior() {

return behavior;

}

public void setBehavior(String behavior) {

this.behavior = behavior;

}

public String getNewstype() {

return newstype;

}

public void setNewstype(String newstype) {

this.newstype = newstype;

}

public String getShow_style() {

return show_style;

}

public void setShow_style(String show_style) {

this.show_style = show_style;

}

}

3.5.8 事件日志Bean之消息通知

package com.newbies.bean;

/**

* 消息通知日志

*/

public class AppNotification {

private String action;//动作:通知产生=1,通知弹出=2,通知点击=3,常驻通知展示(不重复上报,一天之内只报一次)=4

private String type;//通知id:预警通知=1,天气预报(早=2,晚=3),常驻=4

private String ap_time;//客户端弹出时间

private String content;//备用字段

public String getAction() {

return action;

}

public void setAction(String action) {

this.action = action;

}

public String getType() {

return type;

}

public void setType(String type) {

this.type = type;

}

public String getAp_time() {

return ap_time;

}

public void setAp_time(String ap_time) {

this.ap_time = ap_time;

}

public String getContent() {

return content;

}

public void setContent(String content) {

this.content = content;

}

}

3.5.9 事件日志Bean之用户前台活跃

package com.newbies.bean;

/**

* 用户前台活跃

*/

public class AppActive_foreground {

private String push_id;//推送的消息的id,如果不是从推送消息打开,传空

private String access;//1.push 2.icon 3.其他

public String getPush_id() {

return push_id;

}

public void setPush_id(String push_id) {

this.push_id = push_id;

}

public String getAccess() {

return access;

}

public void setAccess(String access) {

this.access = access;

}

}

3.5.10 事件日志Bean之用户后台活跃

package com.newbies.bean;

/**

* 用户后台活跃

*/

public class AppActive_background {

private String active_source;//1=upgrade,2=download(下载),3=plugin_upgrade

public String getActive_source() {

return active_source;

}

public void setActive_source(String active_source) {

this.active_source = active_source;

}

}

3.5.11 事件日志Bean之用户评论

package com.newbies.bean;

/**

* 评论

*/

public class AppComment {

private int comment_id;//评论表

private int userid;//用户id

private int p_comment_id;//父级评论id(为0则是一级评论,不为0则是回复)

private String content;//评论内容

private String addtime;//创建时间

private int other_id;//评论的相关id

private int praise_count;//点赞数量

private int reply_count;//回复数量

public int getComment_id() {

return comment_id;

}

public void setComment_id(int comment_id) {

this.comment_id = comment_id;

}

public int getUserid() {

return userid;

}

public void setUserid(int userid) {

this.userid = userid;

}

public int getP_comment_id() {

return p_comment_id;

}

public void setP_comment_id(int p_comment_id) {

this.p_comment_id = p_comment_id;

}

public String getContent() {

return content;

}

public void setContent(String content) {

this.content = content;

}

public String getAddtime() {

return addtime;

}

public void setAddtime(String addtime) {

this.addtime = addtime;

}

public int getOther_id() {

return other_id;

}

public void setOther_id(int other_id) {

this.other_id = other_id;

}

public int getPraise_count() {

return praise_count;

}

public void setPraise_count(int praise_count) {

this.praise_count = praise_count;

}

public int getReply_count() {

return reply_count;

}

public void setReply_count(int reply_count) {

this.reply_count = reply_count;

}

}

3.5.12 事件日志Bean之用户收藏

package com.newbies.bean;

/**

* 收藏

*/

public class AppFavorites {

private int id;//主键

private int course_id;//商品id

private int userid;//用户ID

private String add_time;//创建时间

public int getId() {

return id;

}

public void setId(int id) {

this.id = id;

}

public int getCourse_id() {

return course_id;

}

public void setCourse_id(int course_id) {

this.course_id = course_id;

}

public int getUserid() {

return userid;

}

public void setUserid(int userid) {

this.userid = userid;

}

public String getAdd_time() {

return add_time;

}

public void setAdd_time(String add_time) {

this.add_time = add_time;

}

}

3.5.13 事件日志Bean之用户点赞

package com.newbies.bean;

/**

* 点赞

*/

public class AppPraise {

private int id; //主键id

private int userid;//用户id

private int target_id;//点赞的对象id

private int type;//点赞类型 1问答点赞 2问答评论点赞 3 文章点赞数4 评论点赞

private String add_time;//添加时间

public int getId() {

return id;

}

public void setId(int id) {

this.id = id;

}

public int getUserid() {

return userid;

}

public void setUserid(int userid) {

this.userid = userid;

}

public int getTarget_id() {

return target_id;

}

public void setTarget_id(int target_id) {

this.target_id = target_id;

}

public int getType() {

return type;

}

public void setType(int type) {

this.type = type;

}

public String getAdd_time() {

return add_time;

}

public void setAdd_time(String add_time) {

this.add_time = add_time;

}

}

3.5.14 主函数

在AppMain类中添加如下内容:

package com.newbies.appclient;

import java.io.UnsupportedEncodingException;

import java.util.Random;

import com.alibaba.fastjson.JSON;

import com.alibaba.fastjson.JSONArray;

import com.alibaba.fastjson.JSONObject;

import com.newbies.bean.*;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

/**

* 日志行为数据模拟

*/

public class AppMain {

private final static Logger logger = LoggerFactory.getLogger(AppMain.class);

static Random rand = new Random();

/**

* 1.appkey

* 2.循环遍历次数

* 3.uid的长度,默认是4

* 4.商品id的长度,默认是4

*

* @param args

*/

public static void main(String[] args) {

// appkey的名称

String appkey = args.length > 0 ? args[0] : "gmall";

// 循环遍历次数

int loop_len = args.length > 1 ? Integer.parseInt(args[1]) : 10 * 100;

// mid的长度

int mid_length = args.length > 2 ? Integer.parseInt(args[2]) : 3;

// uid的长度

int uid_length = args.length > 3 ? Integer.parseInt(args[3]) : 3;

// 商品id的长度

int newsid_length = args.length > 4 ? Integer.parseInt(args[4]) : 3;

for (int i = 0; i < loop_len; i++) {

JSONObject json = new JSONObject();

json.put("ap", appkey);

json.put("cm", generateComFields(mid_length,uid_length));

JSONArray eventsArray = new JSONArray();

int flag = rand.nextInt(2);

switch (flag) {

case (0):

//应用启动

if (rand.nextBoolean()) {

eventsArray.add(generateStart());

}

break;

case (1):

// 事件日志

// 商品点击,展示

if (rand.nextBoolean()) {

eventsArray.add(generateDisplay(newsid_length));

}

// 商品详情页

if (rand.nextBoolean()) {

eventsArray.add(generateNewsDetail(newsid_length));

}

// 商品列表页

if (rand.nextBoolean()) {

eventsArray.add(generateNewList());

}

// 广告

if (rand.nextBoolean()) {

eventsArray.add(generateAd());

}

// 消息通知

if (rand.nextBoolean()) {

eventsArray.add(generateNotification());

}

// 用户前台活跃

if (rand.nextBoolean()) {

eventsArray.add(generatbeforeground());

}

// 用户后台活跃

if (rand.nextBoolean()) {

eventsArray.add(generateBackground());

}

//故障日志

if (rand.nextBoolean()) {

eventsArray.add(generateError());

}

// 用户评论

if (rand.nextBoolean()) {

eventsArray.add(generateComment());

}

// 用户收藏

if (rand.nextBoolean()) {

eventsArray.add(generateFavorites());

}

// 用户点赞

if (rand.nextBoolean()) {

eventsArray.add(generatePraise());

}

break;

}

json.put("et", eventsArray);

// 时间

long millis = System.currentTimeMillis();

// 控制台打印

logger.info(millis + "|" + json.toJSONString());

}

}

/**

* 公共字段设置

*

* @param uid_length

* @return

*/

static JSONObject generateComFields(int mid_length, int uid_length) {

AppBase appBase = new AppBase();

// 设备id

appBase.setMid('m' + getRandomDigits(mid_length));

// 用户id

appBase.setUid('u' + getRandomDigits(uid_length));

// 程序版本号 5,6等

appBase.setVc("" + rand.nextInt(20));

// 程序版本名 v1.1.1

appBase.setVn("1." + rand.nextInt(4) + "." + rand.nextInt(10));

// 安卓系统版本

appBase.setOs("8." + rand.nextInt(3) + "." + rand.nextInt(10));

// 语言 es,en,pt

int flag = rand.nextInt(3);

switch (flag) {

case (0):

appBase.setL("es");

break;

case (1):

appBase.setL("en");

break;

case (2):

appBase.setL("pt");

break;

}

// 渠道号 从哪个渠道来的

appBase.setSr(getRandomChar(1));

// 区域

flag = rand.nextInt(2);

switch (flag) {

case 0:

appBase.setAr("BR");

case 1:

appBase.setAr("MX");

}

// 手机品牌 ba ,手机型号 md,就取2位数字了

flag = rand.nextInt(3);

switch (flag) {

case 0:

appBase.setBa("Sumsung");

appBase.setMd("sumsung-" + rand.nextInt(20));

break;

case 1:

appBase.setBa("Huawei");

appBase.setMd("Huawei-" + rand.nextInt(20));

break;

case 2:

appBase.setBa("HTC");

appBase.setMd("HTC-" + rand.nextInt(20));

break;

}

// 嵌入sdk的版本

appBase.setSv("V2." + rand.nextInt(10) + "." + rand.nextInt(10));

// gmail

appBase.setG(getRandomCharAndNumr(8) + "@gmail.com");

// 屏幕宽高 hw

flag = rand.nextInt(4);

switch (flag) {

case 0:

appBase.setHw("640*960");

break;

case 1:

appBase.setHw("640*1136");

break;

case 2:

appBase.setHw("750*1134");

break;

case 3:

appBase.setHw("1080*1920");

break;

}

// 客户端产生日志时间

long millis = System.currentTimeMillis();

appBase.setT("" + (millis - rand.nextInt(99999999)));

// 手机网络模式 3G,4G,WIFI

flag = rand.nextInt(3);

switch (flag) {

case 0:

appBase.setNw("3G");

break;

case 1:

appBase.setNw("4G");

break;

case 2:

appBase.setNw("WIFI");

break;

}

// 拉丁美洲 西经34°46′至西经117°09;北纬32°42′至南纬53°54′

// 经度

appBase.setLn((-34 - rand.nextInt(83) - rand.nextInt(60) / 10.0) + "");

// 纬度

appBase.setLa((32 - rand.nextInt(85) - rand.nextInt(60) / 10.0) + "");

JSONObject common = (JSONObject) JSON.toJSON(appBase);

return common;

}

/**

* 商品展示事件

*

* @return

*/

static JSONObject generateDisplay(int newsid_length) {

AppDisplay appDisplay = new AppDisplay();

boolean boolFlag = rand.nextInt(10) < 7 ? true : false;

// 动作:曝光商品=1,点击商品=2,

if (boolFlag) {

appDisplay.setAction("1");

} else {

appDisplay.setAction("2");

}

// 商品id

String newsId = 'n' + getRandomDigits(newsid_length);

appDisplay.setNewsid(newsId);

// 顺序 设置成6条吧

int flag = rand.nextInt(6);

appDisplay.setPlace("" + flag);

// 曝光类型

flag = 1 + rand.nextInt(2);

appDisplay.setExtend1("" + flag);

// 分类

flag = 1 + rand.nextInt(100);

appDisplay.setCategory("" + flag);

JSONObject jsonObject = (JSONObject) JSON.toJSON(appDisplay);

return packEventJson("display", jsonObject);

}

/**

* 商品详情页

*

* @param newsid_length

* @return

*/

static JSONObject generateNewsDetail(int newsid_length) {

AppNewsDetail appNewsDetail = new AppNewsDetail();

// 页面入口来源

int flag = 1 + rand.nextInt(3);

appNewsDetail.setEntry(flag + "");

// 动作

appNewsDetail.setAction("" + (rand.nextInt(4) + 1));

// 商品id

appNewsDetail.setNewsid('n' + getRandomDigits(newsid_length));

// 商品来源类型

flag = 1 + rand.nextInt(3);

appNewsDetail.setShowtype(flag + "");

// 商品样式

flag = rand.nextInt(6);

appNewsDetail.setShowtype("" + flag);

// 页面停留时长

flag = rand.nextInt(10) * rand.nextInt(7);

appNewsDetail.setNews_staytime(flag + "");

// 加载时长

flag = rand.nextInt(10) * rand.nextInt(7);

appNewsDetail.setLoading_time(flag + "");

// 加载失败码

flag = rand.nextInt(10);

switch (flag) {

case 1:

appNewsDetail.setType1("102");

break;

case 2:

appNewsDetail.setType1("201");

break;

case 3:

appNewsDetail.setType1("325");

break;

case 4:

appNewsDetail.setType1("433");

break;

case 5:

appNewsDetail.setType1("542");

break;

default:

appNewsDetail.setType1("");

break;

}

// 分类

flag = 1 + rand.nextInt(100);

appNewsDetail.setCategory("" + flag);

JSONObject eventJson = (JSONObject) JSON.toJSON(appNewsDetail);

return packEventJson("newsdetail", eventJson);

}

/**

* 商品列表

*

* @return

*/

static JSONObject generateNewList() {

AppLoading appLoading = new AppLoading();

// 动作

int flag = rand.nextInt(3) + 1;

appLoading.setAction(flag + "");

// 加载时长

flag = rand.nextInt(10) * rand.nextInt(7);

appLoading.setLoading_time(flag + "");

// 失败码

flag = rand.nextInt(10);

switch (flag) {

case 1:

appLoading.setType1("102");

break;

case 2:

appLoading.setType1("201");

break;

case 3:

appLoading.setType1("325");

break;

case 4:

appLoading.setType1("433");

break;

case 5:

appLoading.setType1("542");

break;

default:

appLoading.setType1("");

break;

}

// 页面 加载类型

flag = 1 + rand.nextInt(2);

appLoading.setLoading_way("" + flag);

// 扩展字段1

appLoading.setExtend1("");

// 扩展字段2

appLoading.setExtend2("");

// 用户加载类型

flag = 1 + rand.nextInt(3);

appLoading.setType("" + flag);

JSONObject jsonObject = (JSONObject) JSON.toJSON(appLoading);

return packEventJson("loading", jsonObject);

}

/**

* 广告相关字段

*

* @return

*/

static JSONObject generateAd() {

AppAd appAd = new AppAd();

// 入口

int flag = rand.nextInt(3) + 1;

appAd.setEntry(flag + "");

// 动作

flag = rand.nextInt(5) + 1;

appAd.setAction(flag + "");

// 状态

flag = rand.nextInt(10) > 6 ? 2 : 1;

appAd.setContent(flag + "");

// 失败码

flag = rand.nextInt(10);

switch (flag) {

case 1:

appAd.setDetail("102");

break;

case 2:

appAd.setDetail("201");

break;

case 3:

appAd.setDetail("325");

break;

case 4:

appAd.setDetail("433");

break;

case 5:

appAd.setDetail("542");

break;

default:

appAd.setDetail("");

break;

}

// 广告来源

flag = rand.nextInt(4) + 1;

appAd.setSource(flag + "");

// 用户行为

flag = rand.nextInt(2) + 1;

appAd.setBehavior(flag + "");

// 商品类型

flag = rand.nextInt(10);

appAd.setNewstype("" + flag);

// 展示样式

flag = rand.nextInt(6);

appAd.setShow_style("" + flag);

JSONObject jsonObject = (JSONObject) JSON.toJSON(appAd);

return packEventJson("ad", jsonObject);

}

/**

* 启动日志

*

* @return

*/

static JSONObject generateStart() {

AppStart appStart = new AppStart();

// 入口

int flag = rand.nextInt(5) + 1;

appStart.setEntry(flag + "");

// 开屏广告类型

flag = rand.nextInt(2) + 1;

appStart.setOpen_ad_type(flag + "");

// 状态

flag = rand.nextInt(10) > 8 ? 2 : 1;

appStart.setAction(flag + "");

// 加载时长

appStart.setLoading_time(rand.nextInt(20) + "");

// 失败码

flag = rand.nextInt(10);

switch (flag) {

case 1:

appStart.setDetail("102");

break;

case 2:

appStart.setDetail("201");

break;

case 3:

appStart.setDetail("325");

break;

case 4:

appStart.setDetail("433");

break;

case 5:

appStart.setDetail("542");

break;

default:

appStart.setDetail("");

break;

}

JSONObject jsonObject = (JSONObject) JSON.toJSON(appStart);

return packEventJson("start", jsonObject);

}

/**

* 消息通知

*

* @return

*/

static JSONObject generateNotification() {

AppNotification appNotification = new AppNotification();

int flag = rand.nextInt(4) + 1;

// 动作

appNotification.setAction(flag + "");

// 通知id

flag = rand.nextInt(4) + 1;

appNotification.setType(flag + "");

// 客户端弹时间

appNotification.setAp_time((System.currentTimeMillis() - rand.nextInt(99999999)) + "");

// 备用字段

appNotification.setContent("");

JSONObject jsonObject = (JSONObject) JSON.toJSON(appNotification);

return packEventJson("notification", jsonObject);

}

/**

* 前台活跃

*

* @return

*/

static JSONObject generatbeforeground() {

AppActive_foreground appActive_foreground = new AppActive_foreground();

// 推送消息的id

int flag = rand.nextInt(2);

switch (flag) {

case 1:

appActive_foreground.setAccess(flag + "");

break;

default:

appActive_foreground.setAccess("");

break;

}

// 1.push 2.icon 3.其他

flag = rand.nextInt(3) + 1;

appActive_foreground.setPush_id(flag + "");

JSONObject jsonObject = (JSONObject) JSON.toJSON(appActive_foreground);

return packEventJson("active_foreground", jsonObject);

}

/**

* 后台活跃

*

* @return

*/

static JSONObject generateBackground() {

AppActive_background appActive_background = new AppActive_background();

// 启动源

int flag = rand.nextInt(3) + 1;

appActive_background.setActive_source(flag + "");

JSONObject jsonObject = (JSONObject) JSON.toJSON(appActive_background);

return packEventJson("active_background", jsonObject);

}

/**

* 错误日志数据

*

* @return

*/

static JSONObject generateError() {

AppErrorLog appErrorLog = new AppErrorLog();

String[] errorBriefs = {"at cn.lift.dfdf.web.AbstractBaseController.validInbound(AbstractBaseController.java:72)", "at cn.lift.appIn.control.CommandUtil.getInfo(CommandUtil.java:67)"}; //错误摘要

String[] errorDetails = {"java.lang.NullPointerException\\n " + "at cn.lift.appIn.web.AbstractBaseController.validInbound(AbstractBaseController.java:72)\\n " + "at cn.lift.dfdf.web.AbstractBaseController.validInbound", "at cn.lift.dfdfdf.control.CommandUtil.getInfo(CommandUtil.java:67)\\n " + "at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)\\n" + " at java.lang.reflect.Method.invoke(Method.java:606)\\n"}; //错误详情

//错误摘要

appErrorLog.setErrorBrief(errorBriefs[rand.nextInt(errorBriefs.length)]);

//错误详情

appErrorLog.setErrorDetail(errorDetails[rand.nextInt(errorDetails.length)]);

JSONObject jsonObject = (JSONObject) JSON.toJSON(appErrorLog);

return packEventJson("error", jsonObject);

}

/**

* 为各个事件类型的公共字段(时间、事件类型、Json数据)拼接

*

* @param eventName

* @param jsonObject

* @return

*/

static JSONObject packEventJson(String eventName, JSONObject jsonObject) {

JSONObject eventJson = new JSONObject();

eventJson.put("ett", (System.currentTimeMillis() - rand.nextInt(99999999)) + "");

eventJson.put("en", eventName);

eventJson.put("kv", jsonObject);

return eventJson;

}

/**

* 获取定长度的数字

*

* @param leng

* @return

*/

static String getRandomDigits(int leng) {

String result = "";

for (int i = 0; i < leng; i++) {

result += rand.nextInt(10);

}

return result;

}

/**

* 获取随机字母组合

*

* @param length 字符串长度

* @return

*/

public static String getRandomChar(Integer length) {

String str = "";

Random random = new Random();

for (int i = 0; i < length; i++) {

// 字符串

str += (char) (65 + random.nextInt(26));// 取得大写字母

}

return str;

}

/**

* 获取随机字母数字组合

*

* @param length 字符串长度

* @return

*/

public static String getRandomCharAndNumr(Integer length) {

String str = "";

Random random = new Random();

for (int i = 0; i < length; i++) {

boolean b = random.nextBoolean();

if (b) { // 字符串

// int choice = random.nextBoolean() ? 65 : 97; 取得65大写字母还是97小写字母

str += (char) (65 + random.nextInt(26));// 取得大写字母

} else { // 数字

str += String.valueOf(random.nextInt(10));

}

}

return str;

}

/**

* 收藏

* @return

*/

static public JSONObject generateFavorites() {

AppFavorites favorites = new AppFavorites();

favorites.setCourse_id(rand.nextInt(10));

favorites.setUserid(rand.nextInt(10));

favorites.setAdd_time((System.currentTimeMillis() - rand.nextInt(99999999))+"");

JSONObject jsonObject = (JSONObject) JSON.toJSON(favorites);

return packEventJson("favorites",jsonObject);

}

/**

* 点赞

* @return

*/

static public JSONObject generatePraise() {

AppPraise praise=new AppPraise();

praise.setId(rand.nextInt(10));

praise.setUserid(rand.nextInt(10));

praise.setTarget_id(rand.nextInt(10));

praise.setType(rand.nextInt(4)+1);

praise.setAdd_time((System.currentTimeMillis() - rand.nextInt(99999999))+"" );

JSONObject jsonObject = (JSONObject) JSON.toJSON(praise);

return packEventJson("praise",jsonObject);

}

/**

* 评论

* @return

*/

static public JSONObject generateComment() {

AppComment comment = new AppComment();

comment.setComment_id(rand.nextInt(10));

comment.setUserid(rand.nextInt(10));

comment.setP_comment_id(rand.nextInt(5));

comment.setContent(getCONTENT());

comment.setAddtime((System.currentTimeMillis() - rand.nextInt(99999999))+"");

comment.setOther_id(rand.nextInt(10));

comment.setPraise_count(rand.nextInt(1000));

comment.setReply_count(rand.nextInt(200));

JSONObject jsonObject = (JSONObject) JSON.toJSON(comment);

return packEventJson("comment",jsonObject);

}

/**

* 生成单个汉字

*

* @return

*/

private static char getRandomChar() {

String str = "";

int hightPos; //

int lowPos;

Random random = new Random();

//随机生成汉子的两个字节

hightPos = (176 + Math.abs(random.nextInt(39)));

lowPos = (161 + Math.abs(random.nextInt(93)));

byte[] b = new byte[2];

b[0] = (Integer.valueOf(hightPos)).byteValue();

b[1] = (Integer.valueOf(lowPos)).byteValue();

try {

str = new String(b, "GBK");

} catch (UnsupportedEncodingException e) {

e.printStackTrace();

System.out.println("错误");

}

return str.charAt(0);

}

/**

* 拼接成多个汉字

* @return

*/

static public String getCONTENT() {

String str = "";

for (int i = 0; i < rand.nextInt(100);i++) {

str+=getRandomChar();

}

return str;

}

}

3.5.15 配置日志打印Logback

Spring boot x集成logback与SL4J一起使用,在磁盘打印日志,然后收集。Logback的配置文件由一个个appender组成。一个appender包括:

日志打印的方式(控制台,文件,远程)。其中远程的方式是将所有日志发送到日志服务器,然后统一管理。

日志的格式。(线程,调用方法类,级别,日志内容大小。)

日志的路径。

保留的时间长度。

日志切分的大小

异步日志打印非常关键,这样在高并发的时候不会让请求等待就可以返回。其中日志分为了3种。

控制台

错误日志输出(后台需要查看)

标准日志输出

具体使用:

1)在resources文件夹下创建logback.xml文件。

2)在logback.xml文件中填写如下配置

<?xml version="1.0" encoding="UTF-8"?>

<configuration debug="false">

<!--定义日志文件的存储地址 勿在 LogBack 的配置中使用相对路径 -->

<property name="LOG_HOME" value="/tmp/logs/" />

<!--配置规则类的位置-->

<!--<conversionRule conversionWord="ip" converterClass="com.newbies.appclient.IPLogConfig" />-->

<!-- 控制台输出 -->

<appender name="STDOUT"

class="ch.qos.logback.core.ConsoleAppender">

<encoder

class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符 -->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern>

</encoder>

</appender>

<!-- 按照每天生成日志文件。存储事件日志 -->

<appender name="FILE"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- <File>${LOG_HOME}/app.log</File>设置日志不超过${log.max.size}时的保存路径,注意,如果是web项目会保存到Tomcat的bin目录 下 -->

<rollingPolicy

class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志文件输出的文件名 -->

<FileNamePattern>${LOG_HOME}/app-%d{yyyy-MM-dd}.log</FileNamePattern>

<!--日志文件保留天数 -->

<MaxHistory>30</MaxHistory>

</rollingPolicy>

<encoder

class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--<pattern>%ip|%msg%n</pattern>-->

<pattern>%msg%n</pattern>

</encoder>

<!--日志文件最大的大小 -->

<triggeringPolicy

class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<MaxFileSize>10MB</MaxFileSize>

</triggeringPolicy>

</appender>

<!--异步打印日志-->

<appender name ="ASYNC_FILE" class= "ch.qos.logback.classic.AsyncAppender">

<!-- 不丢失日志.默认的,如果队列的80%已满,则会丢弃TRACT、DEBUG、INFO级别的日志 -->

<discardingThreshold >0</discardingThreshold>

<!-- 更改默认的队列的深度,该值会影响性能.默认值为256 -->

<queueSize>512</queueSize>

<!-- 添加附加的appender,最多只能添加一个 -->

<appender-ref ref = "FILE"/>

</appender>

<!-- 日志输出级别 -->

<root level="INFO">

<appender-ref ref="STDOUT" />

<appender-ref ref="ASYNC_FILE" />

<appender-ref ref="error" />

</root>

</configuration>

3.5.16 打包

1)采用maven对程序打包

2)采用带依赖的jar包。包含了程序运行需要的所有依赖。

3.5.17 启动

1)代码参数说明

// appkey的名称

String appkey = args.length > 0 ? args[0] : "gmall";

// 循环遍历次数

int loop_len = args.length > 1 ? Integer.parseInt(args[1]) : 10 * 100;

// mid的长度

int mid_length = args.length > 2 ? Integer.parseInt(args[2]) : 3;

// uid的长度

int uid_length = args.length > 3 ? Integer.parseInt(args[3]) : 3;

// 商品id的长度

int newsid_length = args.length > 4 ? Integer.parseInt(args[4]) : 3;

这里面有四个参数:

Appkey的名称,比如我有多个应用,那么我可以生成多个应用的日志

循环遍历次数,就是生成多少条日志

mid的长度,设备的长度,决定有多少设备(数字)

Uid的长度,用户的长度,决定有多少用户(数字)

商品id的长度,决定有多少商品(数字)

2)将生成的jar包log-collector-0.0.1-SNAPSHOT-jar-with-dependencies.jar拷贝到hadoop102、服务器上,并同步到hadoop103的/opt/module路径下,

[newbies@hadoop102 module]$ xsync log-collector-1.0-SNAPSHOT-jar-with-dependencies.jar3)在hadoop102上执行jar程序

[newbies@hadoop102 module]$ java -classpath log-collector-1.0-SNAPSHOT-jar-with-dependencies.jar com.newbies.appclient.AppMain >/opt/module/test.log4)在/tmp/logs路径下查看生成的日志文件

[newbies@hadoop102 module]$ cd /tmp/logs/

[newbies@hadoop102 logs]$ ls

app-2019-02-10.log

3.5.18 日志生成集群启动脚本

1)Linux环境变量配置:

(1)修改/etc/profile文件:所有用户的shell都有权使用这些环境变量。

(2)修改~/.bashrc文件:针对某一个特定的用户,如果你需要给某个用户权限使用这些环境变量,你只需要修改其个人用户主目录下的.bashrc文件就可以了。

(3)配置登录远程服务器立即source一下环境变量

[newbies@hadoop102 ~]$ cat /etc/profile >> .bashrc

[newbies@hadoop103 ~]$ cat /etc/profile >> .bashrc

[newbies@hadoop104 ~]$ cat /etc/profile >> .bashrc

2)具体脚本编写

在/home/newbies/bin目录下创建脚本lg.sh

[newbies@hadoop102 bin]$ vim lg.sh在脚本中编写如下内容

#! /bin/bash

for i in hadoop102 hadoop103

do

ssh $i "java -classpath /opt/module/log-collector-1.0-SNAPSHOT-jar-with-dependencies.jar com.newbies.appclient.AppMain >/opt/module/test.log &"

done

修改脚本执行权限

[newbies@hadoop102 bin]$ chmod 777 lg.sh启动脚本

[newbies@hadoop102 module]$ lg.sh 分别在hadoop102、hadoop103的/tmp/logs目录上查看生成的数据

[newbies@hadoop102 logs]$ ls

app-2019-02-10.log

[newbies@hadoop103 logs]$ ls

app-2019-02-10.log

3.5.19 集群时间同步修改脚本

在/home/newbies/bin目录下创建脚本dt.sh

[newbies@hadoop102 bin]$ vim dt.sh在脚本中编写如下内容

#!/bin/bash

log_date=$1

for i in hadoop102 hadoop103 hadoop104

do

ssh -t $i "sudo date -s $log_date"

done

修改脚本执行权限

[newbies@hadoop102 bin]$ chmod 777 dt.sh启动脚本

[newbies@hadoop102 bin]$ dt.sh 2019-2-103.5.20 集群所有进程查看脚本

在/home/newbies/bin目录下创建脚本xcall.sh

[newbies@hadoop102 bin]$ vim xcall.sh在脚本中编写如下内容

#! /bin/bash

for i in hadoop102 hadoop103 hadoop104

do

echo --------- $i ----------

ssh $i "$*"

done

修改脚本执行权限

[newbies@hadoop102 bin]$ chmod 777 xcall.sh启动脚本

[newbies@hadoop102 bin]$ xcall.sh jps第4章 数据采集模块

4.1 Hadoop安装

==============================Begin======================

第3章 Hadoop运行环境搭建(开发重点)

3.1 虚拟机环境准备

1. 克隆虚拟机

2. 修改克隆虚拟机的静态IP

3. 修改主机名

4. 关闭防火墙

5. 创建atguigu用户

6. 配置atguigu用户具有root权限(详见《尚硅谷大数据技术之Linux》)

7.在/opt目录下创建文件夹

(1)在/opt目录下创建module、software文件夹

[newbies@hadoop101 opt]$ sudo mkdir module

[newbies@hadoop101 opt]$ sudo mkdir software

(2)修改module、software文件夹的所有者cd

[newbies@hadoop101 opt]$ sudo chown newbies:newbies module/ software/

[newbies@hadoop101 opt]$ ll

总用量 8

drwxr-xr-x. 2 newbies newbies 4096 1月 17 14:37 module

drwxr-xr-x. 2 newbies newbies 4096 1月 17 14:38 software

3.2 安装JDK

1. 卸载现有JDK

(1)查询是否安装Java软件:

[newbies@hadoop101 opt]$ rpm -qa | grep java(2)如果安装的版本低于1.7,卸载该JDK:

[newbies@hadoop101 opt]$ sudo rpm -e 软件包(3)查看JDK安装路径:

[newbies@hadoop101 ~]$ which java2. 用SecureCRT工具将JDK导入到opt目录下面的software文件夹下面

“alt+p”进入sftp模式

选择jdk1.8拖入

1. 在Linux系统下的opt目录中查看软件包是否导入成功

[newbies@hadoop101 opt]$ cd software/

[newbies@hadoop101 software]$ ls

hadoop-2.7.2.tar.gz jdk-8u144-linux-x64.tar.gz

2. 解压JDK到/opt/module目录下

[newbies@hadoop101 software]$ tar -zxvf jdk-8u144-linux-x64.tar.gz -C /opt/module/3. 配置JDK环境变量

(1)先获取JDK路径

[newbies@hadoop101 jdk1.8.0_144]$ pwd

/opt/module/jdk1.8.0_144

(2)打开/etc/profile文件

[newbies@hadoop101 software]$ sudo vi /etc/profile在profile文件末尾添加JDK路径

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_144

export PATH=$PATH:$JAVA_HOME/bin

(3)保存后退出

:wq(4)让修改后的文件生效

[newbies@hadoop101 jdk1.8.0_144]$ source /etc/profile4. 测试JDK是否安装成功

[newbies@hadoop101 jdk1.8.0_144]# java -version

java version "1.8.0_144"

注意:重启(如果java -version可以用就不用重启)

[newbies@hadoop101 jdk1.8.0_144]$ sync

[newbies@hadoop101 jdk1.8.0_144]$ sudo reboot

3.3 安装Hadoop

0. Hadoop下载地址:

https://archive.apache.org/dist/hadoop/common/hadoop-2.7.2/

- 用SecureCRT工具将hadoop-2.7.2.tar.gz导入到opt目录下面的software文件夹下面

切换到sftp连接页面,选择Linux下编译的hadoop jar包拖入

2. 进入到Hadoop安装包路径下

[newbies@hadoop101 ~]$ cd /opt/software/3. 解压安装文件到/opt/module下面

[newbies@hadoop101 software]$ tar -zxvf hadoop-2.7.2.tar.gz -C /opt/module/4. 查看是否解压成功

[newbies@hadoop101 software]$ ls /opt/module/

hadoop-2.7.2

5. 将Hadoop添加到环境变量

(1)获取Hadoop安装路径

[newbies@hadoop101 hadoop-2.7.2]$ pwd

/opt/module/hadoop-2.7.2

(2)打开/etc/profile文件

[newbies@hadoop101 hadoop-2.7.2]$ sudo vi /etc/profile在profile文件末尾添加JDK路径:(shitf+g)

##HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-2.7.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

(3)保存后退出

:wq(4)让修改后的文件生效

[newbies@ hadoop101 hadoop-2.7.2]$ source /etc/profile6. 测试是否安装成功

[newbies@hadoop101 hadoop-2.7.2]$ hadoop version

Hadoop 2.7.2

7. 重启(如果Hadoop命令不能用再重启)

[newbies@ hadoop101 hadoop-2.7.2]$ sync

[newbies@ hadoop101 hadoop-2.7.2]$ sudo reboot

3.4 Hadoop目录结构

1、查看Hadoop目录结构

[newbies@hadoop101 hadoop-2.7.2]$ ll

总用量 52

drwxr-xr-x. 2 newbies newbies 4096 5月 22 2017 bin

drwxr-xr-x. 3 newbies newbies 4096 5月 22 2017 etc

drwxr-xr-x. 2 newbies newbies 4096 5月 22 2017 include

drwxr-xr-x. 3 newbies newbies 4096 5月 22 2017 lib

drwxr-xr-x. 2 newbies newbies 4096 5月 22 2017 libexec

-rw-r--r--. 1 newbies newbies 15429 5月 22 2017 LICENSE.txt

-rw-r--r--. 1 newbies newbies 101 5月 22 2017 NOTICE.txt

-rw-r--r--. 1 newbies newbies 1366 5月 22 2017 README.txt

drwxr-xr-x. 2 newbies newbies 4096 5月 22 2017 sbin

drwxr-xr-x. 4 newbies newbies 4096 5月 22 2017 share

2、重要目录

(1)bin目录:存放对Hadoop相关服务(HDFS,YARN)进行操作的脚本

(2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

(3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

(4)sbin目录:存放启动或停止Hadoop相关服务的脚本

(5)share目录:存放Hadoop的依赖jar包、文档、和官方案例

第4章 Hadoop运行模式

Hadoop运行模式包括:本地模式、伪分布式模式以及完全分布式模式。

Hadoop官方网站:http://hadoop.apache.org/

4.2 伪分布式运行模式

4.2.1 启动HDFS并运行MapReduce程序

1. 分析

(1)配置集群

(2)启动、测试集群增、删、查

(3)执行WordCount案例

2. 执行步骤

(1)配置集群

(a)配置:hadoop-env.sh

Linux系统中获取JDK的安装路径:

[newbies@ hadoop101 ~]# echo $JAVA_HOME

/opt/module/jdk1.8.0_144

修改JAVA_HOME 路径:

export JAVA_HOME=/opt/module/jdk1.8.0_144(b)配置:core-site.xml

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop101:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-2.7.2/data/tmp</value>

</property>

(c)配置:hdfs-site.xml

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

(2)启动集群

(a)格式化NameNode(第一次启动时格式化,以后就不要总格式化)

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs namenode -format(b)启动NameNode

[newbies@hadoop101 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start namenode(c)启动DataNode

[newbies@hadoop101 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start datanode(3)查看集群

(a)查看是否启动成功

[newbies@hadoop101 hadoop-2.7.2]$ jps

13586 NameNode

13668 DataNode

13786 Jps

注意:jps是JDK中的命令,不是Linux命令。不安装JDK不能使用jps

(b)web端查看HDFS文件系统

http://hadoop101:50070/dfshealth.html#tab-overview

注意:如果不能查看,看如下帖子处理

http://www.cnblogs.com/zlslch/p/6604189.html

(c)查看产生的Log日志

说明:在企业中遇到Bug时,经常根据日志提示信息去分析问题、解决Bug。

当前目录:/opt/module/hadoop-2.7.2/logs

[newbies@hadoop101 logs]$ ls

hadoop-newbies-datanode-hadoop.newbies.com.log

hadoop-newbies-datanode-hadoop.newbies.com.out

hadoop-newbies-namenode-hadoop.newbies.com.log

hadoop-newbies-namenode-hadoop.newbies.com.out

SecurityAuth-root.audit

[newbies@hadoop101 logs]# cat hadoop-newbies-datanode-hadoop101.log

(d)思考:为什么不能一直格式化NameNode,格式化NameNode,要注意什么?

[newbies@hadoop101 hadoop-2.7.2]$ cd data/tmp/dfs/name/current/

[newbies@hadoop101 current]$ cat VERSION

clusterID=CID-f0330a58-36fa-4a2a-a65f-2688269b5837

[newbies@hadoop101 hadoop-2.7.2]$ cd data/tmp/dfs/data/current/

clusterID=CID-f0330a58-36fa-4a2a-a65f-2688269b5837

注意:格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。所以,格式NameNode时,一定要先删除data数据和log日志,然后再格式化NameNode。

(4)操作集群

(a)在HDFS文件系统上创建一个input文件夹

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -mkdir -p /user/newbies/input(b)将测试文件内容上传到文件系统上

[newbies@hadoop101 hadoop-2.7.2]$bin/hdfs dfs -put wcinput/wc.input

/user/newbies/input/

(c)查看上传的文件是否正确

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -ls /user/newbies/input/

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -cat /user/newbies/ input/wc.input

(d)运行MapReduce程序

[newbies@hadoop101 hadoop-2.7.2]$ bin/hadoop jar

share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /user/newbies/input/ /user/newbies/output

(e)查看输出结果

命令行查看:

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -cat /user/newbies/output/*浏览器查看

(f)将测试文件内容下载到本地

[newbies@hadoop101 hadoop-2.7.2]$ hdfs dfs -get /user/newbies/output/part-r-00000 ./wcoutput/(g)删除输出结果

[newbies@hadoop101 hadoop-2.7.2]$ hdfs dfs -rm -r /user/newbies/output4.2.2 启动YARN并运行MapReduce程序

1. 分析

(1)配置集群在YARN上运行MR

(2)启动、测试集群增、删、查

(3)在YARN上执行WordCount案例

2. 执行步骤

(1)配置集群

(a)配置yarn-env.sh

配置一下JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_144(b)配置yarn-site.xml

<!-- Reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop101</value>

</property>

(c)配置:mapred-env.sh

配置一下JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_144(d)配置: (对mapred-site.xml.template重新命名为) mapred-site.xml

[newbies@hadoop101 hadoop]$ mv mapred-site.xml.template mapred-site.xml

[newbies@hadoop101 hadoop]$ vi mapred-site.xml

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

(2)启动集群

(a)启动前必须保证NameNode和DataNode已经启动

(b)启动ResourceManager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/yarn-daemon.sh start resourcemanager(c)启动NodeManager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/yarn-daemon.sh start nodemanager(3)集群操作

(a)YARN的浏览器页面查看,如图2-35所示

http://hadoop101:8088/cluster

(b)删除文件系统上的output文件

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -rm -R /user/newbies/output(c)执行MapReduce程序

[newbies@hadoop101 hadoop-2.7.2]$ bin/hadoop jar

share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /user/newbies/input /user/newbies/output

(d)查看运行结果,如图2-36所示

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -cat /user/newbies/output/*

4.2.3 配置历史服务器

为了查看程序的历史运行情况,需要配置一下历史服务器。具体配置步骤如下:

1. 配置mapred-site.xml

[newbies@hadoop101 hadoop]$ vi mapred-site.xml在该文件里面增加如下配置。

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop101:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop101:19888</value>

</property>

2. 启动历史服务器

[newbies@hadoop101 hadoop-2.7.2]$ sbin/mr-jobhistory-daemon.sh start historyserver3. 查看历史服务器是否启动

[newbies@hadoop101 hadoop-2.7.2]$ jps4. 查看JobHistory

http://hadoop101:19888/jobhistory

4.2.4 配置日志的聚集

日志聚集概念:应用运行完成以后,将程序运行日志信息上传到HDFS系统上。

日志聚集功能好处:可以方便的查看到程序运行详情,方便开发调试。

注意:开启日志聚集功能,需要重新启动NodeManager 、ResourceManager和HistoryManager。

开启日志聚集功能具体步骤如下:

- 配置yarn-site.xml

[newbies@hadoop101 hadoop]$ vi yarn-site.xml在该文件里面增加如下配置。

<!-- 日志聚集功能使能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留时间设置7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

2. 关闭NodeManager 、ResourceManager和HistoryManager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/yarn-daemon.sh stop resourcemanager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/yarn-daemon.sh stop nodemanager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/mr-jobhistory-daemon.sh stop historyserver

3. 启动NodeManager 、ResourceManager和HistoryManager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/yarn-daemon.sh start resourcemanager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/yarn-daemon.sh start nodemanager

[newbies@hadoop101 hadoop-2.7.2]$ sbin/mr-jobhistory-daemon.sh start historyserver

4. 删除HDFS上已经存在的输出文件

[newbies@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -rm -R /user/newbies/output5. 执行WordCount程序

[newbies@hadoop101 hadoop-2.7.2]$ hadoop jar

share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /user/newbies/input /user/newbies/output

6. 查看日志

http://hadoop101:19888/jobhistory

4.2.5 配置文件说明

Hadoop配置文件分两类:默认配置文件和自定义配置文件,只有用户想修改某一默认配置值时,才需要修改自定义配置文件,更改相应属性值。

(1)默认配置文件:

| 要获取的默认文件 |

文件存放在Hadoop的jar包中的位置 |

| [core-default.xml] |

hadoop-common-2.7.2.jar/ core-default.xml |

| [hdfs-default.xml] |

hadoop-hdfs-2.7.2.jar/ hdfs-default.xml |

| [yarn-default.xml] |

hadoop-yarn-common-2.7.2.jar/ yarn-default.xml |

| [mapred-default.xml] |

hadoop-mapreduce-client-core-2.7.2.jar/ mapred-default.xml |

(2)自定义配置文件:

core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml四个配置文件存放在$HADOOP_HOME/etc/hadoop这个路径上,用户可以根据项目需求重新进行修改配置。

4.3 完全分布式运行模式(开发重点)

分析:

1)准备3台客户机(关闭防火墙、静态ip、主机名称)

2)安装JDK

3)配置环境变量

4)安装Hadoop

5)配置环境变量

6)配置集群

7)单点启动

8)配置ssh

9)群起并测试集群

4.3.1 虚拟机准备

4.3.2 编写集群分发脚本xsync

1. scp(secure copy)安全拷贝

(1)scp定义:

scp可以实现服务器与服务器之间的数据拷贝。(from server1 to server2)

(2)基本语法

scp -r $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 递归 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称(3)案例实操

(a)在hadoop101上,将hadoop101中/opt/module目录下的软件拷贝到hadoop102上。

[newbies@hadoop101 /]$ scp -r /opt/module root@hadoop102:/opt/module(b)在hadoop103上,将hadoop101服务器上的/opt/module目录下的软件拷贝到hadoop103上。

[newbies@hadoop103 opt]$sudo scp -r newbies@hadoop101:/opt/module root@hadoop103:/opt/module(c)在hadoop103上操作将hadoop101中/opt/module目录下的软件拷贝到hadoop104上。

[newbies@hadoop103 opt]$ scp -r newbies@hadoop101:/opt/module root@hadoop104:/opt/module注意:拷贝过来的/opt/module目录,别忘了在hadoop102、hadoop103、hadoop104上修改所有文件的,所有者和所有者组。sudo chown newbies:newbies -R /opt/module

(d)将hadoop101中/etc/profile文件拷贝到hadoop102的/etc/profile上。

[newbies@hadoop101 ~]$ sudo scp /etc/profile root@hadoop102:/etc/profile(e)将hadoop101中/etc/profile文件拷贝到hadoop103的/etc/profile上。

[newbies@hadoop101 ~]$ sudo scp /etc/profile root@hadoop103:/etc/profile(f)将hadoop101中/etc/profile文件拷贝到hadoop104的/etc/profile上。

[newbies@hadoop101 ~]$ sudo scp /etc/profile root@hadoop104:/etc/profile注意:拷贝过来的配置文件别忘了source一下/etc/profile,。

2. rsync 远程同步工具

rsync主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点。

rsync和scp区别:用rsync做文件的复制要比scp的速度快,rsync只对差异文件做更新。scp是把所有文件都复制过去。

(1)基本语法

rsync -rvl $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 选项参数 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

选项参数说明

| 选项 |

功能 |

| -r |

递归 |

| -v |

显示复制过程 |

| -l |

拷贝符号连接 |

(2)案例实操

(a)把hadoop101机器上的/opt/software目录同步到hadoop102服务器的root用户下的/opt/目录

[newbies@hadoop101 opt]$ rsync -rvl /opt/software/ root@hadoop102:/opt/software3. xsync集群分发脚本

(1)需求:循环复制文件到所有节点的相同目录下

(2)需求分析:

(a)rsync命令原始拷贝:

rsync -rvl /opt/module root@hadoop103:/opt/

(b)期望脚本:

xsync要同步的文件名称

(c)说明:在/home/newbies/bin这个目录下存放的脚本,newbies用户可以在系统任何地方直接执行。

(3)脚本实现

(a)在/home/newbies目录下创建bin目录,并在bin目录下xsync创建文件,文件内容如下:

[newbies@hadoop102 ~]$ mkdir bin

[newbies@hadoop102 ~]$ cd bin/

[newbies@hadoop102 bin]$ touch xsync

[newbies@hadoop102 bin]$ vi xsync

在该文件中编写如下代码

#!/bin/bash

#1 获取输入参数个数,如果没有参数,直接退出

pcount=$#

if((pcount==0)); then

echo no args;

exit;

fi

#2 获取文件名称

p1=$1

fname=`basename $p1`

echo fname=$fname

#3 获取上级目录到绝对路径

pdir=`cd -P $(dirname $p1); pwd`

echo pdir=$pdir

#4 获取当前用户名称

user=`whoami`

#5 循环

for((host=103; host<105; host++)); do

echo ------------------- hadoop$host --------------

rsync -rvl $pdir/$fname $user@hadoop$host:$pdir

done

(b)修改脚本 xsync 具有执行权限

[newbies@hadoop102 bin]$ chmod 777 xsync(c)调用脚本形式:xsync 文件名称

[newbies@hadoop102 bin]$ xsync /home/newbies/bin注意:如果将xsync放到/home/newbies/bin目录下仍然不能实现全局使用,可以将xsync移动到/usr/local/bin目录下。

4.3.3 集群配置

1. 集群部署规划

|

|

hadoop102 |

hadoop103 |

hadoop104 |

| HDFS

|

NameNode DataNode |

DataNode |

SecondaryNameNode DataNode |

| YARN |

NodeManager |

ResourceManager NodeManager |

NodeManager |

2. 配置集群

(1)核心配置文件

配置core-site.xml

[newbies@hadoop102 hadoop]$ vi core-site.xml在该文件中编写如下配置

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop102:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-2.7.2/data/tmp</value>

</property>

(2)HDFS配置文件

配置hadoop-env.sh

[newbies@hadoop102 hadoop]$ vi hadoop-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

配置hdfs-site.xml

[newbies@hadoop102 hadoop]$ vi hdfs-site.xml在该文件中编写如下配置

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- 指定Hadoop辅助名称节点主机配置 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:50090</value>

</property>

(3)YARN配置文件

配置yarn-env.sh

[newbies@hadoop102 hadoop]$ vi yarn-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

配置yarn-site.xml

[newbies@hadoop102 hadoop]$ vi yarn-site.xml在该文件中增加如下配置

<!-- Reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

(4)MapReduce配置文件

配置mapred-env.sh

[newbies@hadoop102 hadoop]$ vi mapred-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

配置mapred-site.xml

[newbies@hadoop102 hadoop]$ cp mapred-site.xml.template mapred-site.xml

[newbies@hadoop102 hadoop]$ vi mapred-site.xml

在该文件中增加如下配置

<!-- 指定MR运行在Yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

3.在集群上分发配置好的Hadoop配置文件

[newbies@hadoop102 hadoop]$ xsync /opt/module/hadoop-2.7.2/4.查看文件分发情况

[newbies@hadoop103 hadoop]$ cat /opt/module/hadoop-2.7.2/etc/hadoop/core-site.xml4.3.4 集群单点启动

(1)如果集群是第一次启动,需要格式化NameNode

[newbies@hadoop102 hadoop-2.7.2]$ hadoop namenode -format(2)在hadoop102上启动NameNode

[newbies@hadoop102 hadoop-2.7.2]$ hadoop-daemon.sh start namenode

[newbies@hadoop102 hadoop-2.7.2]$ jps

3461 NameNode

(3)在hadoop102、hadoop103以及hadoop104上分别启动DataNode

[newbies@hadoop102 hadoop-2.7.2]$ hadoop-daemon.sh start datanode

[newbies@hadoop102 hadoop-2.7.2]$ jps

3461 NameNode

3608 Jps

3561 DataNode

[newbies@hadoop103 hadoop-2.7.2]$ hadoop-daemon.sh start datanode

[newbies@hadoop103 hadoop-2.7.2]$ jps

3190 DataNode

3279 Jps

[newbies@hadoop104 hadoop-2.7.2]$ hadoop-daemon.sh start datanode

[newbies@hadoop104 hadoop-2.7.2]$ jps

3237 Jps

3163 DataNode

(4)思考:每次都一个一个节点启动,如果节点数增加到1000个怎么办?

早上来了开始一个一个节点启动,到晚上下班刚好完成,下班

4.3.5 SSH无密登录配置

1. 配置ssh

(1)基本语法

ssh另一台电脑的ip地址

(2)ssh连接时出现Host key verification failed的解决方法

[newbies@hadoop102 opt] $ ssh 192.168.1.103

The authenticity of host '192.168.1.103 (192.168.1.103)' can't be established.

RSA key fingerprint is cf:1e:de:d7:d0:4c:2d:98:60:b4:fd:ae:b1:2d:ad:06.

Are you sure you want to continue connecting (yes/no)?

Host key verification failed.

(3)解决方案如下:直接输入yes

2. 无密钥配置

(1)免密登录原理

(2)生成公钥和私钥:

[newbies@hadoop102 .ssh]$ ssh-keygen -t rsa然后敲(三个回车),就会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

(3)将公钥拷贝到要免密登录的目标机器上

[newbies@hadoop102 .ssh]$ ssh-copy-id hadoop102

[newbies@hadoop102 .ssh]$ ssh-copy-id hadoop103

[newbies@hadoop102 .ssh]$ ssh-copy-id hadoop104

注意:

还需要在hadoop102上采用root账号,配置一下无密登录到hadoop102、hadoop103、hadoop104;

还需要在hadoop103上采用newbies账号配置一下无密登录到hadoop102、hadoop103、hadoop104服务器上。

3. .ssh文件夹下(~/.ssh)的文件功能解释

| known_hosts |

记录ssh访问过计算机的公钥(public key) |

| id_rsa |

生成的私钥 |

| id_rsa.pub |

生成的公钥 |

| authorized_keys |

存放授权过得无密登录服务器公钥 |

4.3.6 群起集群

1. 配置slaves

/opt/module/hadoop-2.7.2/etc/hadoop/slaves

[newbies@hadoop102 hadoop]$ vi slaves

在该文件中增加如下内容:

hadoop102

hadoop103

hadoop104

注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行。

同步所有节点配置文件

[newbies@hadoop102 hadoop]$ xsync slaves2. 启动集群

(1)如果集群是第一次启动,需要格式化NameNode(注意格式化之前,一定要先停止上次启动的所有namenode和datanode进程,然后再删除data和log数据)

[newbies@hadoop102 hadoop-2.7.2]$ bin/hdfs namenode -format(2)启动HDFS

[newbies@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh

[newbies@hadoop102 hadoop-2.7.2]$ jps

4166 NameNode

4482 Jps

4263 DataNode

[newbies@hadoop103 hadoop-2.7.2]$ jps

3218 DataNode

3288 Jps

[newbies@hadoop104 hadoop-2.7.2]$ jps

3221 DataNode

3283 SecondaryNameNode

3364 Jps

(3)启动YARN

[newbies@hadoop103 hadoop-2.7.2]$ sbin/start-yarn.sh注意:NameNode和ResourceManger如果不是同一台机器,不能在NameNode上启动 YARN,应该在ResouceManager所在的机器上启动YARN。

(4)Web端查看SecondaryNameNode

(a)浏览器中输入:http://hadoop104:50090/status.html

(b)查看SecondaryNameNode信息

3. 集群基本测试

(1)上传文件到集群

上传小文件

[newbies@hadoop102 hadoop-2.7.2]$ hdfs dfs -mkdir -p /user/newbies/input

[newbies@hadoop102 hadoop-2.7.2]$ hdfs dfs -put wcinput/wc.input /user/newbies/input

上传大文件

[newbies@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -put

/opt/software/hadoop-2.7.2.tar.gz /user/newbies/input

(2)上传文件后查看文件存放在什么位置

(a)查看HDFS文件存储路径

[newbies@hadoop102 subdir0]$ pwd/opt/module/hadoop-2.7.2/data/tmp/dfs/data/current/BP-938951106-192.168.10.107-1495462844069/current/finalized/subdir0/subdir0(b)查看HDFS在磁盘存储文件内容

[newbies@hadoop102 subdir0]$ cat blk_1073741825

hadoop yarn

hadoop mapreduce

newbies

newbies

(3)拼接

-rw-rw-r--. 1 newbies newbies 134217728 5月 23 16:01 blk_1073741836

-rw-rw-r--. 1 newbies newbies 1048583 5月 23 16:01 blk_1073741836_1012.meta

-rw-rw-r--. 1 newbies newbies 63439959 5月 23 16:01 blk_1073741837

-rw-rw-r--. 1 newbies newbies 495635 5月 23 16:01 blk_1073741837_1013.meta[newbies@hadoop102 subdir0]$ cat blk_1073741836>>tmp.file

[newbies@hadoop102 subdir0]$ cat blk_1073741837>>tmp.file

[newbies@hadoop102 subdir0]$ tar -zxvf tmp.file

(4)下载

[newbies@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -get

/user/newbies/input/hadoop-2.7.2.tar.gz ./

4.3.7 集群启动/停止方式总结

1. 各个服务组件逐一启动/停止

(1)分别启动/停止HDFS组件

hadoop-daemon.sh start / stop namenode / datanode / secondarynamenode(2)启动/停止YARN

yarn-daemon.sh start / stop resourcemanager / nodemanager2. 各个模块分开启动/停止(配置ssh是前提)常用

(1)整体启动/停止HDFS

start-dfs.sh / stop-dfs.sh

(2)整体启动/停止YARN

start-yarn.sh / stop-yarn.sh

4.3.8 集群时间同步

时间同步的方式:找一个机器,作为时间服务器,所有的机器与这台集群时间进行定时的同步,比如,每隔十分钟,同步一次时间。

配置时间同步具体实操:

1. 时间服务器配置(必须root用户)

(1)检查ntp是否安装

[root@hadoop102 桌面]# rpm -qa|grep ntpntp-4.2.6p5-10.el6.centos.x86_64

fontpackages-filesystem-1.41-1.1.el6.noarch

ntpdate-4.2.6p5-10.el6.centos.x86_64

(2)修改ntp配置文件

[root@hadoop102 桌面]# vi /etc/ntp.conf修改内容如下

a)修改1(授权192.168.1.0-192.168.1.255网段上的所有机器可以从这台机器上查询和同步时间)

#restrict 192.168.1.0 mask 255.255.255.0 nomodify notrap为

restrict 192.168.1.0 mask 255.255.255.0 nomodify notrapb)修改2(集群在局域网中,不使用其他互联网上的时间)

server 0.centos.pool.ntp.org iburst

server 1.centos.pool.ntp.org iburst

server 2.centos.pool.ntp.org iburst

server 3.centos.pool.ntp.org iburst为

#server 0.centos.pool.ntp.org iburst

#server 1.centos.pool.ntp.org iburst

#server 2.centos.pool.ntp.org iburst

#server 3.centos.pool.ntp.org iburstc)添加3(当该节点丢失网络连接,依然可以采用本地时间作为时间服务器为集群中的其他节点提供时间同步)

server 127.127.1.0

fudge 127.127.1.0 stratum 10(3)修改/etc/sysconfig/ntpd 文件

[root@hadoop102 桌面]# vim /etc/sysconfig/ntpd增加内容如下(让硬件时间与系统时间一起同步)

SYNC_HWCLOCK=yes(4)重新启动ntpd服务

[root@hadoop102 桌面]# service ntpd status

ntpd 已停[root@hadoop102 桌面]# service ntpd start

正在启动 ntpd: [确定]

(5)设置ntpd服务开机启动

[root@hadoop102 桌面]# chkconfig ntpd on2. 其他机器配置(必须root用户)

(1)在其他机器配置10分钟与时间服务器同步一次

[root@hadoop103桌面]# crontab -e编写定时任务如下:

*/10 * * * * /usr/sbin/ntpdate hadoop102(2)修改任意机器时间

[root@hadoop103桌面]# date -s "2017-9-11 11:11:11"(3)十分钟后查看机器是否与时间服务器同步

[root@hadoop103桌面]# date说明:测试的时候可以将10分钟调整为1分钟,节省时间。

=============================End========================

|

|

服务器1 |

服务器2 |

服务器3 |

| HDFS |

NameNode DataNode |

DataNode |

DataNode |

| Yarn |

NodeManager |

Resourcemanager NodeManager |

NodeManager |

4.1.1 添加LZO支持包

1)先下载lzo的jar项目

https://github.com/twitter/hadoop-lzo/archive/master.zip

2)下载后的文件名是hadoop-lzo-master,它是一个zip格式的压缩包,先进行解压,然后用maven编译。生成hadoop-lzo-0.4.20。

3)将编译好后的hadoop-lzo-0.4.20.jar 放入hadoop-2.7.2/share/hadoop/common/

[newbies@hadoop102 common]$ pwd

/opt/module/hadoop-2.7.2/share/hadoop/common

[newbies@hadoop102 common]$ ls

hadoop-lzo-0.4.20.jar

4)同步hadoop-lzo-0.4.20.jar到hadoop103、hadoop104

[newbies@hadoop102 common]$ xsync hadoop-lzo-0.4.20.jar4.1.2 添加配置

1)core-site.xml增加配置支持LZO压缩

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>io.compression.codecs</name>

<value>

org.apache.hadoop.io.compress.GzipCodec,

org.apache.hadoop.io.compress.DefaultCodec,

org.apache.hadoop.io.compress.BZip2Codec,

org.apache.hadoop.io.compress.SnappyCodec,

com.hadoop.compression.lzo.LzoCodec,

com.hadoop.compression.lzo.LzopCodec

</value>

</property>

<property>

<name>io.compression.codec.lzo.class</name>

<value>com.hadoop.compression.lzo.LzoCodec</value>

</property>

</configuration>

2)同步core-site.xml到hadoop103、hadoop104

[newbies@hadoop102 hadoop]$ xsync core-site.xml4.1.2 启动集群

[newbies@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh

[newbies@hadoop103 hadoop-2.7.2]$ sbin/start-yarn.sh

4.1.3 验证

1)web和进程查看

- Web查看:http://hadoop102:50070

- 进程查看:jps查看各个节点状态。

2)当启动发生错误的时候:

- 查看日志:/home/newbies/module/hadoop-2.7.2/logs

- 如果进入安全模式,可以通过hdfs dfsadmin -safemode leave

- 停止所有进程,删除data和log文件夹,然后hdfs namenode -format 来格式化

4.2 Zookeeper安装

4.2.1 安装ZK

======================== Begin ==============

第2章 Zookeeper安装

2.1 本地模式安装部署

1.安装前准备

(1)安装Jdk

(2)拷贝Zookeeper安装包到Linux系统下

(3)解压到指定目录

[newbies@hadoop102 software]$ tar -zxvf zookeeper-3.4.10.tar.gz -C /opt/module/2.配置修改

(1)将/opt/module/zookeeper-3.4.10/conf这个路径下的zoo_sample.cfg修改为zoo.cfg;

[newbies@hadoop102 conf]$ mv zoo_sample.cfg zoo.cfg(2)打开zoo.cfg文件,修改dataDir路径:

[newbies@hadoop102 zookeeper-3.4.10]$ vim zoo.cfg修改如下内容:

dataDir=/opt/module/zookeeper-3.4.10/zkData(3)在/opt/module/zookeeper-3.4.10/这个目录上创建zkData文件夹

[newbies@hadoop102 zookeeper-3.4.10]$ mkdir zkData3.操作Zookeeper

(1)启动Zookeeper

[newbies@hadoop102 zookeeper-3.4.10]$ bin/zkServer.sh start(2)查看进程是否启动

[newbies@hadoop102 zookeeper-3.4.10]$ jps

4020 Jps

4001 QuorumPeerMain

(3)查看状态:

[newbies@hadoop102 zookeeper-3.4.10]$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /opt/module/zookeeper-3.4.10/bin/../conf/zoo.cfg

Mode: standalone

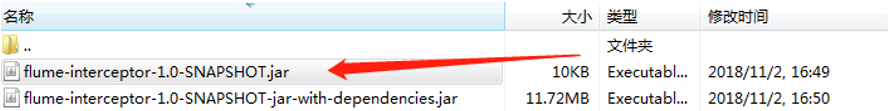

(4)启动客户端: