随机森林-集成学习方法(分类)

1 集成学习方法

集成学习通过建立几个模型组合的来解决单一预测问题。它的工作原理是生成多个分类器/模型,各自独立地学习和作出预测。这些预测最后结合成单预测,因此优于任何一个单分类的做出预测。

2 随机森林

在机器学习中,随机森林是一个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数而定。

在决策树中,一个标准的决策树会根据每维特征对预测结果的影响程度进行排序,进而决定不同的特征从上至下构建分裂节点的顺序,如此以来,所有在随机森林中的决策树都会受这一策略影响而构建的完全一致,从而丧失的多样性。所以在随机森林分类器的构建过程中,每一棵决策树都会放弃这一固定的排序算法,转而随机选取特征。

3 学习算法

根据下列算法而建造每棵树:

(1)用N来表示训练用例(样本)的个数,M表示特征数目;

(2)输入特征数目m,用于确定决策树上一个节点的决策结果,其中m应远小于M;

(3)从N个训练用例(样本)中以随机有放回抽样的方式,取样N次,形成一个训练集(即bootstrap取样),并用未抽到的用例(样本)作预测,评估其误差。

(4)对于每一个节点,随机选择m个特征,决策树上每个节点的决定都是基于这些特征确定的。根据这m个特征,计算其最佳的分裂方式。

随机抽样训练集目的:如果不进行随机抽样,每棵树的训练集都一样,那么最终训练出的树分类结果也是完全一样的

有返回抽样的目的:如果不是有放回的抽样,那么每棵树的训练样本都是不同的,都是没有交集的,也就是说每棵树训练出来都是有很大的差异的,而随机森林最后分类取决于多棵树(弱分类器)的投票表决。

4 集成学习API

class sklearn.ensemble.RandomForestClassifier(n_estimators=10, criterion=’gini’, max_depth=None, bootstrap=True, random_state=None) 随机森林分类器

n_estimators:integer,optional(default = 10) 森林里的树木数量

criteria:string,可选(default =“gini”)分割特征的测量方法

max_depth:integer或None,可选(默认=无)树的最大深度

bootstrap:boolean,optional(default = True)是否在构建树时使用放回抽样

5 案例

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.feature_extraction import DictVectorizer

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

# 1.加载数据

datas = pd.read_csv("http://biostat.mc.vanderbilt.edu/wiki/pub/Main/DataSets/titanic.txt")

# 2.处理数据,找出目标值和特征值

x = datas[['pclass','age','sex']]

y = datas['survived']

# 2.1利用pandas.DataFrame.fillna方法处理缺失数据,inplace=True直接修改原对象

x['age'].fillna(x['age'].mean(),inplace=True)

# 3 分割数据集为训练集合测试集

x_train,x_test,y_train,y_test = train_test_split(x,y,test_size=0.25)

# 4.特征工程的抽取 特征->类别->one_hot编码

# 当特征里面是类别的信息,应该要one-hot编码,否则计算机不知道怎么去计算

dict = DictVectorizer(sparse=False)

# 将x_train(DataFrame类型)转换为字典,关键字orient='records' 时形成[{column -> value}, … , {column -> value}]的结构

# 整体构成一个列表,内层是将原始数据的每行提取出来形成字典

x_train = dict.fit_transform(x_train.to_dict(orient='records'))

print(dict.get_feature_names())

x_test = dict.transform(x_test.to_dict(orient='records'))

# 5.随机森林预测(使用超参数调优,所以在此不添加任何参数)

rfcls = RandomForestClassifier()

params = {"n_estimators":[120,200,300,500,800,1200],"max_depth":[5,10,15,20,25]}

# 6网格搜索与交叉验证

gc = GridSearchCV(rfcls,param_grid=params,cv=10)

gc.fit(x_train,y_train)

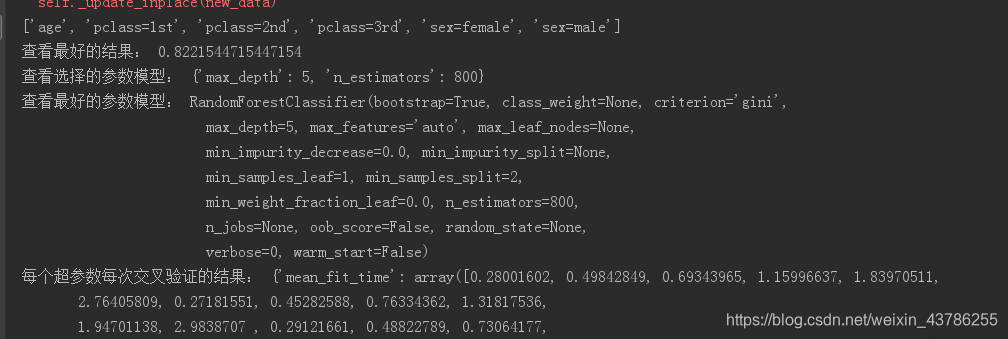

print("查看最好的结果:",gc.best_score_)

print("查看选择的参数模型:",gc.best_params_)

print("查看最好的参数模型:",gc.best_estimator_)

print("每个超参数每次交叉验证的结果:", gc.cv_results_)6 随机森林的优缺点

优点:在当前所有算法中,具有极好的准确率;能够有效地运行在大数据集上;能够处理具有高维特征的输入样本,而且不需要降维;能够评估各个特征在分类问题上的重要性;对于缺省值问题也能够获得很好得结果。

随机森林没有缺点,有的就是选不到合适的参数和特征值。参数选择和特征值准备共同决定最终的预测效果。