part1

agent与环境一直交互

监督学习的样本之间是独立同分布,训练的时候是直接把label输入给他,通过loss训练

强化学习则都不满足这两个情况,样本相关,而且反馈不及时。

游戏中并不知道决策是否正确,也就是奖励延迟。

探索和收益的权衡

没有监督者

监督学习中如果数据相关,则会不稳定,因此需要iid。

为什么关注?因为会有超人的表现。

监督学习上限是人的能力,强化学习则是自己在环境中学习。

pong游戏

输入图片,输出动作的可能性

rollout:从当前帧(s)生成很多数据。从wim去训练

deepRl 类比deepCV

通过卷积(结合特征提取和分类,端到端)

传统强化学习,通过手工制作的特征去描述现在状态,训练价值估计函数决策。

神经网络直接输入状态,不需要手工设计特征,通过神经网络拟合函数就可以。

强化学习如今成功的原因:

(1)、硬件GPU

(2)、端到端

强化学习应用到机械臂:因为建模标签复杂。

应用:

先在虚拟环境中训练,再应用到实际中。

part2

下象棋的奖励是下完一句得到的

智能体是历史的函数

智能体的观测不一定是环境的全部信息(POMDP)

组成成分:

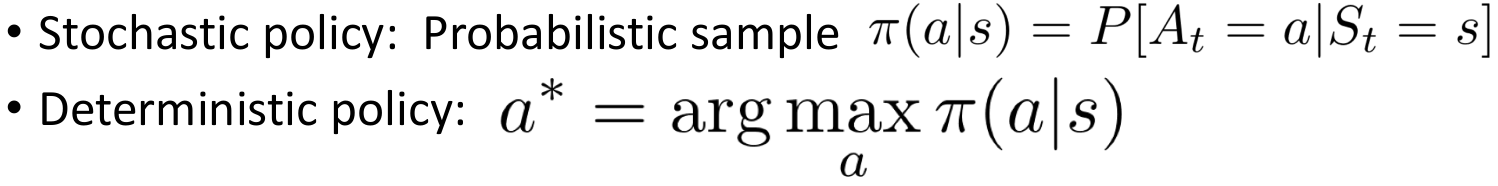

policy:两种

value function:

v:特定状态下执行策略pai得到的期望奖励。Discount未来奖励的加和,是一个期望。

q:特定状态-动作下的奖励

model:

模型决定下一状态会是什么样,奖励会是什么样

有了这三个成分以后就形成了一个马尔科夫决策过程。可视化了状态之间的转移,以及我们之间采取的行为。

例子:

分类一:

基于值函数:

显式学习:值函数

隐式学习:策略

基于策略:

显式学习:策略

隐式学习:无

actor-critic两者都学习

分类二:

资源:

课程相关代码:

https://github.com/cuhkrlcourse/RLexample

openai(游戏):

https://openai.com/

openai gym 代码:

import gym

env = gym.make("Taxi-v2")

observation = env.reset()

agent = load_agent()

for step in range(100):

action = agent(observation)

observation, reward, done, info = env.step(action)

其中经典的控制类游戏:

https://gym.openai.com/envs/#classic_control

第二个游戏代码:

import gym

env = gym.make('CartPole-v0’)

env.reset()

env.render() # display the rendered scene

action = env.action_space.sample()

observation, reward, done, info = env.step(action)