Tabla de contenido

2. CelebA (atributo de celebridad)

1.MS COCO (Objetos Comunes en Contexto)

conjunto de datos de vista de calle

DTD (Conjunto de datos de texturas descriptibles)

conjunto de datos de construcción

conjunto de datos faciales

1.Cara de Helen

Introducción del conjunto de datos:

El conjunto de datos de Helen Face es un conjunto de datos para la detección de puntos clave de rostros, que contiene 2330 imágenes de rostros, que cubren diferentes posturas, expresiones, iluminación y otras condiciones. Cada imagen tiene una etiqueta correspondiente, que incluye la información de posición de los puntos clave de la cara. Este conjunto de datos fue desarrollado por el grupo de investigación de Helen en 2011 para entrenar y evaluar algoritmos de detección de puntos clave de rostros. Dado que el conjunto de datos de Helen Face contiene una gran cantidad de imágenes de rostros y se han marcado los puntos clave, se puede usar para entrenar el algoritmo para que reconozca los puntos clave del rostro.

En el algoritmo de reparación de imágenes de entrenamiento, dado que las imágenes en el conjunto de datos de Helen Face cubren diferentes posturas, expresiones, iluminación y otras condiciones, se puede usar para entrenar el algoritmo de detección de puntos clave de rostros; también se puede usar para entrenar el algoritmo de reparación de rostros , como el algoritmo de entrenamiento para eliminar la oclusión de la cara, el desenfoque y otros problemas en la imagen.

Fuente del conjunto de datos:

Enlace: http://www.ifp.illinois.edu/~vuongle2/helen/

Productor: Helen Research Group (un grupo de investigación integrado por el Departamento de Ciencias e Ingeniería Informática de la Universidad de Illinois en Urbana-Champaign, EE. UU.)

原始文章: AS Razavian, H. Azizpour, J. Sullivan y S. Carlsson, "CNN características listas para usar: una línea de base asombrosa para el reconocimiento", en la Conferencia IEEE sobre talleres de reconocimiento de patrones y visión por computadora, 2014, págs. 806-813.

Ejemplo de muestra:

2. Atributo de celebridad _ _

Introducción del conjunto de datos:

El conjunto de datos de CelebA es un conjunto de datos que consta de imágenes de rostros y etiquetas de atributos asociadas. Contiene más de 200.000 imágenes faciales de alta resolución de más de 10.000 celebridades diferentes. Cada imagen tiene 40 etiquetas de atributos diferentes, como género, edad, patillas, color de ojos, etc., que se pueden usar para entrenar y evaluar los sistemas de visión por computadora.

El conjunto de datos de CelebA consta de una gran cantidad de imágenes de rostros de alta calidad, por lo que se puede usar para entrenar y evaluar algoritmos de pintura de imágenes. Por ejemplo, se puede entrenar un algoritmo en el conjunto de datos de CelebA para pintar imágenes con caras ocluidas o para predecir el color y la textura de las partes que faltan en el conjunto de datos.

Fuente del conjunto de datos:

Enlace: Conjunto de datos de CelebA

Institución productora: Laboratorio Multimedia (CUHK) de la Universidad China de Hong Kong

原始文章: Liu, Z., Luo, P., Wang, X. y Tang, X. (2015). Atributos faciales de aprendizaje profundo en la naturaleza. En Actas de la Conferencia Internacional IEEE sobre Visión por Computador (págs. 3730-3738)

Ejemplo de muestra :

3. Tipo A - Sede

Introducción del conjunto de datos:

El conjunto de datos de CelebA-HQ es una versión mejorada del conjunto de datos de CelebA, que consiste en imágenes de rostros de alta resolución y etiquetas de atributos relacionados. Contiene más de 30 000 imágenes faciales de alta resolución (1024x1024) de más de 1000 celebridades diferentes. Cada imagen tiene 40 etiquetas de atributos diferentes, como género, edad, patillas, color de ojos, etc., que se pueden usar para entrenar y evaluar los sistemas de visión por computadora. El conjunto de datos de CelebA-HQ se utiliza principalmente para tareas de reconstrucción de superresolución y generación de rostros de alta resolución porque proporciona imágenes de rostros de alta resolución y etiquetas de atributos relacionadas.

En comparación con el conjunto de datos de CelebA, el conjunto de datos de CelebA-HQ tiene una resolución más alta y más muestras, por lo que se puede utilizar mejor para tareas de reconstrucción de superresolución y generación de caras de alta resolución. Cada imagen en el conjunto de datos de CelebA-HQ tiene una variedad de etiquetas de atributos, lo que permite que el algoritmo de restauración de imágenes considere información de atributos, como género, edad, color de cabello, etc., al reparar la imagen, para repararla mejor. y acercarse a personas reales La mirada de la cara.

Fuente del conjunto de datos

Enlace: https://github.com/tkarras/progressive_growing_of_gans

Producciones: Tero Karras, Samuli Laine, Timo Aila e investigadores de NVIDIA

Dirección: Karras, T., Laine, S. y Aila, T. (2018). Crecimiento progresivo de gans para mejorar la calidad, la estabilidad y la variación. En Congreso Internacional de Representaciones de Aprendizaje.

Ejemplo de muestra :

4.FFHQ ( Flickr - Rostros - HQ )

Introducción del conjunto de datos:

El conjunto de datos FFHQ es un conjunto de datos de imágenes faciales de alta calidad que contiene más de 70 000 imágenes faciales de alta resolución (1024x1024) de más de 8000 celebridades diferentes. Cada imagen tiene una variedad de etiquetas de atributos, que se pueden usar para entrenar y evaluar los sistemas de visión por computadora.

El conjunto de datos FFHQ se utiliza principalmente para el entrenamiento y la evaluación de redes antagónicas generativas (GAN), ya que proporciona una gran cantidad de imágenes faciales de alta resolución y etiquetas de atributos relacionadas. En comparación con el conjunto de datos CelebA-HQ, el conjunto de datos FFHQ es más grande y diverso, y es más adecuado para tareas de generación de caras de alta calidad.

Al entrenar la imagen en el modelo de pintura, el uso del conjunto de datos FFHQ puede permitir que el modelo aprenda los detalles de las caras de alta resolución, y las etiquetas de atributos se pueden usar para garantizar que la imagen pintada esté más en línea con la autenticidad de la cara. Para los algoritmos de repintado de imágenes, el conjunto de datos FFHQ se puede utilizar para tareas como la reconstrucción de superresolución, la generación de rostros de alta resolución y el repintado de imágenes, que pueden reparar mejor las características faciales como los ojos, la nariz y la boca.

Fuente del conjunto de datos

Enlace: https://github.com/NVlabs/ffhq-dataset

Organización de producción: Tero Karras, Samuli Laine, Miika Aittala, Janne Hellsten, Jaakko Lehtinen, Timo Aila, etc. Investigadores de NVIDIA

原始文章: Karras, T., Laine, S., Aittala, M., Hellsten, J., Lehtinen, J. y Aila, T. (2019). Una arquitectura generadora basada en estilos para redes antagónicas generativas. En Actas de la Conferencia IEEE sobre visión artificial y reconocimiento de patrones (págs. 4401-4410).

ejemplo de muestra

conjunto de datos de escena

1.MS COCO ( Objetos comunes en contexto )

Introducción del conjunto de datos:

El conjunto de datos MS COCO es un conjunto de datos de imágenes grandes que se utiliza para la detección de objetos, la segmentación semántica y otras tareas de visión por computadora. Este conjunto de datos contiene más de 330 000 imágenes que contienen más de 250 millones de instancias de objetos.

Las principales características del conjunto de datos MS COCO son:

1) La cantidad de datos es grande, incluidas 80 categorías de objetos diferentes.

2) Anotaciones de alta calidad, cada imagen tiene varios cuadros de anotación, incluida la categoría del objeto y la información de ubicación.

Para los algoritmos de pintura de imágenes, el conjunto de datos MS COCO se puede utilizar para la fusión de información semántica, así como para tareas como la generación y restauración de objetos. Ayuda al modelo a aprender a reconocer varios objetos y poder arreglarlos mejor. Esto es muy útil para los algoritmos de pintura de imágenes porque permite que el modelo reconozca y repare mejor los objetos en la imagen.

Fuente del conjunto de datos

链接:COCO - Objetos comunes en contexto

Institución productora: Producida conjuntamente por Microsoft Research Asia, la Universidad de Stanford, la Universidad Carnegie Mellon y otras instituciones

Referencias: Lin , T.-Y. , Maire , M. , Belongie , S. , Hays , J. , Perona , P. , Ramanan , D. , … & Zitnick , CL (junio de 2014). Coco de Microsoft: objetos comunes en contexto. En European conference on computer vision (pp. 740-755). Springer, Cham

Ejemplo de muestra :

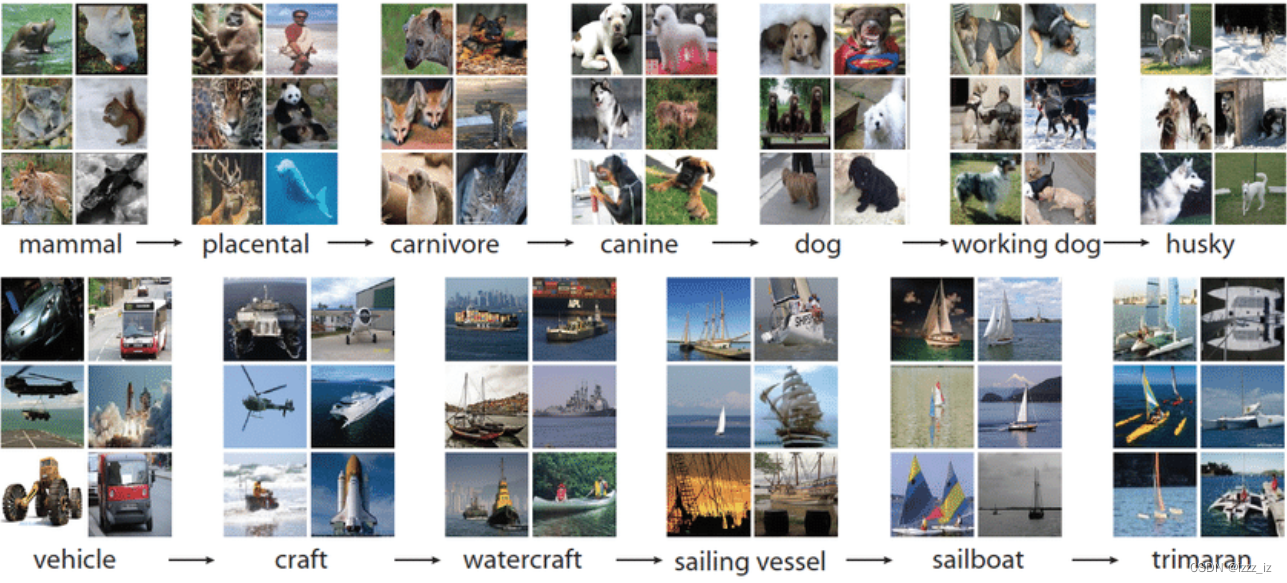

2. Red de imágenes

Introducción del conjunto de datos:

El conjunto de datos de ImageNet es un conjunto de datos de imágenes a gran escala muy popular que se utiliza principalmente para tareas de visión artificial, como la clasificación de imágenes, la detección de objetos y la segmentación de instancias. Este conjunto de datos contiene más de 140 000 imágenes de diferentes categorías, divididas en 1000 categorías en total.

Las características principales del conjunto de datos de ImageNet son:

1) La cantidad de datos es grande, incluidas 1000 categorías de objetos diferentes.

2) Anotación de alta calidad, cada imagen tiene varios cuadros de anotación, incluidas categorías de objetos.

3) La competencia se llevará a cabo todos los años y este conjunto de datos se utilizará en la competencia, lo que puede ayudar a los investigadores a evaluar y comparar el rendimiento de diferentes algoritmos.

Para los algoritmos de pintura de imágenes, el conjunto de datos de ImageNet se puede utilizar para la fusión de información semántica, así como para tareas como la generación y reparación de objetos. Puede ayudar al modelo a aprender a reconocer varios objetos y repararlos mejor, haciendo que los resultados de los algoritmos de restauración de imágenes sean más realistas. Además, también se puede utilizar para evaluar algoritmos de restauración de imágenes, evaluar el rendimiento de los algoritmos de restauración comparando imágenes antes y después de la restauración y comparar los pros y los contras de diferentes algoritmos.

Fuente del conjunto de datos:

Enlace : ImageNet

Instituciones de producción: Universidad de Stanford, Caltech, Microsoft Research Asia, Universidad de Washington y otras

原始文章: Deng, J., Dong, W., Socher, R., Li, L.-J., Li, K. y Fei-Fei, L. (junio de 2009). Imagenet: Una base de datos de imágenes jerárquicas a gran escala. En la conferencia IEEE de 2009 sobre visión artificial y reconocimiento de patrones (págs. 248-255). IEEE.

Ejemplo de muestra:

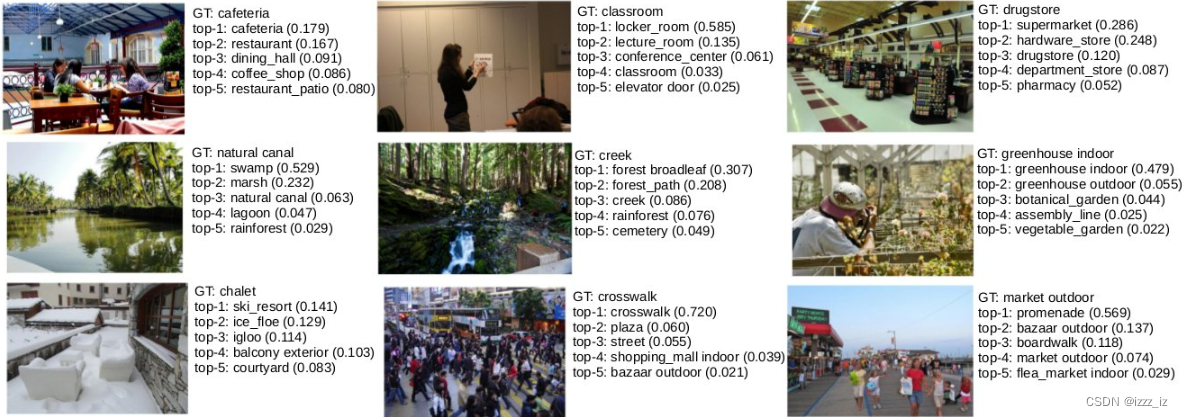

3.Lugares2

Introducción del conjunto de datos:

El conjunto de datos de Places2 es un conjunto de datos de imágenes de escenas a gran escala, que contiene un total de 100 000 imágenes de escenas de alta calidad.

Las características principales del conjunto de datos de Places2 son:

1) La cantidad de datos es grande, incluidas 405 categorías de escenas diferentes.

2) Imágenes de alta calidad, cada imagen es claramente visible.

3) Diversidad, las escenas en el conjunto de datos incluyen ciudades, bosques, playas, interiores, etc.

Fuente del conjunto de datos

链接:Places2: una base de datos a gran escala para la comprensión de escenas

Producido por: Universidad de Stanford y Microsoft Research

原始文章: B. Zhou, H. Zhao, X. Puig, S. Fidler, A. Barriuso y A. Torralba. "Lugares: una base de datos de 10 millones de imágenes para el reconocimiento de escenas" IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017

ejemplo de muestra

conjunto de datos de vista de calle

1.Paris StreetView

Introducción del conjunto de datos:

El conjunto de datos de Street View de París es un conjunto de datos de imágenes de Street View a gran escala que contiene imágenes de Street View de París, Francia. Se han recopilado un total de más de 1 millón de imágenes de Street View en alta resolución, incluidos varios edificios, calles, paisajes, etc. de la ciudad.

El conjunto de datos de Paris StreetView es un gran conjunto de datos de imágenes de Street View que se puede usar para entrenar y evaluar modelos de restauración de imágenes en la investigación de algoritmos de restauración de imágenes. Debido a que este conjunto de datos contiene una gran cantidad de imágenes de Street View de alta resolución, que pueden contener daños en la imagen, desenfoque de movimiento, ruido y otros problemas, por lo tanto, este conjunto de datos se puede usar para entrenar imágenes en modelos de pintura para adaptarse mejor a aplicaciones prácticas Imagen problema en .

Fuente del conjunto de datos

Enlace: http://opendata.paris.fr/explore/dataset/photos-de-rue-a-paris/

Productor: Ciudad de París

Artículo original: (no del artículo, es un conjunto de datos público)

ejemplo de muestra

2.Paisajes urbanos

Introducción del conjunto de datos:

El conjunto de datos Cityscapes es un conjunto de datos de imágenes urbanas de street view de alta calidad, que contiene una gran cantidad de imágenes de street view de alta resolución de las principales ciudades europeas (como París, Londres, Berlín, etc.). Este conjunto de datos también incluye información de anotación correspondiente a estas imágenes, como carreteras, edificios, árboles, etc.

El conjunto de datos de Cityscapes es un gran conjunto de datos de imágenes urbanas de Street View que se pueden usar para entrenar y evaluar modelos de pintura de imágenes. Porque este conjunto de datos contiene una gran cantidad de imágenes de Street View de alta resolución, que pueden contener corrupción de imágenes, desenfoque de movimiento, ruido y otros problemas. Por lo tanto, este conjunto de datos se puede utilizar para entrenar modelos de pintura de imágenes para adaptarse mejor a los problemas de imagen en aplicaciones prácticas.

Además, el conjunto de datos de Cityscapes también se puede utilizar para otras tareas, como la clasificación de imágenes, la detección de objetos, la segmentación semántica, etc. Estas tareas pueden ayudar a los algoritmos de pintura de imágenes a comprender mejor la estructura y la semántica de las imágenes y mejorar el rendimiento de los modelos de pintura de imágenes. También se puede utilizar en la investigación de la conducción autónoma, la planificación urbana y otros campos para ayudar a que los algoritmos de restauración de imágenes se adapten mejor a los escenarios reales.

Fuente del conjunto de datos

链接:Conjunto de datos de paisajes urbanos: comprensión semántica de las escenas de calles urbanas

Organización de producción: Daimler AG, Ford Motor Company, Audi AG, NVIDIA Corporation y la Universidad Técnica de Munich.

原始文章: Cordts, M., Omran, M., Ramos, S., Rehfeld, T., Enzweiler, M., Benenson, R., Franke, U., Roth, S. y Schiele, B. (2016 ). El conjunto de datos de paisajes urbanos para la comprensión semántica de la escena urbana. En Actas de la Conferencia IEEE sobre visión por computadora y reconocimiento de patrones (CVPR)

ejemplo de muestra

conjunto de datos de textura

DTD ( Conjunto de datos de texturas descriptibles )

Introducción del conjunto de datos:

El conjunto de datos DTD es un conjunto de datos a gran escala para la investigación de visión artificial y procesamiento de imágenes. Contiene más de 56.000 imágenes que cubren más de 47 tipos de texturas diferentes. Cada imagen tiene una descripción de texto correspondiente, que se utiliza para describir las características de textura de la imagen. El conjunto de datos DTD se utiliza para entrenar y evaluar la clasificación de imágenes y los algoritmos de análisis de texturas.

Las imágenes y las descripciones de texto correspondientes en el conjunto de datos DTD se utilizan para entrenar algoritmos de pintura de imágenes. Durante el entrenamiento, el algoritmo aprende a pintar texturas en imágenes basándose en descripciones de texto. Por ejemplo, un algoritmo podría aprender a reparar la textura de una piedra en una imagen corrupta basándose en la descripción textual "textura de piedra". Una vez entrenado, el algoritmo puede identificar y reparar diferentes tipos de texturas en imágenes desconocidas.

Cabe señalar que el conjunto de datos DTD se usa para algoritmos de clasificación y análisis de texturas, no para algoritmos de reparación de imágenes. La imagen en sí misma en DTD no se ha dañado. Cuando se entrenan algoritmos de reparación de imágenes, se requiere procesamiento adicional para dañar la imagen Reentrenar.

Fuente del conjunto de datos

Enlace : http://www.robots.ox.ac.uk/~vgg/data/dtd/.

Productor: El Equipo de Investigación de Visión por Computador de la Universidad de Oxford, Reino Unido

原始文章: "El conjunto de datos de texturas descriptibles (DTD)"E. Cimpoi, M. Maji, S. Mohamed, and I. Kokkinos. Actas de la Conferencia IEEE sobre visión artificial y reconocimiento de patrones (CVPR), 2016.

ejemplo de muestra

conjunto de datos de construcción

Fachada

Introducción del conjunto de datos:

El conjunto de datos Façade es un conjunto de datos muy popular para la visión por computadora y la investigación de aprendizaje profundo. Contiene una gran cantidad de imágenes de fachadas de edificios con diferentes ángulos, iluminación y oclusiones. Las dimensiones de estas imágenes son 1024x1024 píxeles, y cada imagen tiene una imagen de etiqueta correspondiente, que contiene la etiqueta de la geometría y el tipo de material de la fachada del edificio. El conjunto de datos Façade se usa ampliamente para entrenar modelos de aprendizaje profundo para predecir la geometría y los tipos de materiales de las fachadas de los edificios.

Este conjunto de datos tiene una variedad de etiquetas, que incluyen:

1) La geometría de las fachadas de los edificios, como ventanas, puertas, paredes, etc.

2) El tipo de material de la fachada del edificio, como vidrio, placa de aluminio, piedra, etc.

3) El estado de iluminación de la fachada del edificio, como sombra, luz solar, etc.

Los algoritmos de pintura de imágenes se utilizan a menudo para restaurar imágenes corruptas u ocluidas, como rellenar partes que faltan o eliminar ruido. Las imágenes en el conjunto de datos Fachada tienen oclusión y ruido naturales, por lo que es un buen conjunto de datos para evaluar el rendimiento de los algoritmos de imagen en pintura.

Por ejemplo, los investigadores pueden usar el conjunto de datos Façade para entrenar modelos de aprendizaje profundo para predecir la geometría y el tipo de material de las fachadas de los edificios, y luego usar esas predicciones para reparar partes ocluidas o faltantes en las imágenes. Además, este conjunto de datos se puede utilizar para evaluar el rendimiento de diferentes algoritmos de pintura de imágenes y seleccionar el mejor algoritmo.

Fuente del conjunto de datos:

Enlace:

Proyecto en GitHub: https://github.com/shannontian/facade-parsing

Sitio web oficial: Base de datos de fachadas de CMP

Plataforma para compartir conjuntos de datos: https://www.vision.ee.ethz.ch/datasets_extra/facade/

Productor : Universidad Técnica Checa en Praga (Universidad Técnica Checa)

原始文章: Un conjunto de datos para el análisis de fachadas de edificios y sus aplicaciones en el diseño automático de fachadas" por TY Lin, A. Maier, A. Prusa y J. Kosecka en Actas de la Conferencia IEEE sobre visión artificial y reconocimiento de patrones (CVPR), 2016

ejemplo de muestra