はじめに: Transformer は、自然言語処理タスクで大きな成功を収めた革新的なニューラル ネットワーク モデルです。この記事では、Transformer の原理、構造、主要コンポーネントを紹介し、機械翻訳、テキスト生成、言語理解などのタスクに対する Transformer の重要な影響について説明します。

文章:

はじめに 自然言語処理 (NLP) は、人工知能の分野における重要な研究方向であり、機械翻訳、テキスト生成、言語理解などのタスクは、NLP において常に注目されている問題です。従来の NLP モデルは、これらのタスクを処理する際に、長距離の依存関係、コンテキストの理解、翻訳の精度などの課題に直面することがよくあります。しかし、Transformer モデルの登場により、これらの問題は根本的に改善されました。

Transformer モデルの原理 Transformer モデルは、2017 年に Vaswani らによって初めて提案され、入力シーケンス内の異なる位置間の依存関係を捉えるセルフ アテンション メカニズム (セルフ アテンション) を導入しました。従来のリカレント ニューラル ネットワーク (RNN) や畳み込みニューラル ネットワーク (CNN) と比較して、Transformer モデルは長距離の依存関係をより適切に処理できるため、NLP タスクのパフォーマンスが大幅に向上します。+v❤Public H: Ai Technology Planet 返信 (123) トランスフォーマー + 500G 人工知能学習情報に関連する情報を受信する必要があります

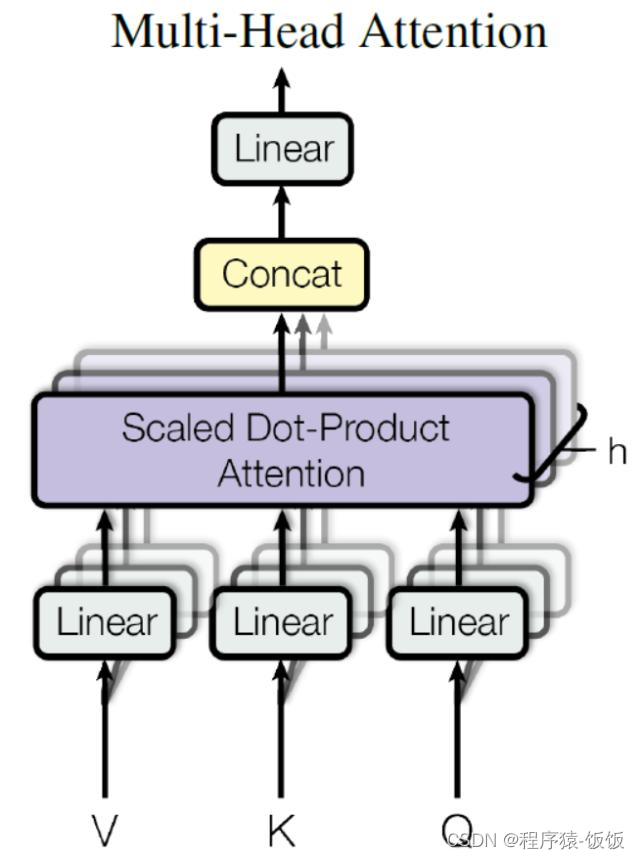

Transformer モデルの構造 Transformer モデルは、入力シーケンスを中間表現に変換するために使用されるエンコーダーと、中間表現に基づいて出力シーケンスを生成するために使用されるデコーダーから構成されます。各エンコーダとデコーダは、多層に積み重ねられたセルフアテンション層とフィードフォワード ニューラル ネットワーク層で構成されます。セルフ アテンション レイヤーは、各位置と他の位置の相関関係を計算することでコンテキスト情報を取得し、フィードフォワード ニューラル ネットワーク レイヤーは特徴をさらに処理するために使用されます。

Transformer モデルの主要コンポーネント セルフ アテンション層とフィードフォワード ニューラル ネットワーク層に加えて、Transformer モデルには、位置エンコーディング、残差接続、層正規化などの主要コンポーネントも含まれています。位置エンコーディングは、入力シーケンス内の各位置に特定のエンコーディング ベクトルを割り当て、位置情報を保存するために使用されます。残留接続により、モデルは層の出力に入力を追加することで勾配をより適切に伝達し、情報の整合性を維持できるようになります。レイヤー正規化は各レイヤーの出力を正規化するために使用され、これによりトレーニングが高速化され、モデルの安定性が向上します。

Transformer モデルの応用 Transformer モデルは、その優れた性能と幅広い応用分野により、自然言語となっています。

タスクの処理に推奨されるモデルの 1 つ。機械翻訳、テキスト生成、言語理解などのタスクで目覚ましい成果を上げています。たとえば、機械翻訳タスクでは、Transformer モデルは入力シーケンスをエンコードし、出力シーケンスをデコードすることでコンテキスト情報を効果的に取得し、高品質の翻訳結果を実現します。テキスト生成タスクでは、Transformer モデルは滑らかで正確なテキストを生成できるため、言語モデルとテキスト生成システムのパフォーマンスが向上します。言語理解タスクでは、Transformer モデルはテキストを意味表現に変換できるため、意味分析や意味検索などの後続のタスクの基礎が提供されます。

Transformer モデルは、自然言語処理の分野での応用に加えて、コンピューター ビジョンや音声処理などの分野でも広く使用されています。コンピューター ビジョン タスクでは、Transformer モデルは画像分類、オブジェクト検出、画像生成などのタスクを処理できます。セルフアテンション機構を導入することで、画像内のさまざまな位置の特徴関係を捉えることができるため、画像処理の精度と効果が向上します。音声処理タスクでは、音声シーケンスをエンコードおよびデコードして、より正確で自然な音声処理結果を実現することにより、音声認識や音声合成などのタスクに Transformer モデルを使用できます。

概要 Transformer モデルは、革新的なニューラル ネットワーク モデルとして、自然言語処理、コンピューター ビジョン、音声処理の分野で重要な進歩を遂げました。自己注意メカニズムの導入と構造設計の最適化により、従来のモデルに存在する長距離依存性とコンテキスト理解の問題を効果的に解決します。Transformer モデルの応用の成功は、学術研究に新しいアイデアと手法を提供するだけでなく、業界での実用化にも大きな推進力をもたらします。継続的な研究開発により、Transformer モデルはより多くの分野でより良い結果を達成し、人工知能技術のさらなる開発を促進することが期待されています。

+v❤公開H:Ai Technology Planet返信(123)は、変圧器+ 500G人工知能学習教材に関する情報を受け取る必要があります