Elasticsearch安装使用IK分词器

solr和elasticsearch都是基于Lucene搜索引擎实现的全文检索工具,因为都是美国人开发的,所以分词习惯和中国的汉字分词差别很大,在国内是用不了其自带的分词器,这里我们推荐使用IK分词器,这个分词器是国人开发的,效果很好。

一、下载IK分词器

PS:IK分词器和ES服务器版本必须保持一致。

官网下载路径:https://github.com/medcl/elasticsearch-analysis-ik/releases

二、下载完成后进行解压

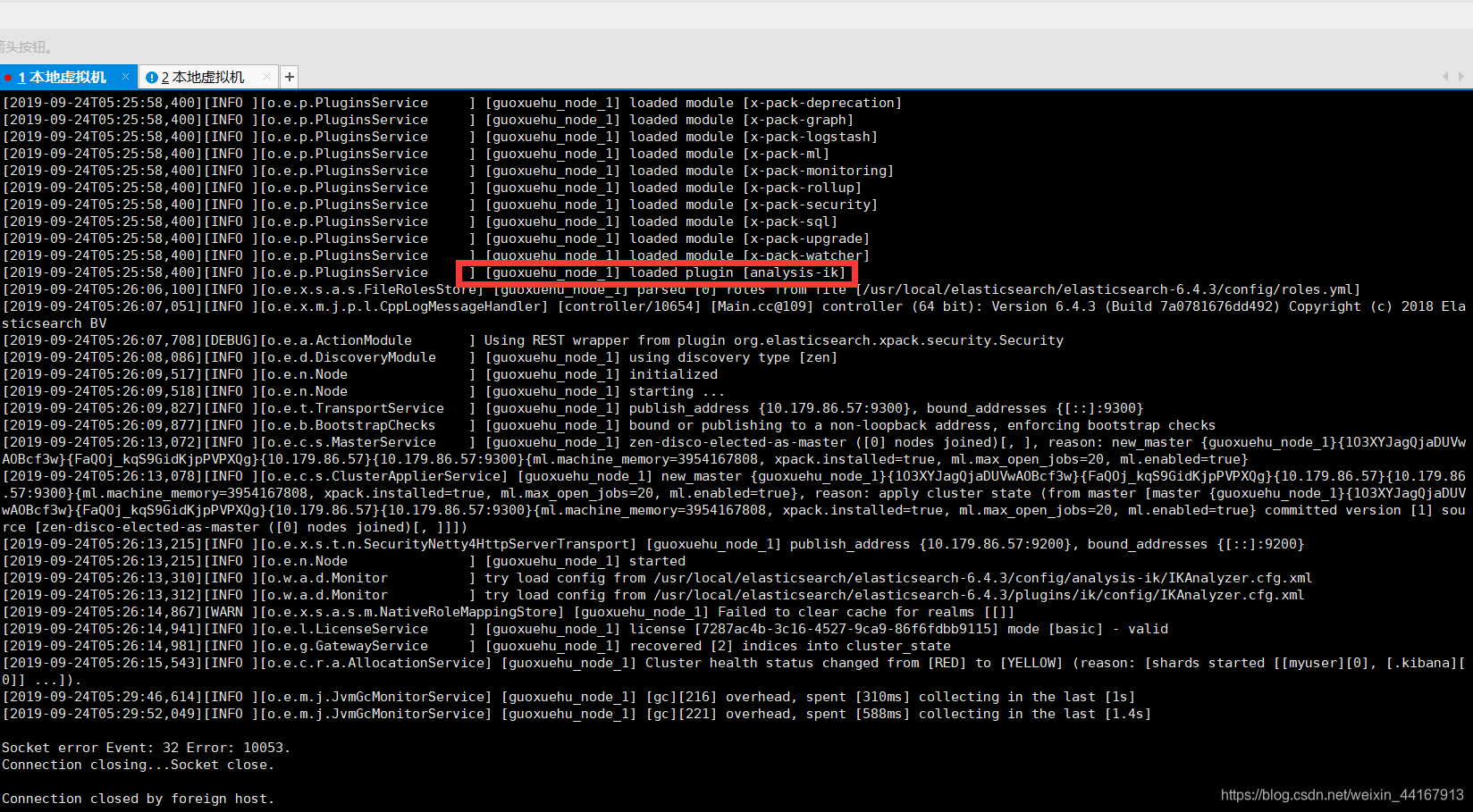

使用winSCP连接虚拟机或者服务器,在elasticsearch文件夹下的plugins文件下新建文件夹“ik”,并把解压的ik分词器文件复制上去,然后重启elasticsearch服务器,出现如下图即加载ik分词器词库完成!

PS:IK分词器效果很好,我们也可以自定义词语,本文不提供了,可以百度教程的。

PS:IK分词器效果很好,我们也可以自定义词语,本文不提供了,可以百度教程的。

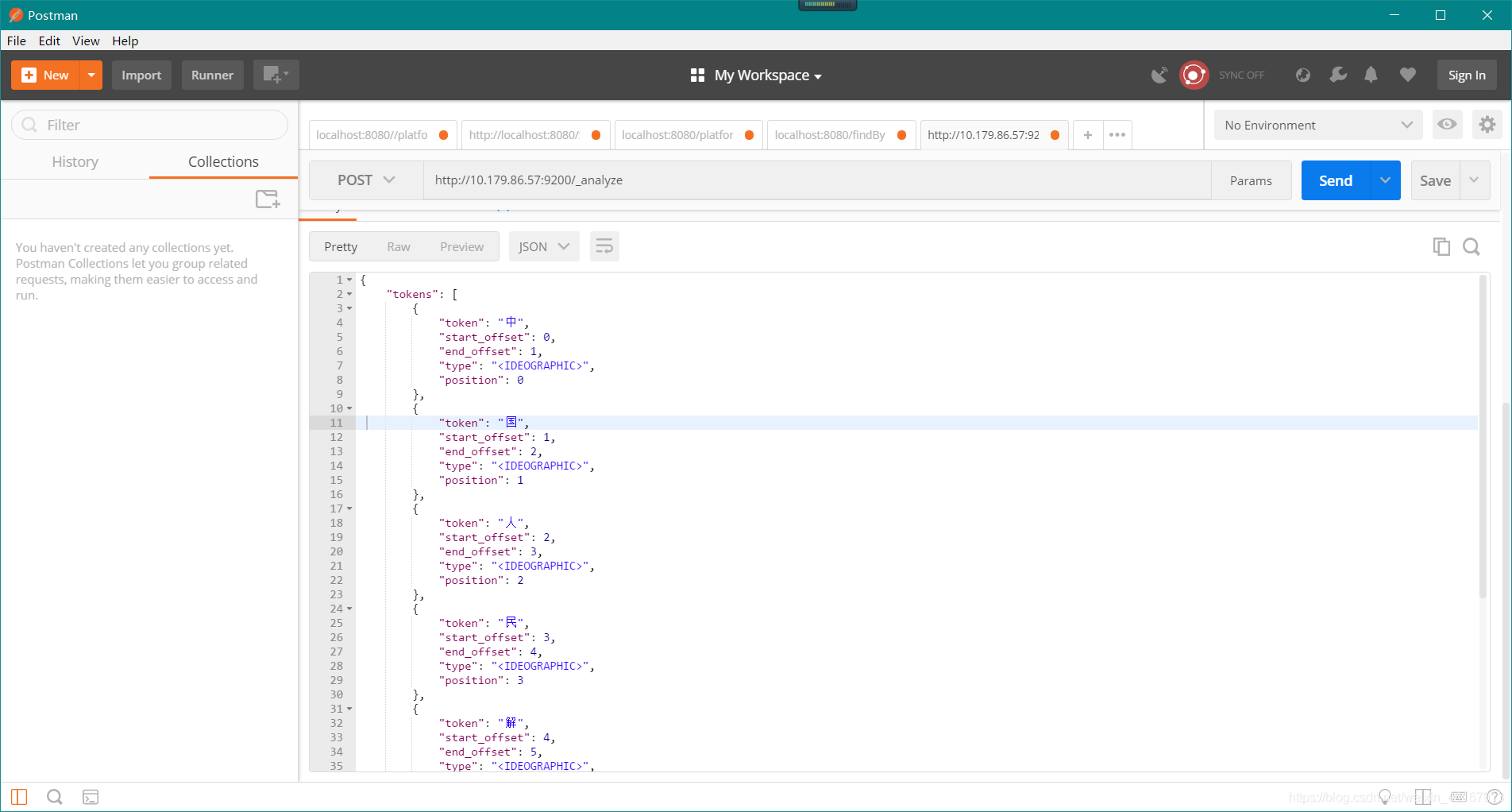

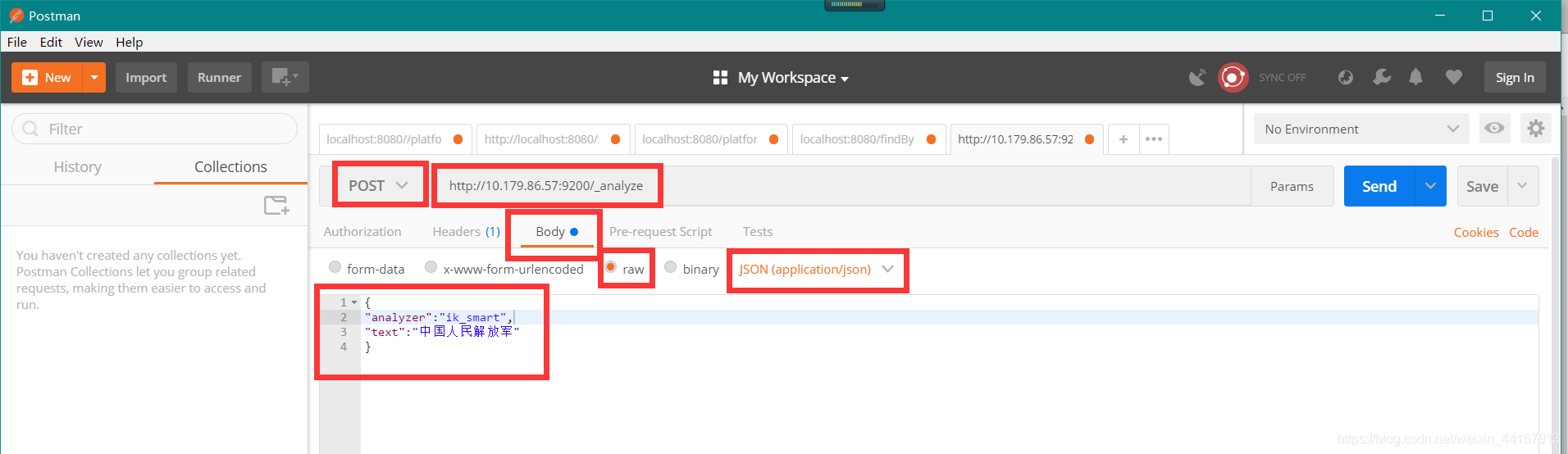

三、使用postman测试分词效果

原本的效果:

使用ik分词器的效果:

使用ik分词器的效果:

这里要注意啦:“analyzer”:"ik_smart"这个就是表示使用IK分词器!

这里要注意啦:“analyzer”:"ik_smart"这个就是表示使用IK分词器!

{

"analyzer":"ik_smart",

"text":"中国人民解放军"

}