理论:

GminDmaxV(D,G)=Ex∼pdata(x)[logD(x)]+Ez∼p(z)[log(1−D(G(z)))]

其中

V表示Value,

x表示真实数据,

z表示噪声,

G(z)表示生成器生成的样本,

E表示期望。

D想增加这个值Value(通过对

D(x)输出1,

D(G(z))输出0,即正确分类,使V接近0),

G想减小这个值(通过让

D把

G(z)分为1,使V负无穷)。当二者达到纳什平衡时,它们各自达到最优。

注:

D(x)∈(0,1),

V(D,G)∈(−∞,0]。

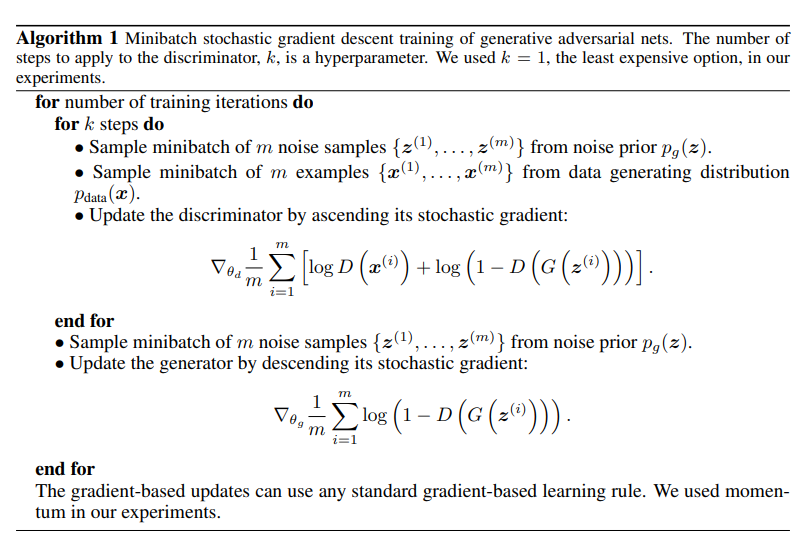

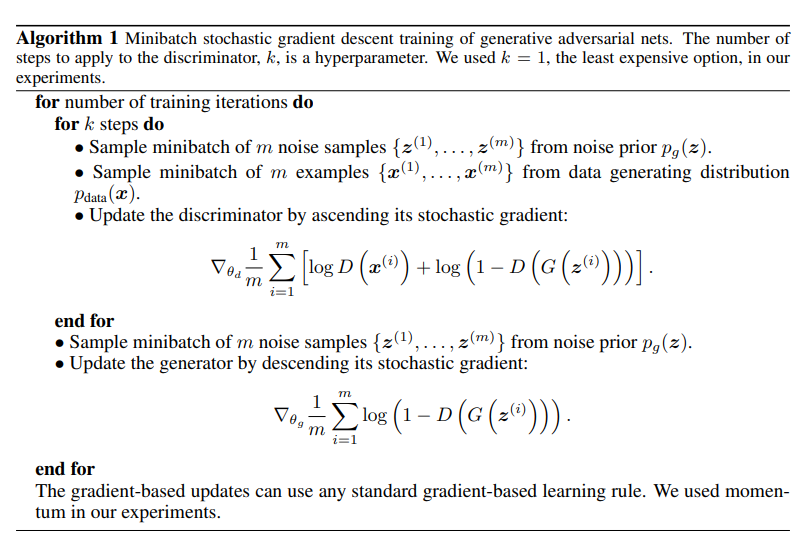

实际:

根据前面价值函数 V(G,D) 的定义,我们需要求两个数学期望,即 E[log(D(x))] 和 E[log(1-D(G(z)))],其中 x 服从真实数据分布,z 服从初始化分布。但在实践中,我们是没有办法利用积分求这两个数学期望的,所以一般我们能从无穷的真实数据和无穷的生成器中做采样以逼近真实的数学期望,即:

GminDmaxV~(D,G)=m1i=1∑mlogD(xi)+m1i=1∑mlog(1−D(G(zi)))

训练时,分别固定

G,最大化

L(D)和固定

D,最小化

L(G)。

伪代码:

第一步我们训练D,D是希望V(G, D)越大越好,所以是加上梯度(ascending)。第二步训练G时,V(G, D)越小越好,所以是减去梯度(descending)。整个训练过程交替进行。

内循环

D的迭代次数

k也可以多于

G。

参考:机器之心