YOLO3搭建自己的训练集数据

由于自己部门需求及学习需求,需要自己制造训练集,并训练好自己的权重,用于检测目标与分割。开始自己探索制造训练集与训练网络的坑坑洼洼的道路,鉴于网上没有较好较为详细的教程,我想要把自己觉得的顺序步骤写出来,给大家减少遇到的坑。

环境配置:Ubuntu16.04+cuda9.0(NVIDA381以上显卡驱动)+cudnn v7+YOLOv3

(其实环境也不用相同,毕竟制造制造数据集的方法是相同的)

我把制造自己的数据集分为以下几个步骤:

1.读懂darknet/cfg/yolov3.cfg文件的一些参数

了见参数是我们必须做的第一步,有助于你熟悉这个神经网络,深度学习的一些概念

特别是以下两个参数,必须重点理解

batch=64

subdivisions=16

cfg文件说明

[net] ★ [xxx]开始的行表示网络的一层,其后的内容为该层的参数配置,[net]为特殊的层,配置整个网络

# Testing ★ #号开头的行为注释行,在解析cfg的文件时会忽略该行

# batch=1

# subdivisions=1

# Training

batch=64 ★ 注意!!!这儿batch与机器学习中的batch有少许差别,仅表示网络积累多少个样本后进行一次BP

subdivisions=16 ★ 这个参数表示将一个batch的图片分sub次完成网络的前向传播

★★ 敲黑板:在Darknet中,batch和sub是结合使用的,例如这儿的batch=64,sub=16表示训练的过

程中将一次性加载64张图片进内存,然后分16次完成前向传播,意思是每次4张,前向传播的循环过程中

累加loss求平均,待64张图片都完成前向传播后,再一次性后传更新参数

★★★ 调参经验:sub一般设置16,不能太大或太小,且为8的倍数,其实也没啥硬性规定,看着舒服就好

batch的值可以根据显存占用情况动态调整,一次性加减sub大小即可,通常情况下batch越大越好,还需

注意一点,在测试的时候batch和sub都设置为1,避免发生神秘错误!

width=608 ★ 网络输入的宽width

height=608 ★ 网络输入的高height

channels=3 ★ 网络输入的通道数channels

★★★ width和height一定要为32的倍数,否则不能加载网络

★ 提示:width也可以设置为不等于height,通常情况下,width和height的值越大,对于小目标的识别

效果越好,但受到了显存的限制,读者可以自行尝试不同组合

momentum=0.9 ★ 动量 DeepLearning1中最优化方法中的动量参数,这个值影响着梯度下降到最优值得速度

decay=0.0005 ★ 权重衰减正则项,防止过拟合

angle=0 ★ 数据增强参数,通过旋转角度来生成更多训练样本

saturation = 1.5 ★ 数据增强参数,通过调整饱和度来生成更多训练样本

exposure = 1.5 ★ 数据增强参数,通过调整曝光量来生成更多训练样本

hue=.1 ★ 数据增强参数,通过调整色调来生成更多训练样本

learning_rate=0.001 ★ 学习率决定着权值更新的速度,设置得太大会使结果超过最优值,太小会使下降速度过慢。

如果仅靠人为干预调整参数,需要不断修改学习率。刚开始训练时可以将学习率设置的高一点,

而一定轮数之后,将其减小在训练过程中,一般根据训练轮数设置动态变化的学习率。

刚开始训练时:学习率以 0.01 ~ 0.001 为宜。一定轮数过后:逐渐减缓。

接近训练结束:学习速率的衰减应该在100倍以上。

学习率的调整参考https://blog.csdn.net/qq_33485434/article/details/80452941

★★★ 学习率调整一定不要太死,实际训练过程中根据loss的变化和其他指标动态调整,手动ctrl+c结

束此次训练后,修改学习率,再加载刚才保存的模型继续训练即可完成手动调参,调整的依据是根据训练

日志来,如果loss波动太大,说明学习率过大,适当减小,变为1/5,1/10均可,如果loss几乎不变,

可能网络已经收敛或者陷入了局部极小,此时可以适当增大学习率,注意每次调整学习率后一定要训练久

一点,充分观察,调参是个细活,慢慢琢磨

★★ 一点小说明:实际学习率与GPU的个数有关,例如你的学习率设置为0.001,如果你有4块GPU,那

真实学习率为0.001/4

burn_in=1000 ★ 在迭代次数小于burn_in时,其学习率的更新有一种方式,大于burn_in时,才采用policy的更新方式

max_batches = 500200 ★ 训练次数达到max_batches后停止学习,一次为跑完一个batch

policy=steps ★ 学习率调整的策略:constant, steps, exp, poly, step, sig, RANDOM,constant等方式

参考https://nanfei.ink/2018/01/23/YOLOv2%E8%B0%83%E5%8F%82%E6%80%BB%E7%BB%93/#more

steps=400000,450000

scales=.1,.1 ★ steps和scale是设置学习率的变化,比如迭代到400000次时,学习率衰减十倍,45000次迭代时,学

习率又会在前一个学习率的基础上衰减十倍

[convolutional] ★ 一层卷积层的配置说明

batch_normalize=1 ★ 是否进行BN处理,什么是BN此处不赘述,1为是,0为不是

filters=32 ★ 卷积核个数,也是输出通道数

size=3 ★ 卷积核尺寸

stride=1 ★ 卷积步长

pad=1 ★ 卷积时是否进行0 padding,padding的个数与卷积核尺寸有关,为size/2向下取整,如3/2=1

activation=leaky ★ 网络层激活函数

★★ 卷积核尺寸3*3配合padding且步长为1时,不改变feature map的大小

# Downsample

[convolutional] ★ 下采样层的配置说明

batch_normalize=1

filters=64

size=3

stride=2

pad=1

activation=leaky ★★ 卷积核尺寸为3*3,配合padding且步长为2时,feature map变为原来的一半大小

[shortcut] ★ shotcut层配置说明

from=-3 ★ 与前面的多少次进行融合,-3表示前面第三层

activation=linear ★ 层次激活函数

......

......

[convolutional] ★ YOLO层前面一层卷积层配置说明

size=1

stride=1

pad=1

filters=255 ★ filters=num(预测框个数)*(classes+5),5的意义是4个坐标加一个置信率,论文中的tx,ty,tw,th,

c,classes为类别数,COCO为80,num表示YOLO中每个cell预测的框的个数,YOLOV3中为3

★★★ 自己使用时,此处的值一定要根据自己的数据集进行更改,例如你识别4个类,则:

filters=3*(4+5)=27,三个fileters都需要修改,切记

activation=linear

[yolo] ★ YOLO层配置说明

mask = 0,1,2 ★ 使用anchor的索引,0,1,2表示使用下面定义的anchors中的前三个anchor

anchors = 10,13, 16,30, 33,23, 30,61, 62,45, 59,119, 116,90, 156,198, 373,326

classes=80 ★ 类别数目

num=9 ★ 每个grid cell总共预测几个box,和anchors的数量一致。当想要使用更多anchors时需要调大num

jitter=.3 ★ 数据增强手段,此处jitter为随机调整宽高比的范围,该参数不好理解,在我的源代码注释中有详细说明

ignore_thresh = .7

truth_thresh = 1 ★ 参与计算的IOU阈值大小.当预测的检测框与ground true的IOU大于ignore_thresh的时候,参与

loss的计算,否则,检测框的不参与损失计算。

★ 理解:目的是控制参与loss计算的检测框的规模,当ignore_thresh过于大,接近于1的时候,那么参与

检测框回归loss的个数就会比较少,同时也容易造成过拟合;而如果ignore_thresh设置的过于小,那么

参与计算的会数量规模就会很大。同时也容易在进行检测框回归的时候造成欠拟合。

★ 参数设置:一般选取0.5-0.7之间的一个值,之前的计算基础都是小尺度(13*13)用的是0.7,

(26*26)用的是0.5。这次先将0.5更改为0.7。参考:https://www.e-learn.cn/content/qita/804953

random=1 ★ 为1打开随机多尺度训练,为0则关闭

★★ 提示:当打开随机多尺度训练时,前面设置的网络输入尺寸width和height其实就不起作用了,width

会在320到608之间随机取值,且width=height,没10轮随机改变一次,一般建议可以根据自己需要修改

随机尺度训练的范围,这样可以增大batch

建议用本子记录一遍,加深理解。我就是这样做的(抱歉写字比较潦草)

参考网址https://www.cnblogs.com/hls91/p/10911997.html

2.理解以后,就开始搭建数据集,细分以下几步.

2.1准备自己想要训练的目标图片(我这里只准备了78张),放在一个文件夹(这里假设为picture)

2.2建立一个rename.py文件,在终端运行:python rename.py**

将这些图片序列命名,如图所示

用到的rename.py:

#coding=utf-8

import os #打开文件时需要

from PIL import Image

import re

class BatchRename():

def __init__(self):

#我的图片文件夹路径,不同的人不同路径

self.path = '//home//user//darknet//scripts//VOCdevkit//VOC2007//JPEGImages'

def rename(self):

filelist = os.listdir(self.path)

total_num = len(filelist)

i = 000000 #图片编号从多少开始,不要跟VOC原本的编号重复了

n = 6

for item in filelist:

if item.endswith('.jpg'):

n = 6 - len(str(i))

src = os.path.join(os.path.abspath(self.path), item)

dst = os.path.join(os.path.abspath(self.path), str(0)*n + str(i) + '.jpg')

try:

os.rename(src, dst)

print ('converting %s to %s ...' % (src, dst))

i = i + 1

except:

continue

print ('total %d to rename & converted %d jpgs' % (total_num, i))

if __name__ == '__main__':

demo = BatchRename()

demo.rename()

2.3同上面的操作类似,建立一个resize.py文件,在终端输入:python resize.py将图片统一大小,非常重要!!我第一次就是没有做到统一大小,导致后面出问题,原因我没搞明白!知道的朋友麻烦留言告知。(当然如果你的图片全是大小一致的就跳过这一步)

resize.py文件代码:

#coding=utf-8

import os #打开文件时需要

from PIL import Image#这些模块得提前装好

import re

Start_path='//home//user//darknet//scripts//VOCdevkit//VOC2007//JPEGImages//' #原来你的图片目录

N_path='//home//user//darknet//scripts//VOCdevkit//VOC2007//JPEGImages_1//'#resize your picture 后保存的位置

list=os.listdir(Start_path)

#print list

count=0

for pic in list:

path=Start_path+pic

print (path)

im=Image.open(path)

w,h=im.size

#print w,h

if w>h:

print (pic)

print ("图片名称为"+pic+"图片被修改")

h_new=(int)(700)

w_new=(int)(700)#我这里统一大小改为700×700,自己按照需求改

count=count+1

out = im.resize((w_new,h_new),Image.ANTIALIAS)

new_pic=re.sub(pic[:-4],pic[:-4],pic) #+'_new'

#print new_pic

new_path=N_path+new_pic #Start_path+new_pic

out.save(new_path)

if h>w:

print (pic)

print ("图片名称为"+pic+"图片被修改")

w_new=(int)(700)

h_new=(int)(700)#我这里统一大小改为700×700,自己按照需求改

count=count+1

out = im.resize((w_new,h_new),Image.ANTIALIAS)

new_pic=re.sub(pic[:-4],pic[:-4],pic) #+'_new'

#print new_pic

new_path=N_path+new_pic #Start_path+new_pic

out.save(new_path)

print ('END')

count=str(count)

print ("共有"+count+"张图片尺寸被修改")

此时,我们的图片大小已经统一了。

2.4必须必须检查图片的序列号是否连续!!!,可能运行过程中的图片会丢失,与我们建立的py文件中打开文件的方式有关,不连续自己手动改为连续。

不连续的例子:

00001.jpg

00002.jpg

00004.jpg

少了00003.jpg,要补上,因为等会在这个会影响给标注文件xml转化为yolov3的标签labels

2.5!!!给图片打标,生成xml文件(会在自己放图片的位置生成xml文件)

这里要安装一个软件:叫labelImages,使用非常简单

安装请按照这个网址https://blog.csdn.net/comway_Li/article/details/85046102

然后选择自己打标的图片的目录,进行图片打标

如图!!!注意选择的格式是voc

给图片打完标后,在picture的目录一个图片对应一个xml文件。

3.在darknet/scripts/目录下建立自己的数据集目录结构

3.1scripts下新建VOCdevkits目录

3.2VOCdevkits目录下建立JPEGImages,Annotations,ImageSets三个目录

3.3在ImageSets下建立Layout与Main两个目录

4.将刚才打标的图片放在建立的JPEGImages目录,对应的xml文件放在Annotations

5.运行test.py 转化标签信息,在Main目录生成三个文件

新建立代码文件叫test.py,

import os

import random

trainval_percent = 0.1

train_percent = 0.9

xmlfilepath = 'Annotations'

txtsavepath = 'ImageSets\Main'

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv)

train = random.sample(trainval, tr)

ftrainval = open('ImageSets/Main/trainval.txt', 'w')

ftest = open('ImageSets/Main/test.txt', 'w')

ftrain = open('ImageSets/Main/train.txt', 'w')

fval = open('ImageSets/Main/val.txt', 'w')

for i in list:

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftest.write(name)

else:

fval.write(name)

else:

ftrain.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

在终端运行python test.py

6.VOC数据转化为labels信息

YOLOV3的label,YOLOV3的label标注的一行五个数分别代表类别(从 0 开始编号), BoundingBox 中心 X 坐标,中心 Y 坐标,宽,高。这些坐标都是 0~1 的相对坐标。和我们刚才标注的label不同,因此我们需要下面的py文件帮我们转换label。

wget https://pjreddie.com/media/files/voc_label.py

这里我提供源码:

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

# 注释掉默认的

# sets=[('2012', 'train'), ('2012', 'val'), ('2007', 'train'), ('2007', 'val'), ('2007', 'test')]

# classes = ["aeroplane", "bicycle", "bird", "boat", "bottle", "bus", "car", "cat", "chair", "cow", "diningtable", "dog", "horse", "motorbike", "person", "pottedplant", "sheep", "sofa", "train", "tvmonitor"]

sets=[ ('2007', 'train'), ('2007', 'val'), ('2007', 'test')]

classes = [ "ganlanqiu"]

def convert(size, box):

dw = 1./size[0]

dh = 1./size[1]

x = (box[0] + box[1])/2.0

y = (box[2] + box[3])/2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x*dw

w = w*dw

y = y*dh

h = h*dh

return (x,y,w,h)

def convert_annotation(year, image_id):

in_file = open('VOCdevkit/VOC%s/Annotations/%s.xml'%(year, image_id)) #(如果使用的不是VOC格式的目录而是自设置数据集名字,则这里需要修改,跟我相同就参照我的目录,下面有)

out_file = open('VOCdevkit/VOC%s/labels/%s.txt'%(year, image_id), 'w') #(同上)

tree=ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text), float(xmlbox.find('ymax').text))

bb = convert((w,h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

for year, image_set in sets:

if not os.path.exists('VOCdevkit/VOC%s/labels/'%(year)):

os.makedirs('VOCdevkit/VOC%s/labels/'%(year))

image_ids = open('VOCdevkit/VOC%s/ImageSets/Main/%s.txt'%(year, image_set)).read().strip().split()

list_file = open('%s_%s.txt'%(year, image_set), 'w')

for image_id in image_ids:

list_file.write('%s/VOCdevkit/VOC%s/JPEGImages/%s.jpg\n'%(wd, year, image_id))

convert_annotation(year, image_id)

list_file.close()

注意,voc_label.py需要与VOCdevkits目录同级位置。

这里需要修改两个地方,sets和classes,参考我的橙色的部分:

修改完后,在终端打开scripts目录,运行

python voc_label.py

cat 2007_train.txt 2007_val.txt > train.txt

观察scripts目录下,是否生成了对应文件 2007_train.txt ;2007_val.txt ;2007_test.txt ;train.txt

再看VOC2007目录下是否多了labels目录,打开是否如下:

坚持至此,兄弟们,数据集完成!!!!

7.修改自己的cfg文件及data

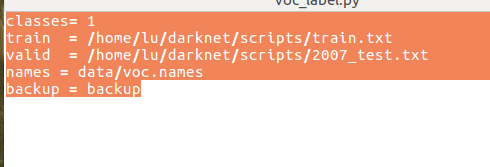

7.1cfg/voc.data文件修改

class是你自己想训练的类的数目,接下来的两个是训练测试目录,只需要修改为对应的目录

7.2修改data/voc.names中的类的名字(我只有一个类)

7.3修改cgf/yolov3-voc.cfg框架文件中的几个参数

此时,发现自己已经熟悉了这个东西,修改起来也不是那么难,参数理解也比较简单了

修改参数文件cfg/yolov3-voc.cfg

ctrl+f搜 yolo, 总共会搜出3个含有yolo的地方。

3个地方都要改,且每个地方都必须要改2处, filters:3*(5+len(classes));

其中:classes:我这里是一个类, len(classes)=1

filters = 18

classes = 1

可修改:random = 1:原来是1,显存小改为0。(是否要多尺度输出。我这里不用,因为样本不足时,这个参数会影响训练效果)

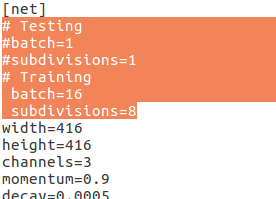

由于自己当初没有截图,参考别人的图

在文件开头,修改训练的batches,subdivisions,自己看情况,显卡不强的掂量以下哈哈

在文件开头,修改训练的batches,subdivisions,自己看情况,显卡不强的掂量以下哈哈

8.下载预训练的权重

恭喜,坚持到这里真不容易!!!过了这一步,就能训练自己的数据了!!

wget https://pjreddie.com/media/files/darknet53.conv.74

这个文件下载看网络!!!很慢!!!我用校园网才下了下来。

注意!!!!敲黑板!!!这个文件必须先在darknet目录下建立backup(保存训练权重的)文件夹,再把这个文件放到darknet目录下,与backup同级

9.成功!!!开始训练!!!!!!!

1:普通训练:

./darknet detector train cfg/voc.data cfg/yolov3-voc.cfg darknet53.conv.74

2:若想使用多个GPU训练

./darknet detector train cfg/voc.data cfg/yolov3.cfg darknet53.conv.74 -gpus 0,1,2,3

3:如终止训练,ctrl+z,权重会保存在backup文件夹下。如果要从检查点停止并重新启动训练

./darknet detector train cfg/voc.data cfg/yolov3.cfg backup/yolov3.backup

我训练10000次后测试图

可视化参数图片: