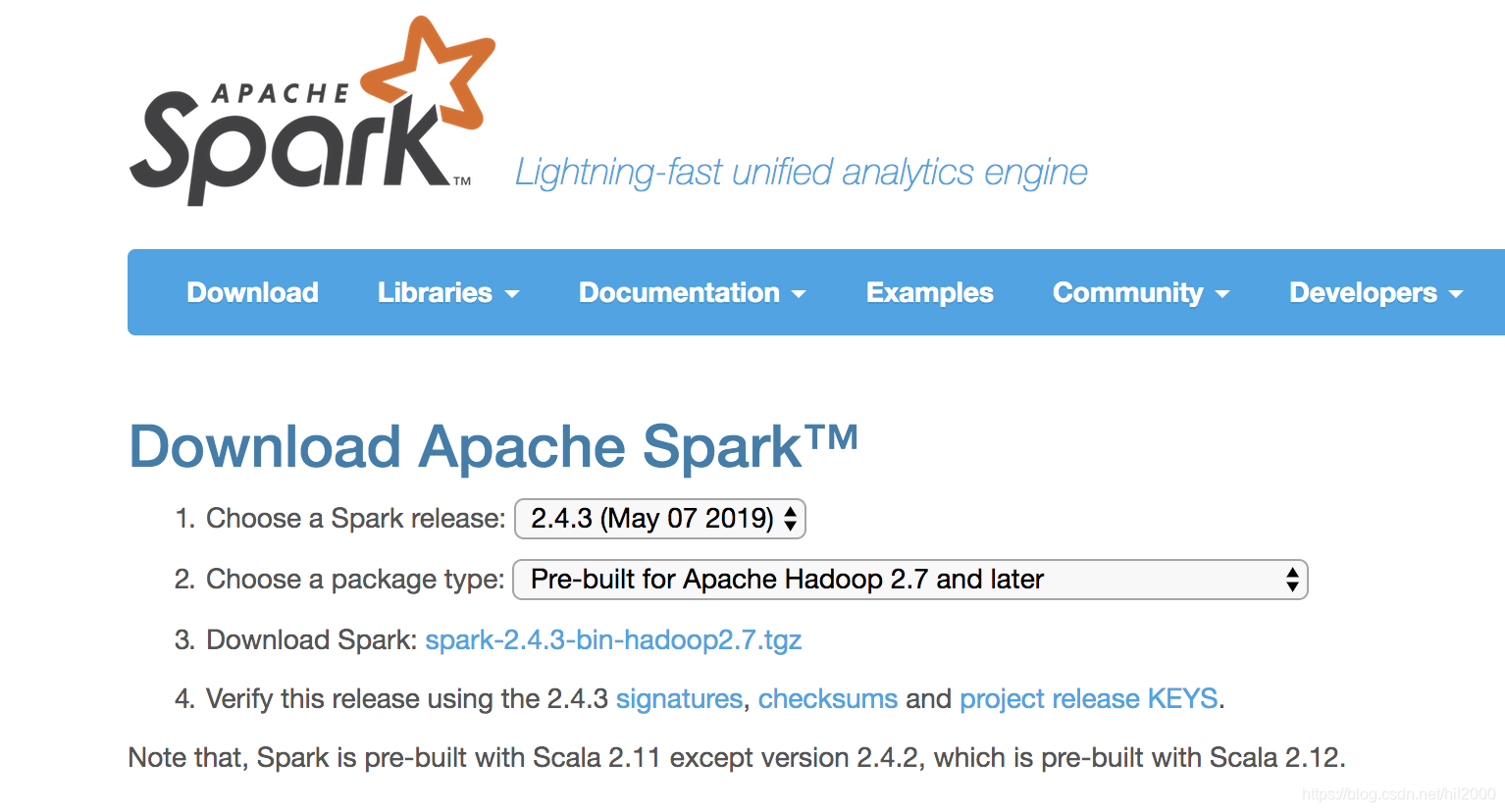

1.访问spark官网https://spark.apache.org/,然后单击download连接https://spark.apache.org/downloads.html

2.进入download界面后,选择类型为Pre-buil for Apache Hadoop2.7 and later,这样就不用事先安装Hadoop了

3.单击download spark后的连接,下载 spark-2.4.3-bin-hadoop2.7.tgz文件,大概有230M

4.打开命令行终端,将spark-2.4.3-bin-hadoop2.7.tgz文件移动到/usr/local下

sudo mv spark-2.4.3-bin-hadoop2.7.tgz /usr/local5.解压缩该文件

sudo tar -zvxf spark-2.4.3-bin-hadoop2.7.tgz6.配置环境变量

sudo nano ~/.bash_profile7.在配置文件里添加如下配置后保存退出

export SPARK_HOME=/usr/local/spark-2.4.3-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOME/bin

export PYSPARK_PYTHON=python38.配置文件生效

source ~/.bash_profile9.安装pyspark

pip3 install pyspark10.启动pyspark,进入交互式命令窗口

参考连接:

[1]https://medium.com/luckspark/installing-spark-2-3-0-on-macos-high-sierra-276a127b8b85