“ 2019年度VIS会议共遴选出3篇最佳论文,可视分析、信息可视化、科学可视化三个领域各1篇,今天阅读科学可视化领域的最佳论文《InSituNet: Deep Image Synthesis for Parameter Space Exploration of Ensemble Simulations》,作者包括俄亥俄州立大学计算机科学与工程系的Wenbin He、Junpeng Wang、Ko-Chih Wang、Han-Wei Shen,以及阿贡国家实验室数学与计算机科学系的Hanqi Guo、Mukund Raj、Youssef S. G. Nashed和Tom Peterka。”

1 发现问题

在处理大规模仿真时,由于I / O和存储限制,普遍采用原位可视化方法,以便在仿真时生成可视化结果。但是,原位可视化方法限制了事后探索的灵活性,因为原始的模拟数据不再可用。尽管已提出了多种基于图像的方法来减轻此限制,但这些方法缺乏探索仿真参数的能力。该论文针对原位可视化组合仿真参数的探索问题开展研究。

相关工作包括基于图像的原位可视化、参数空间探索、可视化深度学习等。

2 研究思路

提出InSituNet,这是一个基于深度学习的替代模型,可为在原位可视化的组合仿真提供参数空间探索支持。此方法利用深度学习的最新进展,可以灵活地探索大型组合仿真的参数空间。

具体来说,将InSituNet设计为卷积回归模型,以学习从“模拟和可视化参数”到“可视化结果”的映射。使用训练好的模型,用户可以在各种可视化设置下为不同的仿真参数生成新图像,从而可以对基础组合仿真进行深入分析。

针对燃烧、宇宙学、海洋模拟等场景,通过定量和定性评估证明InSituNet的有效性。

3 内容概览

论文包括四大核心部分。

3.1 框架概览

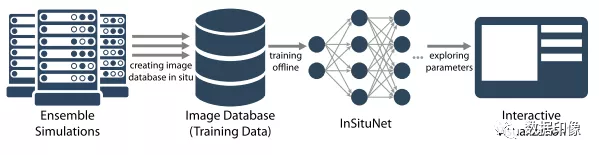

此文方法的工作流程如下图所示。包括三个核心模块。

(1)原位可视化,生成图像,形成图像数据库。此过程中包括3类参数:仿真、视觉映射、视图参数。

(2)训练InSituNet。学习从仿真输入到可视化输出之间的端到端映射。

(3)构建交互式可视化界面,浏览与分析参数。包括预测任意参数条件下的可视化结果,研究不同输入参数对可视化结果的敏感性。

3.2 收集原位训练数据

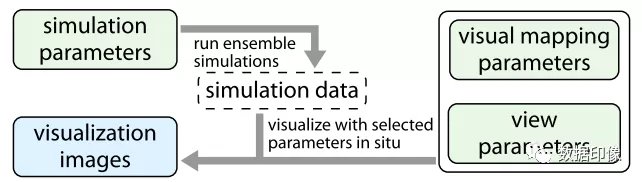

原位数据收集流程如下图所示。

3.3 InSituNet的架构与训练

从输入参数预测可视化图像的训练原理,如下图所示。

3.4 利用InSituNet期待参数空间探索

利用InSituNet进行参数空间探索,如下图所示。

4 创新点

提出一种深度图像合成模型(即InSituNet),可以对集合模拟进行事后参数空间探索。

设计了交互式视觉界面,用于探索和分析集成仿真的参数。

全面分析了InSituNet的不同超参数的影响,并为InSituNet的其他模拟应用提供了指导。

5 体会

原位可视化能够提升可视化效率,但是参数分析方面不太方便,这是一个需要平衡的难题。

更多数据可视化技术相关文章,欢迎关注微信公众号【数据印像】。