加深层的好处

- 减少网络参数

与没有加深层的网络相比,加深了层的网络可以用更少的参数达到同等水平(或者更强)的表现力。我们通过结合卷积运算中的滤波器大小来理解。如下图展示了由5 × 5的滤波器构成的卷积层。

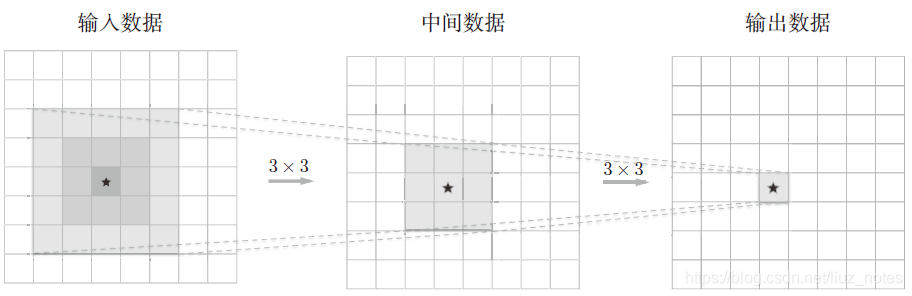

显然,在上图中每个输出节点都是从输入数据的某个5 × 5 的区域算出来的。接下来我们思考下图中重复两次3 × 3 的卷积运算的情形。

此时,每个输出节点将由中间数据的某个3 × 3 的区域计算出来。那么,可以进一步观察到中间数据的3 × 3 的区域又是由前一个输入数据的一个5 × 5 的区域。也就是说,上图的输出数据是“观察”了输入数据的某个5 × 5 的区域后计算出来的。

| 卷积运算 | 卷积区域大小 | 参数数量 |

|---|---|---|

| 5 x 5 | 一层5 x 5 | 25 |

| 5 x 5 | 两层3 x 3 | 18 |

| 7 x 7 | 一层7 x 7 | 49 |

| 7 x 7 | 三层3 x 3 | 27 |

一次5 × 5 的卷积运算的区域可以由两次3 × 3 的卷积运算抵充。 并且,相对于前者的参数数量25(5 × 5),后者一共是18(2 × 3 × 3),通过叠加卷积层,参数数量减少了。而且,这个参数数量之差会随着层的加深而变大。 比如,重复三次3 × 3 的卷积运算时,参数的数量总共是27。而为了用一次卷积运算“观察”与之相同的区域,需要一个7 × 7 的滤波器,此时的参数数量是49。

“叠加小型滤波器来加深网络的好处是可以减少参数的数量,扩大感受野(receptive field,给神经元施加变化的某个局部空间区域)。并且,通过叠加层,将ReLU 等激活函数夹在卷积层的中间,进一步提高了网络的表现力。这是因为向网络添加了基于激活函数的“非线性”表现力,通过非线性函数的叠加,可以表现更加复杂的东西。”

- 使学习更加高效

CNN的卷积层会分层次地提取信息。具体地说,在前面的卷积层中,神经元会对边缘等简单的形状有响应,随着层的加深,开始对纹理、物体部件等更加复杂的东西有响应。 比如,最开始的层只要专注于学

习边缘就好,这样一来,只需用较少的学习数据就可以高效地进行学习。因为比起特定的训练集,拥有某个特征的数据却十分充足,足够训练。

通过加深层,可以分层次地传递信息。也就是说,通过加深层,可以将各层要学习的问题分解成容易

解决的简单问题,从而可以进行高效的学习。

Reference

斋藤康毅. 《深度学习入门——基于python的理论与实现》[M]. 2016