1、sbin下面启动./start-all.sh 之后

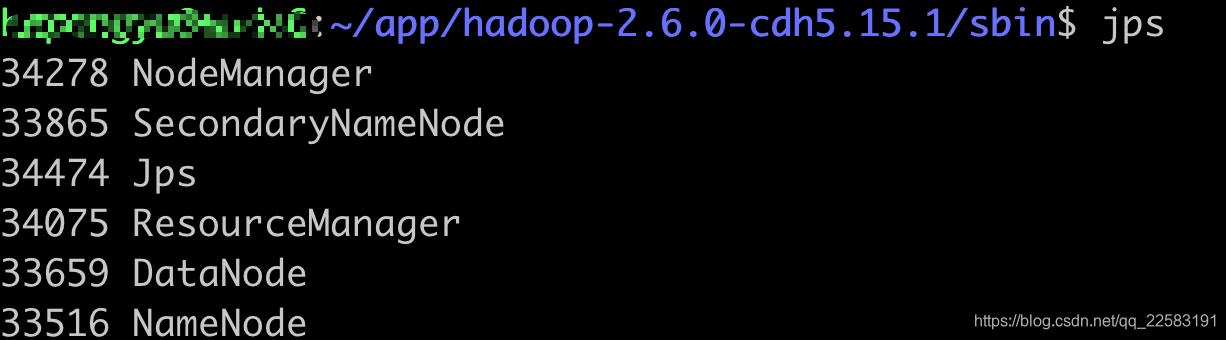

jps查看服务,发现datanode,namenode都木有啊,头大

然后找了两个解决办法:

解决办法一:

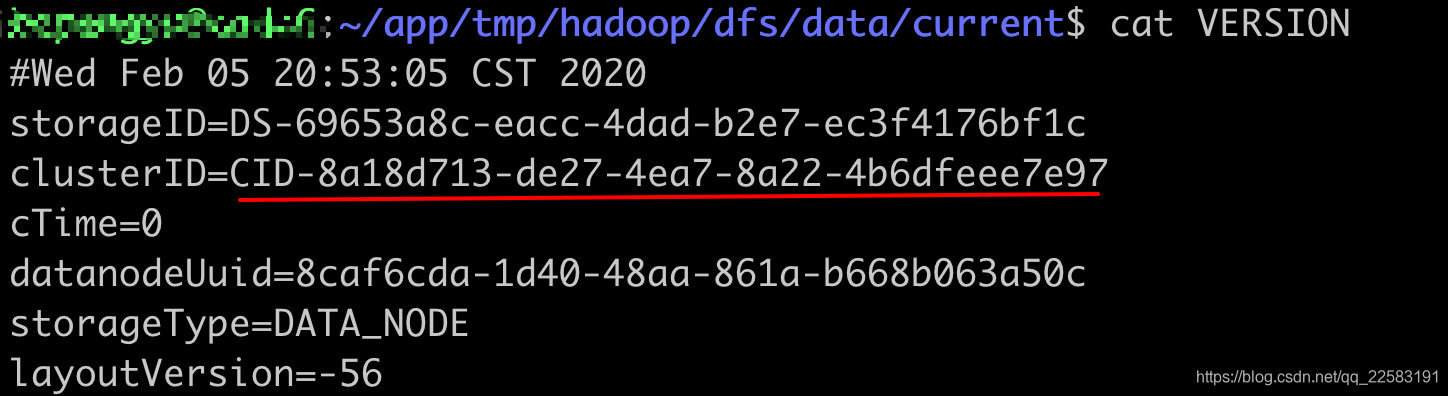

根据日志中的路径,cd /app/tmp/hadoop/dfs/data/current【这个目录每个人不一样的,仅供参考,可以在$HADOOP_HOME/conf/hdfs-site.xml中自己看到的】,能看到 data和name两个文件夹, 将name/current下的VERSION中的clusterID复制到data/current下的VERSION中,覆盖掉原来的clusterID。 让两个保持一致,然后重启,启动后执行jps.我不是通过这个方法解决的,因为我发现两个地方ID是一样的

解决办法二:

直接删除掉dfs文件夹中name和data文件夹里的所有内容

sudo rm -rf data/

sudo rm -rf name/

去到$HADOOP_HOME/bin下面执行

./hdfs namenode -format

之后再重启,OK了。

如有问题欢迎留言,谢谢观看!