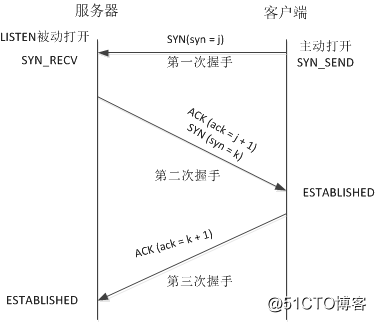

首先贴上tcp 三次握手的原理图

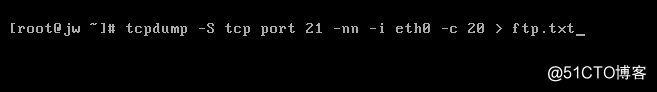

服务器开启ftp服务并执行tcpdump抓包

服务器:192.168.3.14 ftp服务

客户端:192.168.3.100

服务器执行以下命令,客户端访问服务器ftp://192.168.3.14

tcpdump -S tcp port 21 -nn -i eth0 -c 20 > ftp.txt

-S打印TCP 数据包的顺序号时, 使用绝对的顺序号, 而不是相对的顺序号

监控ftp的命令端口21

-c 只抓20个数据包

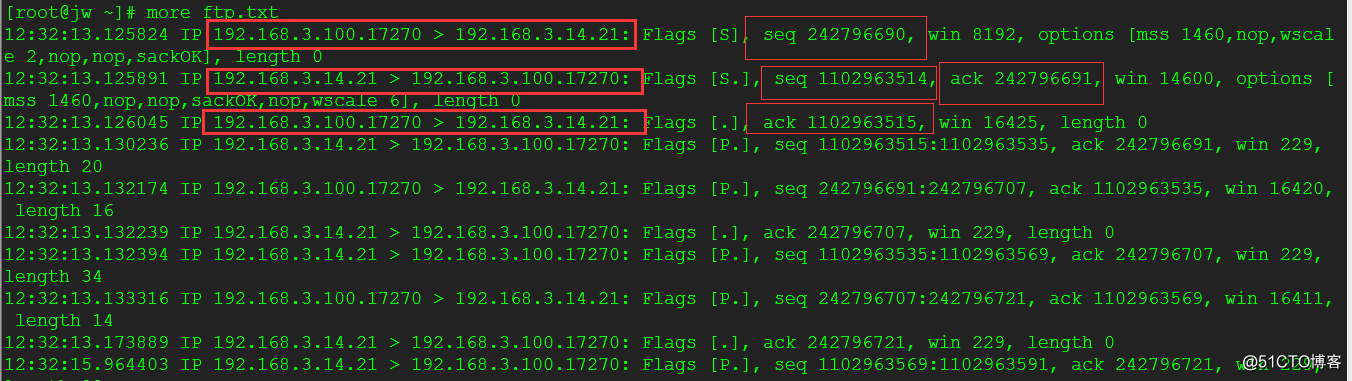

192.168.3.100客户端使用随机端口访问服务器21端口,seq=242796690(syn=j)

服务器192.168.3.14回应客户端192.168.3.100

seq 1102963514, ack 242796691(ack=j+1,seq=k)

客户端192.168.3.100确认接受到服务器192.168.3.14的信息

ack 1102963515(ack=k+1)

此时服务器与客户端进入ESTABLISHED状态,开始进行数据传送。。

利用tcpdump命令统计http的GET和POST请求

1、搭建的知识库服务器, 需要统计来访者都是哪些人,因为系统不是自己开发的,看不到访问日志。所以考虑从系统层面抓取访问流量来实现。

2、通过tcpdump抓取的数据包,在wireshark中打开发现,http的请求GET动作,或者POST动作,加HOST拼接成一个url可以打开,抓取到的页面类似于这种:http://192.168.102.238:8090/pages/viewpage.action?pageId=491717

3、由于我们内部工作人员的IP地址基本固定,所以通过IP和访问的域名来判断是否是正常的打开页面请求,来记录一次来访者。

4、tcpdump命令使用如下:

[root@conence ~]# tcpdump -i em1 tcp[20:2]=0x4745 or tcp[20:2]=0x504f -c 10

| awk {'print $3'} | uniq | sort -n //偏移抓包tcp[20:2]=0x4745 为HTTP-GET 请求,0x504f为HTTP-POST请求,利用该条命令抓取HTTP的GET和POST请求。

5、简单写一个抓包的脚本,放到crontab中每秒执行

[root@coence test]# cat sic.sh

#!/bin/bash

i=1

while (($i<=5))

do

DATE0=`date +%Y%m%d%H%M`

/usr/sbin/tcpdump -i em1 tcp[20:2]=0x4745 or tcp[20:2]=0x504f -c 20 | awk {'print $3'}| uniq | sort -n |awk -F '.' '{print $1.$2.$3.$4}' | uniq >> /tmp/log/src.log_${DATE0}

*//该命令用于抓取HTTP GET/POST 请求,提取源IP,然后利用awk排序并输出,其中uniq 去除重复项,awk -F XX ,提取一个IP地址的其中一个字段 print $1.$2 目的是拆分同一个字符串(比如192.168.1.1.55611这个在awk来看是一个字符,如果需要输出其中的55611 则需要通过-F 加 "." 来拆分,然后使用 print $5 单独输出其中的一个字段),其中/usr/sbin/tcpdump 为绝对路径,如果需要把这个脚本加到crontab中来执行,就需要填写绝对路径*

sleep 10s

*//等待10s,抓包数到20个,才能确认是一次正常的页面请求,这个通过抓包测试过,打开一个页面在15-20个数据包左右*

kill `ps aux | grep tcpdump | grep -v grep | awk '{print $2}'`

//结束当前的抓包

let "i++"

done

exit

6、保存的日志还需要导出之后,通过execl来转换

7、简单的统计效果

1.监听eth0网卡HTTP 80端口的request和response

tcpdump -i eth0 -A -s 0 'tcp port 80 and (((ip[2:2] - ((ip[0]&0xf)<<2)) - ((tcp[12]&0xf0)>>2)) != 0)'

2.监听eth0网卡HTTP 80端口的request(不包括response),指定来源域名"example.com",也可以指定IP"192.168.1.107"

tcpdump -i eth0 -A -s 0 'src example.com and tcp port 80 and (((ip[2:2] - ((ip[0]&0xf)<<2)) - ((tcp[12]&0xf0)>>2)) != 0)'

3.监听本机发送至本机的HTTP 80端口的request和response

tcpdump -i lo -A -s 0 'tcp port 80 and (((ip[2:2] - ((ip[0]&0xf)<<2)) - ((tcp[12]&0xf0)>>2)) != 0)'

4.监听eth0网卡HTTP 80端口的request和response,结果另存为cap文件

tcpdump -i eth0 -A -s 0 'tcp port 80 and (((ip[2:2] - ((ip[0]&0xf)<<2)) - ((tcp[12]&0xf0)>>2)) != 0)' -w ./dump.cap

注1:如果报错"tcpdump: Bluetooth link-layer type filtering not implemented",是因为默认网卡不是ech0,需要用-i参数指定

注2:通过ifconfig命令查看网卡

$ tcpdump -i eth0 -nnA tcp and src host 192.168.1.231 and dst 211.138.24.191|grep 关键字过滤

tcpdump

tcpdump是linux系统自带的抓包工具,主要通过命令行的方式,比较适合在线上服务器进行抓包操作,如果是windows或者ubuntu完全可 以选择一些图形化的工具,ubuntu比较推荐用wireshark,安装方式很简单sudo apt一下即可。

命令行格式:

tcpdump [ -adeflnNOpqStvx ] [ -c 数量 ] [ -F 文件名 ][ -i 网络接口 ] [ -r 文件名] [ -s snaplen ][ -T 类型 ] [ -w 文件名 ] [表达式 ]

常用的参数:

-l 使标准输出变为缓冲行形式;

-n 不把网络地址转换成名字;

-c 在收到指定的包的数目后,tcpdump就会停止;

-i 指定监听的网络接口;(如果没有指定可能在默认网卡上监听,需要指定绑定了特定IP的网卡)

-w 直接将包写入文件中,并不分析和打印出来;

-s 指定记录package的大小,常见 -s 0 ,代表最大值65535,一半linux传输最小单元MTU为1500,足够了

-X 直接输出package data数据,默认不设置,只能通过-w指定文件进行输出

常用表达式:

关于类型的关键字,主要包括host,net,port

传输方向的关键字,主要包括src , dst ,dst or src, dst and src

协议的关键字,主要包括fddi,ip ,arp,rarp,tcp,udp等类型

逻辑运算,取非运算是 'not ' '! ', 与运算是'and','&&';或运算 是'or' ,'||'

其他重要的关键字如下:gateway, broadcast,less,greater

实际例子:

1. http数据包抓取 (直接在终端输出package data)

tcpdump tcp port 80 -n -X -s 0 指定80端口进行输出

2. 抓取http包数据指定文件进行输出package

tcpdump tcp port 80 -n -s 0 -w /tmp/tcp.cap

对应的/tmp/tcp.cap基本靠肉眼已经能看一下信息,比如http Header , content信息等

3. 结合管道流

tcpdump tcp port 80 -n -s 0 -X -l | grep xxxx

这样可以实时对数据包进行字符串匹配过滤

4. mod_proxy反向代理抓包

线上服务器apache+jetty,通过apache mod_proxy进行一个反向代理,80 apache端口, 7001 jetty端口

apache端口数据抓包: tcpdump tcp port 80 -n -s 0 -X -i eth0 注意:指定eth0网络接口

jetty端口数据抓包: tcpdump tcp port 7001 -n -s 0 -X -i lo 注意:指定Loopback网络接口

5. 只监控特定的ip主机

tcpdump tcp host 10.16.2.85 and port 2100 -s 0 -X

需要使用tcp表达式的组合,这里是host指示只监听该ip

小技巧:

1. 可结合tcpdump(命令) + wireshark(图形化)

操作:

在服务器上进行tcpdump -w /tmp/tcp.cap 指定输出外部文件

scp /tmp/tcp.cap 拷贝文件到你本地

wireshark & 启动wireshark

通过 File -> Open 打开拷贝下来的文件,这样就可以利用进行数据包分析了

剩下来的事就非常方便了

tcpdump -XvvennSs 0 -i eth0 tcp[20:2]=0x4745 or tcp[20:2]=0x4854

0x4745 为"GET"前两个字母"GE"

0x4854 为"HTTP"前两个字母"HT"

说明: 通常情况下:一个正常的TCP连接,都会有三个阶段:1、TCP三次握手;2、数据传送;3、TCP四次挥手

里面的几个概念:

- SYN: (同步序列编号,Synchronize Sequence Numbers)

- ACK: (确认编号,Acknowledgement Number)

- FIN: (结束标志,FINish)

TCP三次握手(创建 OPEN)

- 客户端发起一个和服务创建TCP链接的请求,这里是SYN(J)

- 服务端接受到客户端的创建请求后,返回两个信息: SYN(K) + ACK(J+1)

- 客户端在接受到服务端的ACK信息校验成功后(J与J+1),返回一个信息:ACK(K+1)

- 服务端这时接受到客户端的ACK信息校验成功后(K与K+1),不再返回信息,后面进入数据通讯阶段

数据通讯

- 客户端/服务端 read/write数据包

TCP四次握手(关闭 finish)

- 客户端发起关闭请求,发送一个信息:FIN(M)

- 服务端接受到信息后,首先返回ACK(M+1),表明自己已经收到消息。

- 服务端在准备好关闭之前,最后发送给客户端一个 FIN(N)消息,询问客户端是否准备好关闭了

- 客户端接受到服务端发送的消息后,返回一个确认信息: ACK(N+1)

- 最后,服务端和客户端在双方都得到确认时,各自关闭或者回收对应的TCP链接。

详细的状态说明(以及linux相关参数调整)

- SYN_SEND

- 客户端尝试链接服务端,通过open方法。也就是TCP三次握手中的第1步之后,注意是客户端状态

- sysctl -w net.ipv4.tcp_syn_retries = 2 ,做为客户端可以设置SYN包的重试次数,默认5次(大约180s)引用校长的话:仅仅重试2次,现代网络够了

- SYN_RECEIVED

- 服务接受创建请求的SYN后,也就是TCP三次握手中的第2步,发送ACK数据包之前

- 注意是服务端状态,一般15个左右正常,如果很大,怀疑遭受SYN_FLOOD攻击

- sysctl -w net.ipv4.tcp_max_syn_backlog=4096 , 设置该状态的等待队列数,默认1024,调大后可适当防止syn-flood,可参见man 7 tcp

- sysctl -w net.ipv4.tcp_syncookies=1 , 打开syncookie,在syn backlog队列不足的时候,提供一种机制临时将syn链接换出

- sysctl -w net.ipv4.tcp_synack_retries = 2 ,做为服务端返回ACK包的重试次数,默认5次(大约180s)引用校长的话:仅仅重试2次,现代网络够了

- ESTABLISHED

- 客户端接受到服务端的ACK包后的状态,服务端在发出ACK在一定时间后即为ESTABLISHED

- sysctl -w net.ipv4.tcp_keepalive_time = 1200 ,默认为7200秒(2小时),系统针对空闲链接会进行心跳检查,如果超过net.ipv4.tcp_keepalive_probes * net.ipv4.tcp_keepalive_intvl = 默认11分,终止对应的tcp链接,可适当调整心跳检查频率

- 目前线上的监控 waring:600 , critial : 800

- FIN_WAIT1

- 主动关闭的一方,在发出FIN请求之后,也就是在TCP四次握手的第1步

- CLOSE_WAIT

- 被动关闭的一方,在接受到客户端的FIN后,也就是在TCP四次握手的第2步

- FIN_WAIT2

- 主动关闭的一方,在接受到被动关闭一方的ACK后,也就是TCP四次握手的第2步

- sysctl -w net.ipv4.tcp_fin_timeout=30, 可以设定被动关闭方返回FIN后的超时时间,有效回收链接,避免syn-flood.

- LASK_ACK

- 被动关闭的一方,在发送ACK后一段时间后(确保客户端已收到),再发起一个FIN请求。也就是TCP四次握手的第3步

- TIME_WAIT

- 主动关闭的一方,在收到被动关闭的FIN包后,发送ACK。也就是TCP四次握手的第4步

- sysctl -w net.ipv4.tcp_tw_recycle = 1 , 打开快速回收TIME_WAIT,Enabling this option is not recommended since this causes problems when working with NAT (Network Address Translation)

- sysctl -w net.ipv4.tcp_tw_reuse =1, 快速回收并重用TIME_WAIT的链接, 貌似和tw_recycle有冲突,不能重用就回收?

- net.ipv4.tcp_max_tw_buckets: 处于time_wait状态的最多链接数,默认为180000.

相关说明

- 主动关闭方在接收到被动关闭方的FIN请求后,发送成功给对方一个ACK后,将自己的状态由FIN_WAIT2修改为TIME_WAIT,而必须 再等2倍的MSL(Maximum Segment Lifetime,MSL是一个数据报在internetwork中能存在的时间)时间之后双方才能把状态 都改为CLOSED以关闭连接。目前RHEL里保持TIME_WAIT状态的时间为60秒

- keepAlive策略可以有效的避免进行三次握手和四次关闭的动作

其他网络重要参数

net.ipv4.tcp_rmem 参数

默认值: min=4096 default=87380 max=4194304

net.ipv4.tcp_wmem 参数

默认值: min=4096 default=16384 max=4194304

单独总结tcpdump抓包的常用命令

主要语法

过滤主机/IP:

tcpdump -i eth1 host 172.16.7.206

抓取所有经过网卡1,目的IP为172.16.7.206的网络数据

过滤端口:

tcpdump -i eth1 dst port 1234

抓取所有经过网卡1,目的端口为1234的网络数据

过滤特定协议:

tcpdump -i eth1 udp

抓取所有经过网卡1,协议类型为UDP的网络数据

抓取本地环路数据包

tcpdump -i lo udp 抓取UDP数据

tcpdump -i lo udp port 1234 抓取端口1234的UDP数据

tcpdump -i lo port 1234 抓取端口1234的数据

特定协议特定端口:

tcpdump udp port 1234

抓取所有经过1234端口的UDP网络数据

抓取特定类型的数据包:

tcpdump -i eth1 ‘tcp[tcpflags] = tcp-syn’

抓取所有经过网卡1的SYN类型数据包

tcpdump -i eth1 udp dst port 53

抓取经过网卡1的所有DNS数据包(默认端口)

逻辑语句过滤:

tcpdump -i eth1 ‘((tcp) and ((dst net 172.16) and (not dst host 192.168.1.200)))’

抓取所有经过网卡1,目的网络是172.16,但目的主机不是192.168.1.200的TCP数据

抓包存取:

tcpdump -i eth1 host 172.16.7.206 and port 80 -w /tmp/xxx.cap

抓取所有经过网卡1,目的主机为172.16.7.206的端口80的网络数据并存储

1、搭建的知识库服务器, 需要统计来访者都是哪些人,因为系统不是自己开发的,看不到访问日志。所以考虑从系统层面抓取访问流量来实现。

2、通过tcpdump抓取的数据包,在wireshark中打开发现,http的请求GET动作,或者POST动作,加HOST拼接成一个url可以打开,抓取到的页面类似于这种:http://192.168.102.238:8090/pages/viewpage.action?pageId=491717

3、由于我们内部工作人员的IP地址基本固定,所以通过IP和访问的域名来判断是否是正常的打开页面请求,来记录一次来访者。

4、tcpdump命令使用如下:

[root@conence ~]# tcpdump -i em1 tcp[20:2]=0x4745 or tcp[20:2]=0x504f -c 10

| awk {'print $3'} | uniq | sort -n //偏移抓包tcp[20:2]=0x4745 为HTTP-GET 请求,0x504f为HTTP-POST请求,利用该条命令抓取HTTP的GET和POST请求。

5、简单写一个抓包的脚本,放到crontab中每秒执行

[root@coence test]# cat sic.sh

#!/bin/bash

i=1

while (($i<=5))

do

DATE0=`date +%Y%m%d%H%M`

/usr/sbin/tcpdump -i em1 tcp[20:2]=0x4745 or tcp[20:2]=0x504f -c 20 | awk {'print $3'}| uniq | sort -n |awk -F '.' '{print $1.$2.$3.$4}' | uniq >> /tmp/log/src.log_${DATE0}

*//该命令用于抓取HTTP GET/POST 请求,提取源IP,然后利用awk排序并输出,其中uniq 去除重复项,awk -F XX ,提取一个IP地址的其中一个字段 print $1.$2 目的是拆分同一个字符串(比如192.168.1.1.55611这个在awk来看是一个字符,如果需要输出其中的55611 则需要通过-F 加 "." 来拆分,然后使用 print $5 单独输出其中的一个字段),其中/usr/sbin/tcpdump 为绝对路径,如果需要把这个脚本加到crontab中来执行,就需要填写绝对路径*

sleep 10s

*//等待10s,抓包数到20个,才能确认是一次正常的页面请求,这个通过抓包测试过,打开一个页面在15-20个数据包左右*

kill `ps aux | grep tcpdump | grep -v grep | awk '{print $2}'`

//结束当前的抓包

let "i++"

done

exit

6、保存的日志还需要导出之后,通过execl来转换

7、简单的统计效果