1 tensorboard网络结构

下文中所用的部分数据集链接(百度网盘):

链接:https://pan.baidu.com/s/1_Y0rWLj9wuJefzT9JME5Ug

提取码:6fho

先来说说流程图

1.1 不用命名空间

实际上可以直接在会话中添加 :

writer = tf.summary.FileWriter('logs/',sess.graph)

# 扔初始化变量后面就行

另外,关于这个函数 : log是事件文件所在的目录(这里就是当前主目录下),第二个参数是事件文件要记录的图(这里是tensorflow默认的图)。

1.1.1 程序

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 载入数据集

mnist = input_data.read_data_sets("MNIST_data",one_hot=True)

# 定义变量_每个批次的大小

batch_size = 100

# 计算一共多少批次

n_batch = mnist.train.num_examples // batch_size # 整除

# 命名空间

# 定义placeholder

x = tf.placeholder(tf.float32,[None,784],name='x-input')

y = tf.placeholder(tf.float32,[None,10],name='y-input')

# 创建简单的神经网络

W = tf.Variable(tf.zeros([784,10]),name="W")

b = tf.Variable(tf.zeros([10]),name="b")

wx_plus_b = tf.matmul(x,W) + b

prediction = tf.nn.softmax(wx_plus_b)

# 定义代价函数(二次)

loss = tf.reduce_mean(tf.square(y - prediction))

# 使用梯度下降法并最小化代价函数

train_step = tf.train.GradientDescentOptimizer(0.2).minimize(loss)

# 初始化变量

init = tf.global_variables_initializer()

# 定义求准确率的方法

correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(prediction,1))

# 求准确率

accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))

with tf.Session() as sess:

sess.run(init)

# tensorboard绘图

writer = tf.summary.FileWriter('logs/',sess.graph)

for epoch in range(1):

for batch in range(n_batch):

# 输入数据

batch_xs,batch_ys = mnist.train.next_batch(batch_size)

# 训练

sess.run(train_step,feed_dict = {x:batch_xs,y:batch_ys})

# 测试下准确率

acc = sess.run(accuracy,feed_dict = {x:mnist.test.images,y:mnist.test.labels})

print("Iter " + str(epoch) + ".Testing Accuracy " + str(acc))

1.1.2 tensorboard

看上去可能会有些乱,所以可以为其加上命名。

1.2 命名空间

1.2.1 程序

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 载入数据集

mnist = input_data.read_data_sets("MNIST_data",one_hot=True)

# 定义变量_每个批次的大小

batch_size = 100

# 计算一共多少批次

n_batch = mnist.train.num_examples // batch_size # 整除

# 命名空间

with tf.name_scope("input"):

# 定义placeholder

x = tf.placeholder(tf.float32,[None,784],name='x-input')

y = tf.placeholder(tf.float32,[None,10],name='y-input')

with tf.name_scope("layer"):

# 创建简单的神经网络

with tf.name_scope("wights"):

W = tf.Variable(tf.zeros([784,10]),name="W")

with tf.name_scope("biases"):

b = tf.Variable(tf.zeros([10]),name="b")

with tf.name_scope("wx_plus_b"):

wx_plus_b = tf.matmul(x,W) + b

with tf.name_scope("softmax"):

prediction = tf.nn.softmax(wx_plus_b)

# 定义代价函数(二次)

with tf.name_scope("loss"):

loss = tf.reduce_mean(tf.square(y - prediction))

# 使用梯度下降法并最小化代价函数

with tf.name_scope("train"):

train_step = tf.train.GradientDescentOptimizer(0.2).minimize(loss)

# 初始化变量

init = tf.global_variables_initializer()

with tf.name_scope("acc"):

with tf.name_scope("correct_prediction"):

# 定义求准确率的方法

correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(prediction,1))

with tf.name_scope("accuracy"):

# 求准确率

accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))

with tf.Session() as sess:

sess.run(init)

writer = tf.summary.FileWriter('logs/',sess.graph)

for epoch in range(1):

for batch in range(n_batch):

batch_xs,batch_ys = mnist.train.next_batch(batch_size)

sess.run(train_step,feed_dict = {x:batch_xs,y:batch_ys})

# 测试下准确率

acc = sess.run(accuracy,feed_dict = {x:mnist.test.images,y:mnist.test.labels})

print("Iter " + str(epoch) + ".Testing Accuracy " + str(acc))

1.2.2 tensorboard

事实上展开后里边东西是一样的,只是换了一种表述方法,使其结构更加清晰了可以查看对应块的输入与输出及其类型

温馨提示 :

(1)名称域很重要,名称域越好,可视性越好

(2)定义名字别用汉语,会报错…

2 tensorflow网络运行

2.1 程序及函数介绍

这里和上一个程序最大的不同点是下面这个函数 :

def variable_summaries(var):

with tf.name_scope('summaries'):

mean = tf.reduce_mean(var)

tf.summary.scalar('mean', mean) #平均值

with tf.name_scope('stddev'):

stddev = tf.sqrt(tf.reduce_mean(tf.square(var - mean)))

tf.summary.scalar('stddev', stddev) #标准差

tf.summary.scalar('max', tf.reduce_max(var)) #最大值

tf.summary.scalar('min', tf.reduce_min(var)) #最小值

tf.summary.histogram('histogram', var) #直方图

其中,tf.summary.scalar()用来显示标量信息,其格式为 :

tf.summary.scalar(name, tensor, collections=None)

其中name人为指定,tensor为需要统计的张量

summary.histogram()也可以通过上述方法使用

而在面对损失值或者准确率时由于其值只有一个,故而最大、最小、平均等值无意义,只需要直接tf.summary.scalar即可

然后在run会话前先合并下所有的summary : merged = tf.summary.merge_all()

别忘了在训练过程中run一下(本文采用fetch)

最后把summary写到生成的文件中去别忘了再传下周期 : writer.add_summary(summary,epoch)

下面是完整程序 :

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 载入数据集

mnist = input_data.read_data_sets("MNIST_data",one_hot=True)

# 定义变量_每个批次的大小

batch_size = 100

# 计算一共多少批次

n_batch = mnist.train.num_examples // batch_size # 整除

#参数概要

def variable_summaries(var):

with tf.name_scope('summaries'):

mean = tf.reduce_mean(var)

tf.summary.scalar('mean', mean) #平均值

with tf.name_scope('stddev'):

stddev = tf.sqrt(tf.reduce_mean(tf.square(var - mean)))

tf.summary.scalar('stddev', stddev) #标准差

tf.summary.scalar('max', tf.reduce_max(var)) #最大值

tf.summary.scalar('min', tf.reduce_min(var)) #最小值

tf.summary.histogram('histogram', var) #直方图

# 命名空间

with tf.name_scope("input"):

# 定义placeholder

x = tf.placeholder(tf.float32,[None,784],name='x-input')

y = tf.placeholder(tf.float32,[None,10],name='y-input')

with tf.name_scope("layer"):

# 创建简单的神经网络

with tf.name_scope("wights"):

W = tf.Variable(tf.zeros([784,10]),name="W")

variable_summaries(W)

with tf.name_scope("biases"):

b = tf.Variable(tf.zeros([10]),name="b")

variable_summaries(b)

with tf.name_scope("wx_plus_b"):

wx_plus_b = tf.matmul(x,W) + b

with tf.name_scope("softmax"):

prediction = tf.nn.softmax(wx_plus_b)

# 定义代价函数(二次)

with tf.name_scope("loss"):

loss = tf.reduce_mean(tf.square(y - prediction))

tf.summary.scalar("loss",loss)

# 使用梯度下降法并最小化代价函数

with tf.name_scope("train"):

train_step = tf.train.GradientDescentOptimizer(0.2).minimize(loss)

# 初始化变量

init = tf.global_variables_initializer()

with tf.name_scope("accuracy"):

with tf.name_scope("correct_prediction"):

# 定义求准确率的方法

correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(prediction,1))

with tf.name_scope("acc"):

# 求准确率

accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))

tf.summary.scalar("accuracy",accuracy)

# 合并所有summary

merged = tf.summary.merge_all()

with tf.Session() as sess:

sess.run(init)

writer = tf.summary.FileWriter('logs/',sess.graph)

for epoch in range(51):

for batch in range(n_batch):

batch_xs,batch_ys = mnist.train.next_batch(batch_size)

summary,_ = sess.run([merged,train_step],feed_dict = {x:batch_xs,y:batch_ys})

writer.add_summary(summary,epoch)

# 测试下准确率

acc = sess.run(accuracy,feed_dict = {x:mnist.test.images,y:mnist.test.labels})

print("Iter " + str(epoch) + ".Testing Accuracy " + str(acc))

2.2 tensorboard

这里由于程序结构没变所以图表和上面那个一样,所以这次来看看scalar

下面拿accuracy来说下 :

左侧Smoothing可以使折线更加细致,当然,也会因此失真

那么,如何使其看上去更加细致呢?增加样本点数或许是一个不错的选择,但随之而来的问题就是你会增加训练次数,那么,如何保证在训练时间不再增加的前提下多增加样本点数呢?

提供部分程序 :

for i in range(2001):

# 每100个样本

batch_xs,batch_ys = mnist.train.next_batch(100)

summary,_ = sess.run([merged,train_step],feed_dict = {x:batch_xs,y:batch_ys})

writer.add_summary(summary,i)

if i % 500 == 0:

# 测试下准确率

acc = sess.run(accuracy,feed_dict = {x:mnist.test.images,y:mnist.test.labels})

print("Iter " + str(epoch) + ".Testing Accuracy " + str(acc))

将其替换你会话中的主循环即可

效果如下(以accuracy为例) :

有时候细致不等于光滑,不是吗?

接下来是偏置值和权值的分布图,颜色越深则分布在这里的值也就越多

以及权值及偏置值的直方图 :

3 tensorboard可视化

3.1 程序及介绍

运行这个程序前先在你当前主目录中新建一个文件夹(我这里叫hhh),再在里边新建两个文件夹,一个叫data,另一个叫projector,data中要先把数据图片放入,就是下面这张

至于projector,交给你的程序就行

下面是完整程序

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

from tensorflow.contrib.tensorboard.plugins import projector

# 载入数据集

mnist = input_data.read_data_sets("MNIST_data/",one_hot=True)

# 运行次数

max_steps = 1001

# 图片数量

image_num = 3000

# 定义会话

sess = tf.Session()

# 载入图片

embedding = tf.Variable(tf.stack(mnist.test.images[:image_num]), trainable=False, name='embedding')

# tf.stack将0到image_num张图片打包(拼接)

# 关于参数trainable,如果为True,会把它加入到GraphKeys.TRAINABLE_VARIABLES,才能对它使用Optimizer,而此处不需要,所以置为False

# 参数概要

def variable_summaries(var):

with tf.name_scope('summaries'):

mean = tf.reduce_mean(var)

tf.summary.scalar('mean', mean) # 平均值

with tf.name_scope('stddev'):

stddev = tf.sqrt(tf.reduce_mean(tf.square(var - mean)))

tf.summary.scalar('stddev', stddev) # 标准差

tf.summary.scalar('max', tf.reduce_max(var)) # 最大值

tf.summary.scalar('min', tf.reduce_min(var)) # 最小值

tf.summary.histogram('histogram', var) # 直方图

# 命名空间

with tf.name_scope('input'):

# 这里的none表示第一个维度可以是任意的长度

x = tf.placeholder(tf.float32,[None,784],name='x-input')

# 正确的标签

y = tf.placeholder(tf.float32,[None,10],name='y-input')

# 显示图片

with tf.name_scope('input_reshape'):

image_shaped_input = tf.reshape(x, [-1, 28, 28, 1])

# 说下reshape中的第二个参数 :

# -1表示任意值,即可以是任意张图片

# 此处将一张图片(包含784个像素值的一维数组转化为28x28)

# 此处为灰度图片,维度(通道数)为1,如果为rgb图片则为3

tf.summary.image('input', image_shaped_input, 10)

# 其中三个参数分别为名称,张量,生成图像的最大批处理数量

# 创建一个简单神经网络

with tf.name_scope('layer'):

with tf.name_scope('weights'):

W = tf.Variable(tf.zeros([784,10]),name='W')

variable_summaries(W)

with tf.name_scope('biases'):

b = tf.Variable(tf.zeros([10]),name='b')

variable_summaries(b)

with tf.name_scope('wx_plus_b'):

wx_plus_b = tf.matmul(x,W) + b

with tf.name_scope('softmax'):

prediction = tf.nn.softmax(wx_plus_b)

with tf.name_scope('loss'):

# 交叉熵代价函数

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(labels=y,logits=prediction))

tf.summary.scalar('loss',loss)

with tf.name_scope('train'):

#使用梯度下降法

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(loss)

# 初始化变量

sess.run(tf.global_variables_initializer())

with tf.name_scope('accuracy'):

with tf.name_scope('correct_prediction'):

# 结果存放在一个布尔型列表中

correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(prediction,1))#argmax返回一维张量中最大的值所在的位置

with tf.name_scope('accuracy'):

# 求准确率

accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))#把correct_prediction变为float32类型

tf.summary.scalar('accuracy',accuracy)

# 产生metadata文件

if tf.gfile.Exists(r"D:\anaconda\hhh\projector\metadata.tsv"):

tf.gfile.DeleteRecursively(r"D:\anaconda\hhh\projector\metadata.tsv")

# 如果有该文件则删除

with open(r"D:\anaconda\hhh\projector\metadata.tsv", 'w') as f:

# 用写的方式打开,在此处即为新建此文件

labels = sess.run(tf.argmax(mnist.test.labels[:],1))

# 拿到测试集的标签

# 将数据写入对应文件

for i in range(image_num):

f.write(str(labels[i]) + '\n')

# 合并所有的summary

merged = tf.summary.merge_all()

# 将对应图的结构存在指定路径下

projector_writer = tf.summary.FileWriter(r'D:\anaconda\hhh\projector',sess.graph)

# 定义saver保存网络模型

saver = tf.train.Saver()

# 定义配置项

config = projector.ProjectorConfig()

embed = config.embeddings.add()

# 将图片的名字赋给embed.tensor_name

embed.tensor_name = embedding.name

# 给它一个文件的路径

embed.metadata_path = r'D:\anaconda\hhh\projector\metadata.tsv'

# 给它图片的路径

embed.sprite.image_path = r'D:\anaconda\hhh\data\mnist_10k_sprite.png'

# 将目标图片进行拆分(在这个图片上体现就是切分为10k张28x28的图片)

embed.sprite.single_image_dim.extend([28,28])

# 输入目标图片及对应配置

projector.visualize_embeddings(projector_writer,config)

for i in range(max_steps):

# 每个批次100个样本

batch_xs,batch_ys = mnist.train.next_batch(100)

# run下配置

run_options = tf.RunOptions(trace_level=tf.RunOptions.FULL_TRACE)

run_metadata = tf.RunMetadata()

summary,_ = sess.run([merged,train_step],feed_dict={x:batch_xs,y:batch_ys},options=run_options,run_metadata=run_metadata)

projector_writer.add_run_metadata(run_metadata, 'step%03d' % i)

projector_writer.add_summary(summary, i)

# 每训练100次打印下准确率

if i%100 == 0:

acc = sess.run(accuracy,feed_dict={x:mnist.test.images,y:mnist.test.labels})

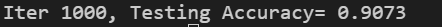

print ("Iter " + str(i) + ", Testing Accuracy= " + str(acc))

# 保存训练好的模型

saver.save(sess, r'D:\anaconda\hhh\projector\a_model.ckpt', global_step=max_steps)

# 关闭writer及会话

projector_writer.close()

sess.close()

跑完以后你的projector就装好需要的东西了

打开终端,tensorboard,打开网址,查看projector项(可能有点慢没加载出来)

3.2 tensorboard

初始时就如下图

如果你觉得不够明显,左边color by 可以改变颜色,如下

除外,你还可以通过T-SNE查看模型的实际效果

左下角可以查看训练次数,当然我这里只训练了82次,之所以只到这里就让它停止了是因为这个模型训练的并不是很好,继续下去没太大的意义,(实际上其准确率到90就差不多收敛了)

上面是程序的输出结果的最后一部分

另外再说一句,这个训练过程真的很有趣…hhh