经典也会被经典超越。

20世纪深度学习研究中,引用最多的论文不再是反向传播。

新的宠儿,是1997年Hochreiter和Schmidhuber发表的Long short-term memory。

大名鼎鼎的LSTM。

作为「LSTM 之父」的 Jürgen Schmidhuber 虽然没有获得图灵奖(也因乖张的行为不受待见),但他在深度学习领域的贡献仍然获得了整个社区的「被动认可」。

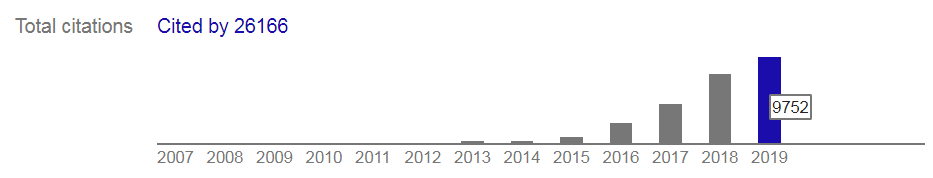

最近几天,有人通过 Google Scholar 的统计发现:Hochreiter 和 Schmidhuber 1997 年发表的 LSTM 论文成为了 20 世纪被引最高的深度学习研究论文。

截至今日,这篇论文的被引用量已经达到 26166,超过了 Hinton 1985 年发表的反向传播相关论文(《Learning internal representations by error propagation》)。

出人预料的排名变化是在最近发生的,LSTM 论文在 2019 年的年度引用量高达 9752 次,高于此前 Bengio、LeCun 等人年度被引最高的 CNN 相关论文(《Gradient-based learning applied to document recognition》)。

20 世纪 DL 最高被引论文易主

其实在此之前,20世纪深度学习领域被引量最高的论文一直是图灵奖得主 Geoffrey Hinton 的「反向传播」相关论文,其累计引用量达到了 64757。但值得注意的是,该引用量是标了星号的(如下图所示)。

该星号表示,这个数字代表的不是单篇论文引用量,而是几篇论文的综合引用量。包括:

-

Learning internal representations by error propagation. DE Rumelhart, GE Hinton, RJ Williams, California Univ San Diego La Jolla, Inst for Cognitive Science, 1985 (被引 25k)

-

Parallel distributed processing. JL McClelland, DE Rumelhart, PDP Research Group, MIT press, 1987 (被引 24k)

扫描二维码关注公众号,回复: 9052206 查看本文章

-

Learning representations by back-propagating errors. DE Rumelhart, GE Hinton, RJ Williams, Nature 323 (6088), 533-536, 1986 被引 (20k)

-

……

因此,上图中 Hinton 被引最高的深度学习论文《Learning internal representations by error propagation》的单篇引用量应该为 25398,略低于 Schmidhuber 的上述论文。

除此之前,Schmidhuber 的上述论文在年度引用量上也拔得头筹(9752),超过了上述「反向传播」三篇论文的总和(3574+461+3181),也高于之前年度被引最高的 CNN 相关论文(6301)。

Schmiduber LSTM 论文年度被引用量。

Bengio、Lecun 等人 CNN 相关论文年度被引用量。

深度学习经典论文——LSTM

LSTM 的全称是长短期记忆网络(Long-Short Term Memory),是具有长期记忆能力的一种时间递归神经网络 (Recurrent Neural Network),其网络结构含有一个或多个具有遗忘和记忆功能的单元。由于独特的设计结构,LSTM 适合于处理和预测时间序列中间隔和延迟非常长的重要事件。

该论文首次发表于 1997 年。由德国慕尼黑工业大学的计算机科学家 Sepp Hochreiter 与 Jürgen Schmidhuber(现任瑞士 Dalle Molle 人工智能研究所的联合主任)共同完成。

论文链接:http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.676.4320&rep=rep1&type=pdf

在提出时,LSTM 被用于解决传统 RNN 在随时间反向传播中权重消失的问题(vanishing gradient problem over backpropagation-through-time),重要组成部分包括 Forget Gate、Input Gate 和 Output Gate, 分别负责决定当前输入是否被采纳,是否被长期记忆以及决定在记忆中的输入是否在当前被输出。

LSTM 网络由重复结构的 LSTM 单元组成,与 RNN 不同之处在于,重复的单元有四层特殊的结构(RNN 只有一层)。

LSTM 论文中的简单模型示意图(8 个输入单元、4 个输出单元和两个存储单元),被视为深度学习领域的经典。

LSTM 的表现通常比时间递归神经网络及隐马尔科夫模型(HMM)更好,比如用在不分段连续手写识别上。2009 年,用 LSTM 构建的人工神经网络模型赢得过 ICDAR 手写识别比赛冠军。LSTM 还普遍用于自主语音识别,2013 年运用 TIMIT 自然演讲数据库达成 17.7% 错误率的纪录。作为非线性模型,LSTM 可作为复杂的非线性单元用于构造更大型深度神经网络。

21 世纪 DL 最高被引论文

时间进入 21 世纪,人工智能/深度学习领域再次兴起。在新的阶段,有三篇经典论文被人们引用的数量远超其他。

有趣的是,它们都是有关神经网络在大规模图像数据集 ImageNet 之中的应用,这在一个侧面说明了计算机视觉方向的火热程度。其中一篇论文介绍了一种快速的、基于 CUDA 的深度卷积神经网络——它就是 AlexNet,这一方法赢得了 2012 年的 ImageNet 竞赛。另一篇论文则是 ImageNet 2014 年冠军的获得者:

- A Krizhevsky、I Sutskever, GE Hinton《Imagenet classification with deep convolutional neural networks》NeuerIPS 2012 (被引次数 53,000)

- B. K Simonyan、A Zisserman《Very deep convolutional networks for large-scale image recognition》arXiv:1409.1556, 2014 (被引次数 32,000)

年度被引次数最多的论文,当然是网络更深、性能更强大的 ResNet——《Deep Residual Learning for Image Recognition》,这一方法赢得了 ImageNet 2015、以及 COCO 竞赛的冠军,也获得了 CVPR2016 的最佳论文奖:该研究的作者是何恺明、张祥雨、任少卿和孙剑(被引次数 36,000;其中仅在 2019 年就增长了 18,000 余次)。

孙剑等人提出的「深度残差网络 ResNet」和「基于区域卷积神经网络的快速物体检测 FasterRCNN」等技术目前被学术和工业界广泛采用,对深度学习的基础研究具有里程碑式的意义。这些研究的思路也被应用在了计算机视觉之外:ResNet 的思想也启发了 DeepMind 的 AI 围棋程序 AlphaGo Zero,并已被应用到了机器翻译、语音合成语音识别等不同领域。

ResNet 现在甚至也成为了深度学习硬件衡量算力的 Benchmark 标准。参与这一研究的四名中国学者如今也都广为被人们所知,当时他们均任职于微软亚洲研究院视觉计算组。

值得注意的是,这些「屡次打破记录的 GPU 加速卷积神经网络」也可以追溯到 Schmidhuber 及其弟子们的研究。AlexNet 的作者 Krizhevsky 在其论文里引用了 DanNet,后者是第一个充分利用 CUDA,并在图像识别挑战上超越人类水平(2011 年)的卷积神经网络。DanNet 在 2011 年的 ICDAR 中文手写内容识别竞赛、IJCNN 2011 交通信号识别竞赛、ISBI 2012 图像分割竞赛以及 ICPR 2012 医疗影像识别竞赛中获得了冠军。

作为目前卷积神经网络中最著名的一种,ResNet 比 DanNet 和 AlexNet 更深入,前者引用了 Srivastava 等人在 2015 提出的 Highway Net(也是 Schmidhuber 等人的研究),这是个特例。从某种意义上讲,这形成了 LSTM 的闭环,因为「Highway Net 在本质上是 LSTM 网络的前馈版本」。

大多数 LSTM 的引用都是参考的 1997 年的这篇 LSTM 论文,但 Schmidhuber 在 Annus Mirabilis 发表的一篇文章指出,LSTM 的基本观点可以追溯到 Seep Hochreiter 在 1991 年的毕业论文,他认为那篇论文是「机器学习研究史上最重要的文献之一」。而且他还向其他学生表示感谢:「LSTM 及其训练程序的改进,都需归功于 Felix Gers、Alex Graves 以及其他我的学生们的贡献。」

LSTM 的原理对于循环网络和前馈网络都是必不可少的,如今它存在于每一部智能手机上,还存在于 DeepMind 在星际争霸以及 OpenAI 在 Dota 这些游戏中取得的冠军中,以及大量 AI 相关应用中。

不过,LSTM 被人们「再次重视」或许也只是一时的现象。在 Reddit 上有网友指出,最近基于 Transformer 的方法正在逐渐升温。