TedDunning在

《AccurateMethodsfortheStatisticsofSurpriseandCoincidence》中介绍了

Log−LikehoodRatio在文本计算中的基本使用。

LLR因为实现简单、有效并且具有大规模数据上的可扩展性,能够被很好的使用到工业系统中。因此基于

LLR的相似度度量广泛应用在推荐系统等多种应用当中。

在这篇Blog中,我们忽略

《AccurateMethodsfortheStatisticsofSurpriseandCoincidence》中对

LLR过多的冗余描述,主要集中的去关注

LLR的计算方式和现有的一些简单有效的代码实现。

本篇博客的组织方式如下。在章节1中,以最简单的方式讨论了

Log−LikelihoodRatio相似度的计算方式,在章节2中讨论了

Log−LikelihoodRatio的具体的代码实现,以及一些可以现用的相似度计算工具。

1. LLR的计算方式

在计算两个事件(例如推荐系统中的点击行为)的

LLR值来做相似度衡量的时候,我们通过两个事件的计数来计算事件之间的相似度。接下来我们以推荐系统中物品相似度的计算为例来介绍

LLR的计算方式。

有两个物品分别为物品

i和物品

j。对应事件计数的简单形式化描述如下:

k11:表示同时浏览了物品

i和物品

j的用户。

k12:表示浏览了物品

i,但是没有浏览物品

j的用户。

k21:表示浏览了物品

j,但是没有浏览物品

i的用户。

k22:表示没有浏览物品

i,并且没有浏览物品

j的用户。

根据上述,我们可以得到如下的一个表格:

| 事件 |

浏览

Itemi |

没有浏览

Itemi |

| 浏览

Itemj |

k11 |

k21 |

| 没有浏览

Itemj |

k12 |

k22 |

Itemi和

Itemj的

LLR计算公式如下:

S=2×(Hm−Hc−Hr)

其中:

Hm表示上述矩阵的矩阵熵,总体的计算公式如下:

Hm=−(Nk11log(Nk11)+Nk12log(Nk12)+Nk21log(Nk21)+Nk22log(Nk22))

Hr表示每行相加计算得到的信息熵,相关的具体计算公式如下:

Hr=−(Nk11+k12log(Nk11+k12)+Nk21+k22log(Nk21+k22))

Hc表示矩阵的每一列相加计算得到的信息熵,相关的具体计算公式如下:

Hc=−(Nk11+k21log(Nk11+k21)+Nk21+k22log(Nk21+k22))

其中

N=k11+k12+k21+k22

2. LLR的代码实现

在

Mahout的

math库中定义了

LogLikelihood类,实现了

LLR的计算,其中具体的计算代码在下面给出。

-

rowEntropy的计算方式如下

private static double xLogX(long x) {

return x == 0 ? 0.0 : x * Math.log(x);

}

private static double entropy(long a, long b) {

return xLogX(a + b) - xLogX(a) - xLogX(b);

}

其中

a=k11+k12并且

b=k21+k22,综合得到

rowEntropy=(N×log(N)−(k11+k12)×log(k11+k12)−(k21+k22)×log(k21+k22))=−((k11+k12)×log(N)−(k11+k12)×log(k11+k12)+(k21+k22)×log(N)−(k21+k22)×log(k21+k22))=−((k11+k12)×(log(N)−log(k11+k12))+(k21+k22)×(log(N)−log(k21+k22)))=(k11+k12)×(logNk11+k12)+(k21+k22)×(logNk21+k22)=−Hr×N

- 同样的

colEntropy的计算方式如下:

colEntropy=(k11+k21)×(logNk11+k21)+(k12+k22)×(logNk12+k22)=−Hc×N

-

matrixEntropy的计算方式

private static double entropy(long a, long b, long c, long d) {

return xLogX(a + b + c + d) - xLogX(a) - xLogX(b) - xLogX(c) - xLogX(d);

}

matrixEntropy=N×log(N)−k11log(k11)−k12log(k12)−k21log(k21)−k22log(k22)=−(k11×log(Nk11)+k12×log(Nk12)+k21×log(Nk21))+k21×log(Nk21))×N

public static double logLikelihoodRatio(long k11, long k12, long k21, long k22) {

Preconditions.checkArgument(k11 >= 0 && k12 >= 0 && k21 >= 0 && k22 >= 0);

double rowEntropy = entropy(k11 + k12, k21 + k22);

double columnEntropy = entropy(k11 + k21, k12 + k22);

double matrixEntropy = entropy(k11, k12, k21, k22);

if (rowEntropy + columnEntropy < matrixEntropy) {

return 0.0;

}

return 2.0 * (rowEntropy + columnEntropy - matrixEntropy);

}

S=2×(rowEntropy+colEntropy−matrixEntropy)=2×(−NHr−NHc+NHm)=N2(Hm−Hr−Hc)

在代码实现里面相似度的计算过程中把

N约掉了,所以在

mahout计算当中实际计算得到的值为

S=N2(Hm−Hr−Hc)

3 相关疑问

问题 1: 在代码的计算过程中,约掉分母

N对整个结果有影响嘛?

问题 2: 在有些博客资料中称

Hr为行熵,称

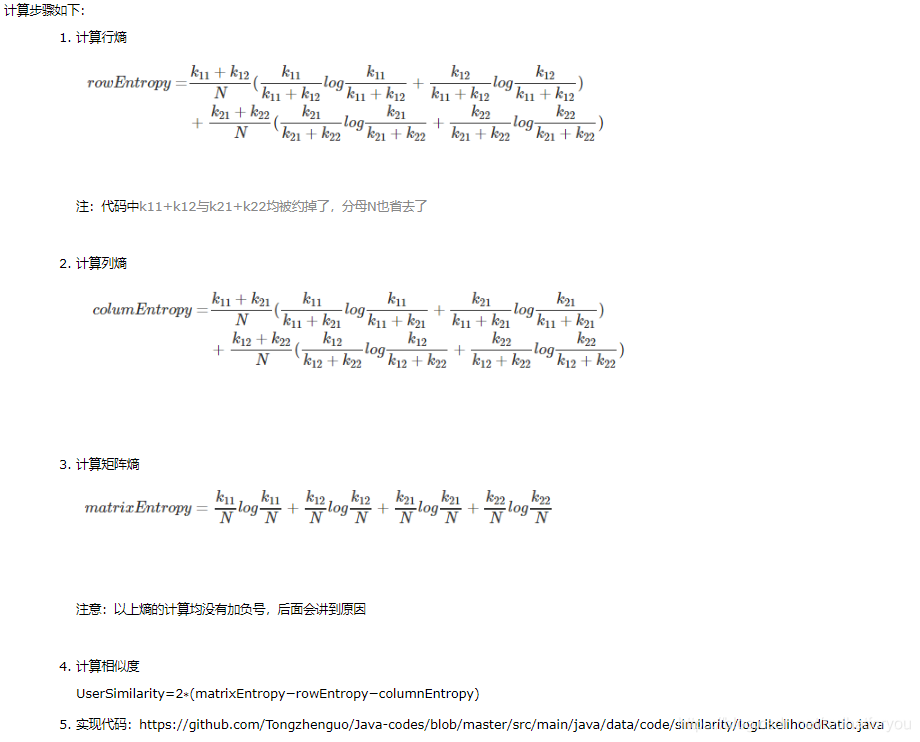

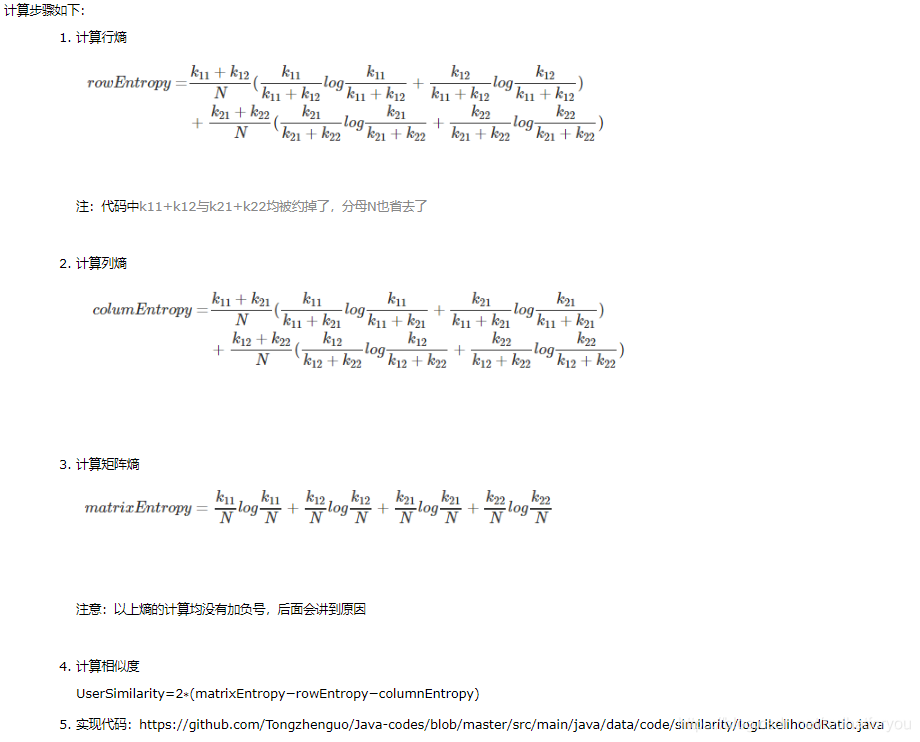

Hc为列熵,并且计算公式不如下:

这种方式和我上面描述的计算方式等价嘛?那种更准确?

欢迎大家留言讨论,如果有问题或者建议的地方希望大家能够提出再核对问题后我会在第一时间进行修正。

4 参考资料

【1】LLR (Log-Likelihood Ratio) used for recommendations

【2】Accurate Methods for the Statistics of Surprise and Coincidence

【3】Building a Correlated Cross-Occurrence (CCO) Recommenders with the Mahout CLI

【4】github · Mathout LogLikelihood Similarity

【5】Surprise and Coincidence

【6】loglikelihood ratio 相似度