一、前言

最近一周,集中时间看了部分经典卷积神经分类网络和目标检测网络的相关论文,结合自己的理解做如下的综述报告,本系列博客为目标检测论文综述,根据内容分为四个部分:

1、深度卷积神经网络

2、CNN based Two-Stage Detectors

3、CNN based One-Stage Detectors

4、基于Anchor-Free的目标检测方法

所有论文综述均保持如下格式:

1、一页PPT内容总结一篇论文

2、标题格式一致:出处 年份 《标题》

3、内容格式一致:针对XX问题;提出了XX方法;本文证明了XXX

4、把握核心创新点,言简意赅

二、深度卷积神经网络

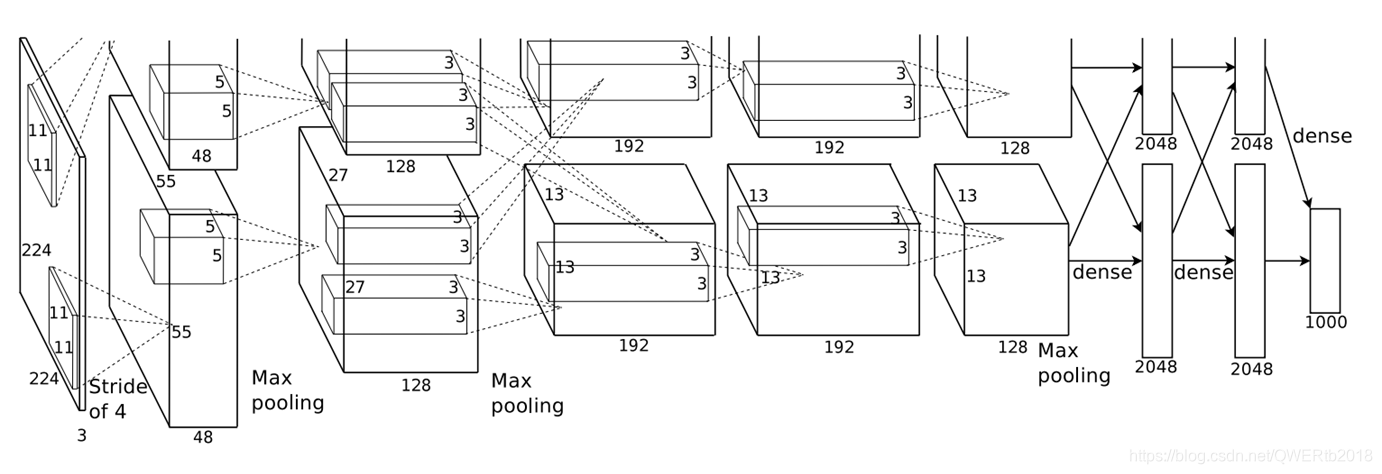

一、ILSVRC 2012《AlexNet:ImageNet Classification with Deep Convolutional Neural Networks》

- 针对:LeNet卷积层深度不够,准确度低

- 提出了:1.使用ReLu;2.Local Response Normalization局部响应归一化;3.数据增强+Dropout(防止过拟合);4.GPU加速网络训练;5.使用最大池化避免平均池化的模糊效果

该网络为常规的5卷积层(3 max-pooling)+3全连接层结构 - 本文证明了:ReLu解决了Sigmoid在网络较深时的梯度弥散问题;LRN对响应较大的值变得更大,并抑制反馈小的神经元,增强模型泛化能力

二、ILSVRC 2014《VGG:Very Deep Convolutional Networks for Large-Scale Image Recognition》

- 针对:卷积神经网络的深度不够

- 提出了:6种结构的VGG网络(A、A-LRN、B、C、D、E),全部使用3×3卷积核和2×2最大池化,不断加深网络结构来提升性能;测试阶段全连接层转卷积,可接受任意大小输入

两个连续3×3卷积相当于5×5的感受野,三个连续相当于7×7,优势在于:1、包含三个ReLu层,使决策函数更有判别性;2、减少参数量 - 本文证明了:通过加深网络能有效提高性能;堆积的小卷积核替代大的卷积核,能增加决策函数判别性和减少参数量;A-LRN结构说明LRN层无性能增益(与AlexNet相比)

三、ILSVRC 2014《GoogleNet: Going deeper with Convolutions》inceptionv1结构

- 针对:增加网络的规模面临两个问题:1.网络参数增加,容易出现过拟合;2.计算量增加

- 提出了:Inception机制,在多个不同尺寸卷积核上进行卷积后再聚合,并使用1×1卷积降维减少参数数量;全局平均池化代替全连接层,减少参数量(借鉴Network in Network)

Inceptionv2:学习VGG,用2个3×3卷积代替inception模块中5×5大卷积,降低参数量,加快计算速度;提出Batch Normalization正则化,对每一mini-batch数据内部进行标准化,使其输出规范到(0,1)正态分布

Inceptionv3:1.卷积核分解,将7×7的卷积核分解为两个一维的卷积(1×7,7×1)减少参数,增加网络深度;2.提出RMSProp参数优化方法

Inceptionv4:相较于v3版本,增加inception模块数量;结合残差神经网络 - 本文证明了:通过加深网络深度和宽度都能有效提升性能

补充《Network in Network》

两个主要贡献是:1、MLP卷积层代替传统卷积层,相当于在激活函数后面,再添加两个1*1卷积层**(降维)**降低了计算复杂度;2.Global Average Pooling代替全连接层,减少参数量,降低网络复杂度和防止过拟合

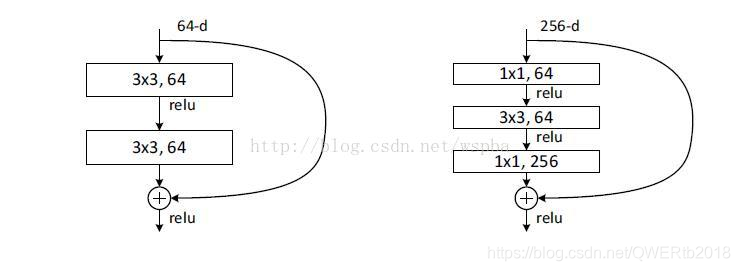

四、ILSVRC 2015《ResNet: Deep Residual Learning for Image Recognition》

- 针对:网络加深,训练集准确率下降,退化问题

- 提出了:残差神经网络,引入能跳过一层或多层的跨层连接(shortcut connection)和拟合残差项解决深层网络难以训练的问题

两种ResNet结构设计,分别针对ResNet34(左)和ResNet50/101/152(右),右图“bottleneck design”目的降低参数数目 - 本文证明了:ResNet解决了网络模型的退化问题,允许神经网络更深

深度卷积神经网络的发展非常迅速,后续的ResNeXt、DenseNet、MobileNet等都在前面这几种经典网络基础上做了相应改进,取得不错成绩。

三、深度神经网络的一些优化策略

针对上述深度卷积网络的总结,可以参考以下方面对网络进行优化改进:

1、卷积层:卷积核小型化、1×1卷积、Inception机制、卷积分解,作用不外乎减少参数量,降低网络复杂度和防止过拟合

2、池化层:全局平均池化、最大池化,还有一些网络中提及的混合池化、随机池化等

3、激活函数:传统的sigmoid,tanh函数,目前主流的有ReLU以及它的改进型

4、网络结构:网络拓扑结构以及卷积层改变,连接关系改进如ResNet和DenseNet等,以及全连接层替换为卷积层的全卷积网络结构

5、优化算法:除了随机梯度下降法外,还有AdaGrad、RMSProp等

6、归一化技术:如Inceptionv2提及的Batch Normalization,对输入数据进行批量归一化,可加速神经网络的训练过程

说明:

1.博客内容只是总结每篇论文的主要创新点,针对什么问题,提出了什么方法,没有翻译论文,也没有详细阐述论文中提出的网络结构,实验方法。原因在于:网上有很多关于各种论文的详细翻译、理解,但读者很难集中时间去消化理解每一篇论文内容,往往都是看完一篇过几天就忘记了,所以本文采用这种总结方式,简洁明了,使其对深度卷积神经网络有一整体的认识。

2.以上内容均基于本人看论文的理解,可能在某些总结上存在错误或者理解不够,恳请大家能在留言提出来,我会及时修改,我希望通过写博客的方式,加深对论文的理解,并期望得到提高,谢谢大家!