编写初衷

如果只是普通的1对1的SSH免密登录还好办,手动设置一次也就ok了,但是试想一下,如果是在集群环境下呢?多了不说,3台主机间的SSH免密操作想想都麻烦吧.

有人说,不怕麻烦,ok,手动也可以,就是花点儿时间,而且通常情况下配置一次就ok了,下次即使是节点关机,重启,等操作后也不用再做任何操作.

但是,如果你跟我一样用的是docker搭建的集群…会让你想想就觉得累…为什么要用Docker?

答:因为资金有限,使用的腾讯云服务器,1核2G,配置低,跑不起虚拟机,而鉴于此特性我们的容器大多是用完了就要关闭的,至少是定期内就要关闭一次的.但令人头疼的是,Docker容器每次重启你都需要重新配置一番,因为/etc/hosts文件中的内容是容器启动时都会重置的.

这时,如果我们写一个能够实现自动化配置SSH免密登录的脚本,并将它打包进Docker Image,那么以后只需要在启动容器后,让每个容器都执行脚本既可.

脚本编写

(1)集群规划:

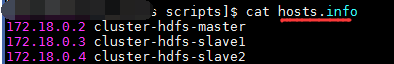

三台主机的ip及hostname映射关系:

172.18.0.2 cluster-hdfs-master

172.18.0.3 cluster-hdfs-slave1

172.18.0.4 cluster-hdfs-slave2

(2)事前准备:

- 准备一个配置完毕,已经可以成功启动hdfs+yarn的docker image.不会做的同学可以参考我的另外一篇博客

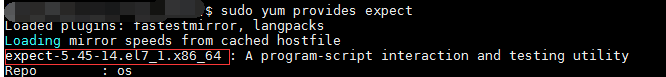

- 脚本中需要用到

expect命令,所以请先安装expect,具体安装包信息可以用下面的命令来查看:

# 先看一下expect所需要安装的包

sudo yum provides expect

# 或者直接安装

sudo yum install -y expect

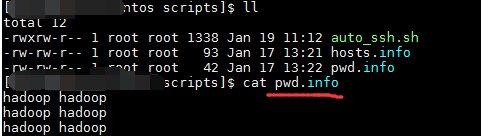

3. 准备三个文件

①将所有节点下,要实现ssh的用户名和密码写入其中.e.g pwd.info

②将集群主机的ip和hostname映射写入其中.e.g hosts.info

注:pwd.info与hosts.info中的行与行对应

③auto_ssh.sh脚本,在此文件中编写脚本,实现自动配置/etc/hosts信息,并实现自动ssh免密

(3)开始编写脚本:

auto_ssh.sh内容如下:

#!/bin/bash

# Program:

# to realize automic ssh connection among the cluster

# 2020/01/16 Shuu First release

function gen-ssh() {

/usr/bin/expect <<EOF

spawn ssh-keygen -t rsa

expect {

"Enter file in which to save the key*" {send "\r";exp_continue}

"Enter passphrase*" {send "\r";exp_continue}

"Enter same passphrase again*" {send "\r"}

}

expect eof

EOF

}

function copy-ssh-id() {

username=$1

host_name=$2

/usr/bin/expect <<EOF

spawn ssh-copy-id -i /home/hadoop/.ssh/id_rsa.pub $username@$host_name

expect {

"yes/no" {send "yes\r";exp_continue}

"password" {send "$password\r"}

}

expect eof

EOF

}

# if there is no id_rsa.pub file, then run the do-shh func.

[ ! -f /home/hadoop/.ssh/id_rsa.pub ] && gen-ssh

# set the hosts's info

sudo awk '{print $1 "\t" $2 >> "/etc/hosts"}' /home/hadoop/scripts/hosts.info

# read the hosts's info and the corresponding username & passwd

# then copy the ssh pub key to all nodes among the cluster

paste -d " " /home/hadoop/scripts/hosts.info /home/hadoop/scripts/pwd.info | while read line

do

#ip=`echo $line | cut -d " " -f1`

host_name=`echo $line | cut -d " " -f2`

username=`echo $line | cut -d " " -f3`

password=`echo $line | cut -d " " -f4`

copy-ssh-id $username $host_name

done

(4)基于以上修改,制作一个新的docker镜像:

sudo docker commit -m "add auto_ssh.sh" centos-base centos:hdfs-cluster-v02

(5)集群容器的启动,及auto_ssh.sh脚本的执行:

这里由于会频繁操作,所以我们在宿主机也准备一个脚本文件,用来群启docker containers.

由于我的环境变量都是特意写在hadoop用户下的~/.bash_profile文件中,所以只有此用户才可以直接运行相关的命令,因此下面的命令调用切换了用户,如果没有此要求的话,可以自行修改.

run_cluster_containers.sh内容如下:

#!/bin/bash

# Program:

# run the docker containers and call the auto_ssh.sh

# 2020/01/16 Shuu First release

# start the 3 containers

# NameNode 50070 hdfs 9000

sudo docker run -p 9000:9000 -p 50070:50070 --name master --privileged -id -h cluster-hdfs-master \

centos:hdfs-cluster-v02 /usr/sbin/init

# Resource Manager 8088

sudo docker run -p 8088:8088 --name slave1 --privileged -d -h cluster-hdfs-slave1 \

centos:hdfs-cluster-v02 /usr/sbin/init

# Secondary NameNode 50090

sudo docker run -p 50090:50090 --name slave2 --privileged -d -h cluster-hdfs-slave2 \

centos:hdfs-cluster-v02 /usr/sbin/init

# run auto_ssh.sh in each docker container

sudo docker exec master /bin/bash -c "su - hadoop -c 'cd ~/scripts && ./auto_ssh.sh'"

sudo docker exec slave1 /bin/bash -c "su - hadoop -c 'cd ~/scripts && ./auto_ssh.sh'"

sudo docker exec slave2 /bin/bash -c "su - hadoop -c 'cd ~/scripts && ./auto_ssh.sh'"

(6)格式化namenode,启动hdfs,yarn.

一般而言,我们都是通过eclipse,idea等IDE来连接我们的hadoop集群,进行相关开发工作的,当然也有需要ssh到某个节点进行操作的时候,但是毕竟我们不会每次都开多个终端窗口,连接到相关的容器,进行资源或服务去启动.这样实在是太麻烦了,所以,我们可以再写一个脚本,实现在宿主机即可以达到启动集群的目的,这样集群启动之后我们就可以在外面进行操作了.

start_dfs.sh内容如下:

#!/bin/bash

# program:

# to start the hdfs and yarn in corresponding container

# 2020/01/16 Shuu First release

# format the namenode

sudo docker exec master /bin/bash -c "su - hadoop -c 'hdfs namenode -format'"

# start hdfs

sudo docker exec master /bin/bash -c "su - hadoop -c 'start-dfs.sh'"

# start yarn

sudo docker exec slave1 /bin/bash -c "su - hadoop -c 'start-yarn.sh'"

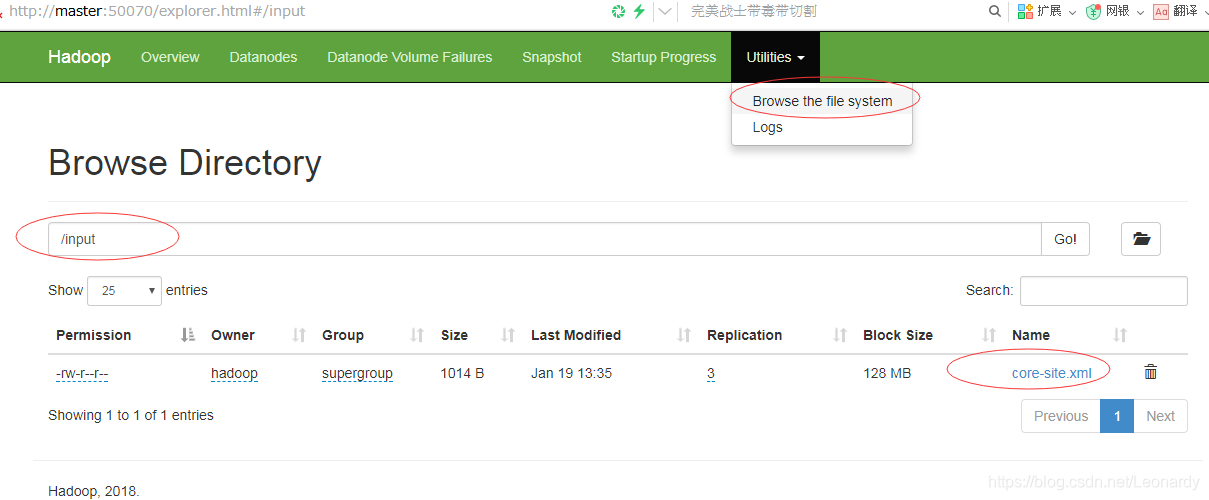

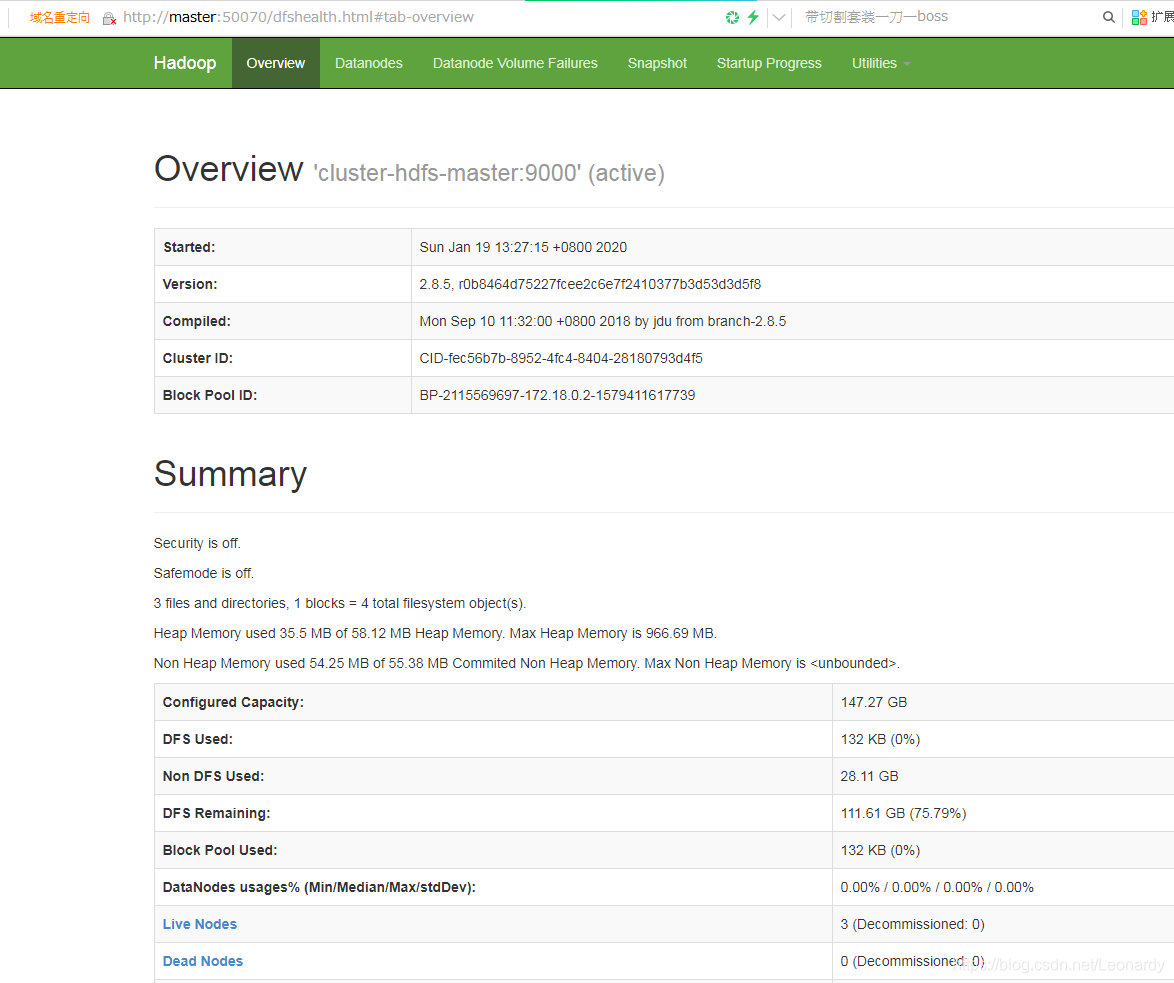

(7)验证容器是否启动成功:

一般而言我们开发用的都是windows端,可以将服务器的ip添加至C:\Windows\System32\drivers\etc\hosts文件中.

然后通过web访问即可,如果用的是云服务器,记得在安全组中把50070端口开放

在hdfs中,创建一个目录/input,并将$HADOOP_HOME/conf/hadoop/core-site.xml拷贝到此目录下.

sudo docker exec master /bin/bash -c "su - hadoop -c 'cd /opt/softwares/hadoop/ \

&& hdfs dfs -mkdir /input && hdfs dfs -put etc/hadoop/core-site.xml /input'"

带命令执行完毕后,到浏览器去看看状态吧,ok,大功告成了!