文章目录

安装节点要求:

1.安装Kafka分布式集群

1.1上传安装包

put c:/kafka_2.11-1.1.1.tgz

1.2解压

tar -xzvf kafka_2.11-1.1.1.tgz -C /home/hadoop/apps/

1.3配置环境变量

vim ~/.bash_profile

按G跳到最后一行按O向下插入,保存退出

export KAFKA_HOME=/home/hadoop/apps/kafka

export PATH=$PATH:$KAFKA_HOME/bin

重新加载配置文件

source ~/.bash_profile

1.4配置server.properties文件

vim $KAFKA_HOME/config/server.properties

修改以下三个地方即可

broker.id=1 ## 当前kafka实例的id,必须为整数,一个集群中不可重复

log.dirs=/home/hadoop/data/kafka ## 生产到kafka中的数据存储的目录,目录需要手动创建

zookeeper.connect=hadoop01:2181,hadoo02:2181,hadoop03:2181/kafka ## kafka数据在zk中的存储目录

1.5同步到其他机器

发送kafka

scp -r kafka/ hadoop02:/home/hadoop/apps/

scp -r kafka/ hadoop03:/home/hadoop/apps/

发送配置文件

scp -r ~/.bash_profile hadoop02:~/.bash_profile

scp -r ~/.bash_profile hadoop03:~/.bash_profile

再给另外的机器重新加载一下

source ~/.bash_profile

1.6创建数据目录

给三台机器都创建一下数据目录

mkdir -p /home/hadoop/data/kafka

1.7启动kafka服务

注意:启动kafka之前要保证zookeeper已经开启

kafka-server-start.sh -daemon ~/apps/kafka/config/server.properties

可以用命令查看kafka进程是否启动

jps

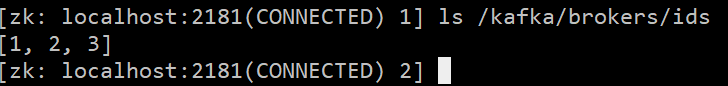

1.8验证

进入zookeeper的客户端

zkCli.sh

ls /kafka/brokers/ids

只要kafka的服务都在zookeeper中进行了注册,便说明kafka已经安装启动成功

2.Kafka的shell操作

2.1topic的curd操作

2.1.1创建topic

kafka-topics.sh --create \

--topic hadoop \

--zookeeper hadoop01:2181,hadoop02:2181,hadoop03:2181/kafka \

--partitions 3 \

--replication-factor 3

- topic指定要创建的topic的名称

- zookeeper指定kafka关联的zk地址

- partitions指定该topic的分区个数

- replication-factor指定副本因子

注意:指定副本因子的时候,不能大于broker实例个数,否则报错!

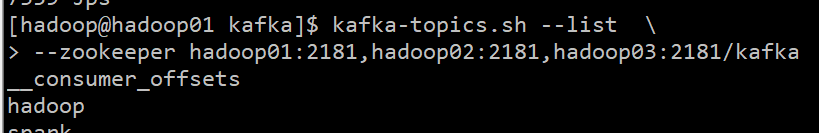

2.1.2查看topic的列表

kafka-topics.sh --list \

--zookeeper hadoop01:2181,hadoop02:2181,hadoop03:2181/kafka

2.1.3查看每一个topic的信息

kafka-topics.sh --describe --topic hadoop \

--zookeeper hadoop01:2181,hadoop02:2181,hadoop03:2181/kafka

- Partition当前topic对应的分区编号

- Leader该partition的所有副本中的leader领导者,处理所有kafka该partition读写请求

- Replicas副本因子,当前kafka对应的partition所在的broker实例的broker.id的列表

- Isr该partition的存活的副本对应的broker实例的broker.id的列表

2.1.4修改一个topic

kafka-topics.sh --alter --topic hadoop --partitions 4 --zookeeper hadoop01:2181/kafka

注意:partition个数,只能增加,不能减少

2.1.5删除一个topic

kafka-topics.sh --delete --topic test --zookeeper hadoop01:2181,hadoop02:2181,hadoop03:2181/kafka

删除之后可以查看一下列表

kafka-topics.sh --list test --zookeeper hadoop01:2181,hadoop02:2181,hadoop03:2181/kafka

可以发现topic hadoop 已经被删除

2.2生产数据

kafka-console-producer.sh \

--topic hadoop \

--broker-list hadoop01:9092,hadoop02:9092,hadoop03:9092

- topic指定数据被生产的topic

- broker-list指定kafka的broker列表

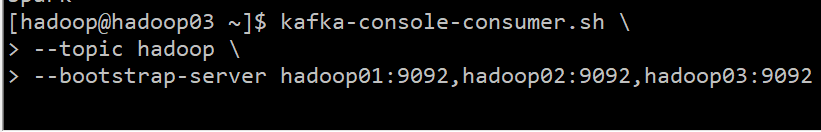

2.3消费数据

在另一台机器上

kafka-console-consumer.sh \

--topic hadoop \

--bootstrap-server hadoop01:9092,hadoop02:9092,hadoop03:9092

没数据,原因在于消费者后于生产者启动,在消费者启动之前生产者消费的数据变不能直接获取,如果想要获取消费者启动之前生产者生产的数据,可以添加一个参数–from-beginning

kafka-console-consumer.sh \

--topic hadoop \

--bootstrap-server hadoop01:9092,hadoop02:9092,hadoop03:9092 --from-beginning

3.总结

kafka消费者在消费数据的时候,都是分组别的。不同组的消费不受影响,相同组内的消费,需要注意,如果partition有3个,消费者有3个,那么便是每一个消费者消费其中一个partition对应的数据;如果有2个消费者,此时一个消费者消费其中一个partition数据,另一个消费者消费2个partition的数据。如果有超过3个的消费者,同一时间只能最多有3个消费者能消费得到数据。

kafka-console-consumer.sh --topic hadoop \

--bootstrap-server hadoop01:9092,hadoop02:9092,hadoop03:9092 \

--group haha \

--offset earliest \

--partition 2

- group消费者对应的消费者组

- offset从什么位置(消息的偏移量)开始消费

- partition消费哪一个分区中的数据

offset是kafka的topic中的partition中的每一条消息的标识,如何区分该条消息在kafka对应的partition的位置,就是用该偏移量。offset的数据类型是Long,8个字节长度。offset在分区内是有序的,分区间是不一定有序。如果想要kafka中的数据全局有序,就只能让partition个数为1。

在组内,kafka的topic的partition个数,代表了kafka的topic的并行度,同一时间最多可以有多个线程来消费topic的数据,所以如果要想提高kafka的topic的消费能力,应该增大partition的个数