一、基于jym构建环境

1、物理引擎和环境引擎

仿真环境(仿真器)需要物理引擎和图像引擎。物理引擎模拟环境中物体运动规律,图像引擎显示环境中物体图像。

render()图像引擎 step()物理引擎2

2、强化学习定义

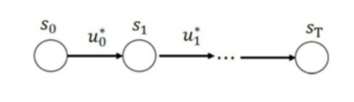

找到最优策略(决策序列)*使累计回报R(t)的期望最大:s

u*(s 状态 u 决策 )

*注:R(t)使随机变量无法进行优化,无法作为目标函数,采用累计回报期望

3、马尔科夫决策

把强化学习问题用马尔科夫决策的的框架表达并解决

马尔科夫性:当前状态蕴含所有历史状态(最优策略使每个状态价值最优)

马尔科夫过程:随机过程(随机状态序列)的每个状态都是马尔科夫的,表示为二元组(S,P)

S有效状态集合、状态转移概率

马氏决策:将动作和回报考虑在内的马尔科夫过程,表示为五元组(S,A,P,R,y)

状态集,动作集,转移概率,回报函数,回报累计折扣因子

5、强化学习概率学

依策略,当前状态s下采取动作a的概率为

状态值函数:累计回报在状态s时的期望

6、强化学习树

7、强化学习解决两个问题:

(1)预测:给定策略π, 求解该策略的状态价值函数v(π)。

(2)控制:求最优状态价值函数和策略。

8、对深度学习及强化学习的理解:

神经网络可以用来拟合函数,强化学习用交互数据来学习规则,深度学习用标定数据来学习规则。

二、思考:机器人控制方面,强化学习可以做什么,深度学习可以做什么?

1、17年爱丁堡大学开发一套深度强化学习分层框架,做机器人平衡控制策略

2、变阻抗控制

3、比传统控制器有更高效率的控制