Flume架构介绍和安装

写在前面

在学习一门新的技术之前,我们得知道了解这个东西有什么用?我们可以使用它来做些什么呢?简单来说,flume是大数据日志分析中不能缺少的一个组件,既可以使用在流处理中,也可以使用在数据的批处理中。

1.流处理:

2.离线批处理:

分析:不管你是数据的实时流处理,还是数据的离线批处理,都是会使用flume这个日志收集框架来做日志的收集。因此,学习这个这个组件是很重要的。这个组件的使用也是很简单的。

简单介绍一下Flume

Flume是一种分布式的、可靠的、可用的服务,用于高效地收集、聚合和移动大量日志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调的可靠性机制和许多故障转移和恢复机制,具有健壮性和容错性。它使用一个简单的可扩展的数据模型,允许联机分析应用程序。

一句话总结:Flume就是用来做日志收集的这么一个工具

Flume架构介绍

1) Source 收集 (从webserver读取数据到Channel中去)

2) Channel 聚集 (减少直接与磁盘的对接次数(生产环境中一般使用类型为Memory),当channel满了,再写到sink中去。同时,也起到了容错的作用,因为只有当sink接收到了数据,channel才会把原有的数据丢弃)

3) Sink 输出(从channel中读取数据,写到目的地,这里的目的地可以是HDFS、其余的一些文件系统或者作为下一个agent的source等)

顺便说一下

Event的概念

在整个数据的收集聚集传送的过程中,流动的是event,即事务保证是在event级别进行的。

那么什么是event呢?—–event将传输的数据进行封装,是flume传输数据的基本单位,如果是文本文件,通常是一行记录,event也是事务的基本单位。

event从source,流向channel,再到sink,本身为一个字节数组,并可携带headers(头信息)信息。event代表着一个数据的最小完整单元,从外部数据源来,向外部的目的地去。

为了方便大家理解,给出一张event的数据流向图:

上面这段引用来自大神“安静的技术控”的文章,因为我觉得大神已经解释得很到位了。很好理解,在这里,感谢大神啦

工欲善其事,必先利其器

因为有的小伙伴可能还没有安装flume组件,接下来我们就开始介绍一下flume的安装。

我这里提供了flume的压缩包百度云链接

链接:https://pan.baidu.com/s/1Cso3Bbo1JnoRdNboJuvpfQ

提取码:hod9

安装方式及其简单,解压及安装

安装。

1. 通过Xftp把.gz包上传到虚拟机

- tar zxvf apache-flume-1.8.0-bin.tar.gz

重命名:mv apache-flume-1.6.0-bin flume

打开 vi /etc/profile

- 配置flume环境变量量

添加#Flume

export FLUME_HOME=/usr/local/soft/flume

export PATH=.:$JAVA_HOME/bin:$FLUME_HOME/bin:$PATH

保存退出

运⾏source /etc/profile

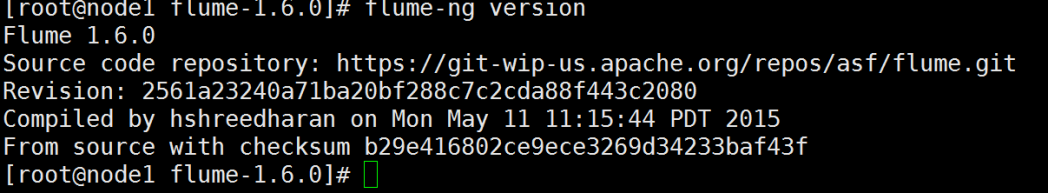

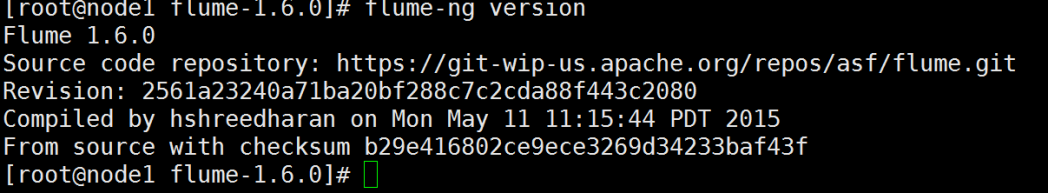

运⾏ flume-ng version 输出版本信息表示安装正确

安装完成,是不是及其简单。

写在前面

在学习一门新的技术之前,我们得知道了解这个东西有什么用?我们可以使用它来做些什么呢?简单来说,flume是大数据日志分析中不能缺少的一个组件,既可以使用在流处理中,也可以使用在数据的批处理中。

1.流处理:

2.离线批处理:

分析:不管你是数据的实时流处理,还是数据的离线批处理,都是会使用flume这个日志收集框架来做日志的收集。因此,学习这个这个组件是很重要的。这个组件的使用也是很简单的。

简单介绍一下Flume

Flume是一种分布式的、可靠的、可用的服务,用于高效地收集、聚合和移动大量日志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调的可靠性机制和许多故障转移和恢复机制,具有健壮性和容错性。它使用一个简单的可扩展的数据模型,允许联机分析应用程序。

一句话总结:Flume就是用来做日志收集的这么一个工具

Flume架构介绍

1) Source 收集 (从webserver读取数据到Channel中去)

2) Channel 聚集 (减少直接与磁盘的对接次数(生产环境中一般使用类型为Memory),当channel满了,再写到sink中去。同时,也起到了容错的作用,因为只有当sink接收到了数据,channel才会把原有的数据丢弃)

3) Sink 输出(从channel中读取数据,写到目的地,这里的目的地可以是HDFS、其余的一些文件系统或者作为下一个agent的source等)

顺便说一下

Event的概念

在整个数据的收集聚集传送的过程中,流动的是event,即事务保证是在event级别进行的。

那么什么是event呢?—–event将传输的数据进行封装,是flume传输数据的基本单位,如果是文本文件,通常是一行记录,event也是事务的基本单位。

event从source,流向channel,再到sink,本身为一个字节数组,并可携带headers(头信息)信息。event代表着一个数据的最小完整单元,从外部数据源来,向外部的目的地去。

为了方便大家理解,给出一张event的数据流向图:

上面这段引用来自大神“安静的技术控”的文章,因为我觉得大神已经解释得很到位了。很好理解,在这里,感谢大神啦

工欲善其事,必先利其器

因为有的小伙伴可能还没有安装flume组件,接下来我们就开始介绍一下flume的安装。

我这里提供了flume的压缩包百度云链接

链接:https://pan.baidu.com/s/1Cso3Bbo1JnoRdNboJuvpfQ

提取码:hod9

安装方式及其简单,解压及安装

安装。

1. 通过Xftp把.gz包上传到虚拟机

- tar zxvf apache-flume-1.8.0-bin.tar.gz

重命名:mv apache-flume-1.6.0-bin flume

打开 vi /etc/profile

- 配置flume环境变量量

添加#Flume

export FLUME_HOME=/usr/local/soft/flume

export PATH=.:$JAVA_HOME/bin:$FLUME_HOME/bin:$PATH

保存退出

运⾏source /etc/profile

运⾏ flume-ng version 输出版本信息表示安装正确

安装完成,是不是及其简单。