如果真的是小白,可以看博客 https://www.jianshu.com/p/c7e642877b0e 学习随机梯度下降法,然后再去学习随机梯度下降的变体的方法,极容易理解。

可能本人是真白(事实上我是长的真黑哈,不开玩笑的),后面对公式矩阵化时看不懂了,经过学习,在这重新以小白的方法解释一下

在这只是有预测函数的形式:$ h_{\theta }(x^{(i)})=\theta _{0}+\theta _{1}x_{1}^{(i)} $

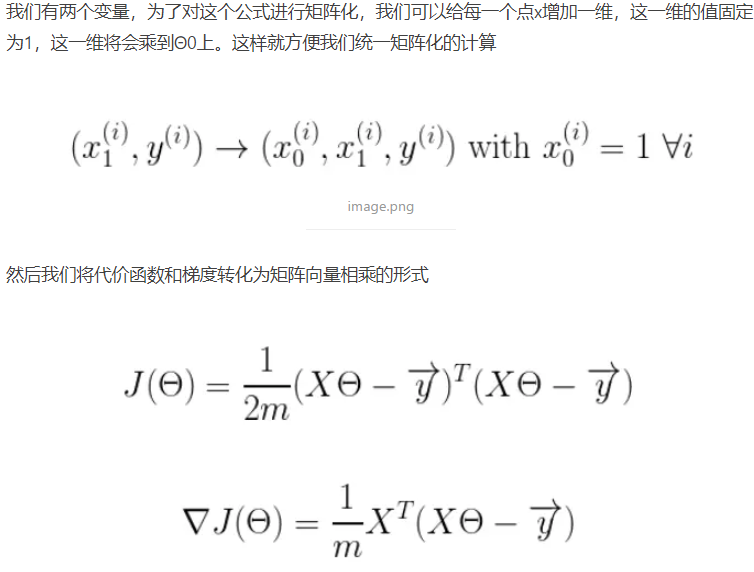

博主说:给每一个点x增加一维,这一维的值固定为1,这一维将会乘到$ \theta _{0} $。然后给出了上图第一个公式。

其实就是加一个$ x_{0}^{(i)} = 1 $,然后把它加到预测函数里(就是和$ \theta _{0} $相乘),等于给$ \theta _{0} $恒乘一个1,即$ h_{\theta }(x^{(i)})=\theta _{0}x_{0}^{(i)+\theta _{1}x_{1}^{(i)} $

把x组成一个向量:$ X = [x_{0}^{(i)},x_{1}^{(i)}]^{T} $,$\theta$也构成一个向量:$ \theta = [\theta _{0},\theta _{1}]^{T} $,然后$ \vec{y} $也是由两个y值组成的向量。这样就到了上图第二个公式。

至于最后一个公式,是因为把$ \theta $当成一个,则$ J(\theta ) = \frac{1}{2m}\sum_{i=1}^{m}(\theta X - y)^{2} $,然后对$\theta$求导即可的其梯度函数,即图中最后一个公式