版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

广义线性模型

普通最小二乘法(OLS)

模型各项接近线性关系时,会出现多重共线性的问题,有局限性

解决方法:前向逐步回归,惩罚线性回归

正则化

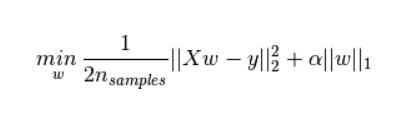

- L1正则化(Lasso回归):

在最小二乘法的最后加上 系数的L1范数,作为惩罚项

Lasso能够将一些作用比较小的特征的参数训练为0,从而获得稀疏解。也就是说用这种方法,在训练模型的过程中实现了降维(特征筛选)的目的。

Lasso是拟合稀疏系数的线性模型。 它在一些情况下是有用的,因为它倾向于使用具有较少参数值的情况,有效地减少给定解决方案所依赖变量的数量。 因此,Lasso 及其变体是压缩感知领域的基础。 在一定条件下,它可以恢复一组非零权重的精确集

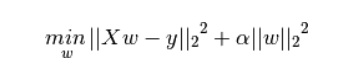

- L2正则化(岭回归):

在最小二乘法的最后加上 系数的L2范数,作为惩罚项

交叉验证

10折交叉验证

将数据集分成十份,轮流将其中9份做训练1份做验证

#3折交叉验证

reg = linear_model.RidgeCV(alphas=[0.1, 1.0, 10.0], cv=3)

reg.fit([[0, 0], [0, 0], [1, 1]], [0, .1, 1])

cross_val_score

运用cross_val_score进行交叉认证

函数在model_selection库里

# X:features y:targets cv:k折交叉验证

cross_val_score(model_name, X, y, cv=k)