前言:

环境介绍:此次部署系统为Cenots 7| MON、OSD |

10.110.180.112 |

Admin |

| MON、OSD |

10.110.180.113 |

Node1 |

| MON、OSD |

10.110.180.114 |

Node2 |

此部署过程是采用文件目录方式挂在激活OSD的方式部署Ceph集群。

1.系统关闭防火墙 关闭selinux

2.配置ntp 时间同步

配置普通用户 sudo 免密

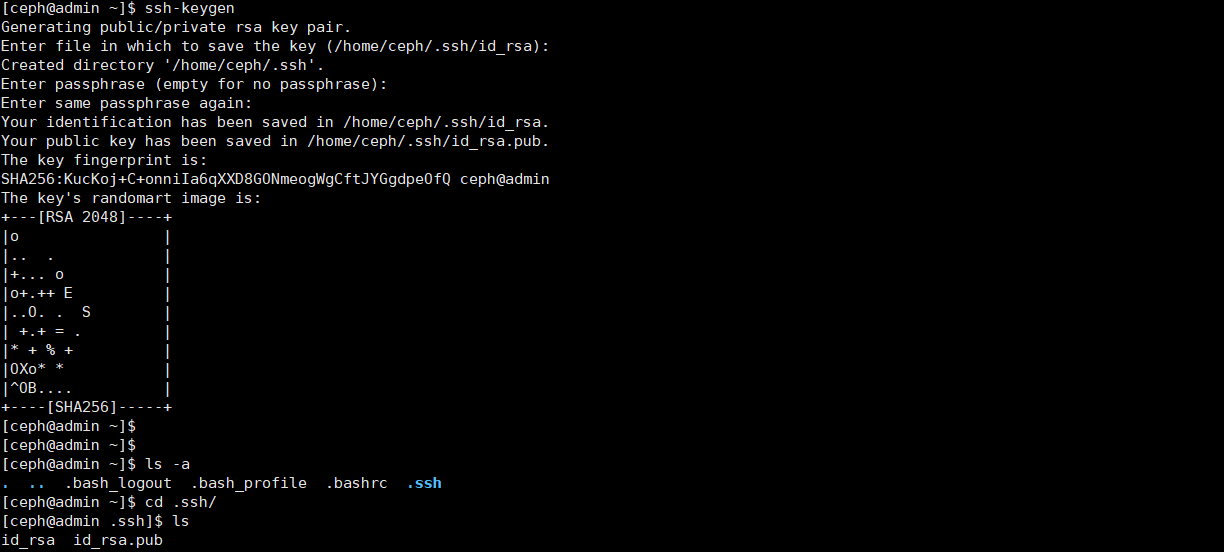

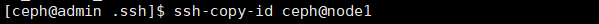

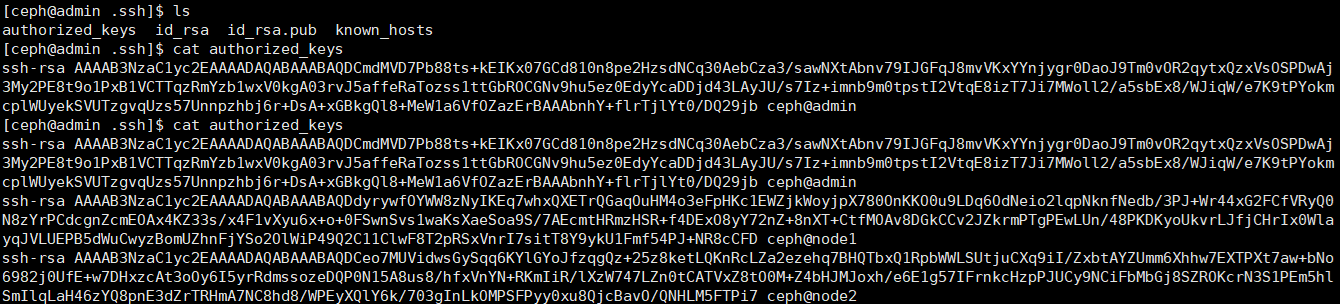

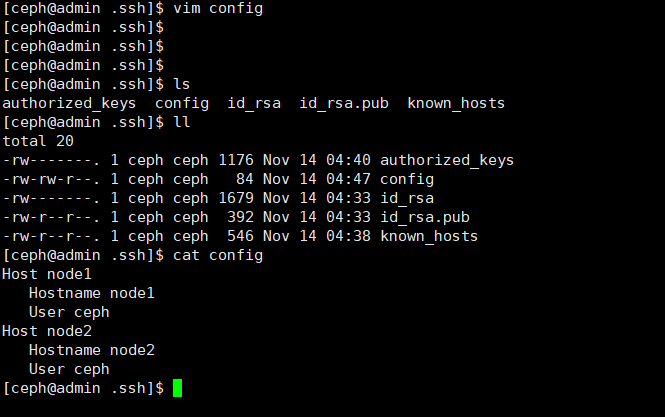

3.配置ssh 免密

4.配置ceph源

[ceph@ceph-admin my-cluster]$ cat -n /etc/yum.repos.d/ceph.repo

1 [Ceph-SRPMS]

2 name=Ceph SRPMS packages

3 baseurl=https://mirrors.aliyun.com/ceph/rpm-jewel/el7/SRPMS/

4 enabled=1

5 gpgcheck=0

6 type=rpm-md

7

8 [Ceph-aarch64]

9 name=Ceph aarch64 packages

10 baseurl=https://mirrors.aliyun.com/ceph/rpm-jewel/el7/aarch64/

11 enabled=1

12 gpgcheck=0

13 type=rpm-md

14

15 [Ceph-noarch]

16 name=Ceph noarch packages

17 baseurl=https://mirrors.aliyun.com/ceph/rpm-jewel/el7/noarch/

18 enabled=1

19 gpgcheck=0

20 type=rpm-md

21

22 [Ceph-x86_64]

23 name=Ceph x86_64 packages

24 baseurl=https://mirrors.aliyun.com/ceph/rpm-jewel/el7/x86_64/

25 enabled=1

26 gpgcheck=0

27 type=rpm-md

[ceph@ceph-admin my-cluster]$

5.更新源

yum makcache

yum update

5.1安装ceph 每个节点都安装 自动安装需要去ceph官方网站下载rpm包 狠慢很慢

Yum install -y ceph 目前国内阿里云和163等 镜像源 都是10.2的ceph

安装完成之后 查看 版本

ceph -v

5.2安装ceph-deploy 部署工具

yum install ceph-deploy

5.3在开始创建集群之前 在ceph 用户下创建文件夹 用户部署文件输出存放

mkdir my-cluster

cd my-cluster

6.部署新的节点

Ceph-deploy new ceph-admin ceph-node1 ceph-node2

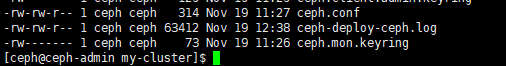

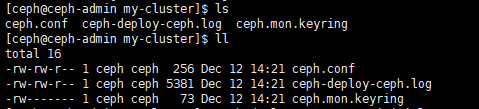

部署完成后 会在文件夹中 产生3个文件

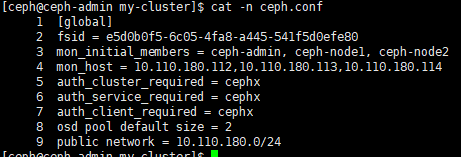

6.1修改ceph.config

6.2修改完成后 部署 mon

ceph-deploy --overwrite-conf mon create-initial

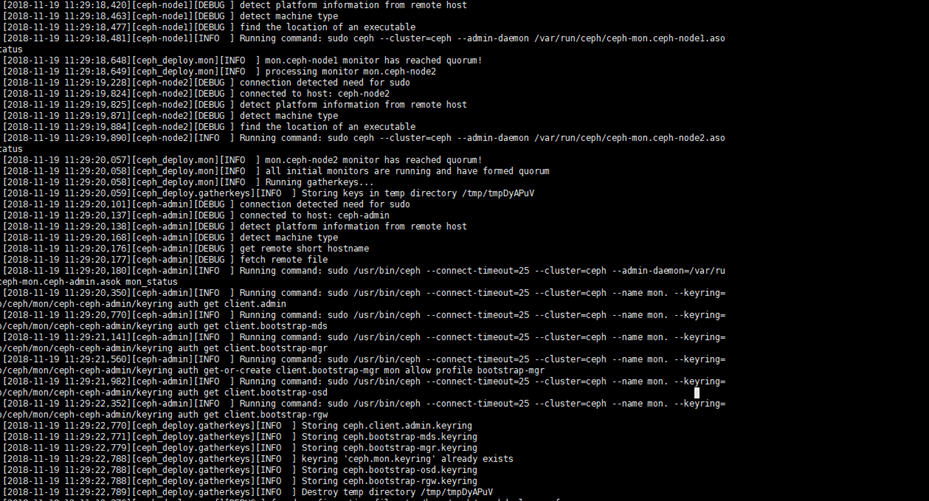

部署完成后会出现如下截图

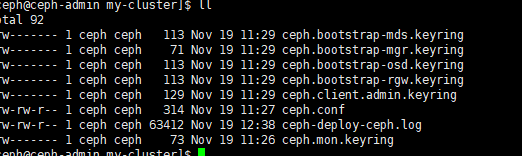

在文件目录下会产生keyring文件

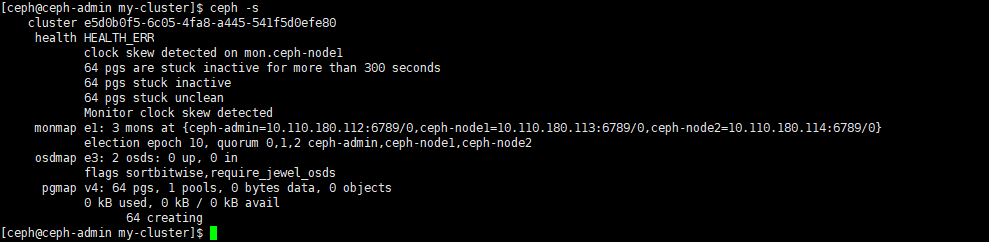

6.3查看ceph 集群状态

以上截图中已经部署了osd ,部署osd有些问题。osd可以是磁盘格式 也可以使文件目录形式,修改物理磁盘作为osd方式。改为目录文件部署osd。

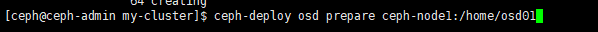

6.4创建两个文件目录

mkdir /home/osd01

给777 权限

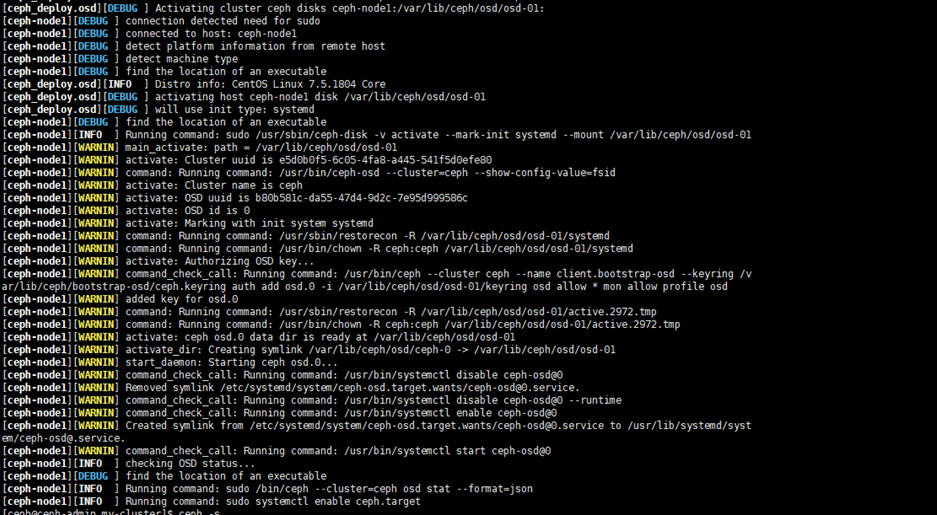

然后准备osd

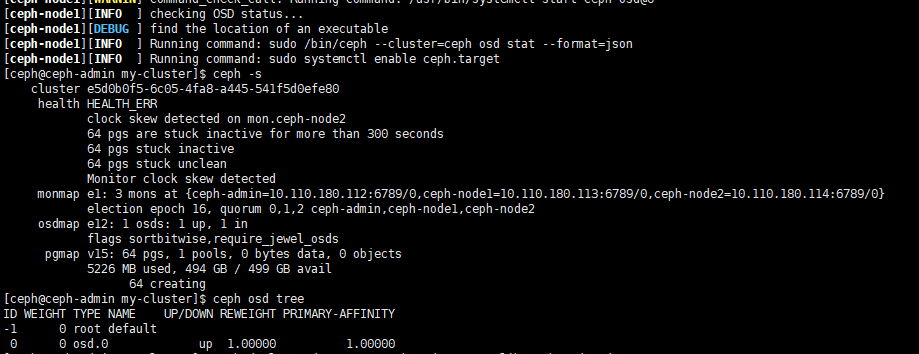

激活完成 ,当部署osd出现running状态时说明osd的状态已经部署完成处于运行状态。以同样的方式部署另外的服务即可。查看下状态目前还有ERR警告。

Ceph 部署 OSD挂在裸磁盘

此次部署方式为挂在服务器硬盘直接部署OSD。基础环境准备和前面的一样在此不赘述。

2018年12月12日

14:28

1. 创建新的集群 第一步

[ceph@ceph-admin my-cluster]$ ceph-deploy new ceph-admin ceph-node1 ceph-node2

执行完成后会生成配置文件

2.创建一个mon 第二步

[ceph@ceph-admin my-cluster]$ ceph-deploy mon create-initial

默认在上面的ceph.conf文件中包含了集群内的所有节点。执行此命令会创建所有节点的mon

3.部署过程部分截图:

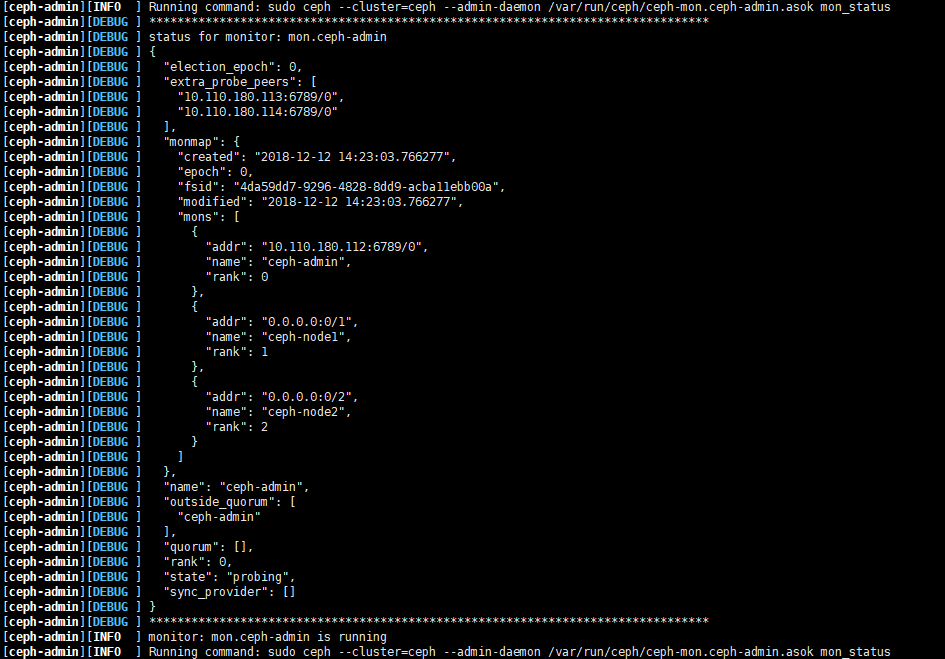

3.1Ceph-admin running

3.2Ceph-node1 running

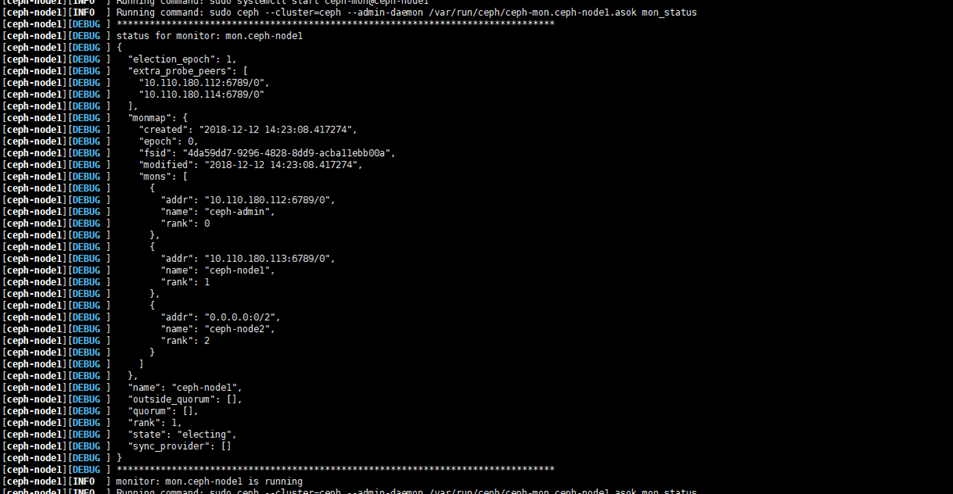

3.3Ceph-node2 running

3.4执行完成后会在目录下产生相关的key文件

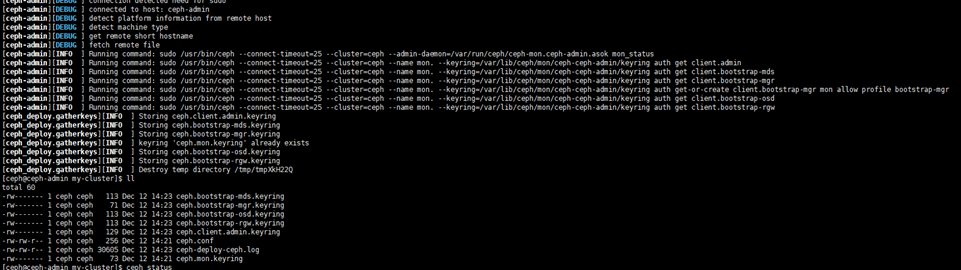

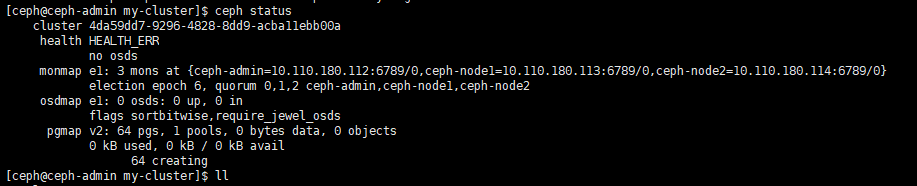

3.5查看集群状态

目前是err状态没问题 因为没有 osd

4.物理硬盘挂在OSD

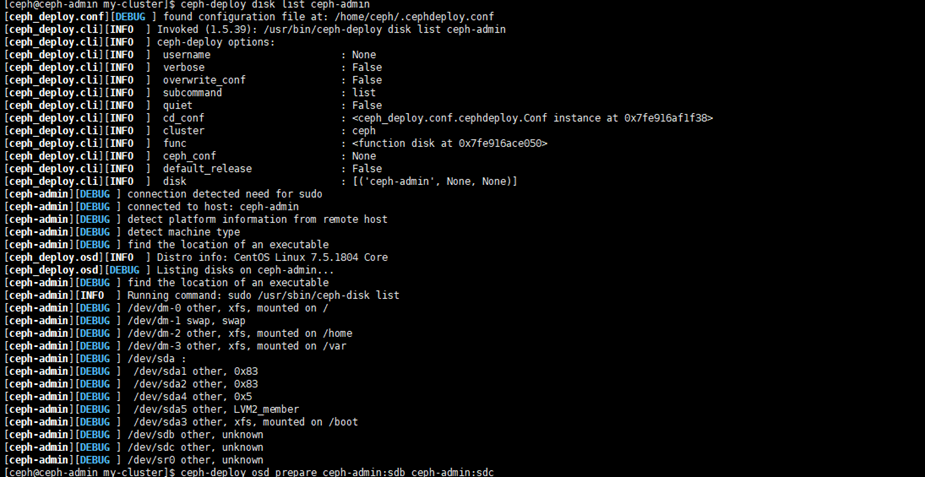

4.1ceph-deploy disk list ceph-admin 检查可用磁盘

4.2 准备磁盘

[ceph@ceph-admin my-cluster]$ ceph-deploy osd prepare ceph-admin:sdb ceph-admin:sdc

注意:在此之前请查看下所有磁盘。此处我使用的是物理磁盘 直接部署osd。

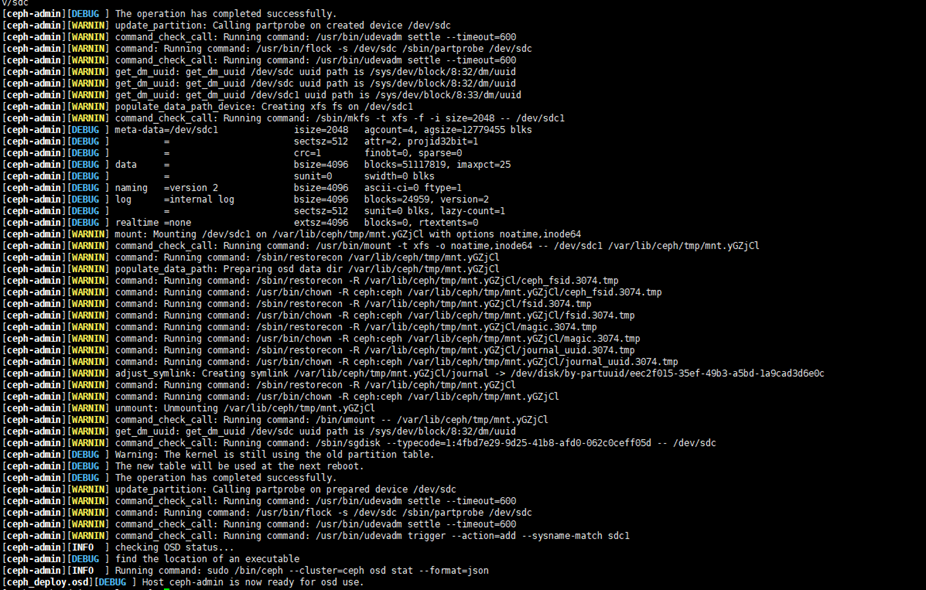

部分截图:执行成功后。

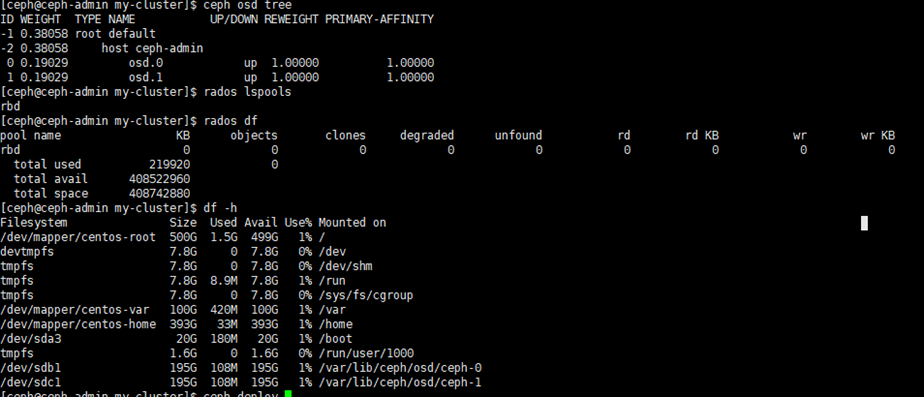

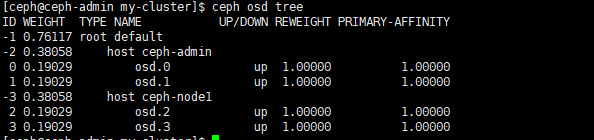

4.3执行完成后 查看ceph osd

4.4添加其他节点的osd

[ceph@ceph-admin my-cluster]$ ceph-deploy disk list ceph-node1

[ceph@ceph-admin my-cluster]$ ceph-deploy osd prepare ceph-node1:sdb ceph-node1:sdc

[ceph@ceph-admin my-cluster]$ ceph-deploy osd prepare ceph-node2:sdb ceph-node2:sdc

4.5再次查看集群状态已经是OK了

5.写在最后

Ceph分布式存储部署过程已经完成了。简单总结下Ceph分布式存储部署的几个关键点1.最关键的是NTP时间问题,如果集群内部的node节点时间不一致会造成ceph集群的不健康状态。2.创建集群万里长征第一步,万事开头难第一步成功了后面部署MON部署MDS服务什么的就很简单了。3.部署OSD应该是万里长征的最后一步了,OSD部署完成也表示这ceph集群可以测试使用了,这一步也非常不易。OSD部署方式分为2种,u文件目录的方式部署,此方式好处是容易找到ceph存储对象的位置,如果文件目录部署失败需要清理文件目录否则会一直报错。v裸磁盘直接部署OSD此方式是ceph集群系统直接管理node节点磁盘。好处相对文件目录速度快一些,如果部署失败需要格式化磁盘 删除osd中的认证key重新部署。