一、设备条件

* 阿里云服务器(Master) 1

* 本机(Slave) 1

二、软件条件

jdk 1.8:https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

spark 2.4.3:http://mirror.bit.edu.cn/apache/spark/spark-2.4.3/spark-2.4.3-bin-hadoop2.7.tgz

三、步骤

1、在Master的服务器上防火墙中开放7077端口或者关闭防火墙,这样 Slave 才能连接到 Master。

2、在Master服务器上启动 spark-master。master的启动文件在spark文件夹的sbin文件夹下。我指定了master的IP地址为服务器的内网IP。

扫描二维码关注公众号,回复:

6873866 查看本文章

./sbin/start-master.sh -h 内网IP

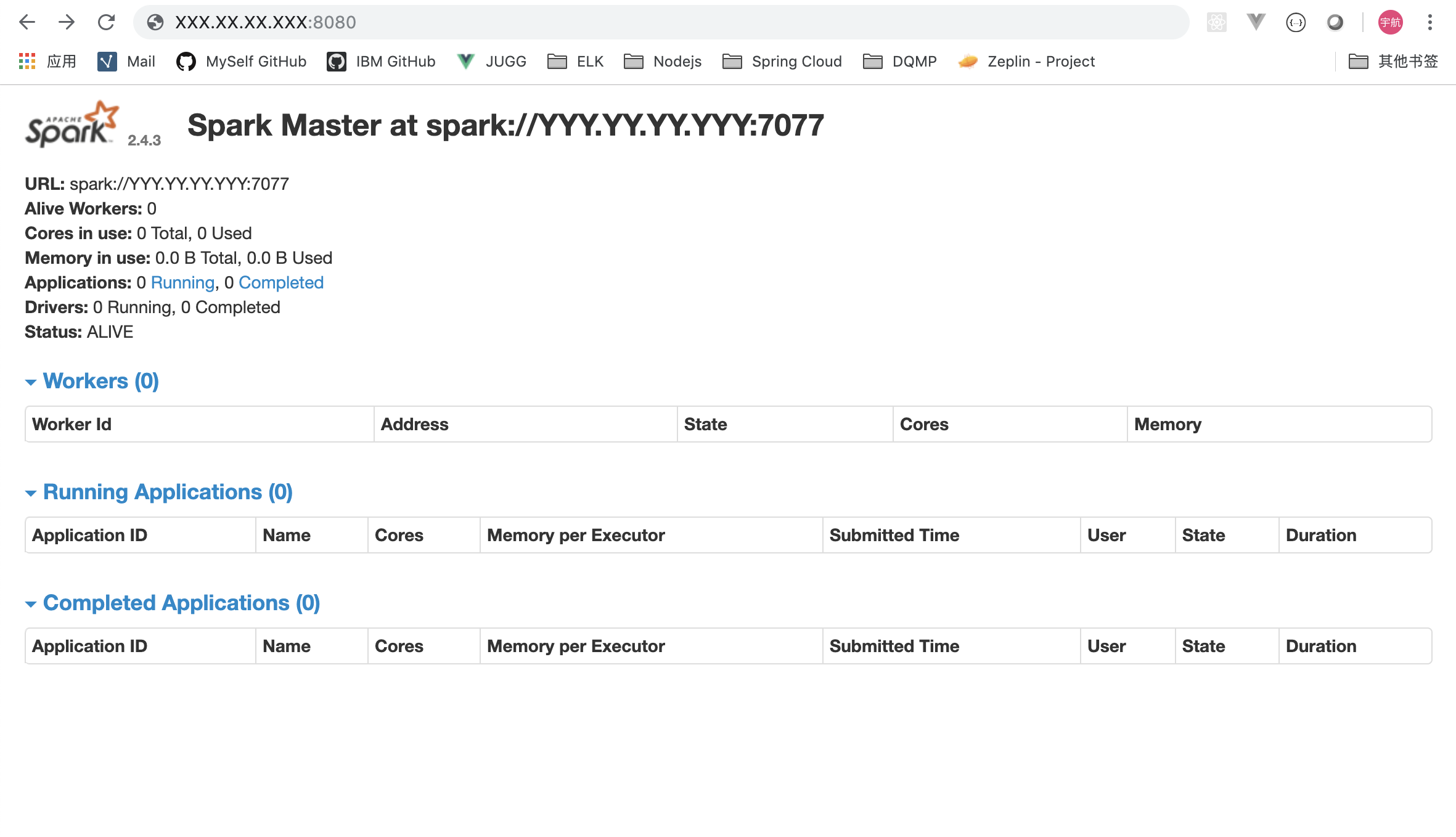

启动成功后可以打开浏览器输入 http://外网IP:8080 , 来查看SparkMaster的信息。XXX.XX.XX.XXX是外网IP,YYY.YY.YY.YYY是内网IP。

3、在主机上启动 slave 来为master创建的节点

./start-slave.sh spark://XXX.XX.XX.XXX:7077

这里 XXX.XX.XX.XXX是外网IP。

查看 log输出,完成之后,在SparkMaster的webUI页面就会多一个Worker。OK,集群搭建完成