环境准备:

准备4台服务器,内存2G,硬盘20G,关闭selinux、关闭firewalld、关闭NetworkManager。

hostname ip 角色(在hadoop平台中扮演的角色)

nn01 192.168.1.10 NameNode,SecondaryNameNode

node1 192.168.1.11 DataNode

node2 192.168.1.12 DataNode

node3 192.168.1.13 DataNode

一、配置Hadoop平台的HDFS集群(分布式存储)

1、在管理节点nn01中,配置ssh秘钥。发送公钥给DataNode节点

配置ssh免密登录,包括nn01主机本身

2、修改地址解析文件,添加主机信息

vim /etc/hosts

3、同步hosts文件到DataNode主机

4、所有节点安装JAVA运行环境。java-1.8.0-openjdk.x86_64 java-1.8.0-openjdk-devel.x86_64

5、解压Hadoop包,把目录放到/usr/local/下。就相当于安装完毕了

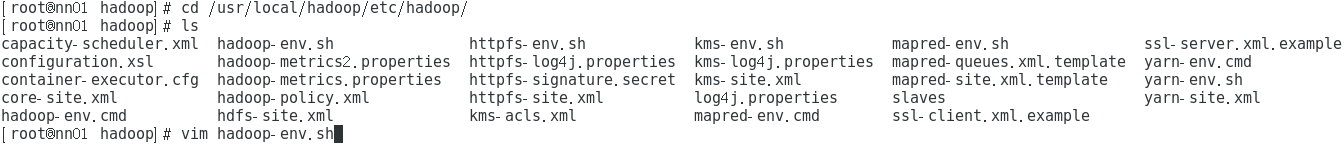

6、修改Hadoop配置文件

①JAVA运行环境的路径和Hadoop的配置文件路径

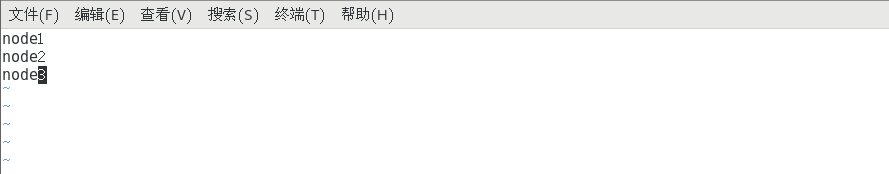

②修改slaves,DataNode节点配置文件

③配置核心参数配置文件,定义hadoop的数据目录,定义hdfs分布式存储的路径

④配置hdfs的相关信息 vim hdfs-site.xml,定义NameNode的地址,定义SecondaryNameNode的地址,定义数据分片总数

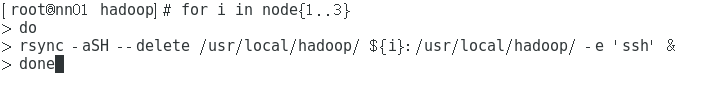

7、同步hadoop目录到每一台DataNode节点上。同时创建数据目录 /var/hadoop

8、在nn01上,执行命令[root@nn01 hadoop]# ./bin/hdfs namenode -format 格式化NameNode。启动HDFS的启动脚本。执行命令[root@nn01 hadoop]# ./sbin/start-dfs.sh

9、用jps命令验证节点角色 node1-node3 理应是角色为DataNode nn01 理应角色为 NameNode和SecondaryNameNode

10、查看集群状态。命令 [root@nn01 hadoop]# ./bin/hdfs dfsadmin -report

HDFS配置完毕。