首先创建个爬虫项目,这里就不讲怎么创建爬虫项目了

将项目部署到Scrapyd上面,Scrapyd是scrapinghub官方提供的爬虫管理、部署、监控的方案之一

安装模块

pip install scrapyd

pip install scrapyd-client

在端口启动scrapyd的服务:要先启动环境管理

命令:scrapyd

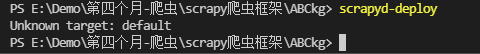

在爬虫根目录执行:scrapyd-deploy

发布爬虫项目到scrapyd

修改scrapy.cfg,去掉url前的#

# 部署工程到scrapyd

[deploy:abckg] # 这是给爬虫项目起别名,跟爬虫名字一样就好

url = http://localhost:6800/ # 把这行注释打开

project = ABCkg # 这个是项目名

进入到scrapy项目根目录,执行:scrapyd-deploy -p (target:spider.cfg文件中[deploy:NAME])(projectname:spider.cfg中project = name)

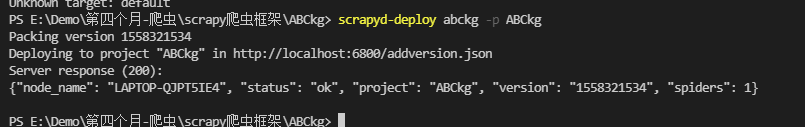

scrapyd-deploy abckg -p ABCkg

这就是部署成功

你可以用setting里面的url 沾到浏览器看下

http://localhost:6800/

Scrapyd可视化

这时Scrapyd上面就有了一个爬虫 ABCkg

Available projects: ABCkg

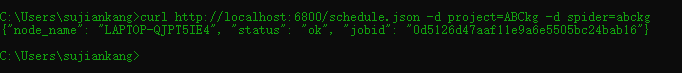

复制Scrapyd下面的 curl http://localhost:6800/schedule.json -d project=default -d spider=somespider把项目名和爬虫名改成自己的如下

# project后面是Scrapyd下面Available projects: ABCkg 这个名字

# spider是 scrapy.cfg(爬虫配置文件)里的 [deploy:abckg]名字

curl http://localhost:6800/schedule.json -d project=ABCkg -d spider=abckg

将修改好的命令在doc里执行

显示ok就是启动爬虫成功

现在点击去看Scrapyd下面的jobs

启动成功

启动成功