非线性变换

定义

通过转换函数

Φ把在空间

X下无法进行线性分割的数据转换为可以进行线性分割的

Z空间的过程(理论上任何非线性可分数据均可转换为更高阶的线性可分的空间)。

x=(x0,…,xd)→Φ→z=(z0,……,zd~)

其中

d<d~,

dvc=d+1,

d~vc≤d~+1. 由于

zi=Φi(x),

Z空间是通过空间

X变换而来的,在此受限情况下,可能出现小于号。

非线性变换增加了参数数量,需要更多的数据进行训练;虽然从理论上可以处理高维数据,但其泛化能力受限。

非线性变换的代价

目标:找到能够反映样本外部数据的模型,即模型泛化能力很重要,要尽量减小已有数据的影响。

Data Snooping: 如果模型选择受到已有数据影响,则会削弱其泛化能力。

- 对于线性基本可分的数据,倘若进行非线性变化,可能产生过拟合,削弱模型泛化作用。倘若采用简单的线性可分模型,则须接受由此带来的

Ein>0误差。

- 对在当前空间中无法线性可分或者难以进行线性分割的条件下可进行非线性转换。

Logistic Regression

在线性分类中,模型为

h(x)=sign(wTx),则

h(x)取值为

±1.

Logistic分类回归中,模型为

h(x)=θ(s)=es+1es=e−s+11

其中

s=wTx,

θ(−s)=1−θ(s),且

0<θ(s)<1.

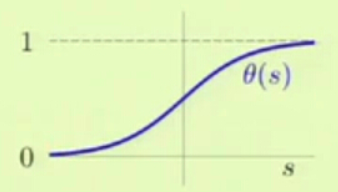

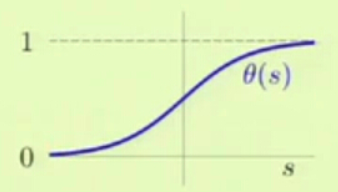

θ(s)=e−s+11被称为sigmoid函数。如下图,Logistic Regression算法将线性函数的结果映射到sigmoid函数中。

模型特点

1.logistic回归只能解决线性问题,但引入soft threshold,相对于linear regression,将结果归一化至(0,1). 可将模型值解释为概率值,

h(x)→0时,表示预测结果接近-1类,,

h(x)→1时,表示预测结果接近+1类。

2. 模型提供发生的可能性,相对于二分类确切结果,提供信息更多。

构造代价函数

- 构造概率模型

P(y∣x)={f(x)1−f(x) if y=+1 if y=−1

f(x)为目标函数,

P(y∣x)为在

X条件下

y发生的概率

- 采用

h(x)来近似

f(x),

P(y∣x)={h(x)1−h(x) if y=+1 if y=−1

由

h(x)=θ(s)及

θ(−s)=1−θ(s)可将上式简化:

P(y∣x)=θ(ywTx)

- 极大似然估计

n=1∏NP(y(n)∣x(n))=n=1∏Nθ(y(n)wTxn)

(1) 取对数似然可得

Maximize

ln(n=1∏Nθ(y(n)wTxn))

即Minimize

−ln(n=1∏Nθ(y(n)wTxn)=n=1∑Nln(θ(y(n)wTxn)1)

- Cross-Entropy error(交叉熵误差度量)

将

θ(s)=e−s+11 代入可得

Ein(w)=N1n=1∑Nln(1+e−y(n)wTxn)

梯度下降求

Ein(w)最小值

推导过程:

其中

w(0)为初始值,

η为移动步长,

v^为移动方向。

算法描述:

终止算法方法:

1、直到找到最好的 W,效果最好,但是无法确定什么时候会终止(有可能无限…)

2、设定一个阀值,当

Ein 小于该阀值的时候终止。

3、限定迭代次数,当 t 大于某个值的时候终止。

利用该方法每次只能找到局部最优值而非全局最优值,不过我们可以通过做多次试验,每次指定不同的初始值,然后取所有结果最小的作为输出。

Reference

机器学习与数据挖掘_线性模型 II

机器学习–Logistic回归计算过程的推导