搭建背景:

目前已经在某个服务器上搭建好了hadoop集群,部署flink环境只需要通过xshell进行操作

步骤:

1、打开xshell,连接hadoop集群所在服务器

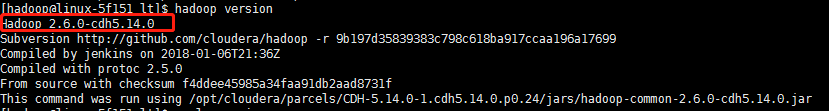

2、查看hadoop版本,如图,可知版本是2.6.0

$ hadoop version

3、去官网下载相应的flink压缩包

下载地址:https://flink.apache.org/downloads.html

找到对应版本的flink,我的是1.6.4版本的

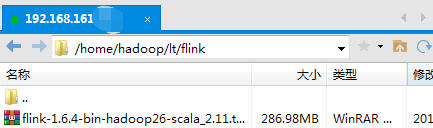

4、下载的压缩包放到服务器的某个目录下(通过xftp)

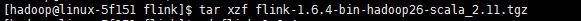

5、通过命令在当前目录进行解压缩

$ tar xzf flink-1.6.4-bin-hadoop26-scala_2.11.tgz

6、运行程序

$ bin/start-cluster.sh

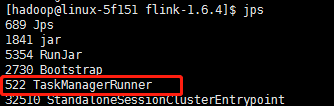

7、查看运行中的task,可以看到有一个在运行中

$ jps

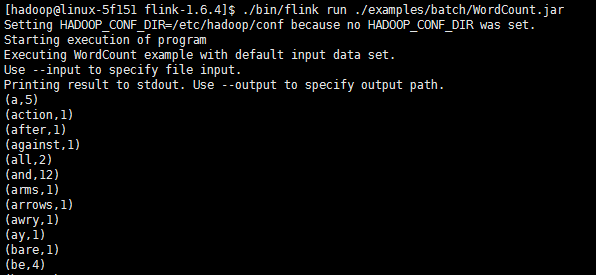

8、运行flink内部的examples,以WordCount.jar为例,可以看到成功运行

$ ./bin/flink run ./examples/batch/WordCount.jar

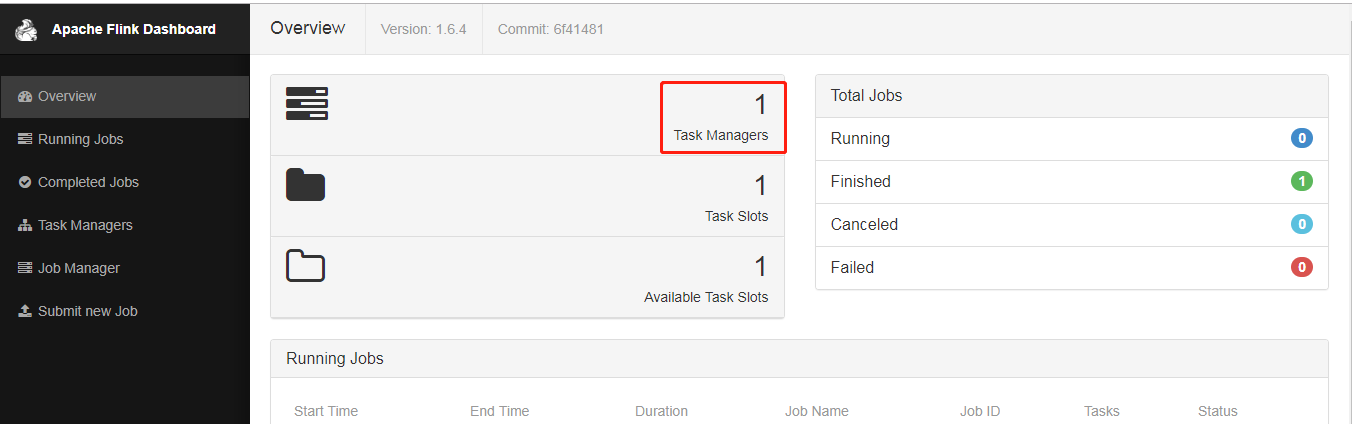

9、打开浏览器查看运行情况

hadoop 所在服务器ip:8081

10、对于flink-1.6.4/conf/flink-conf.yaml的配置问题,下图为文件部分默认配置,测试时不需要修改也能使用,具体项目中按具体配置

参考配置