H.264(MPEG)-4AVC

H.264或MPEG-4第10部分,高级视频编码(MPEG-4 AVC)是一种基于块的运动补偿视频压缩标准。截至2014年,它是录制,压缩和分发视频内容最常用的格式之一。 1它支持分辨率高达8192×4320,包括8K UHD。 2

H.264 / AVC项目的目的是创建一种标准,能够以比以前标准低得多的比特率提供良好的视频质量(即,MPEG-2,H.263或MPEG-的比特率的一半或更低)。 4第2部分),没有增加设计的复杂性,以至于实施起来不切实际或过于昂贵。另一个目标是提供足够的灵活性,使标准能够应用于各种网络和系统上的各种应用,包括低和高比特率,低分辨率和高分辨率视频,广播,DVD存储,RTP / IP分组网络和ITU-T多媒体电话系统。 H.264标准可以被视为由许多不同的配置文件组成的“标准族”。特定解码器解码至少一个但不一定是所有简档。解码器规范描述了可以解码哪些配置文件。 H.264通常用于有损压缩,尽管也可以在有损编码图像中创建真正的无损编码区域,或者支持整个编码无损的罕见用例。

H.264由ITU-T视频编码专家组(VCEG)与ISO / IEC JTC1运动图像专家组(MPEG)一起开发。项目合作伙伴关系被称为联合视频小组(JVT)。 ITU-T H.264标准和ISO / IEC MPEG-4 AVC标准(正式地,ISO / IEC 14496-10-MPEG-4 Part 10,高级视频编码)被共同维护,使得它们具有相同的技术内容。关于第一版标准的最终起草工作于2003年5月完成,其后续版本中增加了其功能的各种扩展。高效视频编码(HEVC),即H.265和MPEG-H第2部分是由相同组织开发的H.264 / MPEG-4 AVC的后继者,而早期标准仍然普遍使用。

最着名的H.264可能是蓝光光盘的视频编码标准之一;所有蓝光光盘播放器必须能够解码H.264。它也被流媒体互联网资源广泛使用,例如来自Vimeo,YouTube和iTunes Store的视频,诸如Adobe Flash Player和Microsoft Silverlight等网络软件,以及地面上的各种HDTV广播(ATSC,ISDB-T,DVB) -T或DVB-T2),电缆(DVB-C)和卫星(DVB-S和DVB-S2)。

H.264受各方拥有的专利保护。涵盖H.264所必需的大多数(但不是全部)专利的许可由专利池MPEG LA管理。3专利H.264技术的商业使用需要向MPEG LA和其他专利所有者支付版税。 MPEG LA允许免费使用H.264技术为最终用户免费提供流媒体互联网视频,思科系统公司代表其开源H.264编码器二进制文件用户向MPEG LA支付版税。

命名

H.264名称遵循ITU-T命名惯例,其中该标准是H.26x系列VCEG视频编码标准的成员; MPEG-4 AVC名称与ISO / IEC MPEG中的命名约定有关,其中该标准是ISO / IEC 14496的第10部分,ISO / IEC 14496是称为MPEG-4的标准套件。该标准是在VCEG和MPEG的合作伙伴关系中共同开发的,之前在ITU-T开展了一项名为H.26L的VCEG项目。因此,通常使用诸如H.264 / AVC,AVC / H.264,H.264 / MPEG-4AVC或MPEG-4 / H.264 AVC之类的名称来引用该标准以强调共同遗产。有时,它也被称为“JVT编解码器”,参考开发它的联合视频组(JVT)组织。 (这种伙伴关系和多种命名并不罕见。例如,称为MPEG-2的视频压缩标准也源于MPEG和ITU-T之间的伙伴关系,其中MPEG-2视频被ITU-T社区称为H .262。4)某些软件程序(如VLC媒体播放器)在内部将此标准标识为AVC1。

历史

1998年初,视频编码专家组(VCEG-ITU-T SG16 Q.6)发出了关于一个名为H.26L的项目的提案征集,其目标是将编码效率提高一倍(这意味着将所需的比特率减半)与用于各种应用的任何其他现有视频编码标准相比,给定的保真度水平。 VCEG由Gary Sullivan(微软,前身为美国PictureTel)担任主席。该新标准的初稿设计于1999年8月通过。2000年,Thomas Wiegand(德国海因里希赫兹研究所)成为VCEG联合主席。

2001年12月,VCEG和运动图像专家组(MPEG-ISO / IEC JTC 1 / SC 29 / WG 11)组成了一个联合视频组(JVT),其章程最终确定了视频编码标准。[5]该规范于2003年3月获得正式批准.JVT由Gary Sullivan,Thomas Wiegand和Ajay Luthra(摩托罗拉,美国:后来的Arris,美国)担任主席。 2004年6月,Fidelity范围扩展(FRExt)项目最终确定。从2005年1月到2007年11月,JVT正致力于通过名为可伸缩视频编码(SVC)的附件(G)将H.264 / AVC扩展到可扩展性。 JVT管理团队由Jens-Rainer Ohm(德国亚琛大学)扩展。从2006年7月到2009年11月,JVT开展了多视频视频编码(MVC),这是H.264 / AVC向免费视点电视和3D电视的扩展。这项工作包括开发两个新的标准配置文件:Multiview High Profile和Stereo High Profile。

第一版H.264 / AVC的标准化于2003年5月完成。在第一个扩展原始标准的项目中,JVT随后开发了所谓的Fidelity Range Extensions(FRExt)。这些扩展通过支持更高的采样位深度精度和更高分辨率的颜色信息实现了更高质量的视频编码,包括称为Y’CbCr 4:2:2(= YUV 4:2:2)和Y’CbCr 4:4的采样结构:4。 Fidelity Range Extensions项目中还包括其他一些功能,例如4×4和8×8整数变换之间的自适应切换,编码器指定的基于感知的量化加权矩阵,高效的图片间无损编码以及支持附加颜色空间。 Fidelity Range Extensions的设计工作于2004年7月完成,其起草工作于2004年9月完成。

最近该标准的进一步扩展包括添加五个其他新的配置文件[哪些?]主要用于专业应用,增加扩展色域空间支持,定义额外的宽高比指标,定义另外两种类型的“补充增强信息”(后过滤提示和色调映射),并弃用之前的FRExt配置文件之一(高4:4:4配置文件),行业反馈[由谁?]指示应该设计不同。

标准中增加的下一个主要功能是可伸缩视频编码(SVC)。在H.264 / AVC的附件G中规定,SVC允许构建包含也符合标准的子比特流的比特流,包括称为“基本层”的一个这样的比特流,其可以由H.264 /解码不支持SVC的AVC编解码器。对于时间比特流可缩放性(即,存在具有比主比特流更小的时间采样率的子比特流),在导出子比特流时从比特流中移除完整的存取单元。在这种情况下,相应地构造比特流中的高级语法和帧间预测参考图片。另一方面,对于空间和质量比特流可伸缩性(即,存在具有比主比特流更低的空间分辨率/质量的子比特流),在导出子比特流时从比特流中去除NAL(网络抽象层)。 。在这种情况下,层间预测(即,从较低空间分辨率/质量信号的数据预测较高空间分辨率/质量信号)通常用于有效编码。可扩展视频编码扩展于2007年11月完成。

标准中添加的下一个主要功能是多视图视频编码(MVC)。在H.264 / AVC的附录H中规定,MVC使得能够构造表示视频场景的多于一个视图的比特流。该功能的一个重要示例是立体3D视频编码。在MVC工作中开发了两个配置文件:Multiview High Profile支持任意数量的视图,Stereo High Profile专为两视图立体视频而设计。 Multiview视频编码扩展于2009年11月完成。

应用

更多信息:使用H.264 / MPEG-4 AVC的视频服务列表:https://en.wikipedia.org/wiki/List_of_video_services_using_H.264/MPEG-4_AVC

H.264视频格式具有非常广泛的应用范围,涵盖从低比特率互联网流媒体应用到HDTV广播和几乎无损编码的数字电影应用的所有形式的数字压缩视频。通过使用H.264,与MPEG-2 Part 2相比,可以节省50%或更多的比特率。例如,据报道,H.264提供的数字卫星电视质量与目前的MPEG-2实现相同,比特率不到一半,目前的MPEG-2实现速率约为3.5 Mbit / s,H.264仅为1.5 Mbit / s的。[23]索尼声称9 Mbit / s AVC录制模式相当于HDV格式的图像质量,其使用大约18-25 Mbit / s。[24]

为了确保H.264 / AVC的兼容性和无故障采用,许多标准组织已经修改或添加到其视频相关标准中,以便这些标准的用户可以使用H.264 / AVC。蓝光光盘格式和现已停产的HD DVD格式都将H.264 / AVC High Profile作为三种强制视频压缩格式之一。数字视频广播项目(DVB)于2004年底批准将H.264 / AVC用于广播电视。

美国的高级电视系统委员会(ATSC)标准机构于2008年7月批准了H.264 / AVC用于广播电视,尽管该标准尚未用于美国境内的固定ATSC广播。[25] [ 26]它还被批准用于最新的ATSC-M / H(移动/手持)标准,使用H.264的AVC和SVC部分。[27]

CCTV(闭路电视)和视频监控市场已将该技术纳入许多产品中。

许多常见的数码单反相机使用包含在QuickTime MOV容器中的H.264视频作为本机记录格式。

派生格式

AVCHD是由Sony和Panasonic设计的高清录制格式,使用H.264(符合H.264,同时添加其他特定于应用程序的功能和约束)。

AVC-Intra是由Panasonic开发的仅帧内压缩格式。

XAVC是Sony设计的录制格式,使用H.264 / MPEG-4 AVC的5.2级,这是该视频标准支持的最高级别。[28] [29] XAVC可支持4K分辨率(4096×2160和3840×2160),速度高达每秒60帧(fps)。[28] [29]索尼宣布支持XAVC的相机包括两款CineAlta相机 - 索尼PMW-F55和索尼PMW-F5。[30]索尼PMW-F55可记录XAVC,4K分辨率为30 fps,速度为300 Mbit / s,2K分辨率,30 fps,100 Mbit / s。[31] XAVC可以以60 fps的速度记录4K分辨率,并以600 Mbit / s的速度进行4:2:2色度子采样。[32] [33]

派生格式

AVCHD是由Sony和Panasonic设计的高清录制格式,使用H.264(符合H.264,同时添加其他特定于应用程序的功能和约束)。

AVC-Intra是由Panasonic开发的仅帧内压缩格式。

XAVC是Sony设计的录制格式,使用H.264 / MPEG-4 AVC的5.2级,这是该视频标准支持的最高级别。[28] [29] XAVC可支持4K分辨率(4096×2160和3840×2160),速度高达每秒60帧(fps)。[28] [29] 索尼宣布支持XAVC的相机包括两款CineAlta相机 - 索尼PMW-F55和索尼PMW-F5。[30] 索尼PMW-F55可记录XAVC,4K分辨率为30 fps,速度为300 Mbit / s,2K分辨率,30 fps,100 Mbit / s。[31] XAVC可以以60 fps的速度记录4K分辨率,并以600 Mbit / s的速度进行4:2:2色度子采样。[32] [33]

设计

本文采用列表格式,可以使用散文更好地呈现。 如果合适,您可以将此文章转换为散文。 编辑帮助可用。 (2016年4月)

特征

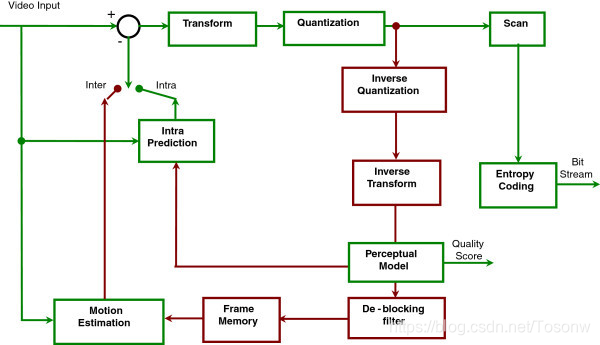

H.264的框图

https://upload.wikimedia.org/wikipedia/commons/8/82/H.264_block_diagram_with_quality_score.jpg

H.264 / AVC / MPEG-4第10部分包含许多新功能,使其能够比旧标准更有效地压缩视频,并为各种网络环境的应用提供更大的灵活性。 特别是,一些这样的关键功能包括:

多画面画面间预测包括以下特征:

以比以前的标准更灵活的方式使用先前编码的图片作为参考,在一些情况下允许使用多达16个参考帧(或者在隔行编码的情况下为32个参考字段)。在支持非IDR帧的配置文件中,大多数级别指定应该有足够的缓冲以允许在最大分辨率下至少4或5个参考帧。这与现有标准形成对比,现有标准的限制通常为1;或者,在传统的“B图像”(B帧)的情况下,两个。这个特殊功能通常允许在大多数场景中适度改进比特率和质量。[引证需要]但在某些类型的场景中,例如具有重复动作或来回切换场景或未覆盖背景区域的场景,它允许显着在保持清晰度的同时降低比特率。

可变块大小运动补偿(VBSMC),块大小为16×16,小至4×4,可实现移动区域的精确分割。支持的亮度预测块大小包括16×16,16×8,8×16,8×8,8×4,4×8和4×4,其中许多可以在单个宏块中一起使用。根据使用中的色度子采样,色度预测块大小相应地更小。

在由16个4×4分区构成的B宏块的情况下,每个宏块使用多个运动矢量(每个分区一个或两个)的能力最大为32。每个8×8或更大的分区区域的运动矢量可以指向不同的参考图像。

能够在B帧中使用任何宏块类型,包括I-宏块,从而在使用B帧时产生更有效的编码。从MPEG-4 ASP中可以看出这一特性。

用于推导半像素亮度样本预测的六抽头滤波,用于更清晰的子像素运动补偿。通过半色值的线性插值导出四分之一像素运动,以节省处理能力。

用于运动补偿的四分之一像素精度,可精确描述移动区域的位移。对于色度,分辨率通常在垂直和水平方向上减半(见4:2:0),因此色度的运动补偿使用八分之一色度像素网格单元。

加权预测,允许编码器在执行运动补偿时指定缩放和偏移的使用,并在特殊情况下提供性能的显着优势 - 例如淡入淡出,淡入淡入和淡入淡出过渡。这包括对B帧的隐式加权预测,以及对P帧的显式加权预测。

用于“帧内”编码的相邻块边缘的空间预测,而不是MPEG-2第2部分中发现的“DC”预测和H.263v2和MPEG-4第2部分中的变换系数预测:

这包括亮度预测块大小为16×16,8×8和4×4(其中每个宏块中只能使用一种类型)。

无损宏块编码功能包括:

无损“PCM宏块”表示模式,其中直接表示视频数据样本,[34]允许特定区域的完美表示,并允许对每个宏块的编码数据量进行严格限制。

增强的无损宏块表示模式允许特定区域的完美表示,同时通常使用比PCM模式少得多的比特。

灵活的隔行扫描视频编码功能,包括:

宏块自适应帧场(MBAFF)编码,对编码为帧的图像使用宏块对结构,允许场模式下的16×16宏块(与MPEG-2相比,其中场图模式处理在图像中被编码为帧导致处理16×8半宏块)。

图像自适应帧场编码(PAFF或PicAFF)允许自由选择的图像混合编码为完整帧,其中两个场被组合在一起用于编码或作为单独的单个场。

新的转换设计功能,包括:

精确匹配整数4×4空间块变换,允许精确放置残留信号,几乎没有先前编解码器设计中常见的“振铃”。这种设计在概念上类似于众所周知的离散余弦变换(DCT),由N. Ahmed,T.Natarajan和K.R.Rao于1974年引入,它是离散余弦变换中的引用1。但是,它被简化并提供精确指定的解码。

精确匹配整数8×8空间块变换,允许比4×4变换更高效地压缩高度相关的区域。该设计在概念上类似于众所周知的DCT,但是被简化并且被提供以提供精确指定的解码。

用于整数变换操作的4×4和8×8变换块大小之间的自适应编码器选择。

对应用于色度DC系数(以及在一种特殊情况下也是亮度)的主空间变换的“DC”系数执行二次Hadamard变换,以在平滑区域中获得甚至更多的压缩。

量化设计包括:

对数步长控制,通过编码器更简单的比特率管理和简化的逆量化缩放

由编码器选择的频率定制的量化缩放矩阵用于基于感知的量化优化

环路去块滤波器,有助于防止其他基于DCT的图像压缩技术常见的块效应,从而获得更好的视觉外观和压缩效率

熵编码设计包括:

上下文自适应二进制算术编码(CABAC),一种在给定上下文中知道语法元素的概率的无损压缩视频流中的语法元素的算法。 CABAC比CAVLC更有效地压缩数据,但需要更多的处理才能解码。

上下文自适应可变长度编码(CAVLC),其是用于编码量化变换系数值的CABAC的较低复杂度的替代。虽然复杂性低于CABAC,但CAVLC比通常用于编码其他现有设计中的系数的方法更精细且更有效。

用于许多未由CABAC或CAVLC编码的语法元素的常见简单且高度结构化的可变长度编码(VLC)技术,称为指数哥伦布编码(或Exp-Golomb)。

损失恢复功能包括:

网络抽象层(NAL)定义允许在许多网络环境中使用相同的视频语法。 H.264的一个非常基本的设计概念是生成自包含数据包,以删除标题重复,如MPEG-4的标头扩展代码(HEC)。[35]这是通过从媒体流中解耦与多个切片相关的信息来实现的。高级参数的组合称为参数集。[35] H.264规范包括两种类型的参数集:序列参数集(SPS)和图片参数集(PPS)。有效序列参数集在整个编码视频序列中保持不变,并且有效图像参数集在编码图像内保持不变。序列和图像参数集结构包含诸如图像大小,采用的可选编码模式和宏块到切片组映射之类的信息。[35]

灵活宏块排序(FMO),也称为切片组,以及任意切片排序(ASO),其是用于重构图片中的基本区域(宏块)的表示的排序的技术。通常被认为是错误/丢失稳健性功能,FMO和ASO也可用于其他目的。

数据分区(DP),一种能够将更重要和不太重要的语法元素分成不同数据包的功能,可以应用不等错误保护(UEP)和其他类型的错误/丢失鲁棒性改进。

冗余切片(RS),一种错误/丢失鲁棒性特征,它允许编码器发送图像区域的额外表示(通常以较低保真度),如果主表示被破坏或丢失,则可以使用该表示。

帧编号,允许创建“子序列”的功能,通过在其他图片之间可选地包含额外图片来实现时间可伸缩性,以及检测和隐藏整个图片的丢失,这可能由于网络数据包丢失或信道而发生错误。

切换片,称为SP和SI片,允许编码器指示解码器跳转到正在进行的视频流,用于诸如视频流比特率切换和“特技模式”操作之类的目的。当解码器使用SP / SI功能跳转到视频流的中间时,它可以获得与视频流中该位置处的解码图像的精确匹配,尽管使用不同的图片或根本没有图片,作为之前的参考。开关。

一种简单的自动过程,用于防止意外模拟起始码,起始码是编码数据中的特殊比特序列,允许随机访问比特流并恢复可能丢失字节同步的系统中的字节对齐。

补充增强信息(SEI)和视频可用性信息(VUI),它们是可以插入比特流的额外信息,以增强视频用于各种目的。[需要澄清] SEI FPA(帧封装安排)包含3D排列的消息:

0: checkerboard: pixels are alternatively from L and R.

1: column alternation: L and R are interlaced by column.

2: row alternation: L and R are interlaced by row.

3: side by side: L is on the left, R on the right.

4: top bottom: L is on top, R on bottom.

5: frame alternation: one view per frame.

辅助图片,可用于alpha合成等目的。

支持单色(4:0:0),4:2:0,4:2:2和4:4:4色度子采样(取决于所选的配置文件)。

支持采样位深度精度,范围为每个采样8到14位(取决于所选的配置文件)。

能够将各个颜色平面编码为具有自己的切片结构,宏块模式,运动矢量等的不同图像,从而允许使用简单的并行化结构设计编码器(仅支持三个支持4:4:4的配置文件) 。

图像顺序计数,用于保持图像的排序和与定时信息隔离的解码图像中的样本值的特征,允许系统单独地携带和控制/改变定时信息,而不影响解码图像内容。

这些技术以及其他几种技术有助于H.264在各种应用环境中在各种情况下比任何先前的标准表现得更好。 H.264通常可以比MPEG-2视频更好地执行 - 通常在比特率的一半或更低的情况下获得相同的质量,特别是在高比特率和高分辨率情况下。[36]

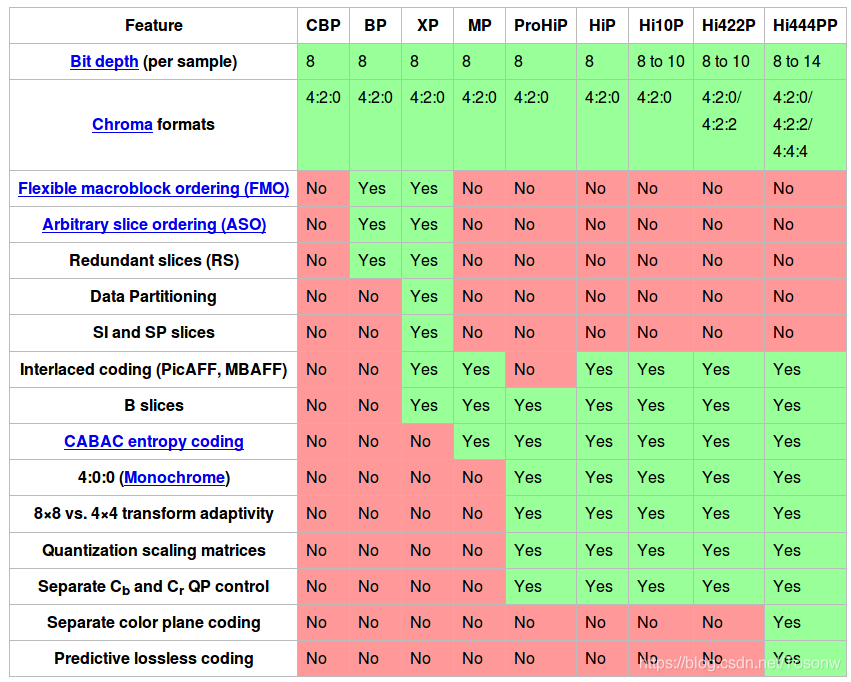

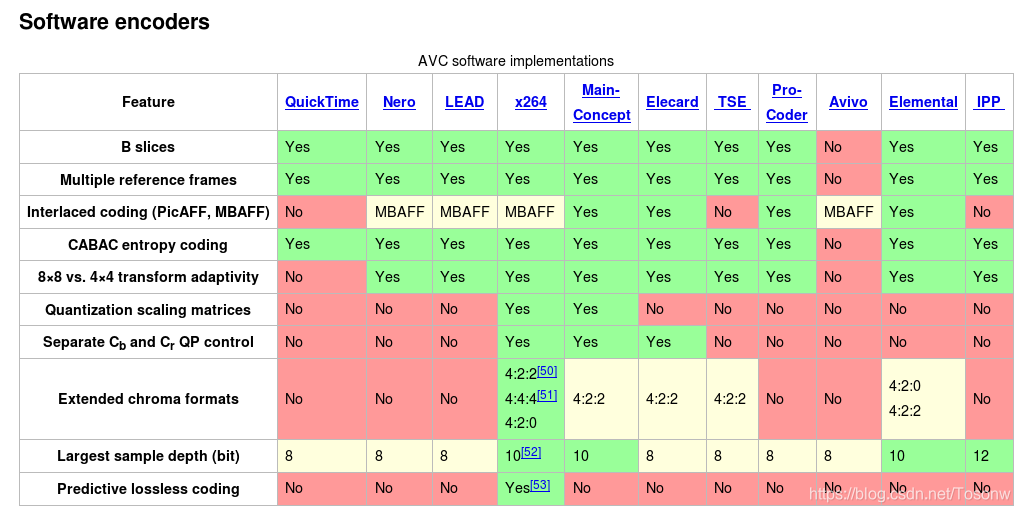

与其他ISO / IEC MPEG视频标准一样,H.264 / AVC具有可以免费下载的参考软件实现。[37]其主要目的是提供H.264 / AVC功能的示例,而不是本身有用的应用程序。运动图像专家组也在进行一些参考硬件设计工作。上述是H.264 / AVC的完整特征,涵盖了H.264的所有配置文件。编解码器的配置文件是该编解码器的一组特征,其被识别以满足预期应用的某些规范集。这意味着某些配置文件不支持列出的许多功能。下一节将讨论H.264 / AVC的各种配置文件。

Feature support in particular profiles

级别

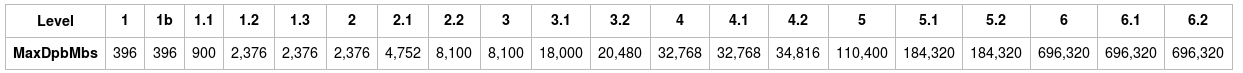

当该术语在标准中使用时,“级别”是指定的一组约束,其指示简档所需的解码器性能的程度。 例如,配置文件内的支持级别指定解码器可以使用的最大图像分辨率,帧速率和比特率。 符合给定级别的解码器必须能够解码为该级别和所有较低级别编码的所有比特流。

Levels with maximum property values[22]

High Profile的最大比特率是Constrained Baseline,Baseline,Extended和Main Profiles的1.25倍; Hi10P为3倍,Hi422P / Hi444PP为4倍。

亮度样本的数量是宏块数量的16×16 = 256倍(并且每秒亮度样本的数量是每秒宏块数量的256倍)。

解码图片缓冲

H.264 / AVC编码器使用先前编码的图片来提供其他图片中的样本值的预测。这允许编码器对编码给定图像的最佳方式做出有效决策。在解码器处,这些图片存储在虚拟解码图片缓冲器(DPB)中。 DPB的最大容量,以帧(或字段对)为单位,如上表右栏中的括号所示,可以按如下方式计算:

DpbCapacity = min(floor(MaxDpbMbs /(PicWidthInMbs * FrameHeightInMbs)),16)

其中MaxDpbMbs是下表中提供的常量值作为级别编号的函数,而PicWidthInMbs和FrameHeightInMbs是编码视频数据的图片宽度和帧高度,以宏块为单位表示(四舍五入为整数值并计算裁剪)和宏块配对(如适用))。该公式在2017年版标准的A.3.1.h和A.3.2.f节中规定。[22]

Hardware

另请参阅:具有板载视频流编码和H.264 / MPEG-4 AVC产品和实现的摄像机列表

由于H.264编码和解码在特定类型的算术运算中需要大量计算能力,因此在通用CPU上运行的软件实现通常功耗较低。但是,最新的四核通用x86 CPU具有足够的计算能力来执行实时SD和HD编码。压缩效率取决于视频算法实现,而不取决于是否使用硬件或软件实现。因此,基于硬件和软件的实现之间的差异更多地取决于功率效率,灵活性和成本。为了提高功率效率并降低硬件形状因数,可以采用专用硬件,用于完整的编码或解码过程,或用于CPU控制环境内的加速辅助。

已知基于CPU的解决方案更加灵活,特别是当编码必须以多种格式,多比特率和分辨率(多屏幕视频)同时进行时,并且可能具有容器格式支持,高级集成广告功能等的附加功能。基于CPU的软件解决方案通常可以更容易地在同一CPU内对多个并发编码会话进行负载均衡。

2011年1月CES(消费电子展)上推出的第二代英特尔“Sandy Bridge”Core i3 / i5 / i7处理器提供片上硬件全高清H.264编码器,称为英特尔快速同步视频。[54] [ 55]

硬件H.264编码器可以是ASIC或FPGA。

具有H.264编码器功能的ASIC编码器可从许多不同的半导体公司获得,但ASIC中使用的核心设计通常是从Chips&Media,Allegro DVT,On2(以前的Hantro,被Google收购)等少数公司中获得许可, Imagination Technologies,NGCodec。一些公司同时拥有FPGA和ASIC产品。[56]

德州仪器(TI)生产一系列ARM + DSP内核,以30fps的速度执行1080p的DSP H.264 BP编码。[57]这允许编解码器(其被实现为高度优化的DSP代码)的灵活性,同时比通用CPU上的软件更有效。

许可

另请参阅:Microsoft Corp.诉Motorola Inc.和Qualcomm Inc.诉Broadcom Corp.

在维护软件算法专利的国家,使用H.264 / AVC的产品的供应商和商业用户预计将为其产品使用的专利技术支付专利许可使用费。[58]这也适用于基线概况。[59]

一个名为MPEG LA的私人组织,与MPEG标准化组织无任何关联,管理适用于该标准的专利许可,以及MPEG-2第1部分系统的专利池,MPEG-2第2部分视频,MPEG-4第2部分视频,HEVC,MPEG-DASH和其他技术。美国的MPEG LA H.264专利至少持续到2027年。[60]

2010年8月26日,MPEG LA宣布,对终端用户免费的H.264编码互联网视频将永远不会收取版税。[61]所有其他特许权使用费仍然存在,例如对H.264视频进行解码和编码的产品的版税以及免费电视和订阅频道的运营商。[62]许可条款以5年为块更新。[63]

法律专利的实际状态在2018年底到期,共有123页。 [64]

2005年,美国专利5,452,104和美国专利5,576,767的受让人高通公司在美国地方法院起诉Broadcom,声称Broadcom通过制造符合H.264视频压缩标准的产品侵犯了这两项专利。[65] 2007年,地区法院认定专利无法执行,因为高通公司在2003年5月发布H.264标准之前未能向JVT披露这些专利。[65] 2008年12月,美国联邦巡回上诉法院确认了地区法院关于专利无法执行的命令,但向地区法院提出了指示,要求将不可执行的范围限制在符合H.264标准的产品范围内。[65]

External links

ITU-T publication page: H.264: Advanced video coding for generic audiovisual services

MPEG-4 AVC/H.264 Information Doom9's Forum

H.264/MPEG-4 Part 10 Tutorials (Richardson)

"Part 10: Advanced Video Coding". ISO publication page: ISO/IEC 14496-10:2010 – Information technology — Coding of audio-visual objects.

"H.264/AVC JM Reference Software". IP Homepage. Retrieved 2007-04-15.

"JVT document archive site". Retrieved 2007-05-06.

"Publications". Thomas Wiegand. Retrieved 2007-06-23.

"Publications". Detlev Marpe. Retrieved 2007-04-15.

"Fourth Annual H.264 video codecs comparison". Moscow State University. (dated December 2007)

"Discussion on H.264 with respect to IP cameras in use within the security and surveillance industries". (dated April 2009)

"Sixth Annual H.264 video codecs comparison". Moscow State University. (dated May 2010)