1.造成梯度消失的原因?造成梯度爆炸的原因?

消失:网络模型深度过深;选用了不合适的损失函数,例如(sigmoid函数)

爆炸:网络模型过深并且初始化权重过大;

2.sigmoid函数值域问题?

值域(0,1)开区间,定义域(-无穷,+无穷)

对于激励函数:梯度只会无限趋近于零,

对于交叉熵损失:值永远大于零,但可能会无限趋近于零

3.sigmoid函数,交叉熵(cross entyopy)损失,hinge损失的梯度与啥有关?

sigmoid:f′(z)=f(z)[1−f(z),导数与自身的函数值有关

交叉熵损失:导数只与预测值和实际值的值有关(ML的逻辑回归那的推导,就是线性回归的梯度下降法!)

hinge损失:hinge通常需要平方进行平滑变为可微,所以导数与未平滑的函数值成正比(答案我不确定.....)

4.词袋模型(BOW)?连续词袋模型(CBOW)?

BOW:没有上下文关系,没有词的顺序,每个词用频率表示而不用向量表示!

CBOW:是word2vec的一个代表模型,另一个代表模型是跳字模型(skip-gram),利用滑窗的思想,用窗口两边的词去估计窗口最中间的词,而skip-gram是用中心词去估计周边词!

窗口内部的语序被完全抛弃了,因为你词向量进行了一个sum,但是语序并不是被完全抛弃了,滑窗本身就是按照自然语言

的顺序去生成样本的,最后生成的词向量一定会包含部分语序的!词向量的表达毕竟有限,语序这些特征可以交给更复杂

的模型去挖掘,词向量能表达的毕竟有限嘛!

5.DNN(多层感知机网络)说说过程?(训练过程,测试过程:输入层(线性),通过隐藏层的非线性变换,全连接到输出层)

激活函数一定是非线性函数?(利用SVM的线性到非线性去说明)

6.输入层的数据预处理?(去均值,标准化,PCA)

7.卷积层做的事?(参数计算,探索模式,feature map的维度靠stride)

8.激励层的激活函数介绍?(sigmoid,tanh(双曲正切),relu,leak relu,maxout,elu)

sigmoid函数每次反向传播梯度大约变为原来的四分之一,双曲正切函数每次大约变为原来的二分之一,一般使用relu,

因为x为正时不会改变梯度大小,x为负时会改变!

9.池化层?(降维下采样,特征不变性,最大,取平均池化)

10.全连接层做的事?(特征展开成向量与权重进行乘积)

11.过拟合怎么办?(随机失活,训练集怎样,测试集怎样,思想解释bagging,特征的冗余)

12.残差网络概述?(梯度弥散,过拟合)

13.CNN应用?(图像识别与定位,离线的物体检测(r-cnn,fast-r-cnn,faster-r-cnn),实时的物体检测(YOLO/SSD)

图像分割(下采样和上采样,池化和卷积,反卷积)

14.谈谈反卷积?(卷积的逆运算,可看做从一个随机变量feature map到一幅图)

15.词袋模型和TF-IDF谈谈?(文档向量的频次,频率,文档向量的构成(词的one-hot编码))

16.n-gram词向量?为啥引出?

17.共现矩阵?n元语言模型?(利用了n-gram的滑窗思想)

18.NNLM谈谈?(对语言模型建模,利用神经网络处理)

19.word2vec谈谈?(连续词袋模型,skip-gram model,n-gram思想,词向量,训练方式输入无监督输出有监督)

20.RNN谈谈?(处理时序数据,记忆有限(梯度/未重复记忆),双向结构,深层双向结构)

21.LSTM谈谈?(缓解了RNN记忆问题,处理了梯度问题,但没有重复记忆,门的思想,参数多,变种GRU)

22.encoder-decoder模型?(可以实现seq2seq,引入attention机制,可用lstm实现)

23.谈谈attention的更新权重过程?有哪些attention机制?(循环过程,globle,local,self注意 decoder层自身的关系

,层次注意 词到句子,句子到段落)

24.对抗网络原理?(生成器,判别器,损失函数的上下界问题)

25.GAN的应用?(深度卷积对抗生成网络(生成图像),图像翻译(涂色),无配对图像翻译(风格变换)循环一致性损失,多领域图像翻译(age,color,face变换))

26.马尔可夫决策?(状态依赖上一次,有限序列,会趋于稳定会收敛到一个值)

27.迁移学习?(实际中样本不足,会过拟合,利用原有的相似任务或者同域任务)

28.保守学习?层迁移?(使W‘变化小一点,加入正则项防止过拟合,利用模型的部分层次来防止过拟合)

29.矩阵的内积,外积?(内积:矩阵的点乘得到一个标量(逐点相乘),外积:矩阵的叉乘得到一个矩阵(矩阵的乘法问题),

内积的值其实度量了相似度,值越大越相似(值=a的模乘b的模乘余弦相似度,最终值只与余弦相似度成正比)

(卷积核就是在寻找和它最相似的部分,卷积核就是W参数进行学习得来的!)

30.卷积核映射的图片size计算公式?((L - K_L)/stride +1 )*((L - K_L)/stride +1 )* Kernel_num ,减去卷积核的长度是因为最后一个核长度是移动不了的!)

31.降采样的池化层真的需要吗?(看实际情况,在没有过拟合,计算资源足够的情况下,是不需要考虑的,因为这是一定程度上信息的丢失!)

32.1*1*3的卷积核真的能降低维度吗?(图片的大小不变,但是可以通过控制通道数(卷积核个数)来控制维度嘛!)

33.AlexNet,VGG,GooleNet,ResNet(华人內)简单说说?(都是image net挑战赛的冠军模型,....)

34.卷积核的是多层还是单层的?(卷积核的厚度为1就是单层,卷积核的厚度为上一层的通道数为卷积多层,每层分别计算求内积在进行加和进行映射)

35.1*1卷积核作用?(降低参数,对卷积核通道降维或者升维就像是在channels通道上做线性组合,有利于特征的提取,实现了跨通道的交互和信息整合。)

36.卷积核的参数?(32*32*5为输入图片维度 核大小为5*5*3(也是参数的个数)(切记厚度必须与上一层的channels匹配才可以进行卷积的!切记!)有几个核需要自己决定,多个卷积核称为多卷积核层)

37.卷积核的映射维度feature map?(feature map:一个feature map就是图片大小维度(灰度图),而三个feature map就是3张图片大小的维度进行叠加厚度为3(彩色图),32*32*3的 图片被5*5*3多层卷积核 有10个核 进行映射会变为为28*28*10的维度了,可以很清楚的看出是可以自由控制通道来进行升维和降维的,当padding可填充时图片大小不会变化且当stride都为1时才可!)

38.物体检测的三种进化概述?(rcnn利用conv对每个候选集进行特征提取在分别进行分类和回归,不完全端到端的网络fast-rcnn通过一次conv的前向计算得到特征用候选集进行分割子集,在经过pooling层进行reshape在把分类和回归连接到神经网络loss利用超参数进行加和调节,完全端到端的网络把候选集的生成连接到神经网络对图片选取中心点进行不同比例进行生成候选集做成了完全端到端的网络!)

39.自编码器autoencoder(dl的无监督学习)?(encoder模型进行特征的压缩与更深层次特征的提取(类似CNN卷积层的视野域的扩增),decoder模块通过对提取的特征特征进行反向升维得到输出。损失函数为输入和输出的相似度,为了让模型更加鲁棒会使用denoising加噪声的方式去学习更有用的特征(为了防止过拟合))

40.word2vec的cbow窗口以及batch_size?(

CBOW的处理步骤:

1.确定窗口大小window,对每个词生成2*window个训练样本,(i-window, i),(i-window+1, i),..(i,i).,(i,i+1)

( i,i+window-1),(i,i+window)

2.确定batch_size,注意batch_size的大小必须是2*window的整数倍,这确保每个batch包含了一个词汇对应的所有样本)

41.RNN梯度消失问题,为什么LSTM和GRU可以解决此问题?(RNN梯度消失是因为网络层级过深,梯度形式为连乘,激活函数选取不当导致,LSTM通过引入门的结构,忘记门(决定忘记的信息),输入门(决定输入的信息),输出门(通过细胞状态的更新来计算当前时刻的输出),GRU对LSTM的门结构进行了改进把忘记门和输入门合并为更新门,降低了参数的数量!)

42.怎么提升网络的泛化能力?(加正则项,加随机失活,对卷积网络可以使用小卷积代替大卷积通过不改变感受野来降低参数利用全卷积网络把全连接层全部使用卷积层进行替代,可以对图片增加样本数通过加噪声扭曲等操作。)

43.什么是seq2seq model?(属于enocder-decoder模型,通过encoder模块进行编码对特征进行压缩和提取,将结果传递给decoder模块,然后对特征进行解码最后得到一个输出!)

44.SPP,YOLO了解吗?(spp是对不同尺寸的图片进行调整保证了尺寸不变性,与fast-rnn的ROI层类似但是速度ROI层更快,yolo实现了通过划分单元格一个阶段的目标检测(因此可以达到实时目标检测),yolo2给卷积层加上了BN层和leaky relu激活函数加快收敛和减少梯度弥散带来的过拟合问题)

45.梯度消失梯度爆炸怎么解决?(层级过深,改变损失函数,改变初始化权重,实在不行就换网络模型)

46.卷积层和池化层有什么区别?(卷积层是降低参数量,通过内积对更高维度特征的提取,可以通过不同的卷积核移动步长来达到升维和降维,池化层只是对特征的降维通过筛去冗余特征不重要的位置信息等特征保留那些重要的特征来实现的!)

47.CNN为什么比DNN在图像识别上更好?(主要还是通过卷积层对特征更深层次的提取和参数量的降低(降低了过拟合的风险),再加上池化层对冗余信息或者不重要的位置信息等的舍弃达到降维(又降低了过拟合的风险))

48.画出lstm的模型细节和四个门的计算公式?(硬伤,后面再说!)

49.采用小的卷积核作用?(通过多个小卷积核近似大的卷积核,让多个层的小卷积达到和大卷积相同的感受野,然后这样还可以降低参数量。)

50.lda和word2vec词表示的区别?(LDA:是引入主题这个隐变量在加入了先验分布在构建一个文档和词的矩阵来对联合概率分布进行建模用先验分布和EM算法进行求解。Word2Vec:是基于神经网络进行训练的,用滑窗的思想也是对联合概率分布进行建模,映射成词向量在通过投影矩阵的映射变为稠密向量,在进行加和然后通过全连接层进行词典大小的分类,会通过一个层次化或者下采样的方式进行加速!)

51.为啥rnn比cnn和全链接更容易梯度爆炸和消失?(主要还是层级过深,rnn的导数是tanh导数很容易趋近于零造成梯度弥散,而初始化权重过大会直接导致梯度爆炸nan值!)

52.文本分类cnn,lstm,attention的区别?(cnn是通过卷积层对特征的提取,在进行全链接分类,lstm对循环神经网络rnn的一种改进,增强了记忆力,引进门的思想把梯度的连乘变为连加,attention引进了在记忆的思想对lstm进行了增强用decoder和encoder模型(seq2seq模型序列对序列模型)encoder模块对特征信息进行压缩和提取作为输入喂给decoder模块然后进行预测,t时刻的输出需要的记忆信息是通过前一个状态的信息对encoder模块的所有输出求权重然后进行整合作为记忆信息来预测t时刻的输出。)

53.为啥relu小于零的输出为零?(增加稀疏性,加快计算速度)

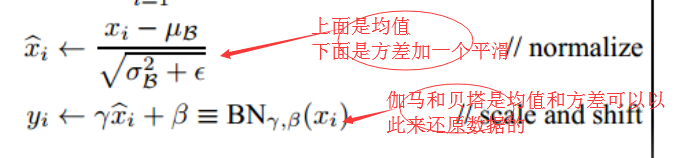

54.batch norm的公式?

55.分类网络的发展史?(

AlexNet(2012年冠军): 卷积网络的在兴起 - 卷积层:5层 ,当时用的还是5*5,3*3的大卷积层。 - 全连接层:3层 - 深度:8层

InceptionNet(2014年冠军):- 全局平均池化层(将图片尺寸变为1×11×1)取代全连接层;

- 利用小卷积核(1*1,3*3,5*5),最大池化层(3*3)

VGGnet(2014年亚军):证明了使用很小的卷积(3*3),增加网络深度可以有效提升模型的效果

-卷积层:16层 - 全连接层:3层 - 连续使用多层小卷积核(3*3*M)

ResNet(2015年冠军):主要是针对层数越深,训练集准确率反而出现下降的情况提出的深度残差网络(解决了过拟合)

网络层加上了连接通道!将梯度的连乘变为连加)

56.检测网络的发展史?(

R-CNN:对图像进行自底向上聚类来选出候选集,对每个候选集进行CNN卷积层提取特征,用svm进行分类,用回归进行对边框的回归来对边框位置进行调整缩放,移动等等。

Fast-R-CNN:对R-CNN进行性能的优化变为了不完全端对端网络,通过一次前向卷积生成的特征用候选框选出对应的特征然后在通过RIP池化层对图片进行resize到同一尺寸,然后把多分类和回归连接到神经网络上,对loss函数进行加权来学习。

Faster-R-CNN:把生成图像候选集接到神经网络上形成了完全端对端的网络,就是取不同的中心点然后选取不同尺寸的图片!

网络分two-stage :生成候选集和进行分类和回归

基于实时的YOLO和SSD以后再说,不是太懂!

对图片进行画格子,然后确定B个中心点,每个中心点确定几个不同比例的子图,把他当成候选集,送入神经网络里然后进行训练!

)