- Backpropagation

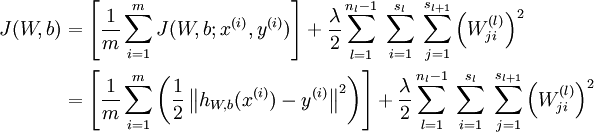

求解损失函数

通过链式法则对参数进行一层一层的求导

- 前向传播计算出所有节点的激活值和输出值

- 计算整体损失函数

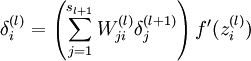

- 后针对第L层的每个节点计算出残差(这里是因为UFLDL中说的是残差,本质就是整体损失函数对每一层激活值Z的导数),所以要对W求导只要再乘上激活函数对W的导数即可

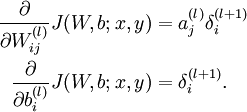

- 梯度消失:本质是由于激活函数的选择导致的, 最简单的sigmoid函数为例,在函数的两端梯度求导结果非常小(饱和区),导致后向传播过程中由于多次用到激活函数的导数值使得整体的乘积梯度结果变得越来越小,也就出现了梯度消失的现象。

梯度爆炸:同理,出现在激活函数处在激活区,而且权重W过大的情况下。但是梯度爆炸不如梯度消失出现的机会多 - 常用的激活函数

- 解决overfitting的方法

dropout, regularization, batch normalizatin,但是要注意dropout只在训练的时候用,让一部分神经元随机失活。

Batch normalization是为了让输出都是单位高斯激活,方法是在连接和激活函数之间加入BatchNorm层,计算每个特征的均值和方差进行规则化

方法名称 公式

KaTeX parse error: Expected 'EOF', got '#' at position 95: …ning_rate * dx #̲ integrate velo…

6. CNN问题

(1)思想

改全连接为局部连接,由于图片特殊性造成的(图像的一部分的统计特性与其他部分是一样的)

通过局部连接和参数共享大范围的减少参数值。

可以通过使用多个filter来提取图片的不同特征(多卷积核)。

(2)filter尺寸的选择,通常为奇数(1,3,5,7)

(3)输出尺寸计算公式

输出尺寸=(N - F +padding*2)/stride + 1

步长可以自由选择通过补零的方式来实现连接。

(4)pooling池化的作用

虽然通过卷积的方式可以大范围的减少输出尺寸(特征数),但是依然很难计算而且很容易过拟合,所以依然利用图片的静态特性通过池化的方式进一步减少尺寸。

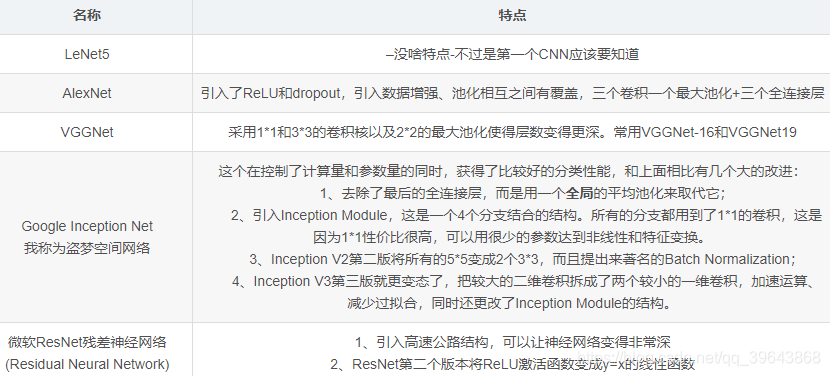

(5)常用的几个模型,这个最好能记住模型大致的尺寸参数。

7. RNN

(1)RNN原理:

在普通的全连接网络或CNN中,每层神经元的信号只能向上一层传播,样本的处理在各个时刻独立,又被成为前向神经网络(Feed-forward+Neural+Networks)。

而在RNN中,神经元的输出可以在下一个时间戳直接作用到自身,即第i层神经元在m时刻的输入,除了(i-1)层神经元在该时刻的输出外,还包括其自身在(m-1)时刻的输出。所以叫循环神经网络

2、RNN、LSTM、GRU区别

RNN引入了循环的概念,但是在实际过程中却出现了初始信息随时间消失的问题,即长期依赖(Long-Term Dependencies)问题,

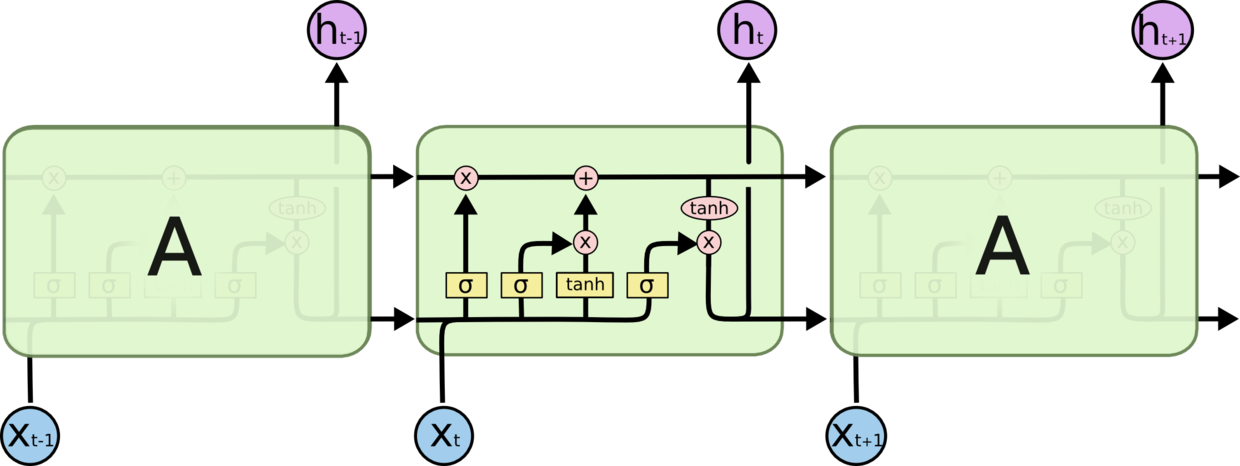

LSTM:因为LSTM有进有出且当前的cell informaton是通过input gate控制之后叠加的,RNN是叠乘,因此LSTM可以防止梯度消失或者爆炸。推导forget gate,input gate,cell state, hidden information等因为LSTM有进有出且当前的cell informaton是通过input gate控制之后叠加的,RNN是叠乘,因此LSTM可以防止梯度消失或者爆炸的变化是关键,下图非常明确适合记忆:

GRU是LSTM的变体,将忘记门和输入们合成了一个单一的更新门。

3、LSTM防止梯度弥散和爆炸

LSTM用加和的方式取代了乘积,使得很难出现梯度弥散。但是相应的更大的几率会出现梯度爆炸,但是可以通过给梯度加门限解决这一问题。

4、引出word2vec

这个也就是Word Embedding,是一种高效的从原始语料中学习字词空间向量的预测模型。分为CBOW(Continous Bag of Words)和Skip-Gram两种形式。其中CBOW是从原始语句推测目标词汇,而Skip-Gram相反。CBOW可以用于小语料库,Skip-Gram用于大语料库。