Week1Day7任务简介:学习第3章k近邻,学习k近邻算法在分类问题中的应用,理解k近邻法的三要素及模型对应的损失函数。学习时长:Day7详细说明:第3章讲了如何用k近邻算法进行分类。同学们通过学习第1节,理解k近邻算法的基本思想;通过学习第2节,掌握k近邻算法如何实现;第3节是一个搜索技术,关于如何对某一训练数据快速找到相邻的k个示例,这里不做学习要求。学习目标:

1、导读视频

2、掌握k近邻算法的原理。

3、理解k近邻算法三要素及模型对应的损失函数。

4、掌握k近邻算法在分类问题上的求解过程。

5、观看助教录制的第1章的作业讲解视频

作业3:

1.思考k近邻算法的模型复杂度体现在哪里?什么情况下会造成过拟合?打卡进行文字说明。。

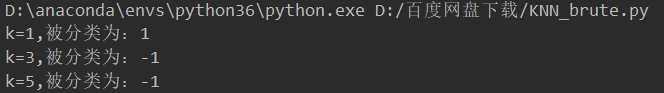

2.给定一个二维空间的数据集T={正实例:(5,4),(9,6),(4,7);负实例:(2,3), (8,1),(7,2)},试基于欧氏距离,找到数据点S(5,3)的最近邻(k=1),并对S点进行分类预测。(1)用“线性扫描”算法自编程实现。(2)试调用sklearn.neighbors的KNeighborsClassifier模块,对S点进行分类预测,并对比近邻数k取值不同,对分类预测结果的影响。(3)思考题:思考“线性扫描”算法和“kd树”算法的时间复杂度。打卡代码运行结果的截图。3.总结本周学习内容,形成笔记。作业答案及代码讲解在下周四公布,助教会进行视频讲解。打卡要求:(文字20字,图片1张)

#draw.py

import matplotlib.pyplot as plt

import numpy as np

def draw(X_train,y_train,X_new):

# 正负实例点初始化

X_po=np.zeros(X_train.shape[1])

X_ne=np.zeros(X_train.shape[1])

# 区分正、负实例点

for i in range(y_train.shape[0]):

if y_train[i]==1:

X_po=np.vstack((X_po,X_train[i]))

else:

X_ne=np.vstack((X_ne,X_train[i]))

# 实例点绘图

plt.plot(X_po[1:,0],X_po[1:,1],"g*",label="1")

plt.plot(X_ne[1:, 0], X_ne[1:, 1], "rx", label="-1")

plt.plot(X_new[:, 0], X_new[:, 1], "bo", label="test_points")

# 测试点坐标值标注

for xy in zip(X_new[:, 0], X_new[:, 1]):

plt.annotate("test{}".format(xy),xy)

# 设置坐标轴

plt.axis([0,10,0,10])

plt.xlabel("x1")

plt.ylabel("x2")

# 显示图例

plt.legend()

# 显示图像

plt.show()#KNN_brute.py

import numpy as np

from collections import Counter

from draw import draw

class KNN:

def __init__(self,X_train,y_train,k=3):

# 所需参数初始化

self.k=k # 所取k值

self.X_train=X_train

self.y_train=y_train

def predict(self,X_new):

# 计算欧氏距离

dist_list=[(np.linalg.norm(X_new-self.X_train[i],ord=2),self.y_train[i])

for i in range(self.X_train.shape[0])]

#[(d0,-1),(d1,1)...]

# 对所有距离进行排序

dist_list.sort(key=lambda x: x[0])

# 取前k个最小距离对应的类别(也就是y值)

y_list=[dist_list[i][-1] for i in range(self.k)]

# [-1,1,1,-1...]

# 对上述k个点的分类进行统计

y_count=Counter(y_list).most_common()

# [(-1, 3), (1, 2)]

return y_count[0][0]

def main():

# 训练数据

X_train=np.array([[5,4],

[9,6],

[4,7],

[2,3],

[8,1],

[7,2]])

y_train=np.array([1,1,1,-1,-1,-1])

# 测试数据

X_new = np.array([[5, 3]])

# 绘图

draw(X_train, y_train, X_new)

# 不同的k(取奇数)对分类结果的影响

for k in range(1,6,2):

#构建KNN实例

clf=KNN(X_train,y_train,k=k)

#对测试数据进行分类预测

y_predict=clf.predict(X_new)

print("k={},被分类为:{}".format(k,y_predict))

if __name__=="__main__":

main()

#skl_KNN.py

import numpy as np

from sklearn.neighbors import KNeighborsClassifier

def main():

# 训练数据

X_train=np.array([[5,4],

[9,6],

[4,7],

[2,3],

[8,1],

[7,2]])

y_train=np.array([1,1,1,-1,-1,-1])

# 待预测数据

X_new = np.array([[5, 3]])

# 不同k值对结果的影响

for k in range(1,6,2):

# 构建实例

clf = KNeighborsClassifier(n_neighbors=k,n_jobs=-1)

# 选择合适算法

clf.fit(X_train, y_train)

# print(clf.kneighbors(X_new))

# 预测

y_predict=clf.predict(X_new)

#print(clf.predict_proba(X_new))

print("预测正确率:{:.0%}".format(clf.score([[5,3]],[[1]])))

print("k={},被分类为:{}".format(k,y_predict))

if __name__=="__main__":

main()