课程:《密码与安全新技术专题》

班级: 1892班

姓名: 李炀

学号:20189215

上课教师:谢四江

上课日期:2019年3月26日

必修/选修: 选修

1.本次讲座的学习总结

讲座主题:人工智能在密码分析设计上的应用/基于深度学习的密码分析与设计

- 人工智能将是下一代安全解决方案的核心。随着数据量、数据传输速度以及监控和管理的数量以指数速率加速,人工智能安全将是未来网络安全的关键组成部分。

- 密码分析与机器学习之间有天然的相似性。

在密码分析中,攻击者试图通过推算出密钥来破解密码系统。解密函数是从一个由密钥索引的已知函数空间(解空间)求解出。攻击者的目的是发现解密函数的精确解。如果攻击者能够获取多个获取密文与明文配对来进行密码分析,其与机器学习的概念相似:机器学习的研究人员也是试图从多个样本与标签配对来进行机器学习模型的求解(训练)。

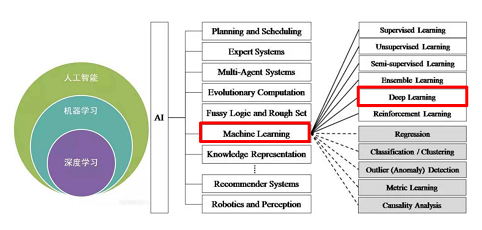

- 深度学习简介

- 深度学习是人工智能领域中,机器学习的一个分支,但是使用较广泛,研究与应用更多。

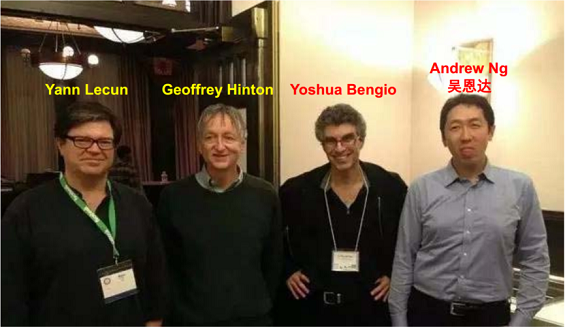

- 深度学习“四大天王”

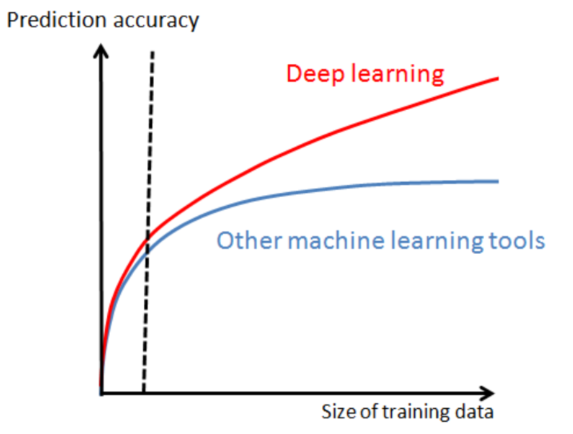

- 深度学习兴起和发展迅速的一个重要契机与原因就是大数据时代的到来。

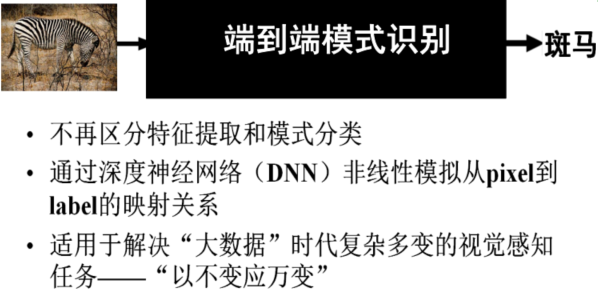

- 视觉大数据时代模型学习的突破:端到端深度学习。

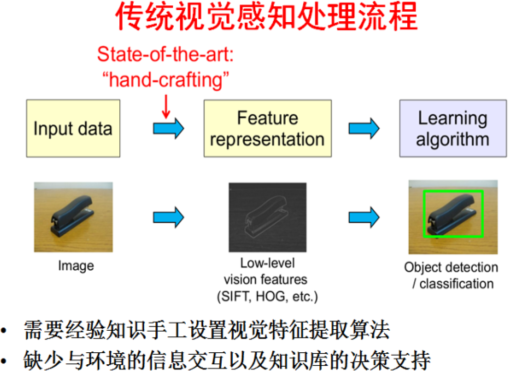

- 传统视觉感知处理流程

- 端到端模式识别

- 传统视觉感知处理流程

- 深度学习是人工智能领域中,机器学习的一个分支,但是使用较广泛,研究与应用更多。

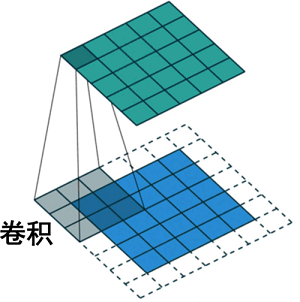

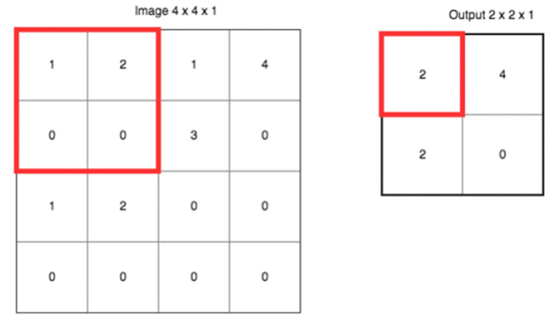

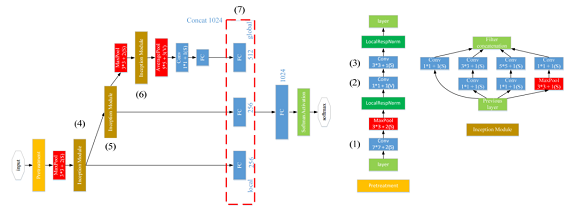

- 卷积神经网络CNNs: Convolutional Neural Networks

只要数据可以表示成矩阵的形式,就可以使用卷积神经网络对其进行卷积与分析,寻找特征值。

- 池化。池化(Pooling)是卷积神经网络中的一个重要的概念,它实际上是一种形式的降采样。有多种不同形式的非线性池化函数,而其中“最大池化(Max pooling)”是最为常见的。它是将输入的图像划分为若干个矩形区域,对每个子区域输出最大值。直觉上,这种机制能够有效的原因在于,在发现一个特征之后,它的精确位置远不及它和其他特征的相对位置的关系重要。池化层会不断地减小数据的空间大小,因此参数的数量和计算量也会下降,这在一定程度上也控制了过拟合。通常来说,CNN的卷积层之间都会周期性地插入池化层。

- 特征学习:仿人脑的层级表达。这是机器学习中使用卷积神经网络正在研究和实验的方向。

- 池化。池化(Pooling)是卷积神经网络中的一个重要的概念,它实际上是一种形式的降采样。有多种不同形式的非线性池化函数,而其中“最大池化(Max pooling)”是最为常见的。它是将输入的图像划分为若干个矩形区域,对每个子区域输出最大值。直觉上,这种机制能够有效的原因在于,在发现一个特征之后,它的精确位置远不及它和其他特征的相对位置的关系重要。池化层会不断地减小数据的空间大小,因此参数的数量和计算量也会下降,这在一定程度上也控制了过拟合。通常来说,CNN的卷积层之间都会周期性地插入池化层。

- 深度学习与密码分析

- 基于卷积神经网络的侧信道攻击

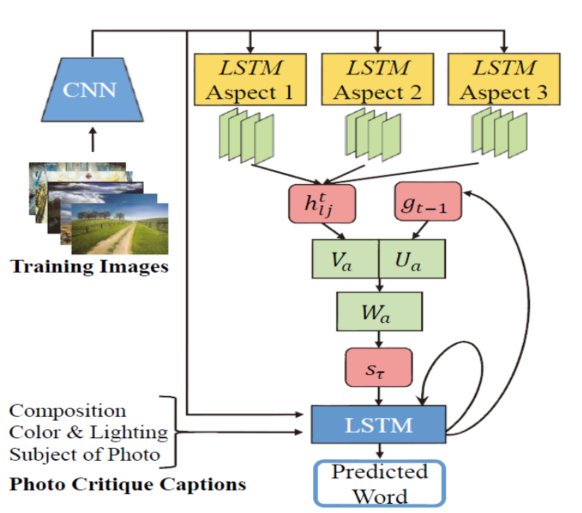

- 基于循环神经网络的明文破译

- 基于生层对抗网络的口令破解

- 基于深度神经网络的密码基元识别

- 深度学习最新进展

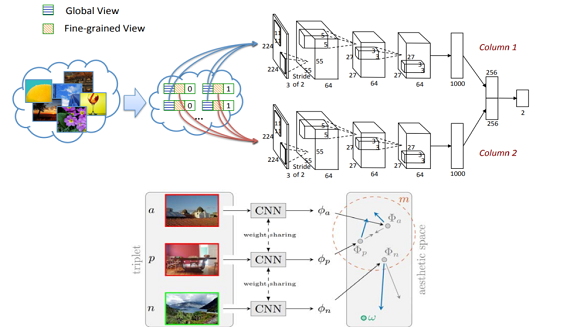

- 多通道深度神经网络

- 级联深度神经网络

- 多任务深度神经网络

- 卷积神经网络与循环神经网络

- 深度森林

- 图深度学习(GraphDL)

- 深度学习已经开始应用于密码分析的多项任务。其中的关键问题在于:如何将多种深度神经网络灵活地运用于多项密码分析任务,以及如何设计出符合密码分析任务需求的新型深度神经网络,以提高分析成功率。

- 多通道深度神经网络

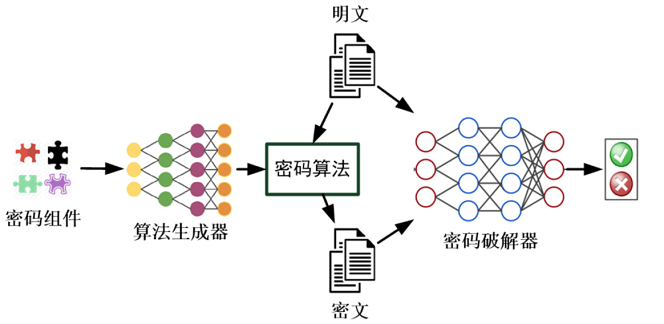

- 深度学习与密码设计

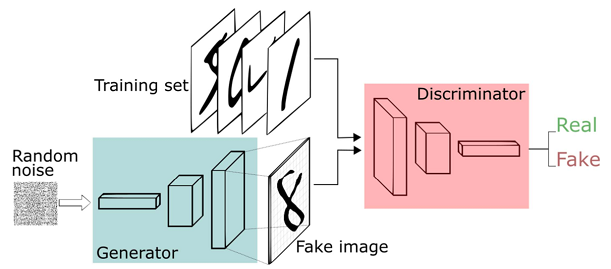

量子计算技术快速发展对密码技术产生极大的威胁和挑战,一旦实用化量子计算出现,将导致基于离散对数、整数分解的公钥密码体制直接被快速攻破,意味着当前所使用的网络信息系统不再安全。因此,未来对于新密码算法的设计需求将与日剧增,然而目前密码算法的设计还停留在人工设计阶段,较为耗时耗力,难以适应未来对密码算法设计的需求。可以利用深度学习,让机器自动设计密码算法。- 生成对抗网络 GAN: Generative Adversarial Network。

- 利用生成对抗网络让机器自己设计密码算法。

- 生成对抗网络 GAN: Generative Adversarial Network。

2.学习中遇到的问题及解决

- 问题1:卷积神经网络中卷积的计算过程。

问题1解决方案:找到相关学习博客,进行学习。

- 什么是卷积

对图像(不同的数据窗口数据)和滤波矩阵(一组固定的权重:因为每个神经元的多个权重固定,所以又可以看做一个恒定的滤波器filter)做内积(逐个元素相乘再求和)的操作就是所谓的『卷积』操作,也是卷积神经网络的名字来源。 - 图像上的卷积

左边是图像输入,中间部分就是滤波器filter(带着一组固定权重的神经元),不同的滤波器filter会得到不同的输出数据,比如颜色深浅、轮廓。相当于如果想提取图像的不同特征,则用不同的滤波器filter,提取想要的关于图像的特定信息:颜色深浅或轮廓。

- 什么是卷积

- 问题2:池化的含义和发展情况。

问题2解决方案:

- 池化(Pooling)是卷积神经网络中的一个重要的概念,它实际上是一种形式的降采样。有多种不同形式的非线性池化函数,而其中“最大池化(Max pooling)”是最为常见的。它是将输入的图像划分为若干个矩形区域,对每个子区域输出最大值。直觉上,这种机制能够有效的原因在于,在发现一个特征之后,它的精确位置远不及它和其他特征的相对位置的关系重要。池化层会不断地减小数据的空间大小,因此参数的数量和计算量也会下降,这在一定程度上也控制了过拟合。通常来说,CNN的卷积层之间都会周期性地插入池化层。

- 池化层通常会分别作用于每个输入的特征并减小其大小。目前最常用形式的池化层是每隔2个元素从图像划分出的区块,然后对每个区块中的4个数取最大值。这将会减少75%的数据量。

- 除了最大池化之外,池化层也可以使用其他池化函数,例如“平均池化”甚至“L2-范数池化”等。

- 发展历史:过去,平均池化的使用较为广泛,但是由于最大池化在实践中的表现更好,所以平均池化已经不太常用。由于池化层过快地减少了数据的大小,目前文献中的趋势是使用较小的池化滤镜,甚至不再使用池化层。

- 发展瓶颈:容易过快减小数据尺寸。

- 发展方向:目前趋势是用其他方法代替池化的作用,比如胶囊网络推荐采用动态路由来代替传统池化方法,原因是池化会带来一定程度上表征的位移不变性,传统观点认为这是一个优势,但是胶囊网络的作者Hinton et al.认为图像中位置信息是应该保留的有价值信息,利用特别的聚类评分算法和动态路由的方式可以学习到更高级且灵活的表征,有望冲破目前卷积网络构架的瓶颈。

- 问题3:生成对抗网络GAN。

问题3解决方案:

GAN的工作原理:以图像生成模型举例。假设我们有一个图片生成模型(generator),它的目标是生成一张真实的图片。与此同时我们有一个图像判别模型(discriminator),它的目标是能够正确判别一张图片是生成出来的还是真实存在的。那么如果我们把刚才的场景映射成图片生成模型和判别模型之间的博弈,就变成了如下模式:生成模型生成一些图片->判别模型学习区分生成的图片和真实图片->生成模型根据判别模型改进自己,生成新的图片->····这个场景直至生成模型与判别模型无法提高自己——即判别模型无法判断一张图片是生成出来的还是真实的而结束。

上述这种博弈式的训练过程,如果采用神经网络作为模型类型,则被称为生成式对抗网络(GAN)。用数学语言描述整个博弈过程的话,就是:假设我们的生成模型是g(z),其中z是一个随机噪声,而g将这个随机噪声转化为数据类型x,仍拿图片问题举例,这里g的输出就是一张图片。D是一个判别模型,对任何输入x,D(x)的输出是0-1范围内的一个实数,用来判断这个图片是一个真实图片的概率是多大。

3.本次讲座的学习感悟、思考等

本次讲座给我打开了机器学习的大门,让我接触到了一种全新的解决问题的办法。以密码分析和设计来说,要设计和攻破一个密码对人类来说是很困难的,但是采用生成对抗网络这种方式,可以让两个模型互相训练,互相学习直到得出想要的结果,中间的过程都可以省略掉,设置好参数,最后拿到结果即可。人工智能是目前计算机技术发展的一个方向,而且与大数据时代的契合度也相当高,未来或许会出现更多更好的方法和模型。

4.生成对抗网络GAN最新研究现状

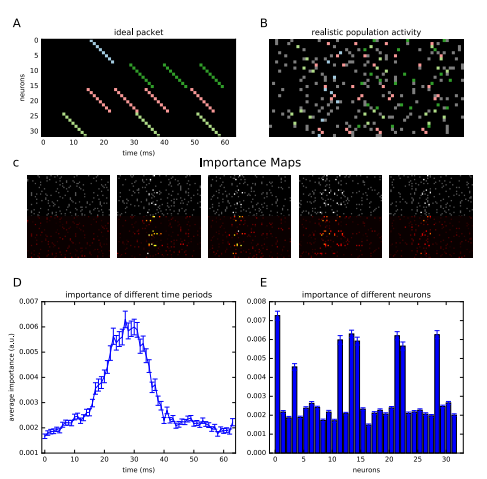

论文1:Synthesizing realistic neural population activity patterns using Generative Adversarial Networks

- 作者:Manuel Molano-Mazon, Arno Onken, Eugenio Piasini, Stefano Panzeri

- 会议名称: ICLR 2018(International Conference on Learning Representations,国际学习表征会议)

- 研究进展:

这篇论文使用生成对抗网络(gans)框架来模拟神经元群体的协同活动,合成真实的神经活动模式。这篇论文提出了一种生成对抗网络并将其命名为“Spike-GAN”,并且证明了Spike-GAN生成的Spike序列能够精确匹配数十个神经元数据集的一阶和二阶统计数据,并且能够很好地近似它们的高阶统计数据。这篇论文将Spike-GAN应用于从蝾螈视网膜记录的真实数据集,并表明它的表现与基于最大熵和二分法高斯框架的最先进方法一样。重要的是,Spike-GAN不需要先验证模型匹配的统计数据,因此构成了比这些替代方法更灵活的方法。最后,论文展示了如何利用训练有素的Spike-GAN来构建“重要性图”,以检测尖峰列车中存在的最相关的统计结构。Spike-GAN提供了一种功能强大,易于使用的技术,用于生成逼真的尖峰神经活动,并描述现代系统神经科学中研究的大规模神经群记录的最相关特征。

最后得出结论:首先,SpikeGan比Maxent和DG模型更灵活,能够适应数据中存在的任何类型的时空结构。此外,它不需要预先假设数据集的哪些统计属性是相关的,因此需要匹配。最后,Spike Gan基于深度神经网络框架,因此能够直接从这个快速增长的领域中出现的工程进展中受益。可以想象,这将使Spike-Gan,或者从中衍生出来的方法,在未来更好地利用实验神经科学界不断增长的数据集。

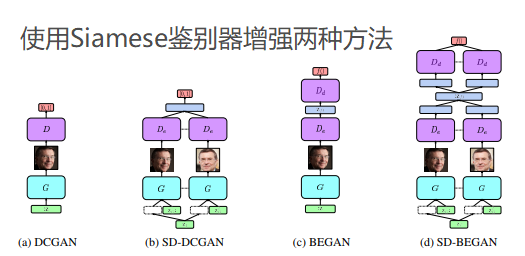

论文2:Semantically Decomposing the Latent Spaces of Generative Adversarial Networks

- 作者:Chris Donahue, Zachary C. Lipton, Akshay Balsubramani, Julian McAuley

- 会议名称: ICLR 2018(International Conference on Learning Representations,国际学习表征会议)

- 研究进展:

这篇论文提出了一种新的训练生成对抗网络的算法(SD-GANs),来共同学习包括身份和观察两方面的潜在含义。该算法具有成对训练方案,其中来自生成器的每个样本由具有共同身份代码的两个图像组成。来自真实数据集的相应样本由同一主题的两个不同照片组成。为了欺骗鉴别器,生成器必须产生既逼真又清晰的图像,并且看起来两张图像是在描绘同一个人。论文中使用Siamese鉴别器增强了DCGAN和BEGAN方法,以适应成对训练。人工评判和现成的面部验证系统的实验证明了该算法能够生成令人信服的,身份匹配的照片。

论文提出的SD-GANs可以将那些与同一性相对应的变异因素与其他因素分开,并且可以从以前从未见过的身份中取样,这是传统GAN所不能做到的。SD-GANs基于已知共性的变异因子分离,为未来的研究提供了一个好的方向。

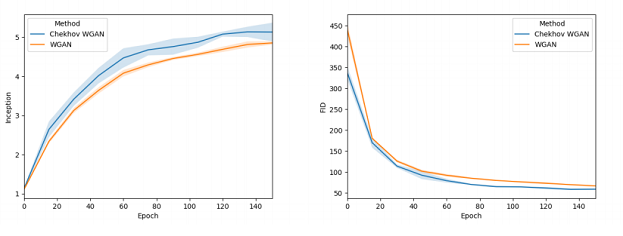

论文3:An Online Learning Approach to Generative Adversarial Networks

- 作者:Paulina Grnarova, Kfir Y Levy, Aurelien Lucchi, Thomas Hofmann, Andreas Krause

- 会议名称: ICLR 2018(International Conference on Learning Representations,国际学习表征会议)

- 研究进展:

虽然gans可以精确地模拟复杂的分布,但由于一个困难的极大极小优化问题导致的不稳定性,导致它们很难训练。 这篇论文将GAN训练为在零和游戏中找到混合策略的问题,基于在线学习的想法,提出了一种名为Chekhov GAN的新型训练方法。新型训练方法与标准GAN训练相比表现出了更高的性能和稳定性。

这篇论文提出了一种训练GAN的新型、规范方法,可以保证收敛到半浅层架构的混合均衡。 根据实验结果,这种方法在应用于常用的GAN架构时具有几个优点,例如改进的稳定性或减少模式下降。 这篇文章为在训练GAN的背景下使用在线学习和游戏理论技术开辟了道路, 下一步要考虑的问题是这种方法是否可以扩展到更复杂的架构。

论文4:On the Discrimination-Generalization Tradeoff in GANs

- 作者:Pengchuan Zhang, Qiang Liu, Dengyong Zhou, Tao Xu, Xiaodong He

- 会议名称: ICLR 2018(International Conference on Learning Representations,国际学习表征会议)

- 研究进展:

这篇论文通过严格的计算,证明了一个鉴别器集保证在有界连续函数集中其线性跨度密集时是有区别的;并且在不同的评估指标下开发了学习分布和真实分布之间的泛化界限。当用神经距离进行评估时,界限表明,只要鉴别器集足够小,无论发生器或假设集的大小如何,都可以保证泛化。当用KL分歧进行评估时,界限提供了关于在GAN训练中测试可能性的反直觉行为的解释,为理解GANS的实际性能提供了依据。本文研究了神经网络等带有参数化判别器类的人工神经网络的判别和泛化特性,并且指明了研究的方向,研究计算神经距离/散度的方法,希望能够将结果扩展到传统GAN上。

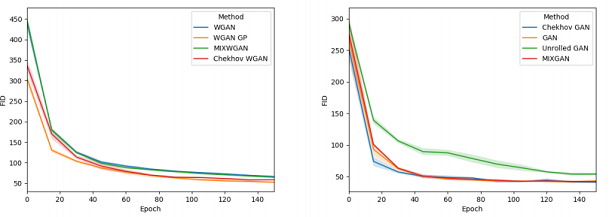

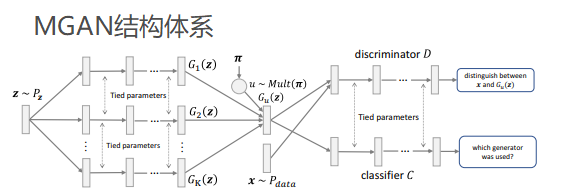

论文5:MGAN: Training Generative Adversarial Nets with Multiple Generators

- 作者:Quan Hoang, Tu Dinh Nguyen, Trung Le, Dinh Phung

- 会议名称: ICLR 2018(International Conference on Learning Representations,国际学习表征会议)

- 研究进展:

论文提出了一种新的对抗性模型来解决生成对抗网络中模式崩溃的问题,使用多个分布的混合来近似数据分布,其中每个分布分别捕获数据模式的子集。通过一个由一个鉴别器、一个分类器和多个生成器组成的极大极小博弈,来构造一个优化问题,使pdata和pmodel之间的JSD最小化,即由生成器引起的分布的混合,同时使这些生成器分布之间的JSD最大化。这有助于模型生成不同的图像以更好地覆盖数据模式,从而有效地避免模式崩溃。论文将这种模型称为混合生成对抗网络MGAN(Mixture Generative Adversarial Network ),MGAN可以通过在其鉴别器和分类器之间以及在其生成器之间共享参数来进行有效的训练,因此可以扩展到实际的大规模数据集上进行评估。论文提出的MGAN是一种比较好的对抗生成网络模型。

参考资料

- CNN笔记:通俗理解卷积神经网络

- 池化 | 机器之心

- 到底什么是生成式对抗网络GAN?

- Synthesizing realistic neural population activity patterns using Generative Adversarial Networks

- Semantically Decomposing the Latent Spaces of Generative Adversarial Networks

- An Online Learning Approach to Generative Adversarial Networks

- On the Discrimination-Generalization Tradeoff in GANs

- MGAN: Training Generative Adversarial Nets with Multiple Generators