记一次将三十万条数据的CSV文件导入到生产环境的kudu数据库中

因为是生产环境,自己也是小心翼翼,进行实践操作。

思路还是简单的

0,开始工作前,先将文件复制出来,保存为.txt文件,且用制表符作为分隔。

1,先将文件上传到集群环境中,放在某个目录下。这里我放在/home

2,将文件数据导入到hive中,建hive表

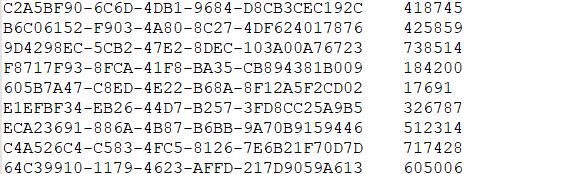

create table kzw_mk_test(

device_id string,

user_id_mk string

)

row format delimited

fields terminated by '\t'

STORED AS TEXTFILE

;

3,将本地文件导入到hive中,命令如下:

load data local inpath '/home/urserid_mk.txt' into table kzw_mk_test;

4,用hue建好kudu表:

CREATE TABLE IF NOT EXISTS kzw_test_device_user_mk(

device_id STRING PRIMARY KEY ,

user_id_mk BIGINT)

STORED AS KUDU

此处遇到一个小问题,用device_id作为主键导入数据后发现有数据丢失情况,说明有主键重复情况,所以修改建表语句,用两个字段联合作为kudu组合主键

修改后建表语句:

CREATE TABLE IF NOT EXISTS kzw_test_device_user_mk(

device_id STRING,

user_id_mk BIGINT,

PRIMARY KEY (device_id, user_id_mk))

STORED AS KUDU

5,最后将hive表导入到kudu表中

INSERT INTO kzw_test_device_user_mk SELECT device_id ,cast(user_id_mk as bigint) FROM kzw_mk_test ;

其中 cast(user_id_mk as bigint) 是因为在hive中该字段是String类型,而hive中是bigint类型,所以要进行类型转换。

一系列步骤下来导入成功,三十多万条数据一条不落。此方法只是本人自己所实践,方法比较笨,如有高人路过望不吝赐教。