1.Hive基本概念

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供类SQL查询功能。

1.1.为什么使用Hive

直接使用hadoop所面临的问题

- 人员学习成本太高

- 项目周期要求太短

- MapReduce实现复杂查询逻辑开发难度太大

使用Hive

- 操作接口采用类SQL语法,提供快速开发的能力。

- 避免了去写MapReduce,减少开发人员的学习成本。

- 扩展功能很方便。

1.2Hive的特点

可扩展 :Hive可以自由的扩展集群的规模,一般情况下不需要重启服务。

延展性:Hive支持用户自定义函数,用户可以根据自己的需求来实现自己的函数。

容错:良好的容错性,节点出现问题SQL仍可完成执行。

1.3Hive基本组成

- 用户接口:包括 CLI、JDBC/ODBC、WebGUI。

- 元数据存储:通常是存储在关系数据库如 mysql , derby中。

- 解释器、编译器、优化器、执行器。

1.4Hive各组件的基本功能

- 用户接口主要由三个:CLI、JDBC/ODBC和WebGUI。其中,CLI为shell命令行;JDBC/ODBC是Hive的JAVA实现,与传统数据库JDBC类似;WebGUI是通过浏览器访问Hive。

- 元数据存储:Hive 将元数据存储在数据库中。Hive 中的元数据包括表的名字,表的列和分区及其属性,表的属性(是否为外部表等),表的数据所在目录等。

- 解释器、编译器、优化器完成 HQL 查询语句从词法分析、语法分析、编译、优化以及查询计划的生成。生成的查询计划存储在 HDFS 中,并在随后有 MapReduce 调用执行。

1.5Hive与Hadoop的关系

Hive利用HDFS存储数据,利用MapReduce查询数据

1.6Hive与传统数据库对比

总结:hive具有sql数据库的外表,但应用场景完全不同,hive只适合用来做批量数据统计分析

1.7Hive的数据存储

1、Hive中所有的数据都存储在 HDFS 中,没有专门的数据存储格式(可支持Text,SequenceFile,ParquetFile,RCFILE等)

扫描二维码关注公众号,回复: 5710341 查看本文章

2、只需要在创建表的时候告诉 Hive 数据中的列分隔符和行分隔符,Hive 就可以解析数据。

3、Hive 中包含以下数据模型:DB、Table,External Table,Partition,Bucket。

- db:在hdfs中表现为${hive.metastore.warehouse.dir}目录下一个文件夹

- table:在hdfs中表现所属db目录下一个文件夹

- external table:外部表, 与table类似,不过其数据存放位置可以在任意指定路径普通表: 删除表后, hdfs上的文件都删了External外部表删除后, hdfs上的文件没有删除, 只是把文件删除了

- partition:在hdfs中表现为table目录下的子目录

- bucket:桶, 在hdfs中表现为同一个表目录下根据hash散列之后的多个文件, 会根据不同的文件把数据放到不同的文件中

2.HIVE的安装部署

搭建方式是在hadoop集群的基础上搭建的:https://blog.csdn.net/weixin_38201936/article/details/85096496

现在提取mini1 、mini2、mini3 三台虚拟机作为集群,mini1作为namenode 主节点 mini2、mini3、作为datanode 从节点

| 节点 | 说明 | ip地址 |

| mini1 | 主节点 | 192.168.63.181 |

| mini2 | 从节点 | 192.168.63.182 |

| mini3 | 从节点 | 192.168.63.183 |

上传jar包 百度网盘提取码:https://pan.baidu.com/s/1PwvdaKCnRRZGWCbnzR8ogA 密码:zzb6

使用普通用户hadoop 登录

1:将jar包上传到mini1 下的根路径如图所示:

:2:

:2:

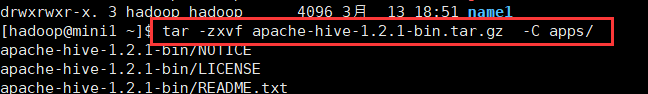

2:将安装包解压到 hadoop集群的apps 安装包内

tar -zxvf apache-hive-1.2.1-bin.tar.gz -C apps/

3:查看解压是否成功:

4:在mini1 安装mysql数据库 安装步骤如下:https://blog.csdn.net/weixin_38201936/article/details/81293244

5:配置hive 在conf文件下添加配置文件

[hadoop@mini1 ~]$ cd apps/apache-hive-1.2.1-bin/conf

[hadoop@mini1 conf]$ ll

[hadoop@mini1 conf]$ vi hive-site.xml

添加的配置内容如下: 添加时注意最下面设置用户名和密码: 我的密码是123456 添加之后保存

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

<description>password to use against metastore database</description>

</property>

</configuration>6:将mysql的驱动包放在hive的驱动包下,首先先进入hive的驱动包下:

[hadoop@mini1 ~]$ cd apps/apache-hive-1.2.1-bin/lib/

mysql驱动包 https://pan.baidu.com/s/1f4M9_a5rNuWmsBKZOLysDA 提取码:0cxr 下载之后放到hive的驱动包下

7:将mysql的驱动包放在hive的驱动包下之后,要在mysql授权(在安装mysql的机器上执行) 使mysql数据库可以设置远程连接权限,任何IP地址或主机都可以与他连接,具体操作步骤如下:

先登录到数据库中 然后执行下面那行命令 对mysql数据库设置远程连接 'root'指代用户名 '123456'指代密码 设置好之后保存退出

[hadoop@mini1 ~]$ mysql -u root -p

mysql> GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123456' WITH GRANT OPTION;

7:设置完命令之后就可以启动hive了 但是需要将hodoop/yarn/lib/jline-xxx.jar 包删除 然后将hive下的 jline-xxx.jar 包导入到hodoop/yarn/lib/文件下 因为 如果不替换的话,hadoop中的jar包的版本如果低于hive中jar 的版本 就会出现启动失败。所以 保险起见 先替换 你也可以先启动hive 如果启动成功就不用替换,启动失败 就替换了

替换:

[hadoop@mini1 ~]$ rm -rf apps/hadoop-2.6.4/share/hadoop/yarn/lib/jline-0.9.94.jar //先移除hadoop下的jline-0.9.94.jar包

[hadoop@mini1 lib]$ cp apps/apache-hive-1.2.1-bin/lib/jline-2.12.jar apps/hadoop-2.6.4/share/hadoop/yarn/lib //再将hive 下的jline-2.12.jar 复制到hadoop下 替换后在启动hive 启动成功!!!

[hadoop@mini1 ~]$ cd apps/apache-hive-1.2.1-bin/

[hadoop@mini1 apache-hive-1.2.1-bin]$ bin/hive

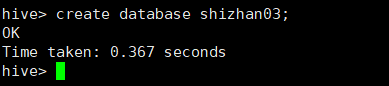

启动成功后就和mysql的操作一样了 可以在里面创建数据库

创建成功后在页面上登录 mini:50070 查看是否有你创建的数据库 我么可以看到创建的数据库已经在上面显示了