多功能与多变量线性回归

n代表特征变量个数,n个特征变量与一个所求值构成一个样本。

由单变量的梯度下降可推出,对每一个参数 theta_ i ,都要同步进行值的更新(在梯度下降的过程中)

特征缩放

若特征值之间值的范围差异过大,会造成代价函数“崎岖”的现象,运行梯度下降算法时便会产生过多的耗时和资源浪费。而利用特征缩放来使代价函数的等值线变得均匀,能够更高效的运行梯度下降算法。

通常情况下,用x_i 的平均值和数据的范围进行数据规范。

学习率

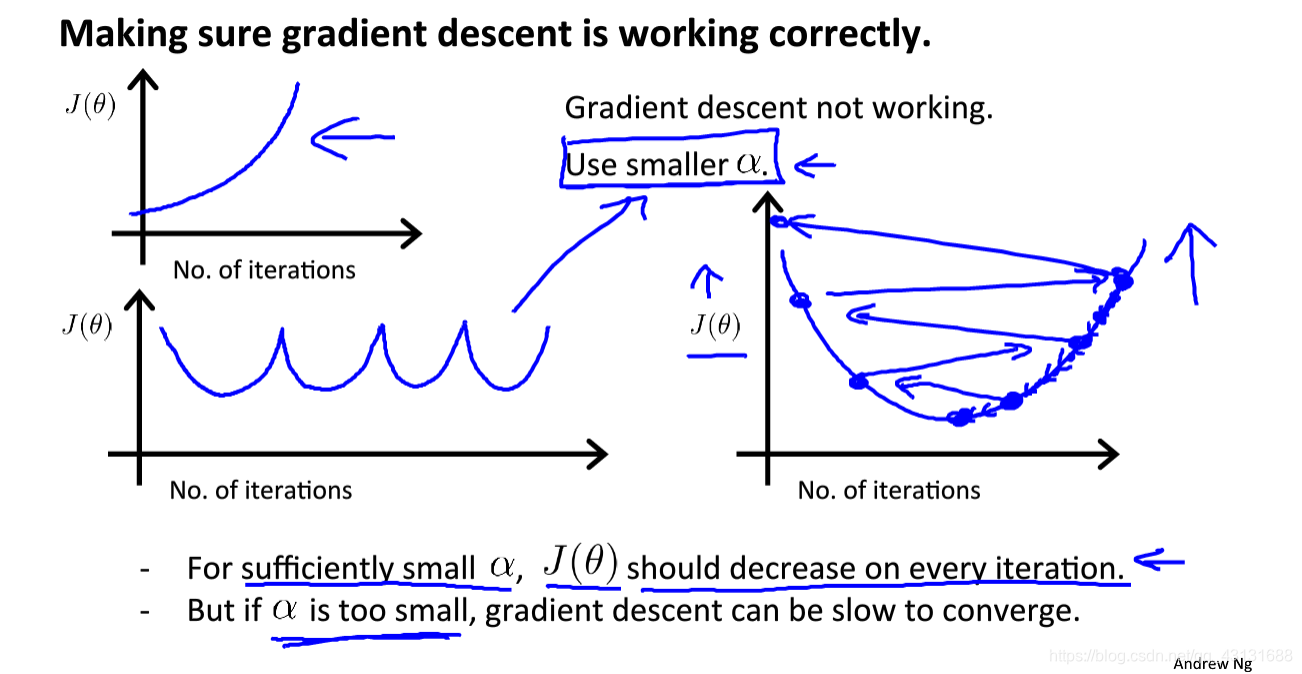

学习率大小的选择在梯度下降中至关重要。随着迭代运算次数的增加,根据J(theta)值的变化趋势可基本判断算法是否正常运行。

多项式回归

线性回归往往无法得出较为精确的结果,在很多情况下我们需要采用非线性的回归方程来更好地拟合数据集。

正规方程及矩阵不可逆情况

正规方程求解min(J)是区别与梯度下降的另一种办法,只需一步就可完成。在计算机中采用矩阵运算来求解。X作为一个design matrix,包含所有样本的特征值,y作为一个m维向量参与运算。

梯度下降与正规方程求解的优缺点如上,我们往往要根据实际情况(运算速度,运算成本,结果要求)选择较为合适的运算方式。

在octave中进行pinv()逆运算其结果不被矩阵是否可逆所影响,我们不做过多讨论。

X(T)X 不可逆可由重复的相同定义的特征变量所导致,也可能是因为样本过少特征值过多所产生。