集群三部曲:伪分布模式

文章目录

请先做好准备工作:参看文章集群三部曲之准备工作

~~单机模式

~~全分布模式

1.伪分布式配置

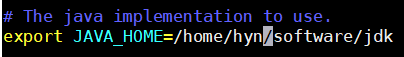

1)配置:hadoop-env.sh(/home/hyn/software/hadoop/etc/hadoop)

Linux系统中获取jdk的安装路径,然后修改文件:

2)配置:core-site.xml(需要在hadoop文件夹下创建data文件夹,data文件夹下创建tmp文件夹)

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://Cloud:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hyn/software/hadoop/data/tmp</value>

</property>

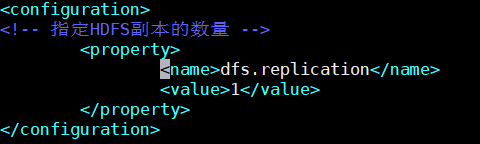

3)配置:hdfs-site.xml

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

2.启动集群

(a)格式化namenode(第一次启动时格式化,以后就不要总格式化)

bin/hdfs namenode -format

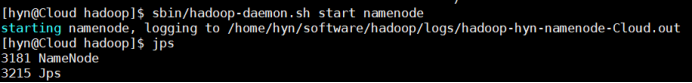

(b)启动namenode

sbin/hadoop-daemon.sh start namenode

(c)启动datanode

sbin/hadoop-daemon.sh start datanode

3.查看集群

1)查看是否启动成功

2)查看log日志:hadoop文件夹下的logs文件

3)Web端查看HDFS文件系统:联网状态下的网址 IP地址:50070

注意:如果不能查看,看如下帖子处理

http://www.cnblogs.com/zlslch/p/6604189.html

4.在HDFS上运行MapReduce的WordCount 程序

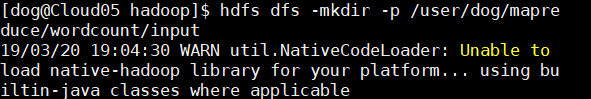

(1)在hdfs文件系统上创建一个input文件夹

bin/hdfs dfs -mkdir -p /user/hyn/mapreduce/wordcount/input

(2)将测试文件内容上传到文件系统上

bin/hdfs dfs -put wcinput/wc.input /user/hyn/mapreduce/wordcount/input/

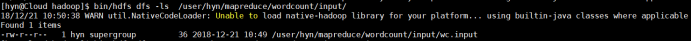

(3)查看上传的文件是否正确

bin/hdfs dfs -ls /user/hyn/mapreduce/wordcount/input/

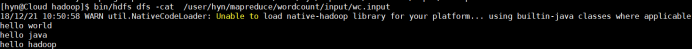

bin/hdfs dfs -cat /user/hyn/mapreduce/wordcount/input/wc.input

(4)在Hdfs上运行mapreduce程序

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.1.jar wordcount /user/hyn/mapreduce/wordcount/input/ /user/hyn/mapreduce/wordcount/output

(5)查看输出结果

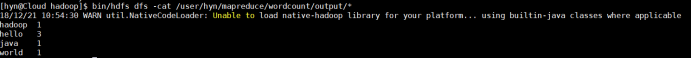

--------------命令行查看:

bin/hdfs dfs -cat /user/hyn/mapreduce/wordcount/output/*

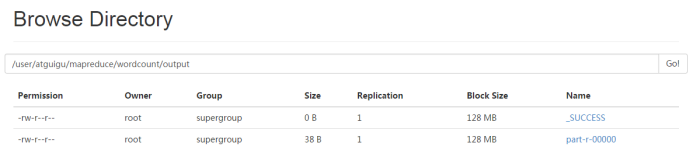

---------------浏览器查看

(6)将测试文件内容下载到本地

hadoop fs -get /user/hyn/mapreduce/wordcount/output/part-r-00000 ./output/

(7)删除输出结果

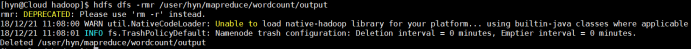

hdfs dfs -rmr /user/hyn/mapreduce/wordcount/output

5.YARN上运行MapReduce 程序

1)在集群的基础上配置Yarn:

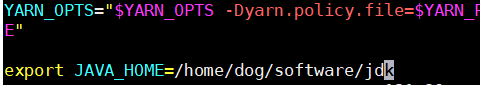

(1)配置yarn-env.sh中的JAVA_HOME

export JAVA_HOME=/home/hyn/software/jdk

(2)配置yarn-site.xml

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>cloud</value>

</property>

(3)配置:mapred-env.sh

配置一下JAVA_HOME

export JAVA_HOME=/home/hyn/software/jdk

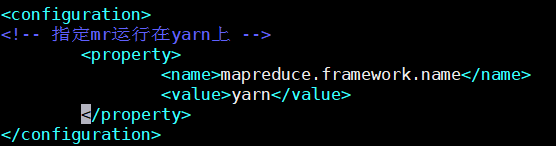

(4)配置: (对mapred-site.xml.template复制并重新命名为) mapred-site.xml

<!-- 指定mr运行在yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

2)启动Yarn

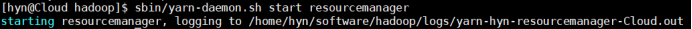

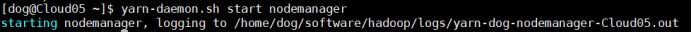

(1)启动resourcemanager**

sbin/yarn-daemon.sh start resourcemanager

(2)启动nodemanager

sbin/yarn-daemon.sh start nodemanager

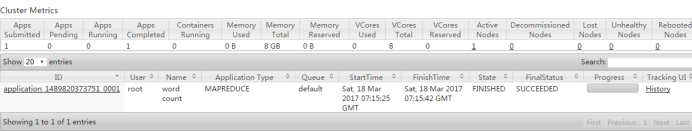

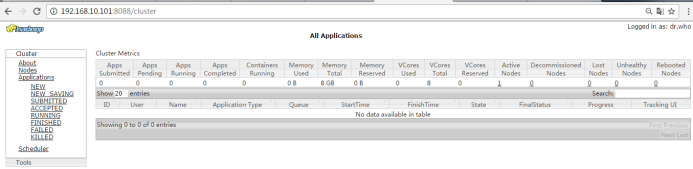

3)Yarn的操作

(1)yarn的浏览器页面查看

http://192.168.244.128:8088/cluster

(2)删除文件系统上的output文件

bin/hdfs dfs -rm -R /user/dog/mapreduce/wordcount/output

(3)执行mapreduce程序

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.1.jar wordcount /user/hyn/mapreduce/wordcount/input /user/hyn/mapreduce/wordcount/output

(4)查看运行结果

bin/hdfs dfs -cat /user/hyn/mapreduce/wordcount/output/*